Cela fait maintenant près de trois mois que NVIDIA a lancé sa nouvelle architecture Ada Lovelace, gravée en 4 nm par TSMC. Elle a depuis été mise sur le marché à travers les GeForce RTX 4080 et 4090 qui visent l'offre haut de gamme. C'est aujourd'hui au tour de la RTX 4070 Ti d'être officialisée.

L'histoire de la GeForce RTX 4070 Ti n'a pas été un long fleuve tranquille. En effet, avant même sa mise en vente, prévue pour demain, elle était contestée. Il faut dire qu'au départ, NVIDIA avait décidé de la présenter comme une GeForce RTX 4080 avec 12 Go de GDDR6X (contre 16 Go pour sa grande sœur) :

Au départ, la GeForce RTX 4070 Ti était la RTX 4080 de 12 Go

Problème : ses caractéristiques étaient également revues à la baisse. Comme on pouvait s'y attendre, la polémique a rapidement enflé, au point que le constructeur décide assez rapidement de reculer, comprenant l'erreur de ses équipes marketing. Son lancement a donc été reporté et un nouveau nom lui a été trouvé : GeForce RTX 4070 Ti.

NVIDIA a profité de ce temps de réflexion pour revoir un autre élément de sa stratégie : le prix. Annoncée à 1 099 euros, la GeForce RTX 4080 de 12 Go était peu intéressante rapportée à sa puissance de calcul. Présentée comme une RTX 4070 Ti, elle sera vendue à partir de 899 euros, ce qui est déjà bien plus intéressant.

Surtout que pour ce prix, le constructeur promettait des performances supérieures à une GeForce RTX 3090, avec un TGP réduit à seulement 285 watts. Qu'en est-il dans la pratique ?

Une presque GeForce RTX 3090 (Ti), plus efficace

Nous ne reviendrons pas en détails sur les nouveautés introduites par Ada Lovelace, déjà évoquées. Nous aurons également l'occasion d'évoquer certaines fonctionnalités propres à cette architecture dans de prochains articles.

Commençons donc par vérifier que la RTX 4070 Ti est bien identique à la RTX 4080 de 12 Go telle qu'elle avait été annoncée. NVIDIA nous a confirmé qu'elle utilisait bien une puce de taille réduite, l'AD104, gravée en 4 nm par TSMC, composée de pas moins de 35,8 milliards de transistors. Elle se compose de 5 Graphics Processing Clusters (GPC) pour un total de 60 Streaming Multiprocessors (SM) et 30 Texture Processing Clusters (TPC), soit :

- 7 680 CUDA Cores

- 240 Tensor Cores (4e génération)

- 60 RT Cores (3e génération)

- 240 unités de texturing

- 80 ROPs

Avec une fréquence Boost de 2,61 GHz, on arrive bien à 40 TFLOPS de puissance de calcul, soit autant que la RTX 3090 Ti qui avait été annoncée à 2 249 euros et 36 TFLOPS pour la RTX 3090. On est également bien au-delà côté ray-tracing avec 93 TFLOPS (contre 82 annoncés au départ pour la RTX 4080 de 12 Go) et Tensor avec 641 TFLOPS, soit pas moins du double de ce qui était proposé par la RTX 3090 Ti. Cette carte fait donc parfaitement le lien entre la précédente génération et la nouvelle, tout en étant bien plus abordable que ses ancêtres.

Seule différence notable : elle n'embarque que 12 Go de GDDR6X, ce qui ne devrait pas être une limite excepté dans certains cas précis, mais nous le vérifierons lors des tests. L'AD104 se contente également d'une interface de 192 bits, ce qui donne une bande passante de 504 Go/s avec des puces mémoire à 21 Gb/s.

Consommation, AV1 et configuration

Côté consommation, NVIDIA annonce 12 watts au repos, 20 watts en lecture de vidéo AV1 et 226 watts en moyenne en jeu. Deux connecteurs PCIe à 8 broches sont nécessaires à son alimentation, ou un 12VHPWR PCIe 5.0 de 300 watts. La RTX 4070 Ti n'étant proposée que par des constructeurs tiers, chacun fait ici comme bon lui semble.

Dans notre cas, nous avons reçu une Gigabyte Gaming OC respectant la nouvelle norme, livrée avec un adaptateur. Elle bénéficie d'un boost plus élevé sur le GPU, mais négligeable puisque l'on passe à 2,64 GHz. Rien sur la mémoire. Elle a par contre droit à un design et un refroidissement massif avec un très large dissipateur et trois ventilateurs, semi-passifs. Les amateurs de disco apprécieront également que des LED s'allument selon la vitesse de rotation, donnant un effet stroboscopique, avec un jeu de couleurs. Elle a une sortie HDMI 2.1 et trois DP 1.4a.

Nous l'avons utilisé sur une alimentation Fox Spirit GT-750P V2 certifiée 80PLUS Platinum. Comme nous le verrons, ce choix était surdimensionné pour nos besoins, bien que NVIDIA recommande un bloc de 700 watts. Ce, même si le reste de notre machine de test était plutôt « massif » : un Intel Core i9-12900K refroidit par un Noctua NH-U12A, accompagné de 2x 16 Go de DDR5-6000 XPG A-Data, sur une carte mère Z690 Maximus Hero ASUS avec le BIOS/UEFI v2204 et deux SSD Samsung de 1 To (PCIe 4.0 x4). Le tout était installé sur Windows 11 22H2.

Au final, la machine consomme 70 watts au repos, comme avec une RTX 3090, contre 50 watts lorsqu'on utilise la partie graphique intégrée. Lors de la compression de la vidéo 4K de Tears of Steel en H.265 4K avec le profil exploitant les moteurs NVENC de Handbrake (AV1 n'est pas encore supporté pour les GPU de NVIDIA), on passe à 226,42 watts pour un débit de 149,6 images/s, soit 1,5 joule par image calculée. Dans le cas de la GeForce RTX 3090 Founders Edition, nous obtenons 107,47 ips pour 268,47 watts soit 2,5 joules par image calculée.

Cela donne la consommation d'énergie suivante :

Handbrake 1.60 - Tears of Steal 4K > HEVC 4K (NVENC) :

- GeForce RTX 3090 : 12,22 Wh

- GeForce RTX 4070 Ti : 6,97 Wh

Ici, on voit clairement l'apport du doublement des moteurs NVENC (39 % de débit en plus) et de la nouvelle architecture, moins gourmande en énergie, puisque l'on divise la consommation par 1,75 à tâche identique.

Quelles performances sous Blender (OptiX) ?

On continue avec les applications de productivité et le logiciel de rendu 3D Blender, dans sa version 3.4. Ici, on ne prend même plus la peine de tester la scène bmw27_gpu qui est rendue en... moins de six secondes. Nous avons plutôt utilisé Cosmos Laundromat et barbershop, bien plus lourdes. Néanmoins, la GeForce RTX 4070 Ti est ici très rapide pour effectuer de tels calculs, surtout par rapport à un CPU (même un i9-12900K) :

- Cosmos Laundromat :

- Core i9-12900K : 7min 12s pour 41,71 Wh

- GeForce RTX 3090 : 47s pour 4,86 Wh

- GeForce RTX 4070 Ti : 43 s pour 2,92 Wh

- Barbershop :

- Core i9-12900K : 15min 40s pour 92,82 Wh

- GeForce RTX 3090 : 55s pour 6,27 Wh

- GeForce RTX 4070 Ti : 52 s pour 3,77 Wh

Nous ne reviendrons pas ici sur l'intérêt d'effectuer un rendu sur GPU plutôt que sur CPU lorsque c'est possible, le rapport étant de 1 à 10/15 en temps et jusqu'à 1 pour 25 en énergie. Mais on constate que si la GeForce RTX 4070 Ti est légèrement plus rapide que la RTX 3090, elle divise sa consommation énergétique par 1,66.

Et pour les GamerZ ?

Passons maintenant aux jeux. Ici, nous opposerons la GeForce RTX 4070 Ti à la RTX 3090 dont nous disposions dans notre laboratoire. Nous effectuerons des tests face aux nouvelles Radeon RX 7000 qui seront proposées à un tarif équivalent par AMD dès qu'elles seront disponibles. Actuellement, on trouve les RX 7900XT à partir de 1060 euros. Nous ferons le point d'ici quelques jours pour une analyse performances/prix cohérente.

Comme à notre habitude, commençons par le benchmark Superposition 1.1 d'Unigine en DirectX et OpenGL :

Que ce soit via DirectX ou OpenGL, on note un gain net de 5 % environ dans le test 1080p Extreme. Un écart réduit à 1,5/1,9 % lorsque l'on est dans une définition 4K. Mais la GeForce RTX 4070 Ti reste en tête.

On note une autre différence qui peut avoir son importance : lors des différents tests, la GeForce RTX 3090 a vu la température de son GPU grimper à 70°C, contre 53/55°C dans le cas de la GeForce RTX 4070 Ti. Un écart dû principalement à la moindre consommation de cette dernière, qui génère donc moins de chaleur.

Regardons ensuite ce qu'il en est avec deux jeux aux moteurs assez gourmands, avec leurs paramètres graphiques au maximum, en 1440p et 2160p, Borderlands 3 et Assassin's Creed Valhalla :

Ici aussi, on se retrouve avec une légère avance de la GeForce RTX 4070 Ti (5 à 7 %) en 1440p, qui disparait en 2160p, la RTX 3090 repassant devant, sans doute du fait de sa plus grosse bande passante mémoire. Mais n'oublions pas que cette similarité des performances se fait avec une bien meilleure efficacité énergétique sur la RTX 4070 Ti grâce à l'architecture Ada Lovelace.

Ainsi, dans le benchmark intégré à Borderlands 3 (Brutal, 2160p), on obtient les scores suivants :

- RTX 3090 : 515,38 watts soit 7,16 joules par image caculée

- RTX 4070 Ti : 414,84 watts, soit 5,80 joules par image caculée (-19 %)

RTX et DLSS 3

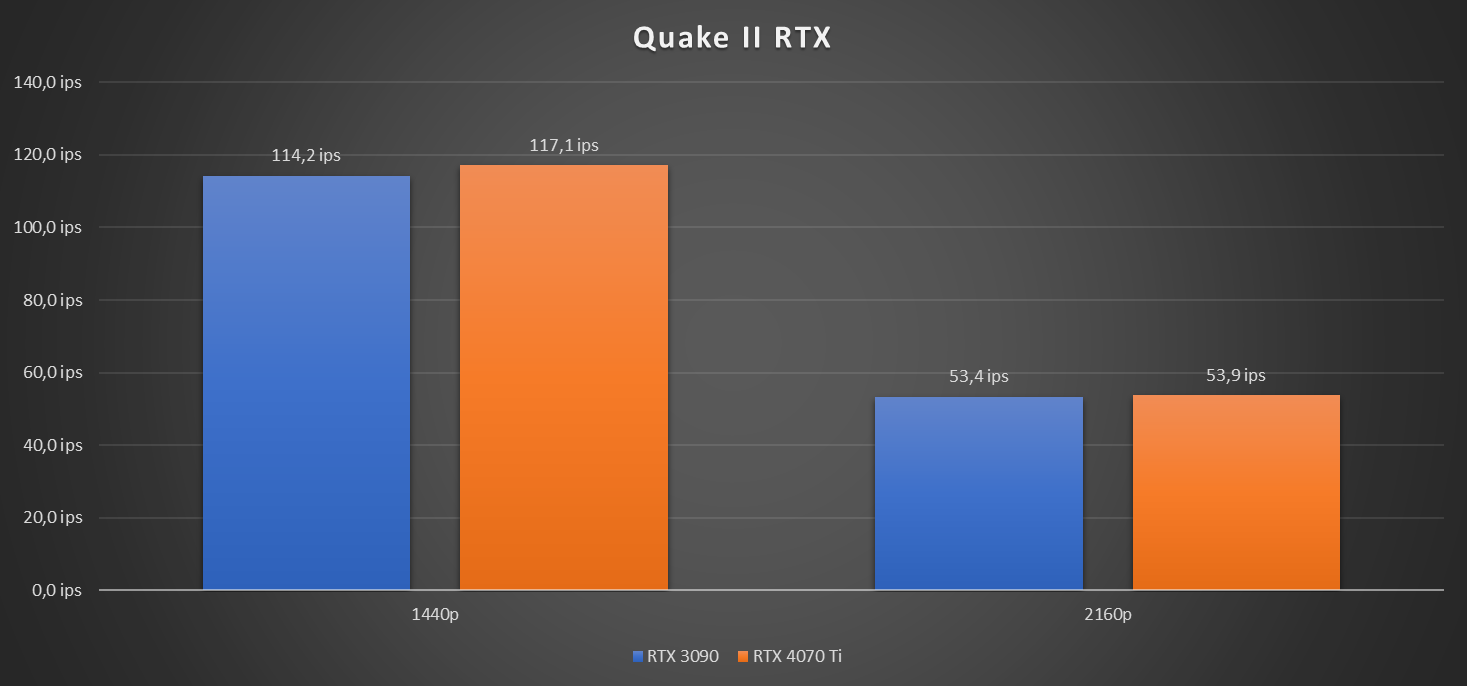

Pour ce qui est du ray tracing, voici les résultats obtenus avec Quake II RTX :

Ici, malgré les capacités supérieures de la GeForce RTX 4070 Ti et le fait que l'on soit sur un scénario de rendu complet en ray tracing, on note un score similaire, avec seulement un avantage de 1 à 2,5 %.

Dans le cas du Deep Learning Super Sampling (DLSS), sa version la plus récente exploitant les possibilités de l'architecture Ada Lovelace ouvre la voie d'une nouvelle fonctionnalité : la génération d'images. Ainsi, outre le fait d'effectuer le rendu dans une définition inférieure avec un agrandissement grâce à un modèle entraîné via une IA, la carte graphique est capable d'utiliser les Tensor Core pour générer des images et améliorer la fluidité.

Pour savoir ce qu'il en est, nous avons effectué une série d'essais avec le jeu F1 22, qui est l'un des premiers à exploiter DLSS 3 avec différents niveaux de qualité et la génération d'images par l'IA :

Ici on est sur un constat similaire : la carte est au niveau de la RTX 3090 le plus souvent, avec un avantage pour cette dernière dans des cas assez gourmands (ici le DLAA). Mais la RTX 4070 Ti se démarque avec la génération d'image, lui permettant d'aller chercher des performances supérieures à moindres frais. Surtout que sa consommation est aux alentours de 404 watts dans ce test, contre 563 watts pour la RTX 3090.

GeForce RTX 4070 Ti : efficacité et performances, quid du prix ?

Comme on a pu le voir, la promesse de parité entre la GeForce RTX 4070 Ti et la RTX 3090 est tenue. Mais elle n'a pas de quoi être au niveau de la RTX 3090 Ti, surtout dans des situations gourmandes en bande passante mémoire, comme la 4K. Mais ce n'est pas si grave, pour deux raisons.

La première est la consommation réduite : on est à 100/150 watts de moins qu'un modèle de génération précédente pour des performances meilleures ou similaires, de quoi faire grimper en flèches l'efficacité, notamment dans des cas comme la compression vidéo où Ada Lovelace dispose de deux moteurs NVENC et de l'AV1.

On a aussi droit à des fonctionnalités comme DLSS 3 et la génération d'images qui arrivent dans un nombre croissant de jeux et ouvrent des voies intéressantes en termes de performances à très haute définition pour une telle carte... annoncée à 899 euros. Nous verrons demain chez les revendeurs ce qu'il en est.

Car là réside la capacité de succès de cette carte. Positionnée à ce prix, elle est moins chère que la Radeon RX 7900 XT d'AMD qui est positionnée de manière similaire en termes de performances. S'il y a un écart tarifaire, ce sera à l'avantage de NVIDIA. Si AMD s'aligne ou propose une alternative, ça se discutera au gré des benchmarks.

Une chose est sûre, cette GeForce RTX 4070 Ti, bien qu'un peu grosse dans un PC, a tout pour plaire. Le modèle de Gigabyte ici testé est parfaitement silencieux et bien conçu, avec une ventilation semi-passive et des effets de couleurs qui plairont à certains. Espérons qu'un tarif dépassant les 1000 euros ne viendra pas gâcher la fête.

Commentaires (28)

#1

900€ quand même, peut-être qu’une 4070 classique arrivera dans une zone de prix envisageable pour moi.

Toute façon rien ne presse, je joue à la version steam de Dwarf Fortress en ce moment, je n’ai pas de soucis de FPS

Ma Radeon 5700XT me satisfait en 1440P, mais sur certains jeu 4K sur la TV, c’est parfois un peu juste.

#1.1

Ma 5700XT Nitro+ a un peu de mal sur Cyberpunk 2077 en 1080p (OK, j’ai bourriné sur les options en mode “tout à fond” 😅).

#2

Cela reste hors de portée de ma bourse , mais on va dans la bonne direction par rapport à la génération précédente en terme de rapport perf/conso.

, mais on va dans la bonne direction par rapport à la génération précédente en terme de rapport perf/conso.

Reste que malheureusement elle ne sera pas vendue par Nvidia, donc peut de chance de la voir au tarif annoncé. De plus pour se démarquer de la concurrence, j’ai bien peur que les constructeurs vont malheureusement tenter de vendre des versions boostées, ruinant ainsi les pseudo bons rapports perf/prix et surtout perf/conso .

Il faudra être à l’affut de la bonne affaire, perso j’attends plutôt la 4060 voir la 4060TI selon les tarifs.

Merci pour ce test et bonne année à tous !!!!!

#3

Un petit détail sur cette carte : il n’y aura pas de model de référence pré fait par Nvidia.

Les partenaires devant faire leur propre models pour cette carte + le fait qu’à la base c’était un model avec un prix de vente 50$ plus haut (la 4080 12gb) qui avait probablement déjà été acheter avant la réduction de prix + Nvidia qui est de plus en plus dure avec les partenaire (la marge Nvidia augmente pendant que celle des partenaires diminue). Tout ça fait pas bon présage pour la tarification

#3.1

Dans l’article :

Pour les tarifs on verra, normalement il y aura pas mal de modèles aux alentours des 900⁄920 euros, mais je préfère attendre de voir ce que diront les stocks à la mise en ligne Pour le reste, la spéculation et les racontars ne servent jamais à grand chose, surtout pour des accords commerciaux de cette ampleur dont peu de personnes ont réellement connaissance (mais les constructeurs et partenaires savent très bien “dealer” ce genre de changement).

Pour le reste, la spéculation et les racontars ne servent jamais à grand chose, surtout pour des accords commerciaux de cette ampleur dont peu de personnes ont réellement connaissance (mais les constructeurs et partenaires savent très bien “dealer” ce genre de changement).

#3.2

Même à 900E c’est du délire, je me souviens quand la 1070 battait la 980ti, mais à un MSRP de 400$. Certes, c’est la version TI, mais quand même. Les fabricants ont complètement craqué avec les prix, d’ailleurs il y a du stock partout, j’espère que ça va les faire bouger.

#4

250 euro de trop encore

#4.1

250 ? plutôt 500 de trop oui… J’ai acheté ma GTX 1660 Ti 310€ il y a trois ans, aujourd’hui pour un prix équivalent on trouve (difficilement) des RTX 3050 ou des RX 6600 qui offrent des performances à peine supérieure… Alors oui ces cartes supportent des choses comme le Ray Tracing et le DLSS mais pas de quoi justifier le remplacement.

Reste à espérer que les RTX 4060 et RX 7600 soit à un prix raisonnable (et pas 3⁄4 d’un SMIC) et offre enfin un vrai gain de performance.

#4.2

Pas grave, après les factures et els courses de bouffe il ne te resteras pas assez pour envisager un carte à 50 balles.

Oui les cartes sont plus cher qu’avant, mais inflation + coûts de production du node largement supérieur au précédent+ hausse de prix des wafer par TSMC (+20%).

#4.3

Ca risque de ne pas durer.

On entre maintenant dans une situation contraire à la pénurie qu’on a connu dans la “période covid”.

Il y a une certaine inertie dans les capacités de production et les stocks.

Ils ont augmenté les capacités de production pour rattraper la demande et maintenant qu’elles sont plus hautes, la demande a chuté.

Le sud-coréen a averti que ses profits s’étaient effondrés au dernier trimestre 2022. Le marché des puces électroniques se retourne et entre en récession

https://www.lemonde.fr/economie/article/2023/01/06/samsung-la-chute-la-plus-spectaculaire-depuis-huit-ans_6156840_3234.html

Overcapacities and lessening demand will likely lead to an approximate 20% drop in the semiconductor industry this year.

https://www.electronicdesign.com/technologies/embedded-revolution/article/21257375/objective-analysis-understanding-the-2023-chip-market-collapse

Desktop GPU Sales Hit 20-Year Low

https://www.tomshardware.com/news/sales-of-desktop-graphics-cards-hit-20-year-low

#4.5

La baisse sera valable uniquement pour les produits déjà en bôite pour limiter les stocks qui sont de l’immobilisation (30x0 chez nVidia), pas ou bien moins pour les nouveaux produits, qui resteront quoi qu’il arrive cher.

LA seule boite ou presque qui peut tirer les prix vers le bas “facilement” c’est Appel, parce qu’ils réservent bien en avance et qu’ils paient cash vu qu’ils ont la puissance financière pour.

Se plaindre de l’augmentation et se plaindre du coût de la carte sont deux choses différentes.

Se plaindre que les carte de 2022 sont plus cher que les cartes de 1997 en disant “Ah bah c’était moins cher avant” en ne tenant pas compte des facteurs communs à toute l’industrie, je suis. désolé, mais c’est stupide.

Se plaindre du coût élevé en 2022 des cartes et des profits faramineux des fabricants en même temps, là oui. Après, c’est aussi la loie de l’offre et la demande, en partie, et c’est pour cette raison que les prix vont redescendre sur une partie de la production (30x0 chez nVidia, sur les 40x0 pas certain que ça baisse tant que ça).

#4.4

Je peux aisément acheter cette carte tous les mois mais crla ne les vaux pas, même en compant 20 % d inflation par rapport à la génération précédente, c est trop cher .

J investit dans ce qui rapporte, et je ne suis pas la pour renflouer le cours de leur action.

#5

Le rapport conso/perf est intéressant en tous cas. Plus que la RX 7900 XT qui risque de baisser en prix.

C’est en fin d’année que sort le FSR 3 côté AMD non ? Faudra voir ce que ça donne contre le DLSS3. C’est quand même assez dingue ces technos je trouve…

#6

quid de l’intérêt à miner des cryptos ? on va se faire chourrer les cartes encore ou ce n’est pas intéressant ?

#6.1

Pas très intéressant de miner avec son GPU en ce moment.

Avec entre autre la baisse des cryptos et l augmentation des prix de l électricité, ce n’est pas très intéressant actuellement. Pas d’inquiétude à avoir de ce côté.

Ca n empêche pas que s’il y a des 4070 TI au prix “officiel”, elles vont partir très vite.

Il n y a qu à voir les problèmes de disponibilité de la RX 7900 XTX ou de la RTX 4090 (difficile à trouver au MSRP).

Les seuls cartes de la nouvelle gen qu’on trouve facilement au prix officiel sont la 7900 XT et la 4080 qui ont toutes les deux la réputation d’avoir un mauvais rapport perf/prix.

J’espère que les prix et la disponibilité vont s améliorer dans les mois à venir

#6.2

Il y a des tendances dans les cryptos, comme passer d’un proof of work très (trop?) énergivore à un proof of stake bien meilleur sur ce point, et enfin certains pays commencent les taxations comme l’Italie.

Ici un expert propose un mix en taxant beaucoup plus fortement les énergivores :

https://www.schneier.com/blog/archives/2023/01/decarbonizing-cryptocurrencies-through-taxation.html

De tout cela, le besoin en GPU pour le minage diminue.

Je crois même que NVidia ne bride plus ses cartes grand public sur les fonctions de hachage. D’un autre côté son bridage était contourné par des firmwares spécifiques, comme d’autres bridages (flux vidéos…).

#6.3

D’un autre coté le “LHR” de nvidia ciblait spécifiquement le minage Ethereum or ce dernier est passé en proof of stake l’été dernier donc il ne sert plus à grand chose. Et en effet, il avait (en grande partie) été contourné avant même cette date.

#7

Pas assez de VRAM, mon fils….

#8

A part en cas de grosse baisse de prix, cette génération de cartes s’appelle ‘non merci, je passe’…

Il n’y a pas de “Founder Edition” pour ce modèle, il est donc extrêmement peu probable qu’à ce stade il y ait des cartes au prix officiel… peut-être quand les RTX 5060 seront annoncées

#9

Les tarifs sont maintenant affichés sur le site d’un revendeur français connu : entre 899,95 € et 1239,95 € selon le modèle. Même sans FE, la promesse du prix est tenue. Evidemment, les modèles les moins chers sont en rupture.

#9.1

Oui et il y a eu une meilleur disponibilité que ce j’imaginais pour le lancement.

Il y a eu des modèles à 899 euros dispo pendant plusieurs heures pour le lancement.

(Et même maintenant, j’en vois encore 1 commandable avec dispo sous 7 jour).

A voir comment ça évolue dans les prochaines semaines

#10

Ça reste de la carte haut de gamme.

J’espère que les 4060 et 4050 seront vraiment accessibles… Pas comme la génération précédente.

#11

J’ai un slot PCIe 3.0 16x. Cette nouvelle carte est en PCIe 4.0 16x.

On est d’accord que c’est compatible (et même que la perte de perf est négligeable) svp ?!

#11.1

Exact

https://www.techspot.com/review/2104-pcie4-vs-pcie3-gpu-performance/

#12

Je ne sais pas à quel point cette comparaison est pertinente en fait. Ces cartes n’ont pas du tout la même cible, du moins officiellement.

En effet, avec ces 24Go de mémoire, la 3090 a toujours été présentée comme étant avant tout pour les professionnels.

Ici la 4070 Ti obtient des performances équivalentes mais il s’agit bien d’une carte gaming qui ne sera pas optimale pour tous les scénarios de création graphique, notamment ceux nécessitant bcp de mémoire graphique.

#13

Merci, mes souvenirs ne me font pas défaut donc !

#14

Sony annonce qu’il n’y a plus de pénurie pour les PS5, on attend l’annonce de NVIDIA

#15

En pratique, j’ai l’impression que les 10GiB de ram de ma 3080 sont insuffisants pour les jeux en “4K tout à fond”, et ce dès la sortie de la carte. On voit clairement qu’elle se met à ramer à cause de transferts intempestifs sur le bus PCI express, y compris sur de vieux titres avec de grosses textures et peu d’effets. Donc le coup du “équivalent à la 3090” mais avec 12GiB de ram, je n’y crois pas…