Cette année, la GTC de fin d'année de NVIDIA n'a pas été que l'occasion d'annoncer des nouveautés à destination des professionnels. Jen Hsun Huang a profité du début de sa conférence pour viser les joueurs avec une bonne nouvelle : les GeForce RTX de série 40 arrivent dès le 12 octobre. Mais...

La GPU Technology Conference de NVIDIA est un évènement organisé deux fois par an, servant à la société à mettre en lumière ses technologies telles qu'elles sont conçues et déployées par ses équipes et ses partenaires dans de nombreux secteurs, de la conception 3D au domaine médical en passant par la robotique ou la recherche.

Bref, il s'agit principalement d'un moment consacré aux « pros », où il est surtout question de frameworks, API et kits de développement, de nouvelles cartes graphiques/réseau pour stations de travail et pour serveurs, de switchs capables de traiter plusieurs dizaines de Tb/s, de métavers et autres solutions émergentes.

H100 arrive, un nouveau Jetson Nano

Lors de la précédente édition, l'architecture Hopper avait été dévoilée. Équipant la carte H100, elle est composée de pas moins de 80 milliards de transistors gravés en 4 nm par TSMC. Elle gère DPX, dispose de HBM3 et de nouveaux accélérateurs comme le Transformer Engine qui doit réduire drastiquement le temps d'entraînement de modèles IA lourds, prenant en compte des milliards de paramètres, comme BERT, GPT-3, ou Dall-E. On apprend aujourd'hui qu'elle sera proposée dans de premiers serveurs de partenaires à compter du mois prochain.

Mais Jen Hsun Huang a également annoncé le module Jetson Orin Nano qui sera proposée à partir de 199 dollars en janvier 2023, peu après la mise en ligne du JetPack SDK 5.1, son OS Linux maison basé sur Ubuntu. Ce module dispose de 6 cœurs ARM Cortex-A78 (v8.2), d'une solution graphique à 512 ou 1 024 cœurs Ampere, de 4 à 8 Go de mémoire, avec un TDP compris entre 5 et 15 watts selon la configuration et les versions.

Elle pourra être utilisée au sein du même kit de développement que les Jetson Orin NGX/AGX annoncés en début d'année. Elle est, selon NVIDIA, jusqu'à 80 fois plus performante que l'actuelle Jetson Nano : 40 TOPS (IINT8).

Thor prend le pouvoir dans les voitures, IGX et services cloud

On a également eu droit à l'annonce d'une nouvelle plateforme Drive pour les véhicules autonomes de 2025 : Thor. Cette carte est équipée d'une puce de 77 milliards de transistors avec un GPU de prochaine génération et un CPU Grace. Elle sera capable de gérer différents systèmes (Android, Linux, QNX), en offrant une capacité de calcul globale de 2 000 TFLOPS (FP8). Une alternative à la multiplication des composants selon le constructeur.

La plateforme unifiée Drive Thor arrive dans les véhicules autonomes de 2025

Une plateforme IGX a également été évoquée pour le domaine de la robotique et du médical. Il s'agit cette fois d'une carte mère avec un module équipé d’un SoC Orin intégrant un CPU + GPU de la génération actuelle (ARM + RTX Ampere), accompagnée de nombreux connecteurs, d'une gestion distante (BMC), de ports PCIe... Une preuve de plus que le constructeur cherche à remplacer les processeurs x86 sous toutes leurs formes.

Mais NVIDIA a aussi profité de cette GTC de fin 2022 pour annoncer que la société entrait elle aussi dans l'ère des services. Ainsi, après son GeForce Now commercialisé auprès des joueurs, Omniverse est proposé en SaaS dans une version « Cloud », tout en pouvant être déployé par des partenaires. Il en sera de même pour des modèles IA LLM tels que NeMO ou sa déclinaison Bio à destination des chercheurs (calculs sur protéines, ADN, etc.). D'autres devraient suivre au fil des mois et prendre une part plus importante dans le modèle économique.

Néanmoins, ce que beaucoup retiendront de cette édition de la GTC est qu'elle a été l'évènement où ont été lancées de nouvelles GeForce RTX, ainsi que l'architecture Ada Lovelace. En effet, Jen Hsun Huang a ouvert sa conférence avec ces annonces, de nombreux détails ayant été distillés depuis. Nous devrions d'ailleurs nous entretenir avec les équipes du constructeur pour répondre à nos questions d'ici la mise en vente des premières cartes. Mais nous avions assez de matière pour un premier article condensant les informations importantes.

Ada Lovelace, nouvelle architecture des GeForce

Après Grace Hopper, c'est donc bien à la mathématicienne pionnière de l'informatique Ada Lovelace que NVIDIA rend hommage à travers la dénomination de son nouveau GPU destiné à des usages grand public. Pour rappel, il s'agissait précédemment de chercheurs et scientifiques comme (Blaise) Pascal ou (Alan) Turing.

Première nouveauté, donc : on en revient à une segmentation des usages et des noms, avec des solutions différentes selon les marchés, là où la précédente architecture Ampere était déclinée selon les gammes. Il faut dire que les besoins sont de plus en plus radicalement différents, ce qui explique le besoin de séparer les conceptions, même si certains éléments peuvent être réutilisés, comme les Tensor Cores ou la gravure en 4 nm par TSMC.

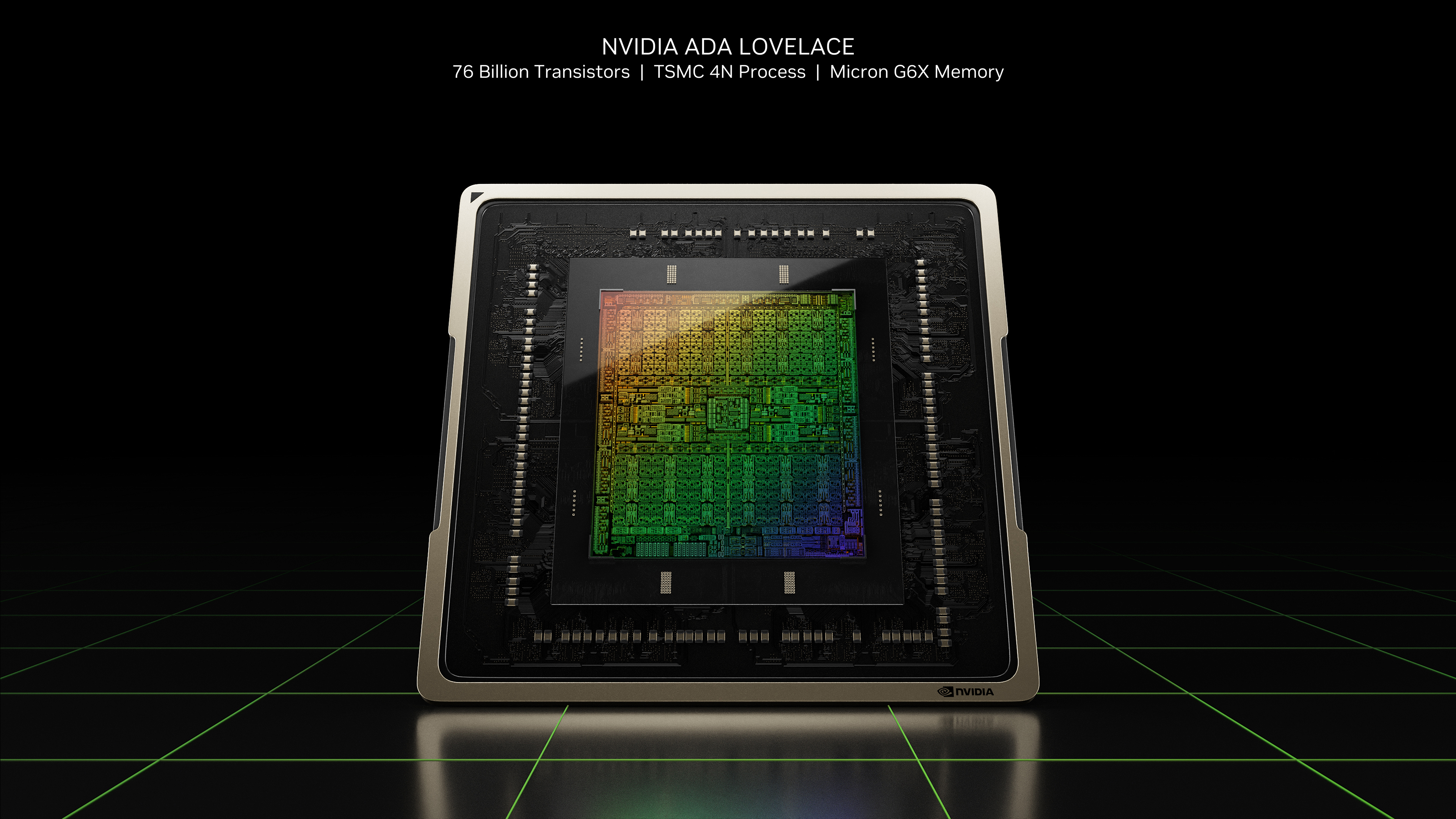

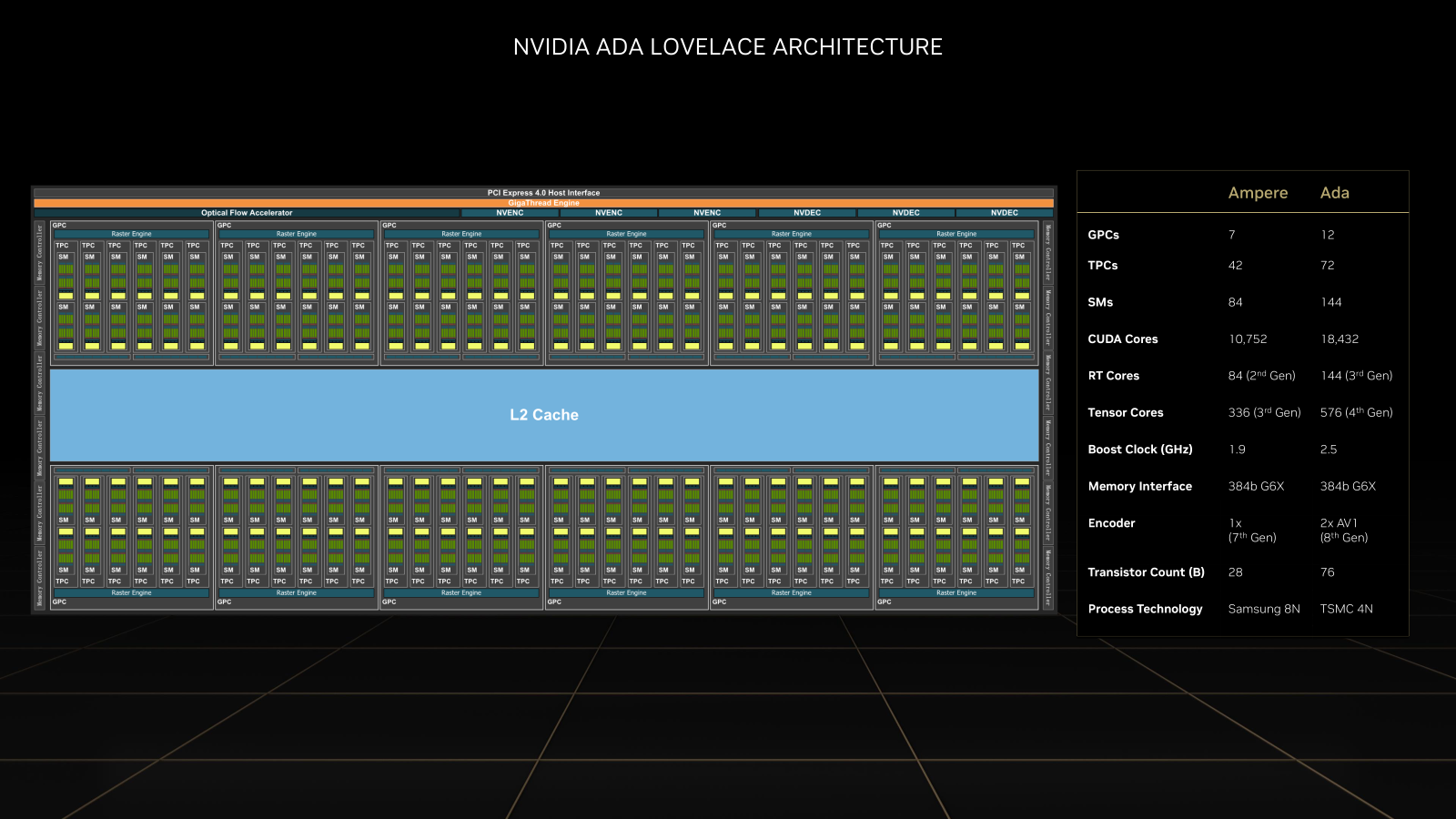

Pour le moment, on sait assez peu de choses de cette architecture, Jen Hsun Huang n'en ayant livré que les grandes lignes et les points forts. Il faudra attendre le livre blanc qui devrait être publié d'ici quelques semaines pour en savoir plus et analyser les choses en profondeur. Pour le moment, on sait que la puce complète se compose de 76 milliards de transistors pour un maximum de 18 432 CUDA Cores. Elle est accompagnée de GDDR6X Micron.

Dans le détail, elle est organisée en 12 Graphics Processing Clusters (GPC) contenant chacun 72 Texture Processing Clusters (TPC) avec 144 Streaming Multiprocessors (SM). On passe de 84 à 144 RT Cores, de 336 à 576 Tensor Cores. Chaque unité ayant au passage été améliorée. La fréquence maximale de la puce complète se situe aux alentours de 2,5 GHz, contre 1,9 GHz précédemment. Côté unités de calcul FP32/INT32, on reste sur un même équilibre par rapport à Ampere, soit 2:1. Il en est de même pour l'équilibre général de la puce.

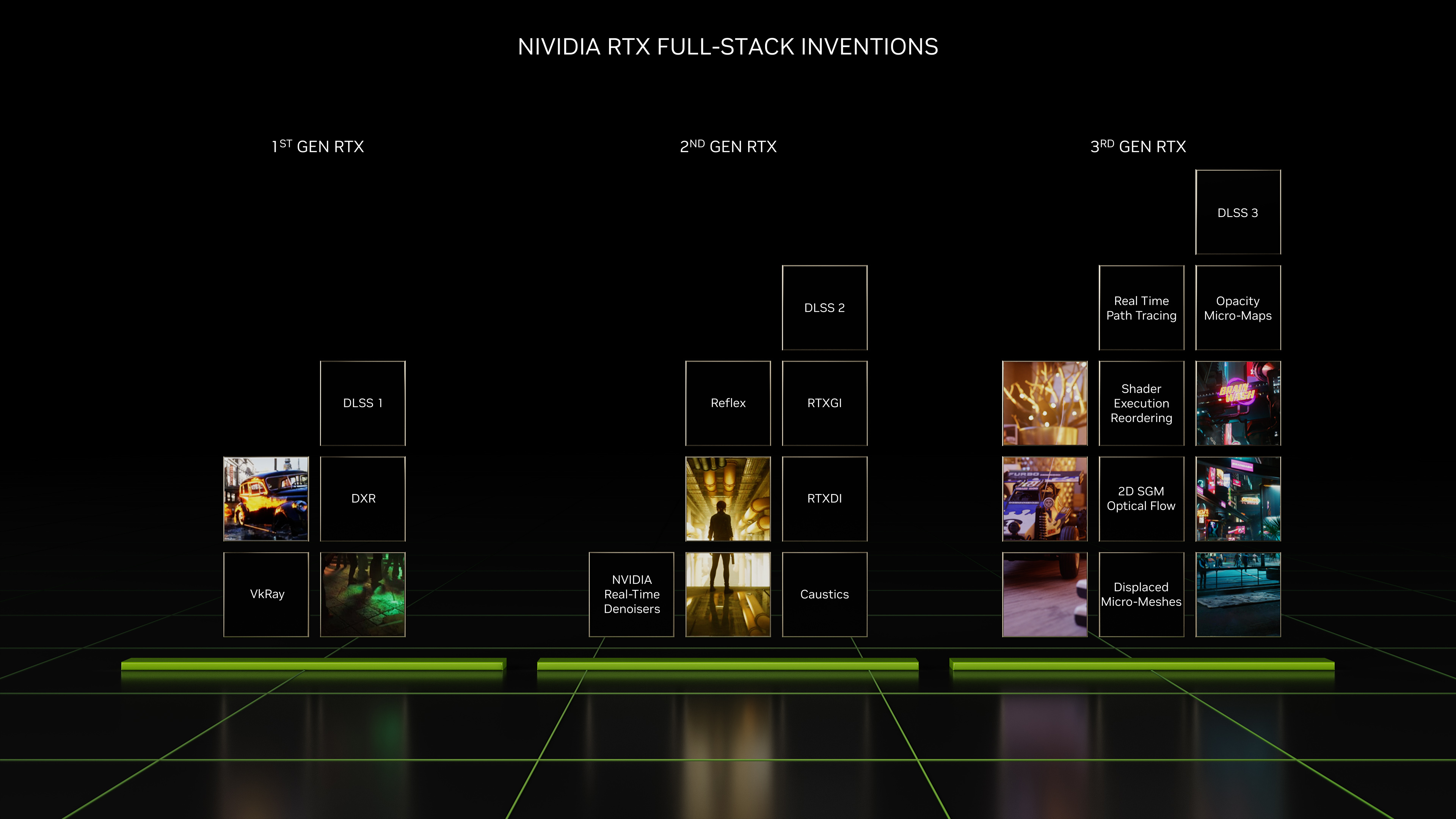

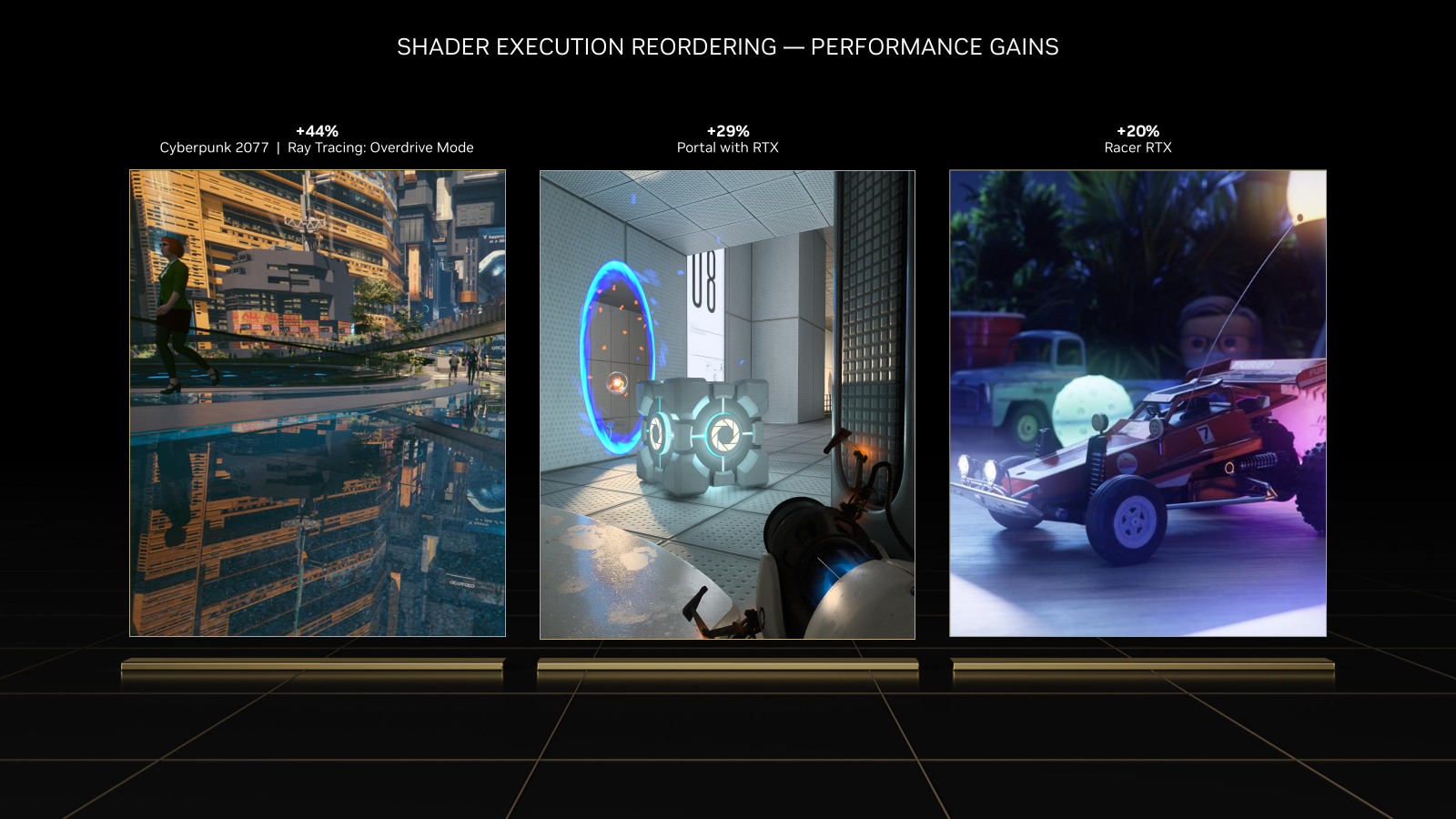

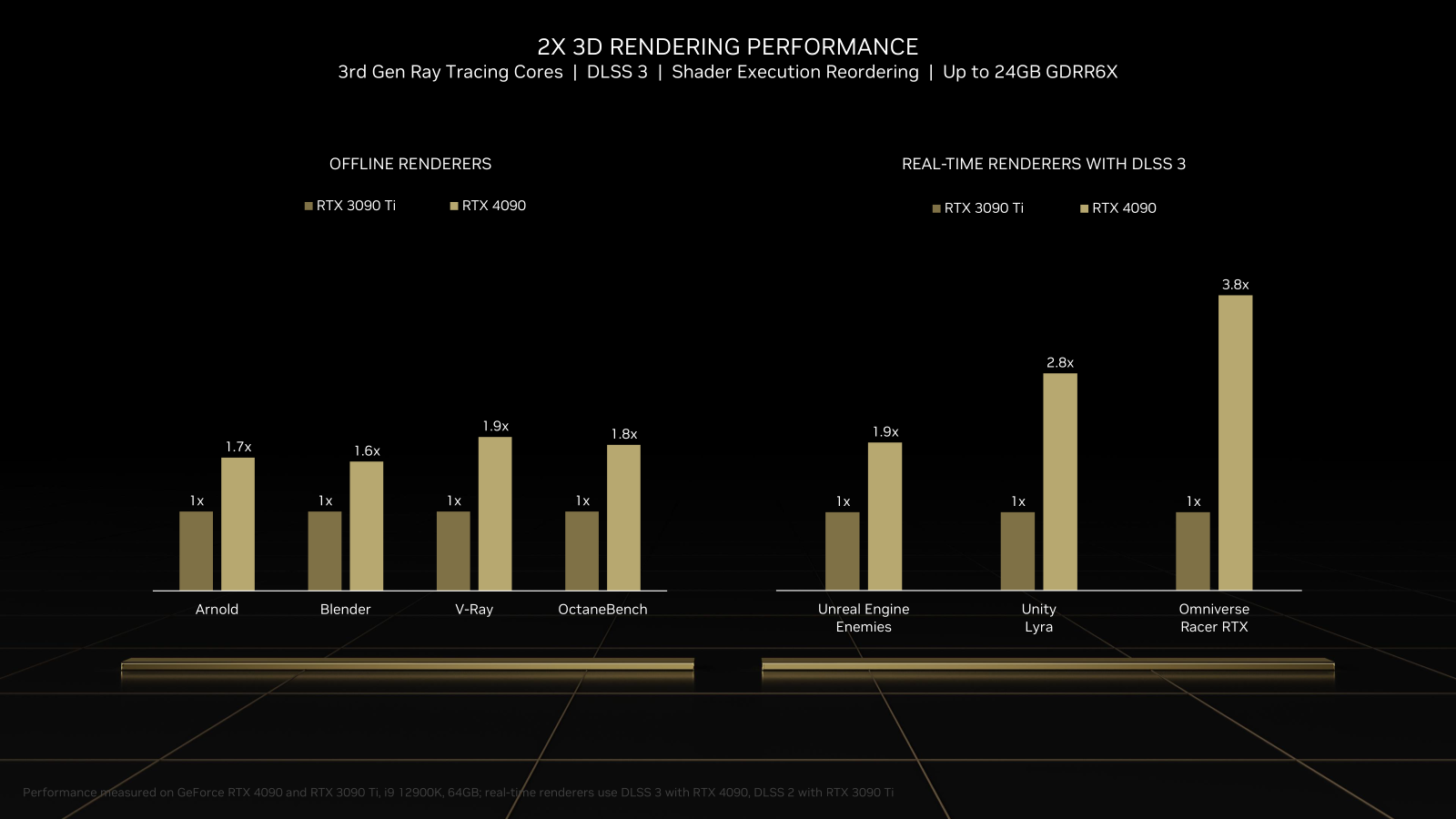

Côté puissance de calcul, on nous annonce 90 TFLOPS, contre 40 TFLOPS pour la GeForce RTX 3090 Ti lancée en mars (10 752 CUDA Cores). Les Streaming Multiprocessors ont été repensés pour être capables de réagencer les instructions à exécuter et être plus efficaces (Shader Execution Reordering), les RT Cores passent à la 3e génération (200 RT TFLOPS), les Tensor Cores à la 4e (1 400 Tensor TFLOPS). Bien plus qu'Ampere.

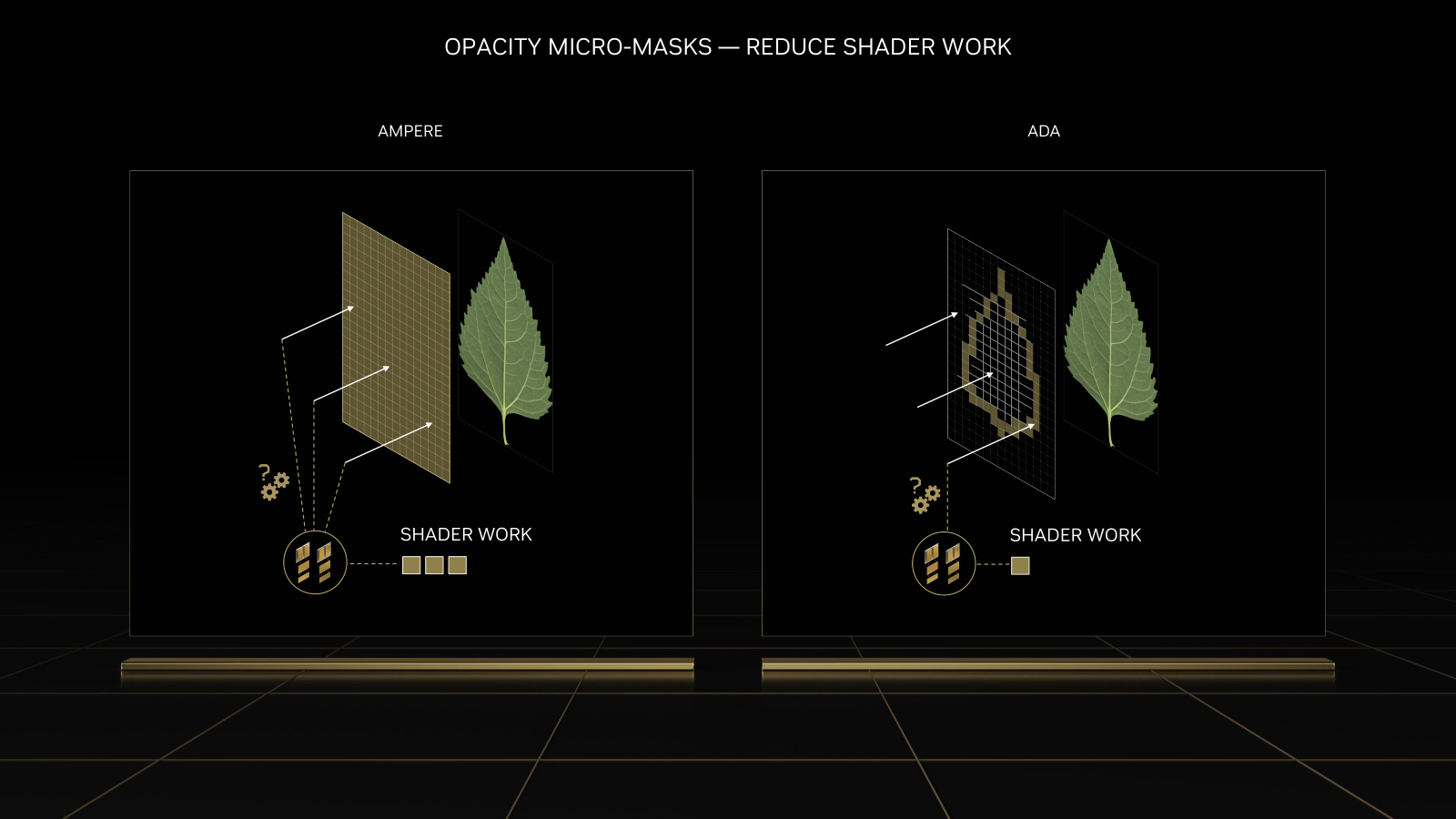

Un gros travail aurait également été mené en lien avec les développeurs pour améliorer les performances dans le cadre des jeux et applications exploitant le ray tracing, où le rendu est repensé dans son ensemble par rapport à l'habituelle rasterisation. Outre les 20 à 44 % de gain promis par la réorganisation de l'exécution des shaders, des fonctionnalités d'optimisations ont été introduites comme les opacity micro-masks/maps, permettant de réduire la zone où sont appliqués des shaders , sans avoir à la déterminer.

Les displaced micro-meshes permettent, eux, de créer des surfaces d'apparence complexe à travers un triangle et une displacement map pour simplifier le calcul de la manière dont les rayons de lumière doivent intéragir avec lui. Des exemples sont donnés sur différents objets avec des ratios de réduction importants du stockage nécessaire et de la construction de l'arbre d'analyse pour les rayons (BVH). Il sera intéressant de voir les effets en pratique. NVIDIA et ses partenaires ont pour cela créé des outils pour que les développeurs puissent en tirer parti.

Au final, NVIDIA annonce que son nouveau GPU est deux fois plus efficace énergétiquement que la génération précédente. Mais surtout, que la puissance de calcul d'une seule carte est bien plus importante grâce à l'ensemble des technologies et améliorations introduites par l'architecture Ada Lovelace.

On apprend au passage qu'une version RTX de Portal est attendue pour novembre, elle sera proposée comme un DLC offert aux possesseurs du jeu. NVIDIA veut d'ailleurs favoriser de telles adaptations en fournissant un outil dédié aux fans de mods en tous genres, sous le petit nom de RTX Remix.

DLSS 3 est déjà là

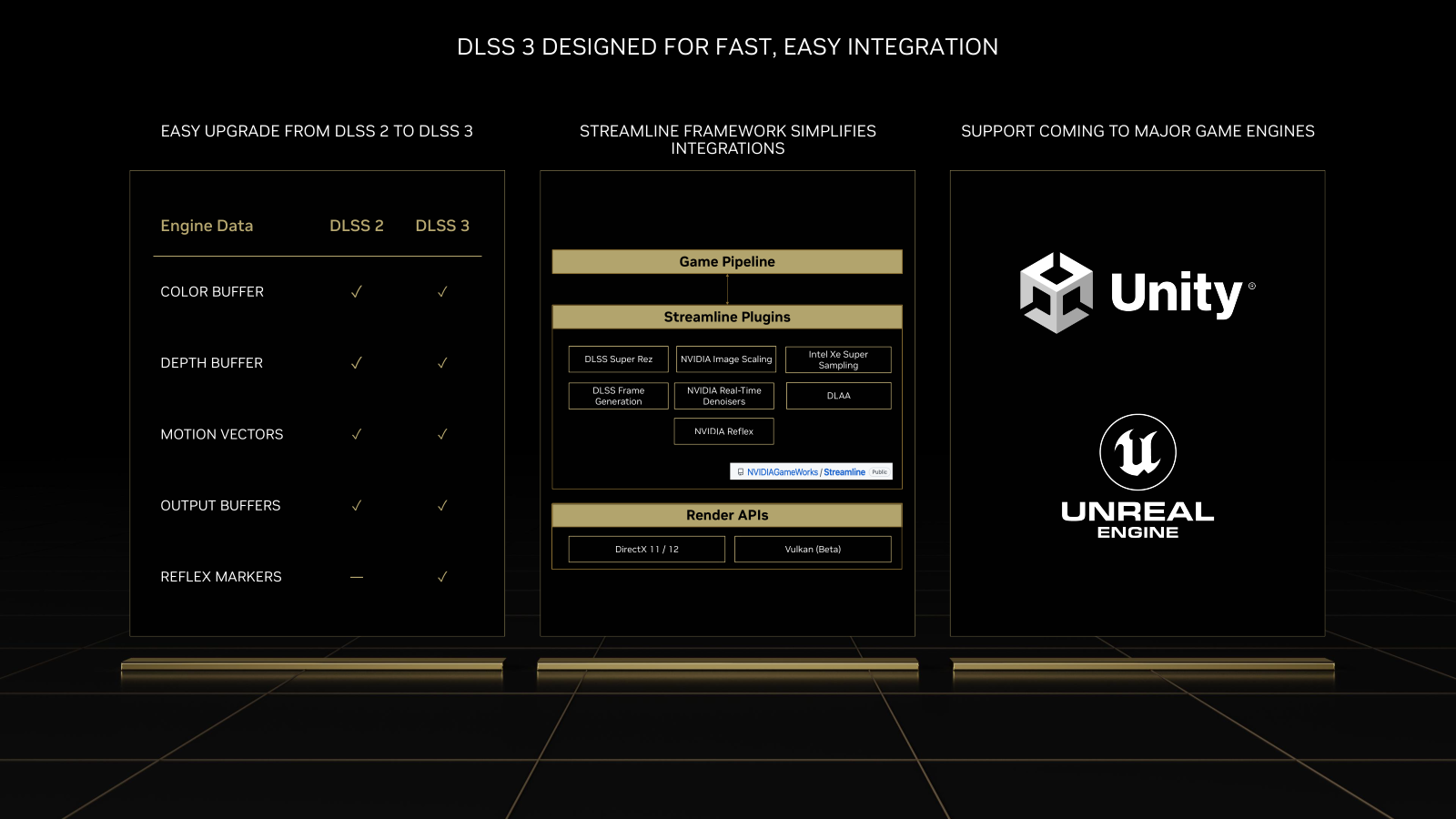

L'un des exemples donnés est DLSS 3. Une technologie qui semble présentée comme exclusive à la série 40 des GeForce RTX, mais nous n'avons pas encore pu échanger avec NVIDIA sur ce point. La raison ? Elles intègrent un OpenFlow Accelerator prenant en compte par cette nouvelle version de la solution d'amélioration de l'image.

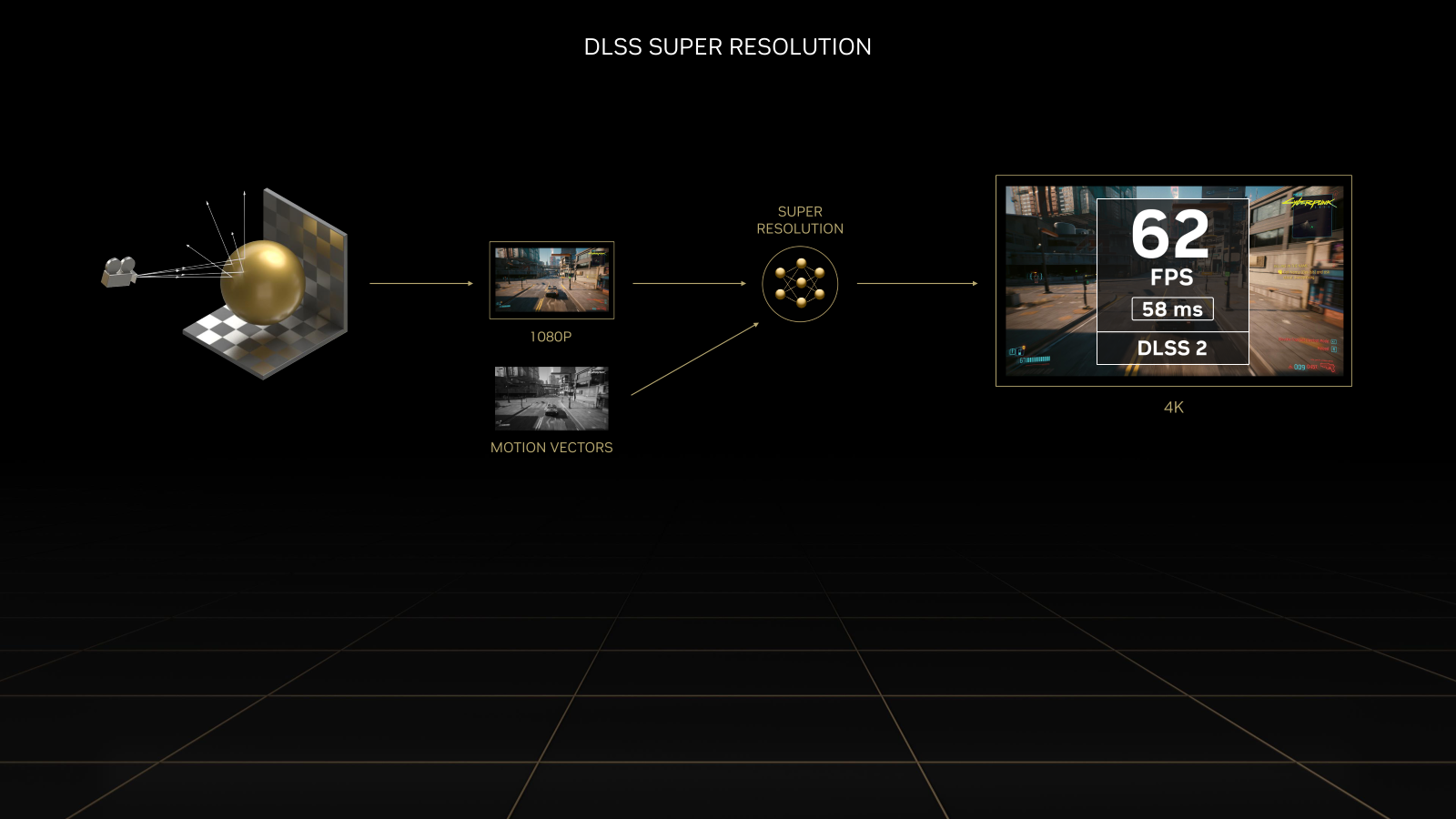

Pour rappel, elle consistait précédemment à calculer le rendu d'un jeu dans une définition moindre que celle demandée puis à la repasser en taille nominale grâce à une IA spécialement entrainée pour cela, appliquée via les Tensor Cores. De quoi afficher des performances bien meilleures avec une qualité d'image assez bluffante dans les versions 2.x de DLSS, la première ayant connu quelques ratés à son lancement.

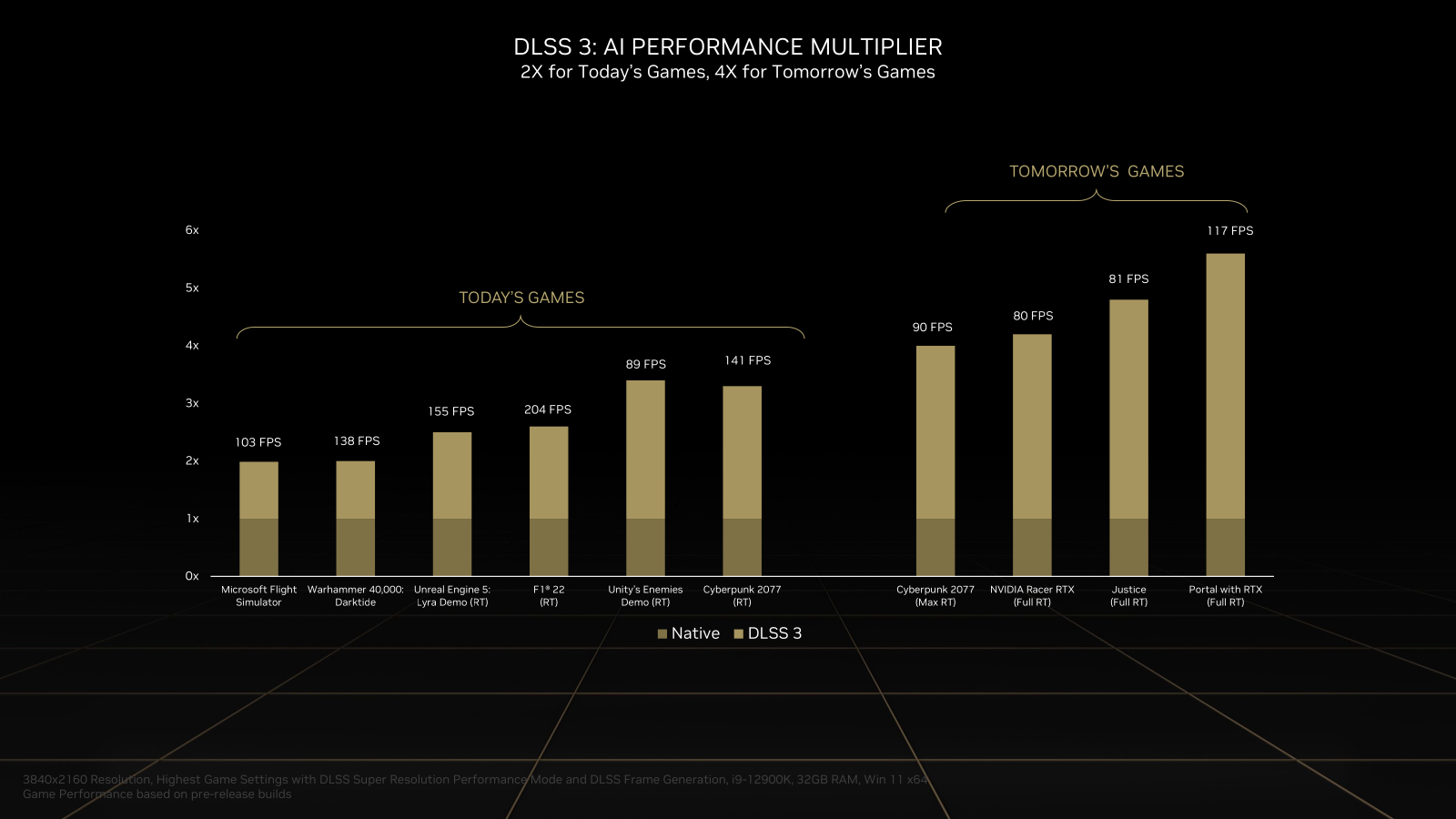

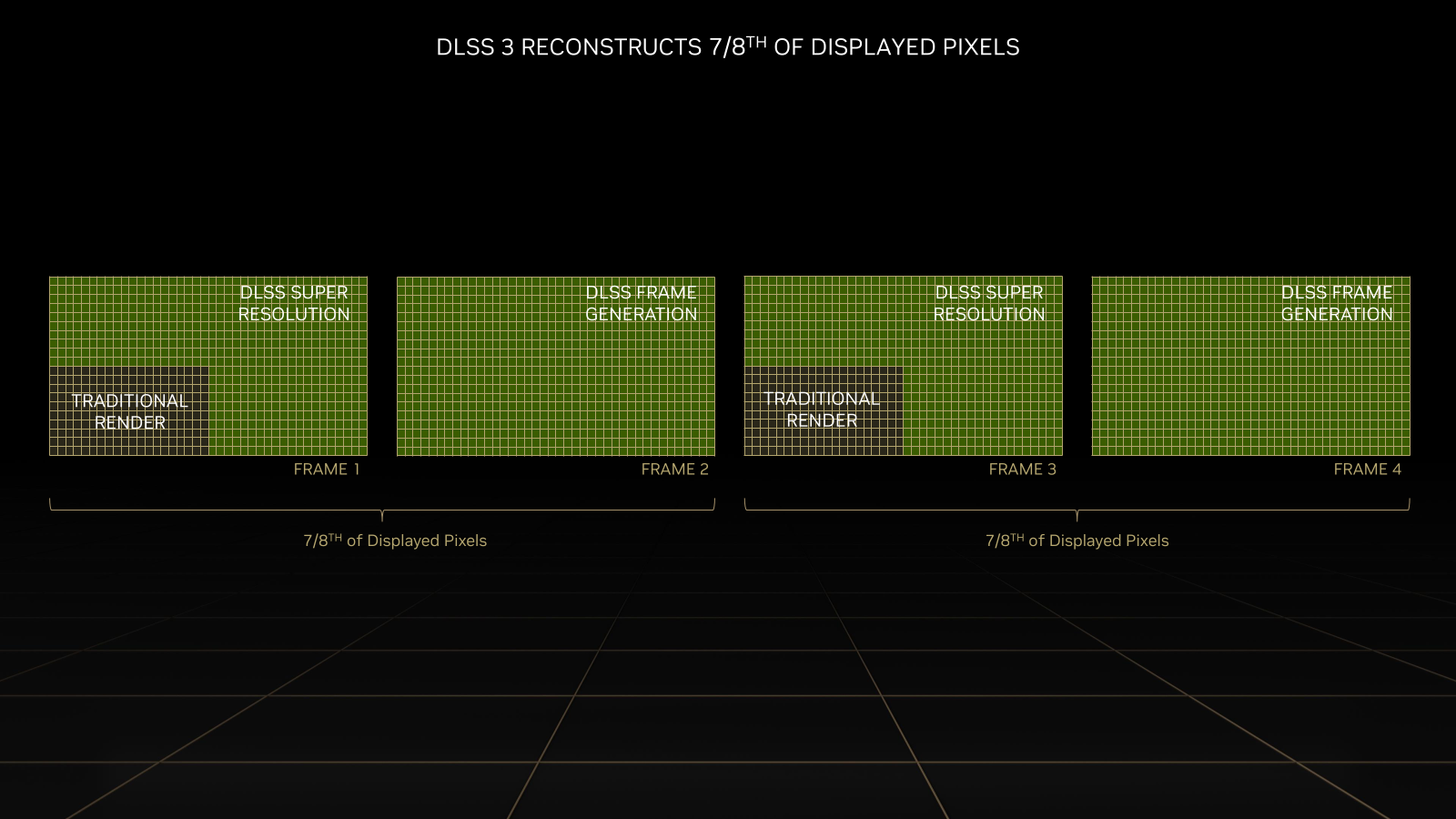

Quelle est la nouveauté de DLSS 3 ? Elle est capable d'ajouter des images intermédiaires entièrement créées par ses soins (AI Frame Generation) et donc augmenter d'autant le nombre d'images par seconde produites et la fluidité. Notamment grâce à l'OpenFlow Accelerator, dont NVIDIA nous a indiqué qu'il était nécessaire pour exécuter cette tâche avec de bonnes performances. Ainsi, les GeForce RTX de série 20/30 ne pourront pas en profiter.

En effet, pour générer de nouvelles images intermédiaires, il faut calculer en temps réel les différences entre deux existantes et « deviner » la couleur des pixels de ces zones. Pour cela, il faut notamment une analyse fine du mouvement des différents éléments de la scène. Selon les tests de NVIDIA, cela ne peut se faire de manière fine à travers les seuls motion vectors, d'où l'introduction de son analyse « optical flow », plus fine mais très gourmande en calcul. Elle n'est d'ailleurs pas parfaite de l'aveu même de NVIDIA qui précise qu'elle est utilisée de manière complémentaire aux motions vectors, de manière à disposer d'un rendu final sans artefacts.

Plus de 35 jeux sont d'ores et déjà prêts à utiliser DLSS 3 avec la génération d'image par l'IA, qui sera simplement désactivée sur les cartes qui ne peuvent pas en profiter. C'est notamment le cas de Flight Simulator qui est plutôt connu pour être limité par le CPU. De quoi afficher des performances de plus de 100 ips dans ce titre. Une vidéo de démonstration a même été publiée afin de montrer les écarts constatés en pratique.

Soyez donc prudents avec les niveaux de performances annoncés par NVIDIA sur les GeForce RTX de série 40 pour le moment, qui sont en général le fruit de l'activation de DLSS 3 seulement sur ces cartes. La société est néanmoins confiante, expliquant que le potentiel de cette technologie reste encore a découvrir et qu'il sera croissant lorsqu'il sera pleinement pris en compte par les développeurs, les gains étant déjà très élevés avec quelques jeux à venir.

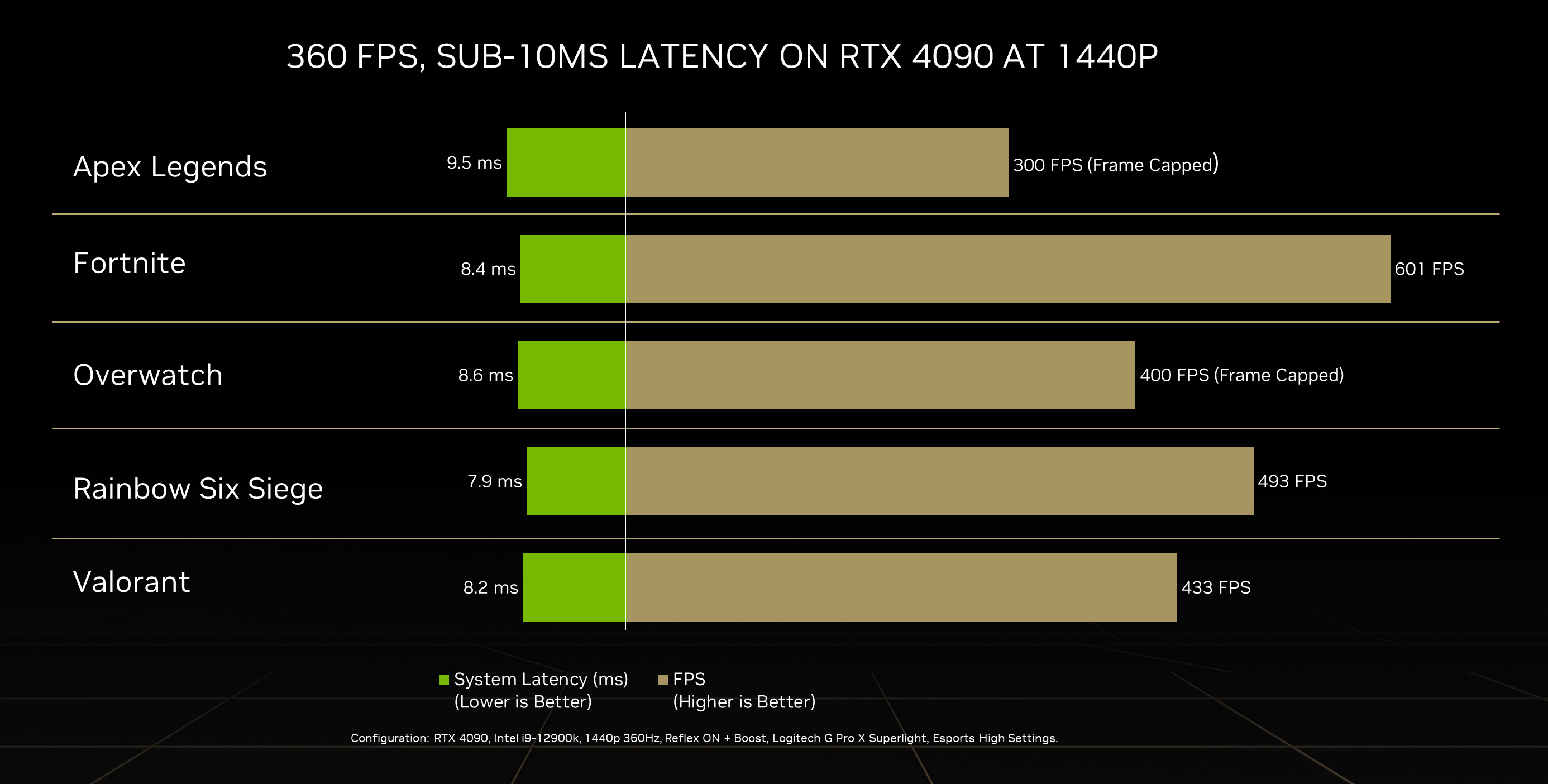

Le constructeur en profite pour évoquer un sujet qui prend de l'importance dans son discours : la manière de relever les niveaux de performances. Plus que la simple moyenne d'ips ou les niveaux mini/maxi, l'entreprise indique que la latence du système est un critère de choix pour les joueurs, ce qui lui permet au passage de vanter son initiative Reflex. Un sujet sur lequel nous aurons bientôt l'occasion de revenir plus en détails.

DLSS 3 semble également prendre plus de poids dans les arguments « Studio » visant les créateurs, puisqu'il est utilisé dans un nombre croissant d'applications et une source de gain de performances dans différentes situations : le temps de rendu 3D qui peut être très réduit ou la fluidité dans le viewport.

La compression matérielle AV1 fait son entrée

Autre nouveauté attendue : après la décompression AV1 gérée par NVDEC dans la génération précédente, c'est la compression qui arrive dans le moteur NVENC de 8e génération. La matrice des fonctionnalités vidéo de NVIDIA n'est pas encore à jour, mais cela devrait être utile dans des usages de type streaming, bureau distant, etc.

En effet, AV1 est pour rappel un codec bien plus efficace dans son rapport qualité/poids d'image, tout en étant dépourvu de royalties, ce qui permet un usage large et dans de nombreux outils, notamment open source. On note que sur les GeForce RTX annoncées deux moteurs NVENC (8e génération) sont présents, un NVDEC (5e génération).

NVIDIA dit avoir travaillé en lien avec l'écosystème pour que cette nouveauté soit prise en compte rapidement, notamment du côté d'outils très utilisés par les streamers tels qu'OBS, Discord, etc. Deux moteurs NVENC étant intégrés aux modèles annoncés aujourd'hui, le temps de compression peut être divisé par deux.

L'outil maison Brodcast, proposé sous la forme d'un SDK aux développeurs, est d'ailleurs mis à jour, intégrant des améliorations pour la gestion de l'image de fond, l'eye contact ou l'utilisation d'un avatar.

GeForce RTX 4090 : dès le 12 octobre, à 1 949 euros

La première carte à être disponible sera la plus chère : la GeForce RTX 4090. Elle sera mise sur le marché dans trois semaines, le 12 octobre. Pour le moment, nous n'avons pas d'information sur les quantités qui seront proposées par les revendeurs français ou par NVIDIA pour ses modèles Founders Edition. Mais le constructeur veut sans doute éviter le raté connu avec les RTX de série 30 du fait de la demande importante.

Ce modèle a été annoncé à 1 599 dollars, ce qui donne 1 949 euros TTC en France, parité euros/dollars oblige. Selon nos informations, les tests seront publiés puis les cartes disponibles, sans procédure de précommande. Cette dernière n'embarque pas un GPU complet, laissant de la marge pour d'éventuels modèles « Ti ». On a ainsi droit à 16 384 CUDA Cores cadencés entre 2,23 et 2,52 GHz. Côté mémoire il est question de 24 Go de GDDR6X avec un bus de 384 bits. Jusqu'à quatre écrans peuvent être gérés (avec HDCP 2.3) via un port HDMI 2.1 et trois DP 1.4a.

NVIDIA précise dans les petites lignes que l'on peut atteindre la « 4K 12 bits HDR à 240 Hz avec DP 1.4a + DSC. Jusqu’à 8K 12 bits HDR à 60 Hz avec DP 1.4a + DSC ou HDMI 2.1 + DSC. Avec double DP 1.4a + DSC, jusqu’à 8K HDR à 120 Hz. Rendu en 4K HDR à 120 Hz, en 8K HDR à 60 Hz et les fréquences de rafraîchissement variables, conformément à la norme HDMI 2.1a ».

La carte occupe toujours trois emplacements PCIe mais sa consommation maximale grimpe à 450 watts, comme pour la GeForce RTX 3090 Ti. Pour rappel, la RTX 3090 était, elle, annoncée à 350 watts. Ainsi, trois connecteurs PCIe à 8 broches seront nécessaires à son alimentation, ou un connecteur PCIe 5.0 adapté. Notez au passage que le port PCIe de la carte reste, lui, à la génération 4.0. Les dimensions sont de 304 x 137 x 61 mm.

Cette carte sera proposée en version Founders, qui comporte des améliorations au niveau de son étage d'alimentation et du sytème de refroidissement par rapport à la génération précédente.

GeForce RTX 4080 : attention à la version 12 Go

C'est en novembre que la GeForce RTX 4080 sera mise sur le marché. Mais déjà, on peut s'attendre à ce que ce modèle fasse parler de lui. En effet, s'il existe en deux déclinaisons, 12 et 16 Go de GDDR6X, annoncés respectivement à 1 099 et 1 469 euros, la différence tarifaire s'explique par de nombreux autres « détails ».

Et si l'on retrouve les caractéristiques de la carte précédente dues à l'architecture Ada Lovelace, dont la partie vidéo, il existe des différences importantes selon les déclinaisons qui auraient pu justifier une dénomination un peu moins similaire. Car si la version 12 Go est dotée de 7 680 CUDA Cores cadencés entre 2,31 et 2,61 GHz, avec un bus mémoire de 192 bits, celle de 16 Go a droit à 9 728 CUDA Cores cadencés entre 2,21 et 2,51 GHz, avec un bus mémoire de 256 bits. Elle occupe également trois emplacements PCIe par défaut, ce qui n'est pas forcément le cas de sa petite sœur, proposée uniquement via des designs de partenaires qui peuvent varier, précise NVIDIA.

Côté consommation, l'une affiche 285 watts au compteur, contre 320 watts pour le gros modèle. La première pourra se contenter de deux câbles PCIe à 8 broches, contre trois pour sa grande sœur. Dans les deux cas, un seul câble d'alimentation PCIe 5.0 suffira, certifié 300 watts pour l'une, 450 watts pour l'autre.

Bref, il faudra voir quelles seront les différences de performance en pratique avant de juger, mais on aurait aimé que NVIDIA opte pour des dénominations plus claires étant donné les écarts qui seront constatés.

Les GeForce RTX de série 40 proposées par les partenaires de NVIDIA

RTX 6000 et L40 : les versions « Pro » avec 48 Go de mémoire

C'est plus discrètement que le constructeur a évoqué ses premières cartes à destination des professionnels. En effet, deux modèles avec 48 Go de GDDR6X ont fait leur apparition sur son site : la RTX 6000 destinée aux stations de travail, et la L40 pour serveurs, équipée donc d'un simple dissipateur, sans ventilateur.

Il s'agit dans les deux cas d'une carte occupant deux slots PCIe seulement, avec une consommation maximale de 300 watts, dotée d'un connecteur PCIe 5.0 adapté, de quatre DisplayPort 1.4, intégrant par contre trois moteurs NVENC et trois NVDEC, gérant des fonctionnalités spécifiques, notamment du côté de la virtualisation.

Leurs tarifs et dates de disponibilités n'ont pour le moment pas été détaillés.

Commentaires (65)

#1

Ce modèle a été annoncé à 1 599 dollars, ce qui donne 1 949 euros TTC en France, parité euros/dollars oblige.

Euh ! Actuellement 1 EUR = 1 USD à peu de chose prêt. De quelle parité est ce qu’on parle quand le prix en euros est 22% plus cher ?

#1.1

Euh … La TVA justifie ce prix non ?

Les annonces se font toujours en prix HT, du coup, on prend le prix en $ et on rajoute 20% pour avoir le prix en €.

#1.4

Ah oui, avec la TVA, ça marche

#1.2

de la parité avec TVA

#1.3

Tu as raté le “TTC” dans la phrase ;)

#1.5

TVA :-o

#1.6

Faudrait un jour piger qu’aux USA les prix sont toujours HT car la taxe diffère d’un Etat à un autre.

De ce fait c’est 1 599 dollars HT contre 1 949 euros TTC.

#2

Apparemment je lis un peu partout que le DLSS3 ne sera compatible qu’avec les 4xxx, j’imagine quand même que les jeux qui passent au DLSS 3 sans avoir eu le 2 auront une rétrocompatibilité avec les anciennes Gen

#3

Mouais …

J’attends de voir les tests de ces monstres, ça fait longtemps que je me méfie des annonces de performances x2, x3, …

J’ai du mal à imaginer qu’elles vont se vendre comme la génération précédente en période de pénurie au vu des prix. Beaucoup de monde se plaint justement de ces prix trop élevés.

Perso, j’ai acheté sur un coup de bol une 6900XT au MSRP (je voulais une 6800XT à la base) soit aux alentours de 990€ et ça m’a fait très mal. J’en suis très content mais je ne pense pas remettre une telle somme dans un composant avant longtemps.

Pour la consommation, j’attends les tests aussi car j’ai du changer d’alimentation lors de l’achat de ma 6900XT (300W environ) et mon alim de 550W ne tenait pas le choc en charge.

Je suis étonné du double modèle de 4080. Comme vous, je ne suis pas fan et c’est trop ambiguë pour le consommateur non averti.

#4

Je n’ai pas réussi à éditer mon message précédent…

Pour le DLSS 3, je ne suis pas fan de l’approche de nVidia sur la techno fermée contrairement du FSR d’AMD. Je comprends tout à fait la stratégie mais c’est con de bloquer ce genre de techno à une gamme particulière et “force” le changement de matos pour en profiter.

Je me demande ce que va proposer AMD en face mais il va falloir patienter jusqu’en novembre pour le savoir.

Merci David pour l’article, c’est ce que j’aime sur NI !!

#5

Voir ce que j’en dit dans l’article. On verra bien sur la durée. Il est fort possible que ce ne soit pas le cas au lancement, peut être que ça changera ensuite, ou pas. Avant d’en avoir parlé en détail avec NVIDIA, personne ne peut rien affirmer, juste spéculer (et spéculer, c’est mal).

Vu la croissance des CUDA Cores et donc des FP32/Int, l’évolution x2 sera là au minimum, à voir selon les besoins des jeux, la définition, mais rien que ceux qui font du calcul verront les avantages. Après ce sera dépendant des usages RTX/Tensor et des nouveautés type DLSS 3. L’important sera aussi le FPS/Watt dans les différentes situations, et l’apport du 4 nm.

On analyse pas une tendance de marché sur un cas personnel. La question pour NVIDIA c’est : est-ce qu’il y aura assez de clients pour ces cartes aux tarifs annoncés. Vu les marchés/publics visés (dont tu ne fais pas parti selon ce que tu en dis) il y a de grandes chances. On verra bien.

C’est comme pour des machines comme le Mac Studio. Perso j’ai un Mac mini à la maison, ce n’est pas pour autant que personne n’achète le Studio malgré ses prix délirants. Certains ont le besoin, et l’apport de cette machine est supérieur à son coût pour leur business.

#5.1

J’ai juste donné mon ressenti et ce que je vois sur pas mal de sites de hardware.

Je me doute qu’on ne peut pas se fier à ça pour faire une tendance de marché.

J’ai juste dit que j’ai du mal à imaginer comment elles allaient se vendre (bien ou pas) tout comme j’étais très étonné des ventes pendant la pénurie malgré les prix.

J’attends les tests avec impatience, j’espère que tu feras un nouvelle article sur NI !

#6

DLSS en v2 déjà améliore le nb de fps assez considérablement, ce serait dommage qu’il n’y ait pas de retrocompatibilité :/ Mais bon, si c’est dépendant aux nouvelles techno dans les 40x.

#7

On a déjà l’information de la part de NVidia sur Resetera : https://www.resetera.com/threads/nvidia-debuts-dlss-3-october-12th-release-35-games-will-get-support.634256/post-93607910

“When a DLSS 3 games comes out, and you own a GeForce RTX 30 Series or 20 Series graphics card or laptop, you can use DLSS 2 Super Resolution in that title.

This is the same Super Resolution technology available in over 200 games and apps.

There’s also a benefit for every GeForce RTX GPU: DLSS 3 comes packaged with NVIDIA Reflex, which works on all generations of GeForce RTX GPUs, and also some older GTX series.

So if you own a GeForce RTX 30 or 20 Series, you would get DLSS 2 + Reflex. Even if a game is labelled as a “DLSS 3 Game”.”

#7.1

Les briefs de NVIDIA se font cet après-midi ;)

Non et ce ne sera sans doute pas tout de suite

On le dit à chaque fois, mais NVIDIA décale ses gammes au fil des générations. Une 4080 n’est pas comparable à une 3080. C’est du marketing.

Après chacun analyse comme il veut, même si ça n’a pas de sens.

Je ne comprendrais jamais ce genre de réaction. Mettons que tu as un budget GPU de 500 euros, la question c’est « est-ce que la RTX 40 à 500 sera mieux que la génération précédente ». La réponse sera très certainement oui. Tout le reste n’a guère d’intérêt en pratique, sauf à aimer se plaindre 😅

#8

Bonjour, il y a-t-il eu des annonces au sujet d’une modification des offres Geforce Now? Aujourd’hui l’offre de base limitée à la FHD tourne sur 2080 ou 3060 généralement et l’offre améliorée en 4K sur 3080. Personnellement, je lorgne plus sur cette dernière que sur l’achat d’une 40xx stock qui est ma foi fort chère.

#9

Je crois que DLSS s’appuie sur du hardware spécifique que les cartes AMD n’ont pas. Le résultat entre FSR et DLSS est quand même bien différent en terme de qualité. C’est comme pour NVENC qui est un gros plus pour ceux qui veulent streamer, enregistrer leurs sessions de jeu pour partager sur YT ou simplement montrer un jeu dans discord.

https://youtu.be/ROp5FCfLwR8?t=19

#9.1

Oui je le sais aussi.

Après est ce qu’AMD n’aurait pas fait comme nVidia s’il avait été les premiers à sortir la techno ?

Est ce que rendre le FSR compatible n’a pas été fait dans le but de “contrer” nVidia avec son DLSS propriétaire ?

LE DLSS est plus qualitatif même si le FSR2 a bien amélioré les choses.

Pour NVENC, je comprends mieux certains messages et plaintes sur des forums car je ne comprenais pas les griefs contre AMD

#10

Les prix grimpent beaucoup trop, je passe mon tour

La pénurie due au minage faisait énormément monter les prix des RTX30 et autres.

Mais là il semblerait que le passage de l’ethereum au PoS rende l’usage d’un gpu nettement moins utile. Je me trompe peut-être sur ce point ?

Mais si ce n’est pas le cas il n’y aura pas beaucoup de joueurs prêts à passer à la caisse.

Il me semble difficile, hors minage, de maintenir des prix aussi hauts

#10.1

Ca permet surtout justement découler les RTX 3xxxx.

#11

Moi ce qui me choque c’est l’augmentation tarifaire

La GeForce RTX 4080 16 Go à 1 469 € c’est tellement du foutage de gueule par rapport à l’ancienne génération. Dommage que l’article n’en parle pas mais il ne faut pas oublier qu’il y a deux ans la RTX 3080 était disponible à son lancement à 719 €. Ils ont plus que doubler le prix.

Sans oublier ce mensonge qu’est la 4080 12 Go à 1099 € alors qu’il s’agit d’une 4070 tout simplement. La 3070 à sa sortie elle était sortie à 519 € !!

Pour rappel donc à leur sortir respective :

RTX 3090 : 1549 €

RTX 3080 : 719 €

RTX 3070 : 519 €

RTX 4090 : 1949 € : soit une augmentation d’un gen à l’autre de 126 % !!!!

RTX 4080 16 Go : 1 469 € > augmentation de 204 % !!!!

RTX 4080 12 Go (aka RTX 4070) : 1099 € > augmentation de 212% !!!!!!!!

Pourquoi aucun site ne parle de ce GROS GROS foutage de gueule ! J’ai jamais une augmentation de prix pareil d’une génération à l’autre. Meme Apple n’oserait pas !!

#11.1

Surtout qu’il y avait déjà une augmentation entre la série 20 et la série 30.

Après … ce sont des prix auxquels les gens achetaient des cartes sur ebay il y a un an.

Financièrement ça me semble un bon choix. On vend cher à ceux qui sont prêts à mettre le prix (entreprises, gros streamers, riches, …), ensuite si ça stagne on baisse les prix.

Je suppose qu’ils ont choisi de sacrifier une partie de leur image de marque, mais c’est pas comme si la concurrence était au point actuellement, donc ils s’en foutent et tant pis pour nous

#11.2

Pour NVENC, youhou ! A voir ce que donne l’encodage AV1 matériel, vs du CPU only (en terme de qualité)

Je crois qu’à l’époque, tu n’as pas essayé d’acheter une 3070. Hormis quelques chanceux, rares sont ceux qui l’ont payée ce prix. Les pros devaient bien souvent payer des cartes à 4-5000€…

Les pros devaient bien souvent payer des cartes à 4-5000€…

D’autre part, les gens qui vont acheter une 4090 vont être ravis à ce prix

Et puis je ne vois pas ce qui te permet de dire que la 4080 12go est une 4070.

Bref, à chaque chose son public.

D’autre part, l’augmentation est de 26%, pas de 126% ;)

On a besoin de trucs pour que la consommation ne soit pas proportionnelle aux tailles d’écrans.. sinon ça devient ingérable.

#11.3

Oui, pour les jeux je me dis que c’est super ce dlss. Avec un limiteur ips j’imagine qu’on peut réduire la consommation par rapport aux générations précédentes . Mais pour les autres types de calculs, c’est là ou je me pose la question des perf’.

#11.4

La question n’est pas de qui pourra se la payer mais de l’augmentation qu’ils sont en train de nous envoyer en pleine fasse quel que soit la gamme !! Ma EVGA GeForce RTX 3080 FTW3 ULTRA GAMING je l’ai payé aux alentours de 870 € à sa sortie et c’était déjà pas une période pas facile pour acheter une cg j’ai bien galéré pour l’avoir. Et là je devrais payer le double pour une Founder Edition en plus ? Mais elles vont être à combien les custom ? Qu’est-ce qui justifie qu’on double un tarif, tu m’explique ?

Regarde la différence entre les prix en France cette fois :

GTX 980 : 542 €

GTX 1080 : 669 €

RTX 2080 : 849 €

RTX 3080 : 719 €

RTX 4080 : 1469 €

Et pourquoi la RTX 4080 12 Go est une 4070 ? Je sais pas regarde les specs c’est clairement une carte en dessous de la 4080 16 Go et pas qu’un peu. C’est flagrant qu’ils l’ont appelé 4080 12 Go juste pour faire style “oh vous avez vu on a pas autant augmenté le tarif que ca”. Si on suit ta logique pourquoi la RTX 3080 12G et 8G n’ont que très peu de différences que la quantité de ram ? Et encore la version 12Go est sortie 2 ans après pas au lancement. Regarde les specs ca se voit que c’est une fausse 4080.

Sérieusement ils ont fumé pour doubler les tarifs, et toi on dirait que tu veux leur donner raison.

#11.5

Ce qui importe vraiment au final c’est le prix de la carte qui répond à tes besoin de performances, et de son efficacité énergétique pour avoir les performances que tu désires au coût le plus faible

Par exemple à titre perso du 1080p 60fps ça me suffit, donc la 4050⁄4060 sera sûrement intéressante par les fonctionalités modernes et la grande efficacité énergétique

C’est sûr que si tu veux jouer en 8k va falloir lâcher les billets pour la 4090, mais quoi qu’il arrive à chaque nouvelle génération les rapports perf/prix et perf/conso augmentent, il faut arrêter de comparer les prix des mêmes gammes de générations différentes car les performances n’ont rien à voir

#11.6

On n’achète pas une gamme, on achète un besoin.

Avant d’acheter ta 3080, as-tu testé une 3070? Une 3060 ? Tu serais surpris de leurs capacités…

Et c’est drôle, mais pourquoi la 4080 16go ne serait pas une Ti et la 12go une normale ? Ce n’est que ton idée de la gamme, ce qui est donc complètement biaisé.

Tu as bien eu de la chance de l’avoir à un tarif pareil. Pendant 18 mois, ça a été à milles lieues d’être la norme.

Ps: oui, je leur donne raison, et tu vas voir que je ne suis pas le seul… parce que j’achète un besoin ;)

#11.7

Yes, et je dirais même qu’avec DLSS, il y a encore moins besoin d’aller chercher la 4080 puisqu’on peut jouer en 4K tout en calculant en 1080p…

#12

Vivement les bench’ ! :)

Je suis un peu sceptique sur les perf/w « reel », le dlss étant un peu un cheatmod pour faire grimper les ips…

Et puis faut voir la consommation aussi

#13

Mis a part que tu ne sais pas compter (de 1549 à 1949, ça ne fait que 26% d’augmentation soit grosso modo la baisse de l’euro vs le dollars donc pas vraiment d’augmentation en $) pas 126% et si les perf font *2 c’est pas si mal

La 4080 12go n’est pas une 4070.

C’est la 4080 16go qui devrait s’appeler 4080ti !

Et là, on passe de 729€ à 1099€ pour la xx80 (oui, là ça fait mal, y a bien plus que les 20% de l’€/$) et de 1249€ à 1479€ pour la xx80ti (plus raisonnable, comme pour la xx90 quoi)

#13.1

Détends toi mec je ne pouvais plus modifier les pourcentages quand j’ai vu mon erreur ! Sérieux quand je vous lis je me dis qu’il font bien d’augmenter les prix tellement vous êtes capable d’avaler n’importe quoi.

#14

C’est moi, ou la démo de Portal en RTX ressemble juste à un portal avec des textures/moteur mises à jour ?

Je veux dire, je suis pas du tout hypé par ça.

Sinon, vraiment cool pour NVENC !

#14.1

Nan, tu n’es pas le seul. C’est comme le RTX sur Minecraft…

#15

Tellement de gens qui pleurent sur les prix des GeForce RTX en commentaires… On est sur le (très) haut de gamme les gens avec les 4080 et 4090, faut redescendre un peu…

#15.1

Peut être qu’avec les tests, les gens se rendront compte du gap de performance et que ça aidera à comprendre qu’on est sur du très haut de gamme.

Y a plus qu’a attendre

#16

Je ne comprendrais jamais ce concept de définir les gammes au niveau tarifaire et non pas comme le fabricant les a défini.

Encore heureux que la nouvelle gamme est plus performante que la précédente à budget équivalent, la loi de Moore a mal vieilli mais on a encore un peu de marge sur la progression en densité des puces et l’efficacité énergétique, c’est un du propre au secteur. Où est d’ailleurs le “glissement” de gamme quand il n’y a pas de nouvelles références introduites en entrée de gamme, et que ce glissement s’opère uniquement vers le haut, autant sur la niche du THG que sur les séries populaires XX60 et XX70 ?

Parce que l’écart en terme de nombre de CUDA cores est très important entre la 4080 et 4090 et cela laisse un trou dans la gamme pour au moins une version Ti ( 16384 vs 9728 ), contrairement aux 3090 et 3080 qui étaient beaucoup plus proches ( 10496 vs 8704 ). La taille du bus est aussi différente sur la version 12Go ( 192bits contre 384 sur 4090 )

Après le flop de la 3090ti qui a perdu 900€ après cinq mois de commercialisation, je ne comprends pas comment on peut trouver encore le moyen de défendre la tarification de Nvidia. Oui les cartes sont puissantes avec des technos proprios assez uniques, mais ça commence à se voir qu’ils prennent les clients pour des vaches à lait. Le pire c’est que même si un concurrent finissait par apporter une réponse intéressante niveau perf / prix, Nvidia resterait incontournable et indéboulonnable grâce à ses technos développées de longue date et dont les logiciels sont devenus dépendants ( CUDA, RTX, Tensor Cores pour les plus voyants )

Oui les cartes sont puissantes avec des technos proprios assez uniques, mais ça commence à se voir qu’ils prennent les clients pour des vaches à lait. Le pire c’est que même si un concurrent finissait par apporter une réponse intéressante niveau perf / prix, Nvidia resterait incontournable et indéboulonnable grâce à ses technos développées de longue date et dont les logiciels sont devenus dépendants ( CUDA, RTX, Tensor Cores pour les plus voyants )

#16.1

Le fabricant défini des gammes au sein d’une génération. NVIDIA n’a jamais dit “les 4080 c’est l’équivalent des anciennes 3080” (bien au contraire). Après on peut se raconter les histoires que l’on veut, mais ce qui fait le choix, c’est le perf/prix, l’enveloppe

Comme dit plus haut, ce sont des chiffres et du marketing. Mais effectivement, on le voit à chaque annonce puisqu’on a toujours les mêmes rengaines : ça marche. Comme quoi…

#16.2

Ce qui “marche”, c’est surtout de ne sortir les cartes les plus accessibles que (très) longtemps après.

La production des “anciennes” 3060⁄3070 sera-t-elle continuée après la sortie des 4000 ?

Si on se base sur une segmentation à grosses mailles en 4 modèles 4050 à 4090 pour reprendre la segmentation à laquelle on est habitués, puisque les 4080 & 4090 on beaucoup augmentés leurs prix, si on raisonne du postulat que les 4080 n’ont rien à voir avec les 3080, cela veut dire soit :

Le modèle 4080 donne un indice de fractionnement plus important de la gamme, avec l’écart entre la 4080 16 Gio et la 4090 ouvrant le champ pour des (une ?) 4080 Ti.

Si la seconde option mentionnée ci-avant est la bonne, ils pourrait être tentés d’avoir 3-4 versions par numéro (doubler les numéro de base, doubler les Ti), mais vient alors la question du coût de production d’une offre trop segmentée : les économies d’échelles ne sont maximisées que pour des volume d’un modèle unique très importants; à segmenter, on les réduit.

N’oublions pas que la production des 3000 n’a jamais suivi la demande : ils ont à l’époque saturé leur appareil de production. Ainsi, sauf à en avoir drastiquement augmenté la capacité afin d’atteindre de volumes unitairement intéressants, une telle stratégie de segmentation me laisse perplexe industriellement parlant.

#16.3

L’entrée de gamme est remplacé par les APU comme le 5700g par exemple. Ça permet de jouer au jeux compétitif dans de bonnes conditions a très bas prix. Donc nvidia n’a aucun intérêt à sortir des cartes moins puissantes que la 3050 car elle ne les vendrait tout simplement pas.

#16.4

Oui et non. Il y a toujours un marché pour une petite carte simple slot principalement pour la bureautique et la partie vidéo, pour équiper des machines dépourvues (serveurs, vieux PC, machines avec gros CPU mais pas de GPU intégré, etc.). NVIDIA a fait le choix de ne pas trop se mettre à jour sur ce terrain laissant de vielles générations s’en occuper (GT 710⁄730 par exemple). Mais avec Intel qui va s’y placer, je suppose que ça changera via du Ampere ou Ada.

#17

Pas très clair et le positionnement commercial sur DLSS 3.0. Le DLSS 2 est seulement dispo aujourd’hui sur MSFS que les series 3000 sont deja dépassées ?

Il faudra attendre les tests pour voir la différence entre les gen, mais il sera difficile de faire la part des choses entre l’evolution DLSS et le reste (frequence, memoire).

#18

Je partage ce point de vue. Cette histoire de “glissement de gamme” serait crédible si toutes les gammes suivaient… seulement, si on considère que la x080 n’est plus du haut de gamme mais du ultra haut de gamme qui justifie un prix plus élevé (et la x090 est alors du giga-hypra-haut-de-gamme), alors ça vaut pour toutes les gammes du dessous et les x050 devraient être du milieu de gamme déjà très satisfaisant. Or, qu’est-ce qu’on constate ? Qu’une 3050 arrivée en fin de cycle RTX 3000 fait à peine mieux qu’une carte du haut de l’entrée de gamme type GTX 1660, sortie presque 3 ans plus tôt.

Autrement dit peut-être que le gain de perfs en 3 ans sur le segment des cartes à 1000€ est réel, mais alors sur les cartes à moins de 500€ ça saute pas aux yeux et à moins de 300€ c’est encore pire, quand nvidia daigne sortir quelque chose le progrès par rapport aux gens précédentes est négligeable. Et ça c’est pour la gen 3000 qui était une gen “pas chère” point de vue MSRP. Il y a fort à parier qu’une 4050 sera nettement plus chère.

Quant à la gamme des GPU dédiés à 150€, qui était autrefois la gamme “qui permet de jouer, à condition d’accepter des sacrifices”, elle n’existe plus, purement et simplement. Maintenant, c’est iGPU qui ne permet pas de jouer, ou 250€ au strict minimum.

Il est loin le temps où le haut de gamme était à 500€, et où pour ce prix tu étais assuré de pouvoir jouer à tous les jeux présents et à venir dans l’année avec tous les détails au max dans la résolution “haut de gamme” du moment…

#19

Le haut de gamme, à la base, c’était 500-600€. Désolé de constater qu’à 1500€ la 4080, y a eu un peu d’inflation… Même la 1080Ti FE est sortie à 825€… la 980Ti à 749€.

Même à considérer que la 4090 est l’équivalent d’anciennement les Titan et que la 3080 est l’équivalent d’une Ti, ça reste un doublement du prix à gamme équivalente en 7 ans. Et un prix qui fait +80% en 5 ans.

Je veux bien qu’on soit dans une période inflationniste, mais pas tant.

#19.1

Le très haut de gamme, pour pro, c’est 8K€.

Le haut de gamme, pour semi pro + gamer trop friqué, c’est 1000-2000€.

Pour le gamer normal, le budget n’a pas changé, tant qu’il ne met pas tout en ultra.

ps: pour info, Cyberpunk détails moyens sur une P2000 (équivalent 1060) castrée à 75W (au leu de 160W), ça fonctionne très bien et est jouable en QHD. Et c’est suffisamment joli.

Arrêtez de pleurer, sérieux.

#20

À condition de confondre images/seconde et secondes/image alors.

Le budget a juste doublé à gamme équivalente en 7 ans. Le milieu de gamme à 250 Euros est maintenant vendu à 500. Le haut de gamme est passé de 500 à 1000. Le très haut de gamme est passé de 750 à 1500. Si on avait accepté ce genre d’évolutions depuis l’époque des Pentium et des premières cartes 3DFX, un PC moderne coûterait plusieurs dizaines de milliers d’euros aujourd’hui.

On parle là, bien évidemment, de gammes de cartes grand public. Les cartes pro sont un autre marché. On ne considère pas qu’un PC à base d’i9+3090Ti est de l’entrée de gamme parce que ça coûte une fraction du prix et a une fraction des capacités d’un supercalculateur. C’est un autre type de machine pour un autre marché.

#21

D’une certaine manière, si, ils le disent en appelant ces cartes des 4080, tout en sachant très bien comment ça sera interprété - c’est même la raison d’existence de cette nomenclature.

Le fait est que le haut de gamme des cartes graphiques grand public est beaucoup plus cher qu’avant. Acheter la meilleure carte pour jouer aux jeux les plus gourmands est bien plus cher aujourd’hui qu’hier.

Il est aussi clair que ce haut de gamme fait beaucoup plus de choses qu’avant, consomme plus d’énergie tout en ayant une meilleur finesse de gravure etc, en plus du fait que la position de NVIDIA sur le marché en général leur permet d’imposer leurs prix.

#22

Je viens de réaliser que la gamme 50 n’existait pas pour les 2000 mais est apparue avec les 3000 : le sens de la marche est donc bien vers une plus grande segmentation.

Et si des 4040 apparaissaient ?

#23

Sinon l’article parle de l’absence de PCIe 5.0, mais ce qui m’étonne le plus c’est l’absence de DP 2.0, pour éviter les “double DP 1.4a + DSC” : NVIDIA serait donc en retard sur les cartes Intel et les futures cartes AMD.

#24

Parfois c’est comme ça, parfois c’est l’inverse, tout dépend de la stratégie de production. Spoiler : on ne peut pas fabriquer 6 gammes de GPU en simultanée. Pour le reste, j’ai du mal à comprendre le point. Des 4060⁄4070 seront disponibles, il faudra juger de leur pertinence lorsqu’elles seront sur le marché. Mais cela change quoi pour ceux qui ne sont pas intéressés par des cartes à plus de 1 500 euros, quel que soit leur nom ?

Pour le reste, je l’ai déjà dit : spéculer c’est le mal.

Les GeForce 750 Ti c’est quoi ? (Les premières à sortir de la génération Maxwell pour rappel). Mais la segmentation suit le besoin de la gamme. Si un jour NVIDIA a besoin de sortir une 4010 ou une 5010, elle sortira. Comme répété à longueur de lancement, ce ne sont que des noms marketing, ils n’ont pas de sens sinon un ordre au sein d’une génération. Il n’y a donc pas beaucoup d’enjeu.

La seule règle que NVIDIA respecte à travers les générations, c’est que la xx60 doit être une carte “sweet spot” au niveau de son ratio perf/prix. Mais on sait très bien qu’avec les décalages successifs de gamme, ça risque de devoir glisser à un moment ou un autre.

Oui, mais la question c’est : est-ce que la BP mémoire est suffisante ? On verra en pratique ;)

De ce que j’en comprends PCIe 5.0 est présent dans Ada mais pas utilisé sur les cartes grand public, à vérifier (déjà qu’on doit être loin de saturer le PCIe 4.0…). Pour DP 2.0 c’est plus étonnant oui surtout que, comme tu dis, ça reste un avantage pratique que de l’intégrer. Mais là aussi on verra ce que l’on arrivera à savoir sur les raisons qui ont mené à ce choix au final.

#25

Pour info j’ai complété l’article avec les infos données à l’occasion des briefs techniques destinés à la presse hier après-midi

#26

Le prix est indécent et le bullshit des tensor coeurs - DLSS 3 uniquement compatible RYX 4000 alors que AMD fait pareil sans me fait bien rire

#26.1

AMD fait du super sampling classique, avec prise en compte du Temporal dans la version 2 pour affiner. Cela n’a rien à voir si avec DLSS 1, 2 ou 3 (ce que même AMD dit). FSR est une alternative à DLSS qui est plus large dans sa compatibilité (puisque pas d’IA/Tensor) mais moins précis et qui ne peut pas reconstruire des images intermédiaires entières.

Les deux ont une stratégie/approche différente, chacune ayant ses avantages et ses inconvénients. Chacun choisi donc selon ses besoins et critères (et préférences). Mais un conseil : on ne combat pas le “bullshit” en racontant n’importe quoi.

#27

Leur approche est différente mais le FSR 2 (et. bientôt intel ) est au niveau du DLSS 2 tant en terme de performance que de qualité d’image. Je ne vois donc pas dans une utilisation gaming l’intérêt des Tensors à part segmenter et pousser artificiellement à changer de version de carte tous les 2 ans.

Si l’émulation software est au niveau du hardware spécifique il y a bien un problème .

Ceci dit je suis reconnaissant envers NVIDIA, ce sont eux qui innovent ces dernières années.

#27.1

Non, mais on peut se contenter de FSR 1⁄2 sans problème. Et on voit bien la tendance, l’écart ne va faire que se creuser, AMD devra de toutes façons implémenter des unités Tensor/IA pour s’adapter aux innovations à venir qui viendront en partie de là (comme sur CPU où ils s’y mettent). Ils le font de toutes façons déjà dans les architectures CDNA, ne manque que la couche logicielle.

Pour Intel c’est différent puisque XeSS aura un fonctionnement similaire aux versions initiales de DLSS, on verra en pratique le résultat lorsque les cartes seront réellement testées via des patchs publiquement disponibles. Mais le résultat et les possibilité devraient être similaires.

C’est vrai surtout du fait de la situation depuis deux ans (et la parité euro/dollar ne va rien arranger malheureusement). Mais la RTX 3050 a été annoncée à 279 euros par exemple. On verra quel sera l’état du marché à l’arrivée des séries 40 d’entrée de gamme. Mais bon, on reste dans un monde où c’est la loi de l’offre et la demande. On peut s’en désoler, ça reste un fait.

Par contre pour le rapport prix/perfs en baisse, à mon avis, il faut refaire les calculs mais ça me parait difficile, surtout avec Ampere qui a consisté à doubler le FP32 (après si c’est dans Minecraft en 720p, forcément… )

)

#28

Faut quand même admettre que pour 300 € on a plus grand-chose, voire moins bien que par le passé.

Si les anciennes générations étaient encore vendues, à la limite, en tant que plus bas de gamme, mais à la place ils font une nouvelle gamme qui a un rapport prix/perfs moins bon (et de plus en plus étalé, pour combler le fossé qui s’élargit à mesure que le haut de gamme s’envole, réduisant d’autant plus le choix).

#29

Déception pour moi qui comptait prendre une 4080.

Pour ceux comme moi qui on réussit à choper au MSRP, ça fait qu on passe de 719€ à 1099€ sur les xx80, soit +53%.

Hors je doute qu on soit à plus de +53% niveau perf (hors DLSS et ray tracing qui mettent en valeur la nouvel gen).

Ca voudrait dire que le rapport perf/€ stagne d’une génération à l’autre.

J’ai bien conscience que la chute de l euros joue beaucoup, mais le résultat est là.

J espère me tromper sur les perfs et avoir une bonne surprise, on verra avec les tests indépendants.

#29.1

Avant pour avoir les TFLOPS d’une 4080 de 12 Go (soit 40 TFLOPS) il fallait une 3090 Ti. Je vois mal comment le Perf/euro serait en train de stagner ? Et on ne parle là que des TFLOPS bruts, sans les optimisations de l’architecture et ses nouvelles fonctionnalités.

#29.2

Encore heureux qu’il ne stagne pas, c’est dans l’ordre des choses. Si les fabricants augmentaient les prix des composants en accord avec le gain de performances à chaque génération, le seul moyen de se payer une nouvelle config aujourdh’hui serait d’hériter d’un tonton millionaire.

Donc oui le rapport perf / euro s’améliore, mais si NV n’était pas si gourmand ce ratio pourrait être encore meilleur. Alez j’ose rêver, peut être même que les tarifs pourraient être stables d’une génération à l’autre, hors inflation ?

Un doux rêve…même EVGA a dit stop, d’ailleurs l’article d’Anandtech à ce sujet est assez intéressant.

#29.3

J’ai du mal à comprendre la remarque. Tu dis qu’il pourrait baisser… alors qu’il baisse puisque l’on a autant ou plus de TFLOPS pour moins cher que sur la génération précédente, inflation comprise (et même parité €/$ comprise sur la 4090). Pour rappel au lancement des RTX 30 j’écrivais :

C’était avec les prix de lancement, avant la phase d’inflation du marché des GPU (indépendante de la phase d’inflation actuelle). Actuellement, on est entre 19,3 et 24,5 $ du TFLOPS sur les RTX 40, le moins cher étant sur la 4090, la moins intéressante de ce point de vue étant la 4080 16 Go.

Le modèle le moins intéressant n’est plus le même, mais on reste sur un TFLOPS/$ en baisse, alors même que les modèles les plus accessibles (en général ceux avec le meilleur sweet spot) ne sont pas encore annoncés. On a aussi un écart réduit qui était assez pénalisant pour la 3090 à sa sortie, ce qui n’est pas le cas ici pour la 4090 qui se détache bien des autres modèles.

Pour le reste, ce qui fait la compétitivité, c’est la concurrence. On verra dans quelle mesure AMD et Intel arrivent à mettre la pression sur NVIDIA de ce point de vue. Et le passé l’a bien montré, ce n’est pas que la question du coût qui entre en jeu, sinon le marché serait favorable au cassage de prix, ce qui n’est pas le cas. C’est toujours plus complexe que ça.

Et une fois de plus (la réflexion se veut ici générale), j’ai du mal à comprendre ces discussions sans fin à chaque lancement, comme si chacun défendait l’oeuvre de sa vie en étant pour machin ou contre bidule, ayant un avis sur la politique prix/marge de sociétés à but lucratif.

Si une carte vous intéresse, achetez là, sinon, achetez autre chose, ou rien. Le marché est divers et personne ne vous en voudra ici de préférer votre carte actuelle ou une RX 6950XT à une RTX 4090. Défendre ou s’opposer à une marque n’a pas de sens, une marque se moque bien de votre capacité à argumenter dans les commentaires, ce n’est que le fruit d’un marketing plus ou moins efficace. Ce qui importe (ou devrait importer) ce sont les produits, s’ils conviennent à un besoin et un budget à un instant “t”. Tout le reste, c’est du vent servant à faire de la page vue.

#29.4

Ca n’a aucun sens ces remarques. Encore heureux qu’on a mieux que la génération précédente, sauf que l’entrée de gamme augmente tout autant à chaque fois, et toute la suite aussi. Il suffit de suivre un peu l’actualité et de voir qu’ils ont mis les prix très haut pour pouvoir entre autre vider les stocks de 3xxx, et si Nvidia se comportait correctement EVGA n’aurait pas abandonné le marché des GPUs peut-être.

Mais comme d’habitude, à défendre ces grosses boîtes qui ont des comportement limites, avec comme justification que ce sont des “sociétés à but lucratif”. J’espère que le marché de l’occas va cartonner suite à la chute du minage et que ça va les calmer un peu.

Entre les prix et la conso ça devient du délire les GPUs maintenant.

#29.5

Pour le moment on a uniquement le catalogue haut de gamme annoncé, attendons la suite avant d’émettre des remarques concernant l’entrée de gamme ;)

Je ne nie pas le rôle du marketing, bien au contraire. Je me désole qu’il fonctionne aussi bien, même sur un public plus “éduqué” sur ces sujets que la moyenne. Et je dis simplement que j’aimerai qu’il intervienne moins dans les analyses que je lis ici ou là post-lancement.

D’ailleurs j’ai du mal à comprendre ta remarque sur la 4090, puisque c’est clairement la plus intéressante du lot, alors que ce n’était pas du tout le cas de la 3090. Au contraire, tu as une carte deux fois plus perf/\(, avec un tarif similaire (hors hausse du €/\) sur lequel NVIDIA ne peut rien) au pire en euros elle se cale sur la 3090 Ti qui était sortie à un tarif plus élevé et le même TDP.

Après si tu as besoin de cartes avec 48 Go de mémoire, on sort des GeForce et c’est que tu as un besoin professionnel. Ce n’est pas tant le pouvoir d’achat qui t’intéresse que ta productivité et une telle carte est vite rentabilisée (ou alors tu as un souci de modèle économique). Et il y a les RTX 6000 ou même la L40 pour ça. Après oui une RTX 4090 avec 48 Go de RAM à 999 $ ce serait cool. Une Ferrari électrique à 10 000 euros aussi

Après comme dit, si telle ou telle carte ne correspond pas à un besoin précis, il y a d’autres modèles, la concurrence, chacun est libre de ses solutions. Ce n’est pas comme si on était obligé d’acheter ces produits.

#29.6

Merci c’est clair

Peut-être à mettre dans le prochain article ou quand le milieu de gamme sortira.

#30

Oui bon alors je fais mes Babbage et je repars chez les ATIstes.

C’est bien d’aller au delà de l’image en simili-cuir de la marque. Merci pour l’article dont la digestion va me prendre du temps.

#31

Je ne dis pas le contraire pusique c’est effectivement le cas, je dis qu’il pourrait baisser plus si NVidia ne se faisait pas des marges de cochon, et donc rendre ce fameux rapport perf / Euros encore plus intéressant. Alors ils ont bien le droit de faire les marges qu’ils veulent et d’imposer les prix qu’ils leur conviennent, mais faire comme si c’était anodin et ne pas comprendre pourquoi une majorité de geek s’offusquent des prix qui montent ( cf hardware.fr, reddit, etc. ), je trouve ça fou.

Alors je ne défends pas telle ou telle marque, juste mon “pouvoir d’achat” comme j’imagine beaucoup d’autres commentateurs. J’ai une 3090 dont je suis très content et qui à sa sortie était une bonne affaire par rapport à mes besoins. C’était la première CG grand public avec 24Go de VRAM, à un tarif je crois divisé par deux par rapport à la Titan RTX 24Go à l’époque, une aubaine. On ne peut pas en dire de même pour la 4090 puisqu’elle a pris 400 euros par rapport à la 3090, que la quantite de mémoire stagne et que le NVLink est passé aux oubliettes.

D’ailleurs ce serait un truc à creuser, est-ce qu’ils essayent de clarifier leur gamme et d’arrêter ce segment “prosumer” qu’est la série 90 ?

On l’a vu avec la pénurie, c’est à qui sera le plus chaud pour se faire tondre, soit par les scalpers, soit par NVidia qui s’adapte très bien, même si ils s’en défendent, Ils auraient tort de se priver, mais les baisses de prix drastiques sur certains modèles ces dernières semaines sont un peu voyantes. ( oui je parle bien de la 3090Ti qui ressemble à un gros test de positionnement tarifaire foiré )

C’est un point de vue de journaliste, et je ne dis pas ça de manière péjorative. C’est ton rôle d’être neutre et de se fier aux chiffres uniquement. De là à nier le rôle du marketing…tu peux le déplorer, mais c’est l’interface majoritaire entre la marque et les acheteurs, pas le rapport TFLOPS / euros. Quelqu’un qui voudrait troquer sa 1080 pour une 4080 verra surtout que la gamme 80 a pris quasiment 700€ sur le PPC en 6 ans, et que les autres gammes ont suivi le mouvement à des échelles variées. Alors il pourra chosir un modèle inférieur et quand même bénéficier d’un gain de performance appréciable avec une hypothétique 4070⁄4060, mais le déclassement est là. Pour la même somme d’argent inflation comprise, on s’éloigne à chaque génération de ce qui se fait de mieux dans la gamme.

#32

@pamputt

Pas seulement la TVA, mais la parité euros dollars, ce n’est plus tout à fait ça. L’Euro étant passé officiellement sous la valeur du dollar