Alors que personne ne comprend comment fonctionnera la surveillance algorithmique des URL, la députée Paula Forteza formule trois propositions pour une meilleure utilisation des nouvelles technologies par les pouvoirs publics. Objectif : pallier les problèmes posés par le « solutionnisme technologique ».

« À chaque fois qu’une nouvelle technologie fait son apparition dans le débat public, elle est présentée comme une "solution miracle" » déplore la députée dans une note publiée par la Fondation Jean Jaurès. Elle y évoque notamment l’usage extensif de drones, présenté comme « la solution idoine pour traquer les délinquants et régler les problèmes d’insécurité du quotidien ». Ou TousAntiCovid, que d'aucuns, tant du côté de ses promoteurs que détracteurs, présentaient comme devant « nous permettre de contenir rapidement et efficacement la pandémie ».

Ce qui n'est pas tout à fait exact, comme nous l'avions alors rapporté : Inria avait ainsi repoussé sans hésiter l'idée d’un sésame qui viendrait terrasser Covid-19 : « Aucune équipe travaillant sur ces sujets n’oublie que le « proximity tracing » n’est qu’une composante d’un ensemble plus vaste de mesures, dans le cadre d’une approche pilotée par une politique de santé. Je ne connais personne qui croie au solutionnisme technologique en la matière ».

Jean-François Delfraissy, président du Conseil scientifique Covid-19, avait lui aussi précisé que « l'outil numérique n'est qu'un des éléments, et qu'il ne faut pas tomber dans une vision que l'innovation va nous sauver et qu'avec les tests diagnostics et le numérique tout va être dans le meilleur des mondes, parce que la réponse est non ».

- StopCovid : Inria dévoile son protocole ROBERT en réponse à celui d’Apple et Google

- « Contact tracing » : la nécessité (oubliée) de milliers d'enquêteurs

Reste que si la députée ne mentionne pas explicitement Evgeny Morozov, sa note fait clairement référence à la notion de « solutionnisme technologique » qu'il avait formulée en 2013, selon laquelle « ce qui pose problème n’est pas les solutions proposées, mais plutôt la définition même de la question : le solutionniste possède un marteau (le Web, Internet, de puissants ordinateurs…) et tout ressemble à un clou. »

Évoquant le débat à venir sur l'élargissement du périmètre des algorithmes aux « adresses complètes de ressources utilisées sur Internet » dans le cadre du projet de loi consacré au renseignement, Paula Forteza relève ainsi qu'« une nouvelle fois, la question de l’utilisation des nouvelles technologies par les pouvoirs publics est mise au débat », mais aussi et surtout qu'« une nouvelle fois, nous avançons à l’aveugle ».

Pour elle, « l’inflation législative liée aux technologies à risque [TousAntiCovid, Big Brother Bercy, algorithmes de surveillance…, ndlr] de ces dernières années » est « d’autant plus préoccupante qu’elle a lieu à la va-vite : sans évaluations ni études d’impact sérieuses, sans cadre de réflexion, sans véritable débat démocratique ».

Trois niveaux d’analyse des technologies

Elle propose dès lors une méthode d’analyse « sur au moins trois niveaux » :

- niveau technique : cette technologie est-elle efficace ?

- niveau juridique : cette technologie fait-elle l’objet de garde-fous suffisants et de mécanismes de contrôle effectifs ?

- niveau éthique : cette technologie est-elle socialement acceptable ?

Évoquant l’application TousAntiCovid et les algorithmes de surveillance, la députée avance par exemple que « l’efficacité est la première question que se posent les experts techniques lorsqu’ils développent une nouvelle solution ».

Or, début novembre, au pic de la seconde vague, l’application ne permettait de notifier que 0,55 % des cas contacts, comme le soulignait l’expert des données Christian Quest. Le Monde a depuis constaté de son côté que « l’utilité des applications de traçage des cas contacts est impossible à mesurer ».

Les trois algorithmes développés depuis la loi Renseignement de 2015 ont, pour leur part, permis de générer 1 739 alertes en 2020, entraînant autant de levées d’anonymat de personnes ayant ainsi été identifiées pour des « comportements suspects » à partir de l'analyse algorithmique de leurs méta-données téléphoniques.

Si l’efficacité réelle de TousAntiCovid est impossible à mesurer avec certitude (on ne peut pas dire ce qu’il se serait passé sans l’application), le cas des algorithmes est différent : le taux de faux positif est très certainement connu par les autorités (combien de levées d’anonymat pour rien ?) mais il n’a pas été dévoilé publiquement.

Le nouveau projet de loi Renseignement ne vise pas moins à étendre les algorithmes aux URL ou, plus précisément, aux « adresses complètes de ressources utilisées sur internet » (pour reprendre la formulation ésotérique du gouvernement, voir nos analyses juridique et technique de cette disposition).

- Renseignement : pérenniser la surveillance algorithmique pour l’étendre aux URL

- Décryptage de capacités « secret défense » de la DGSE

Surveillance des URL : 25 ETP, 20 M€ d'achats, 4 M€ de frais annuels

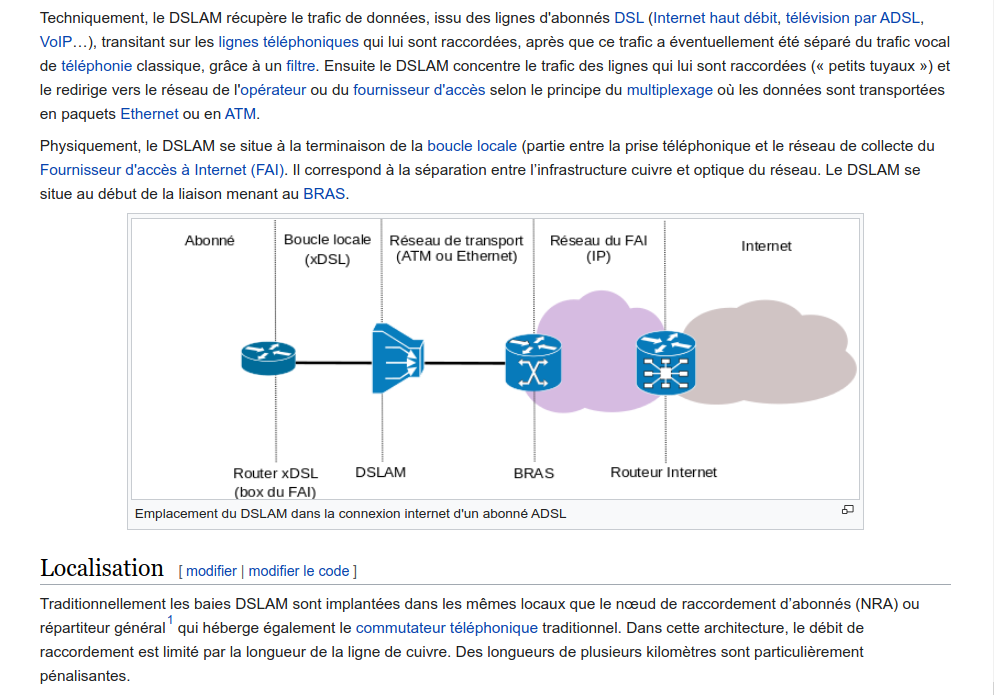

Or, relève Forteza, « nous savons qu’environ 80 % du trafic Internet est chiffré » (dont plus de 90 % du trafic web, via le protocole https), et que les fournisseurs d’accès Internet (FAI) n’ont pas le droit de conserver les traces des URL.

« Seuls les hébergeurs de contenus peuvent avoir des informations suffisamment précises sur les données de connexion », précise la note. Or, « ces hébergeurs sont principalement basés à l’étranger, ce qui rendrait impossible d’y "brancher" des algorithmes ». « Il est établi que l’accès aux URL n’est pas possible avec le degré et l’utilité que laissent entendre les déclarations de Gérald Darmanin » écrit pour sa part Pierre Beyssac dans un billet pointant du doigt les nombreuses questions et inconnues techniques que l'on peut relever au sujet de ces algorithmes :

- les boites noires contiennent-elles des moyens de stockage ?

- où sont-elles placées : sur les dorsales de réseaux, aux points d’échange, aux points de raccordement des abonnés, chez les hébergeurs, sur des liens internationaux… liste non exhaustive et non exclusive ?

- quelles informations pré-triées remontent-elles aux services de police ?

- quels traitements sont réalisés, dans la boite noire et après celle-ci, sur les informations ?

En outre, et comme l'a remarqué la journaliste Amaelle Guiton, le ministère de l'Intérieur a précisé à la CNIL que « les flux de données ne sont pas analysés au moyen d’algorithmes installés sur les réseaux des opérateurs mais dupliqués puis acheminés au sein d’une infrastructure dépendant de l’État pour être soumis à des dispositifs de détection centralisés » et contrôlés par le Groupement Interministériel de Contrôle (GIC), chargé de « centraliser » les techniques de renseignement pour le compte de la CNCTR.

Dès lors, on peut estimer que les trois algorithmes autorisés par la Commission nationale de contrôle des techniques de renseignement (CNCTR) ne correspondent pas à un seul algorithme déployé sur trois infrastructures d'opérateurs téléphoniques, mais bien à trois algorithmes différents de détection des comportements suspects, utilisés pour analyser les flux émanant de tout ou partie des opérateurs de téléphonie.

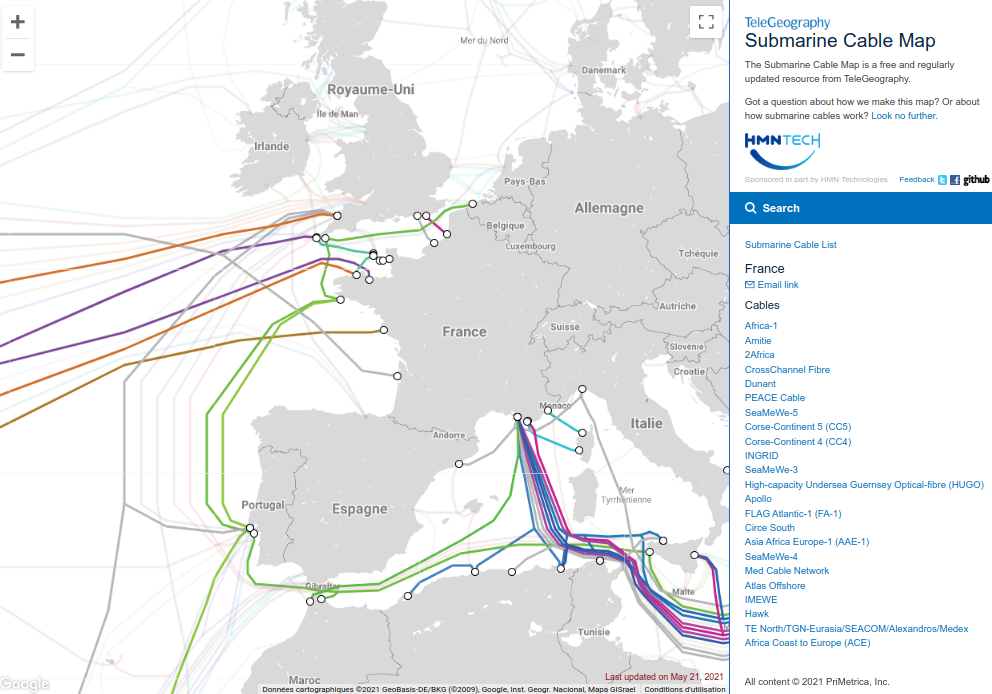

D'autre part, si la DGSE a pu mettre en place une surveillance de l'Internet à l'international à partir de 2008, c'est parce que les flux sont canalisés sur une vingtaine de câbles sous-marins, goulets d'étranglement facilitant considérablement la duplication des flux, afin qu'ils puissent être par la suite analysés.

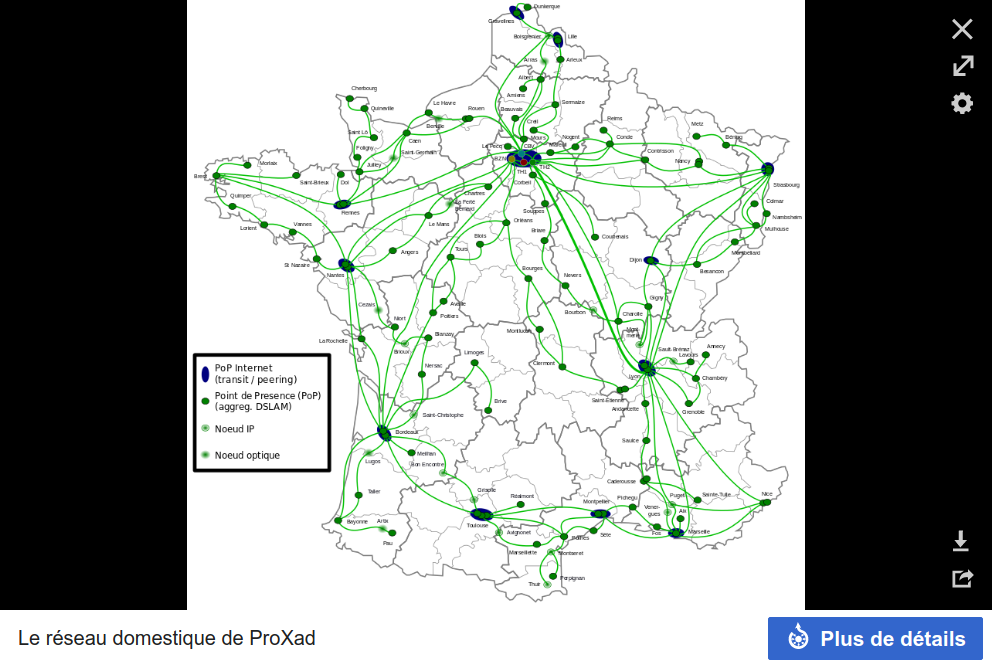

A contrario, le maillage de l'infrastructure Internet en France est décentralisé. Aucun des spécialistes que nous avons consultés n'a été en mesure de nous indiquer où le Groupement Interministériel de Contrôle (GIC), chargé de « centraliser » les techniques de renseignement pour le compte de la CNCTR, pourrait dupliquer les flux Internet pour placer tout ou partie de nos méta-données sous surveillance, au vu des milliers de points de présence (PoP) et de transit (DSLAM/OLT, NRA/NRO, B(R)AS/BNG, IXP) qui permettent aux paquets de données d'être distribués.

Tout juste apprend-on, dans l'étude d'impact annexée au projet de loi, que « les modifications prévues (centralisation par le GIC, prise en compte des adresses complètes des ressources sur Internet) rendent nécessaires une adaptation de l’architecture technique actuellement mise en œuvre », et que « ces évolutions nécessitent un renfort de 25 équivalent temps plein » :

« La cellule commune pilotée par la DGSI chargée de concevoir et paramétrer les algorithmes ainsi que de gérer les alertes devra élargir sa compétence pour définir des traitements automatisés tirant bénéfice des nouvelles possibilités offertes par les URL.

Le coût d’adaptation de l’architecture technique est évalué à 20 millions d’euros pour l’achat et la mise en œuvre des dispositifs techniques et de 4 millions d’euros annuels pour leur maintien en condition opérationnelle. »

Des chiffres à comparer aux 500 millions d'euros investis en 2008, ainsi qu'au recrutement de 800 ingénieurs, afin de déployer le système français de surveillance de l’Internet sur la vingtaine de câbles sous-marins où transitent les flux de données vers ou depuis l'international. En tout état de cause, il semble donc techniquement et financièrement impossible que les algorithmes puissent analyser l'ensemble du trafic Internet français.

Paula Forteza souligne à ce titre que les trois délibérations de la CNIL, déplorant le manque d’information sur les expérimentations en cours et préconisant une expérimentation pour l’extension de cette technologie aux URL, recommandent en outre une évaluation plus approfondie, avant que de prévoir leur généralisation.

Elle formule dès lors deux propositions, en vue de « renforcer le pouvoir des parlementaires dans la compréhension de l’efficacité de ce type de technologies » :

« La première est l’obligation de fournir une étude d’impact sur toute utilisation de nouvelles technologies par les pouvoirs publics sur laquelle le législateur est amené à se prononcer.

La seconde solution est de renforcer les capacités du Parlement lui-même concernant ces enjeux, en créant une véritable commission chargée du numérique, dotée d’administrateurs et d’experts en nouvelles technologies. Cette commission pourrait se saisir au fond et pour avis de tous les textes de loi qui concernent le numérique et les nouvelles technologies. »

Du droit d'accès au devoir de transparence

Elle se penche ensuite sur le volet juridique, en revenant sur l’usage extensif de drones par la police et la technologie de scrapping des données sur les réseaux sociaux pour lutter contre la fraude fiscale.

Elle rappelle qu'en l’absence de cadre juridique, le Conseil d’État avait ainsi sanctionné la préfecture de police de Paris en mai 2020 lorsqu'elle avait fait voler des drones pour contrôler le respect du confinement. Ce qui a aussi conduit le Conseil constitutionnel à censurer le 20 mai une large partie de l’article de loi relatif à l’usage des drones en raison d’un manque de garde-fous et de contrôles suffisants pour protéger la vie privée de nos concitoyens.

Évoquant le data mining effectué par #BigBrotherBercy sur les plateformes en ligne afin d'identifier de potentielles infractions, Paula Forteza rappelle que la CNIL avait indiqué que cette technologie induit un « changement d’échelle dans l’utilisation de données personnelles », déplorant d’avoir dû rendre son avis dans l’urgence.

La députée propose de s'inspirer du modèle estonien pour renforcer le contrôle des citoyens sur le traitement de ses données personnelles par l’État, notamment du fait du développement à venir de l’identité numérique :

« Les Estoniens peuvent savoir en temps réel quelle administration utilise leurs données personnelles. Ils peuvent ainsi avoir la possibilité de déposer un recours pour comprendre quel a été le motif de traitement de ses données et engager une procédure s’il considère que ce traitement est abusif.

Nous pouvons ainsi passer d’un simple droit d’information et d’accès à un devoir de transparence de la puissance publique sur l’utilisation des données personnelles et une réelle capacité de contrôle par les citoyens. »

Forteza rappelle que dans le cadre de la loi de transposition du RGPD, elle avait « fait adopter un amendement permettant d’étendre les actions de groupe, contre des acteurs privés ou publics, afin de réparer les dommages causés par un manquement à la loi Informatique et libertés » :

« Aujourd’hui, seuls les syndicats, les associations de consommateurs et les associations déclarées depuis cinq ans et ayant comme objet la protection de la vie privée et des données personnelles peuvent exercer ces actions.

Il conviendrait de lever ce verrou pour renforcer la capacité d’action de la société civile. Il faut aussi étudier la question du financement de ces actions de groupe, qui n’ont jusqu’à présent que très peu été utilisées. »

Une convention citoyenne sur les enjeux éthiques du numérique

La députée estime que nous sommes de plus en plus souvent confrontés à des exemples « d’effets de cliquet » où une technologie est d’abord développée dans un cadre limité avec des objectifs « louables », puis étendue à d’autres usages « beaucoup plus controversés », pour être enfin, « rapidement généralisée ».

Elle illustre son analyse par deux exemples de dilemmes éthiques : l’usage de la reconnaissance faciale à des fins d’identification dans l’espace public et le développement de technologies dites « sous la peau ».

Alors que plusieurs grandes villes américaines comme Oakland, Portland ou San Francisco se sont déjà prononcées pour un moratoire au sujet de la reconnaissance faciale à des fins d’identification, dans l'espace public, le gouvernement s'est quant à lui prononcé pour son expérimentation, notamment en prévision (ou sous couvert) des Jeux olympiques d'été de 2024 à Paris. Elle rappelle au surplus le concept de « surveillance sous-la-peau » (under-the-skin surveillance), développé par le philosophe israélien Yuval Noah Harari à la faveur de la pandémie :

« Jusqu’à présent, lorsque votre doigt touchait l’écran de votre smartphone et cliquait sur un lien, le gouvernement voulait savoir exactement sur quoi votre doigt cliquait. Mais avec le coronavirus, le centre d’intérêt change. Maintenant, le gouvernement veut connaître la température de votre doigt et la tension artérielle sous sa peau. »

Elle craint en outre que l'« informatique affective » (affective computing) et les technologies de détection des émotions, de reconnaissance vocale mais aussi et surtout faciale ne soient de plus en plus utilisées pour « déceler l’angoisse, le dégoût, la peur, la joie, la tristesse, la surprise », entre autres :

« L’une des prochaines étapes pour la protection de nos données sera de protéger ces données émotionnelles, que nous ne contrôlons pas nécessairement et que nous générons sans le vouloir. Elles disent beaucoup de nous et peuvent avoir un intérêt commercial pour des grandes entreprises, mais aussi politique pour des régimes autoritaires afin de renforcer leur pouvoir de contrôle. »

Inspiré par un texte intitulé « Quatre priorités éthiques pour les neurotechnologies et l’IA », publié dans la revue Nature en 2017, le parlement chilien a de son côté récemment décidé de légiférer sur la protection des « neuro-droits », se félicité Forteza :

« À l’initiative du sénateur Guido Girardi, cette loi vise à encadrer deux aspects. Le premier est l’intimité mentale des personnes : les données cérébrales des personnes sont traitées avec une confidentialité comparable à celle des greffes d’organes. Le second est le droit à l’identité et le maintien de l’individualité des personnes. »

La député propose qu’« une convention citoyenne sur les enjeux éthiques du numérique puisse voir le jour, à la manière de celle sur le climat » :

« Cette convention pourrait par exemple conduire à rédiger une Charte constitutionnelle du numérique qui contiendrait les grands principes liés aux droits et libertés numériques, sous le modèle de celle que nous avions portée de manière transpartisane au Sénat et à l’Assemblée lors des débats sur la révision constitutionnelle de l’été 2018, finalement interrompus. »

« Reprenons le contrôle » !

S’inspirant des avancées en bioéthique, elle estime que « nous devons installer une réflexion non pas uniquement en matière de droit à la protection des données personnelles mais aussi en matière de dignité humaine » :

« Nous devons faire attention : aujourd’hui trop souvent le label "GDPR compliant" (respectueux du RGPD) fonctionne comme un blanc-seing donné à des technologies qui posent question en termes d’éthique et d’acceptabilité sociale.

Les réflexions sur la dignité, en matière éthique, impliquent la préservation de l’intégrité physique et psychique d’une personne, la défense de son identité, de son intimité et de son estime de soi. »

L'évolution, et l'accumulation des transformations numériques auxquelles nous sommes confrontés « donnent le sentiment d’une perte de contrôle sur nos vies, d’une dérégulation complète des cadres sociaux et d’une marginalisation de l’humain. Reprenons le contrôle et la maîtrise de ces évolutions », conclut la députée.

Commentaires (19)

#1

On a vu ce qu’a donné l’action de la QdN malheureusement… Il ne suffit pas d’agir, encore faut-il qu’en face il y ait une réaction, ou au moins la volonté de traiter les sujets !

Le Chili a légiféré sur la protection, mais y a-t-il des pays qui ont autorisé ces traitements ? Ou l’envisagent ? Ça fait peur… Faudra-t-il bientôt “chiffrer” son visage pour conserver sa liberté de mouvement sans être espionné “under the skin” ?

Sinon, beau travail de la députée, ce sont des questions sérieuses. Mais je n’ai pas bien compris si c’était juste un article avec des propositions de “bonne intention”, ou si c’était un début de travail législatif ? On en parle ici et sur le site de la Fondation Jean Jaurès, mais qui d’autre s’empare du sujet, du côté du législateur ?

#2

Ça c’est une très très bonne idée !

#3

C’est la commission copie privée qui pose la question ?

#3.1

#4

N’étant pas inscrite dans un groupe parlementaire, son travail risque de rester lettre morte mais cela fait quand même plaisir d’avoir des député·e·s qui soulèvent de vrais problèmes

#5

Je pense même qu’il faut tout analyser avec une IA alimentée par de l’hydrogène issus de smartgrids et de véhicules autonomes et acheté via la blockchain, pour vraiment en finir avec ce solutionnisme technologique ! (j’ai bon là, j’ai rien oublié ? )

)

#5.1

quantique !

#6

Y’a une phrase que je répète quasi quotidiennement au boulot : “c’est pas technique, c’est de l’orga”.

Systématiquement, les projets et métier veulent compenser un mauvais geste ou un défaut de conception par une réponse technique. Tout aussi systématiquement, ça ne fonctionne pas.

C’est malheureusement devenu culturel : on cherche un moyen technique pour résoudre un problème humain.

#6.1

oh que c’est bien dit

faudra que je pense à ressortir ça aux CDP pour qu’ils l’expliquent aux clients qui font des demandes tordues pour compenser qu’ils sont mal organisés

#6.2

Fais en bon usage

La méthode que j’applique avec ce principe est de découper et reformuler le besoin jusqu’à leur démontrer qu’ils veulent compenser leur propre incompétence. Parce que je travaille hélas avec des des CP caisses enregistreuses : le métier dit, il faut faire, dont faut le faire bêtement sans réfléchir… (challenger le besoin ? houlà surtout pas, ils ont toujours raison !)

Que de thune gaspillée dans ces conneries !

#7

Et 5G aussi.

#8

J’ai trouvé cet article bien écrit, merci @Manach.

Cet article est une bonne analyse contrairement à d’autres qui sont parfois un inventaire d’exemples indigeste.

#9

Et dans le Brief d’aujourd’hui, Mme Pécresse veut une IA pour exploiter sa “vidéoprotection” parce qu’il y a tellement de caméra et pas assez d’agents.

#10

Clairement, sur le numérique, Paula Forteza me parait de loin la plus impliquée et la plus compétente de l’hémicycle. Mais elle n’était déjà pas écoutée quand elle faisait parti de la majorité, alors maintenant qu’elle en est partie …

#11

Oui, c’est un peu l’équivalent du fameux “dis-moi ce dont tu as besoin, je t’expliquerai comment t’en passer”. Meme sans aller jusqu’à remettre en cause le bien-fondé du besoin exprimé, il faut un peu de tact pour faire passer l’idée qu’il faut peut etre le reformuler / découper, voire le retravailler. Ca, ce n’est pas mon fort ^_^

#11.1

En fait l’idée n’est pas de leur dire comment s’en passer, mais de les laisser exprimer ce sur quoi ils sont compétents : la finalité de la chose (et ne pas oublier que l’agilité considère que le client a le droit de changer d’avis, tant qu’il ne devient pas une girouette). Charge aux personnes compétentes sur le sujet de le traduire en technique et découpant chaque aspect pour construire la chaîne de valeur.

Ceux qui viennent directement avec leur besoin + leur solution technique sans avoir consulté qui que ce soit, et en plus forcent pour le mettre en place parce que “le client a toujours raison” (spoiler alert : non, il ne sait quasi jamais ce qu’il veut) ne donnent qu’un seul résultat : un gaspillage d’énergie et de ressources. (dernier exemple en date de tête, le client qui a exigé une API pour retourner des données, sauf qu’il s’en sert pour extraire 45% de sa base articles avec les mouvements de stocks et commandes associées … et ensuite il râle que le système ne tient pas la charge. Bawé normal, une API c’est pas fait pour faire du flux batch et ramener 100Mo de données par appel…)

C’est pas pour rien que l’hymne des prestataires c’est : faire et défaire, ça fait du chiffre d’affaire. Perso j’essaye de faire du chiffre d’affaire qui me valorise un minimum, d’où mon refus de me laisser entraîner dans ces rouages infernaux.

Mais c’est un exercice qui est très difficile.

#11.2

Tout ça me fait fortement pensé à la vidéo de l’expert en réunion .

.

#11.3

Un grand classique

Loin d’être faux

#12

Ce qui peut s’expliquer aisément en formulant ainsi: le client exprime le “quoi”, toi tu proposes le “comment”. Dès que le métier veut s’intéresser au “comment”, tu sais que ça va partir en vrille.

Mébon, au final c’est leur argent, s’ils insistent pour me le donner, hein…