Après des mois de travail, la première alpha publique de FreeNAS 10 est enfin disponible. Elle se base sur FreeBSD 10.2 et les changements sont nombreux, aussi bien sur l'interface que sur l'architecture interne du système d'exploitation.

FreeNAS est un système d'exploitation libre permettant de transformer un serveur en NAS. Alors que la mouture 9.3 est déployée depuis maintenant près de 10 mois, la première alpha publique de la version 10 est disponible. Elle est présentée comme « un nouveau chapitre dans l'histoire de ce projet » et, comme son nom le laisse supposer, elle est basée pour la première fois sur FreeBSD 10 (en version 10.2 pour être précis).

Tout change : de l'interface à l'architecture interne

Les changements sont nombreux et importants, à commencer par la présence de deux interfaces graphiques. La première reste dans la lignée de ce que l'on trouve dans FreeNAS 9.x, tandis que la seconde est « basée sur les technologies du Web modernes et propose un accès beaucoup plus interactif aux options de FreeNAS ». Plus de détails sont donnés dans ce dépôt GitHub ainsi que sur ce billet de blog.

L'équipe en charge du projet explique également avoir également entièrement revu la conception interne avec un « tout nouveau serveur "middleware" qui sert de médiateur pour tous les accès à FreeNAS et supporte le multi-utilisateur (et bientôt multi-rôle) pour l'accès au système ». Tous les détails techniques se trouvent dans ce billet de blog. De son côté, l'interpréteur de commande (CLI) a été amélioré avec de l'autocomplétion et un accès « haut niveau à toutes les fonctions et événements de FreeNAS ».

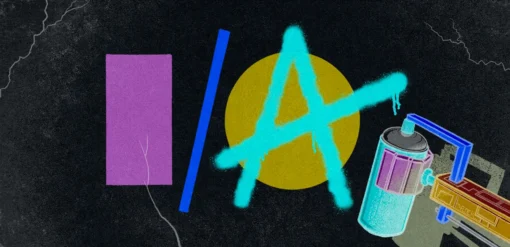

L'architecture interne de FreeNAS 9 puis celle de FreeNAS 10 avec le « middleware » en position centrale

Des limitations inhérentes à cette version alpha

Plusieurs restrictions sont évidemment de la partie avec cette mouture alpha. Tout d'abord, Swift et Gluster ne sont pas encore pris en charge, tout comme les périphériques de stockage ainsi que les « pools » chiffrés, cette dernière fonctionnalité étant en train d'être entièrement retravaillée pour FreeNAS 10. La gestion des plugins n'est pas disponible car elle est également en pleine mutation. Elle passera par la virtualisation avec l'hyperviseur bhyve disponible dans FreeBSD 10.0 et devrait être disponible avec la bêta.

Si l'aventure vous tente néanmoins, sachez que la mise à jour depuis FreeNAS 9.3 et les versions précédentes n'est pas supportée officiellement (il faudra là encore attendre la bêta). FreeNAS précise tout de même que ce genre de migration « peut fonctionner », mais ne souhaite pas s'engager officiellement sur cette possibilité. Comme toujours avec une version alpha, il est recommandé de ne pas l'installer sur un serveur en production.

Commentaires (47)

#1

Est-ce qu’il y a toujours besoin d’utiliser de la mémoire ECC ?

#2

Oui, puisque c’est toujours ZFS derrière, et c’est lui qui recommande de la mémoire ECC

#3

La même chose existe sous noyau Linux, genre du debian-based ? " />

" />

#4

Oué enfin ça marche très bien sans…

#5

Effectivement, si on utilise ZFS il faut utiliser de la mémoire ECC. Sinon on risque de perdre toutes ses données!

(pour le fonctionnement: ZFS fait un checksum de toutes les données présente sur le disque pour des raisons de robustesse et pour éviter les cocrumptions silencieuse des données. Ce checksum est vérifié sen mémoire lorsqu’une donnée est lue, si la mémoire vive a une erreur sur un bit de donnée, le checksum change et ZFS va “corriger” l’erreur en écrivant les données corrompues sur le disque. Si on fait un scrubs d’un volume entier, toutes les données peuvent passer dans cette espace de mémoire vive corrompue et ainsi corrompre les données de tout le disque en plus de corrompre l’architecture du système de fichier.)

#6

Va voir du coté d’Open media Vault

#7

Tu parles d’une distrib : OpenMediaVault ?

Et pour ZFS c’est bien, j’adore ce FS. Mais sous Linux j’ai eu pas mal de soucis avec les portages ZFS/fuse et ZFSonLinux. Et sous FreeNAS tu fais pas ce que tu veux avec l’OS si je ne m’abuse.

#8

J’allais me lancer et redonner vie a un vieux Dell T3400. Je vais finalement attendre cette v10 ^^

Et oui, ZFS requiert de la ECC, pas tant pour les données qui peuvent etre corrompues, mais surtout pour le dataset (journal de fichiers), autant ne pas prendre de risques.

#9

Un petit tuto pour la mise en place et l’utilisation serait le bienvenu " />

" />

#10

Le support de ZFS sous est minimale et expérimentale Linux . Il y a un équivalent qui est BTRFS mais lui aussi n’est pas terminé.

#11

cherche “tuto freenas”… tu tombera sur un truc du genre “durindel”

C’est vraiment facile à trouver quand même

#12

Comme avec tous les systèmes de fichiers en faite.

L’utilisation de la RAM ECC c’est vraiment pour des usages professionnel avancé. Car un bit de mémoire qui change d’état cela n’arrive quasiment jamais.

#13

Sinon il y a NAS4free aussi

#14

Je sais pas si il est à jour, mais effectivement le tuto de Durindel (http://www.durindel.fr/tutoriel-configuration-de-freenas ) m’a beaucoup servit.

#15

Pour info :

AMD Sempron 140

8go ram ddr3 Gskill

Asus m4a89gtd

2 carte contrôleur Asus U3S6 pour avoir des sata en plus (30€ l’unité… pas cher)

8 HDD (5 bon vieux spin F1 qui tourne toujours en raidZ + 2 barracuda et un vélociraptor)

1 clé usb sandisk ultra fit pour l’os

Le tout dans un Fractal R3, avec tout les tiroirs c’est très agréable.

J’ai juste remplacé le proc’ par un 1045T et mis une 4870 qui tourne toujours pour en faire un pc de jeux/secours quand il sert pas de serveur de stockage.

… franchement, si vous avez un vieux machin qui traine et que vous pouvez booster la ram, ça fait un petit serveur très sympa. Tout à fais compatible Rsync si vous avez un Synology à sauvegarder dessus au cas ou :)

@Kazer2.0 : Oh ba c’est bien suffisant. Il avait commencé avec Freenas 8. Là il a fait le 9.3 en décembre 2014 avec d’autres articles plus tard. Ya pas besoin de tuto qui date du mois, c’est complètement bon ce qu’il fait ;)

#16

+10 !

#17

bon, moi qui étais pret à refaire mon install de FreeBSD sur une base 10.2 neuve, j’vais attendre un peu pour (re) tester FreeNAS !

une X-series fanless dans un Fractal R2, un Opteron sur une Tyan, une brouette de WD Green sur une carte LSI 1068 (25€ sur Ebay !), la machine du bonheur, allumée début 2011 et jamais touchée depuis <3

#18

De toute façon c’est prévu pour que tu n’ai pas besoin de mettre les mains sous le capot.

#19

Et pour le ZFS je crois qu’il faut énormément de mémoire aussi, 1 Go / To de disque il me semble. Je ne me souviens plus exactement des chiffres.

C’est entre autre pour ca que je suis passé sous Openmediavault qui me convient très bien.

#20

J’ai acheté un proliant G1610T il y a deux semaines et installé FreeNAS9 !

" />

" />

Cette version 10 annonce du bon

#21

#22

Oui, c’est gourmand. 1Go de RAM par To de stockage… a peu près. ça dépend des usages. Si tu utilise de la déduplication faut multiplier par 2 ou 4 les besoins en RAM, je sais plus… après c’est recommandé 8Go de base.

#23

Et bien non, en faite c’est par 5 pour la déduplication ^^

base 8Go

+2 pour une AD

+4 par VM

+16 pour de l’iscsi…

C’est pas gourmand, c’est ultra goinfre ! ^^

==> Doc RAM FreeNAS

#24

hate de tester la version finale sur mon NAS.

#25

La déduplication en usage Home est apparement inutile.

Par contre la ECC je passerai pas a coté. Ca doit se trouver pas cher pour un vieux Core2Duo/Quad, largement suffisant pour un NAS meme avec encodage video.

#26

Ya des chances oui, mais faut voir l’usage.

Par contre, que je sache, la ram ecc ne fonctionne qu’avec des xeon.

#27

Non.

ECC intel cpus

#28

#29

#30

#31

Certes, mais moi j’aime bien personnaliser un système à fond !

J’ai fait un tuto histoire de montrer un peu le top sur mon serveur local => http://wiki.osremix.com/fr/ordinateurs/linux/installer_configurer_serveur_polyva…

#32

Le ZFS j’adore mais si c’est pour une utilisation locale perso autant dire que c’est un truc de riche et que ce soit avec FreeNas ou Nas4Free, il vaut mieux se concentrer sur les chipsets réseau (je recommande Intel) que de savoir si l’intégrité des fichiers sera conservée à coup de Giga de RAM ECC.

J’ai un serveur FreeNas et un OpenMediavault en fait mon FreeNas est un 8To ZFS (5x2To RAIDZ) avec 16Go de RAM que j’ai fini par abandonner au profit d’OMV car malgré tous mes efforts pour peaufiner mes vitesses de transfert de poste à poste j’ai rarement fait mieux que ce que j’ai lu plus haut des pointes au max à 75Mo/s ce qui n’est pas mal en situation domestique mais frustrant quand on sait que la bande passante est quasi libre et qu’on peut espérer jusqu’à 120Mo/s en Gigalan. Quelle ne fut pas ma surprise quand avec une Mini ITX AMD C60 et 4Go de RAM et de l’EXT4 j’obtenais des vitesses de 90 à 110 Mo/s sans rien faire.

Soit, le ZFS apporte son lot de souplesse et de facilités de gestion de données mais comme dit Olivier Cochard-Labbé pour la maison c’est un peu overkill; moi je dirais (et ça n’engage que moi) c’est comme le PC : c’est bien d’y passer, c’est con d’y rester.

#33

Je ne m’y connais pas assez pour savoir si l’histoire de la mémoire ECC utilisée est réelle ou non, mais pour ma part j’ai un NAS perso qui tourne sous FreeNAS 7.x (d’après mes souvenirs… je n’arrive pas à y accéder depuis le web, mon routage ne fonctionne pas) depuis presque 4 ans et mes deux barrette de 4Go ne sont en rien ECC et j’ai encore jamais eu un seul pépin avec …

Par contre je serais bien intéressé pour faire un upgrade (ou plusieurs par paliers) tout en gardant mon RAID5 et mes données safe et dispo après upgrade ? C’est faisable ça ?

#34

pour un raspberry 2, est ce que cela fonctionne ?

je lis dans les commentaires qu’il faut de l’ECC et bcp de RAM

#35

L’ECC n’est pas obligatoire, mais c’est une sécurité (qui a un certain coup).

C’est un peu comme un double backup, y a peu de chances qu’un backup crame, mais y en a tout de meme, donc go double backup.

La ECC c’est pareil, en cas de coupure, un fichier a des chances d’etre corrompu, si pas de bol, c’est le catalogue qui est corrompu et la tu perds tout. Donc comme pour les backups, mieux vuat pas jouer avec le feu, si tu as des données tres importantes sur ton NAS.

#36

Non malheureusement. Processeur x86 en 64bit quasi obligatoire.

Hardware

#37

#38

En ZFS les données ne sont pas écrite de la même façon je crois. Le fichier est copié et l’index est mit en dernier ce qui limite bien plus la corruption en cas de coupure. En temps normal on aurait un bout de fichier copié, là y’aurait rien du tout (sauf si ça coupe pile dans l’écriture de l’index…)

#39

#40

ECC ne protège pas contre les coupures mais contre le changement d’état imprévu d’un bit (impact d’un rayon cosmique ou défaillance matérielle).

#41

Oui la vitesse est impactée…. ça va plus vite avec lz4.

Car le CPU est rapide alors que le HDD est un goulot d’étranglement.

Une fois compressé il y a moins de blocs à écrire.

#42

#43

Non si il y a une micro coupure capable d’effacer la RAM elle va forcément engendré un redémarrage de CPU bien avant. De plus les RAM de PC sont capable de détecter un contenu corrompu avec un contrôle de parité.

La RAM ECC permet une détection plus approfondi, sur des bloques plus petits et offre la possibilité de restaurer le contenu défectueux.

Mais dans la pratique un bit qui change comme cela est extrêmement rare si les contrôles de qualité de la RAM ont bien été fait (et c’est le cas sur toutes les RAM du commerce).

Bref à main d’avoir des données extrêmement critique où d’être un haute altitude et d’avoir également un CPU qui possède des caches et registre ECC également la RAM ECC c’est bon pour faire jolie.

#44

Oui, j’avais compris, le controle fin de la corruption des données, c’est surtout ca la spécificité de la ECC. ^^

Pour la raison pour laquelle une bit en RAM va etre corrompu, je vous fais confiance, si les micro coupures n’induisent pas de corruption alors tant mieux.

Simplement, que vu que j’ai mis la main sur un Dell T3400, qui a des barettes ECC installées, je vais en profiter :)

Sachant que dans mon freenas je vais mettre des photos/videos auxquelles je tiens, autant etre rassuré, meme si c’est purement psy.

#45

Gros débat, une bonne analyse ici :http://jrs-s.net/2015/02/03/will-zfs-and-non-ecc-ram-kill-your-data/

En gros sans ECC, le mécanisme de checksum/scrub de ZFS n’est pas fiable à 100%.

#46

Merci pour le lien, je vais me pencher dessus.

cf le site de Durindel :

“Pour ma part, j’ai jugé ce risque acceptable et ai choisi de la RAM standard pour mon premier NAS, testée toutefois pendant 36h consécutives avec MemTest86, aucune erreur n’étant acceptable.”

Tout est dit, si non ECC, mieux vaut de bonne barettes, et ca roule.

#47

Si c’est toujours d’actualité, le portage ZFS est assez abouti sous Linux maintenant.

http://www.zfsbuild.com/2013/01/25/zfsbuild2012-nexenta-vs-freenas-vs-zfsguru/

Je ne connais pas bien Freenas, mais je partirait plutôt sur Nexenta, qui est gratuit jusqu’à 16 ou 18TB de mémoire, pour faire du ZFS.