Des chercheurs ont développé « le premier nano-neurone artificiel capable de reconnaitre des chiffres prononcés par différents locuteurs ». Julie Grollier, directrice de recherche au CNRS et co-auteure de la publication scientifique dans Nature, revient avec nous sur les détails de cette annonce et ses implications dans l'intelligence artificielle.

Depuis longtemps, l'intelligence artificielle (au sens large du terme) s'inspire du cerveau humain, et parvient même à le dépasser dans certaines tâches (lire notre analyse sur le jeu de Go). En l'espace de quelques mois, deux étapes importantes ont été franchies dans le biomimétisme. En avril dernier, des chercheurs de l'unité mixte de physique CNRS/Thales annonçaient avoir créé « une synapse artificielle capable d'apprendre de manière autonome [...] et réussi à modéliser ce dispositif ».

Pour rappel, les synapses assurent la connexion et la transmission d'informations entre les neurones du cerveau. Aujourd'hui, suite logique des événements, la même équipe du CNRS/Thales (qui mélange donc recherche fondamentale et appliquée) annonce un nano-neurone artificiel fonctionnel, une première mondiale. Cette démonstration aura demandé environ cinq ans de travail à l'équipe.

Une avancée, certes, mais dans quelle direction et surtout dans quel but ? Julie Grollier, co-auteure de la publication scientifique et directrice de recherche au CNRS, répond à nos questions.

Quelle est la réelle nouveauté ?

Nous avons tout d'abord cherché à savoir quelle était la nouveauté dans l'annonce d'aujourd'hui, car des neurones artificiels existent depuis longtemps déjà. Les deux éléments importants sont : nano et fonctionnel. « Avant il n’existait pas de neurones de la taille nanométrique, en tout cas capable de faire une tâche cognitive » nous explique la scientifique.

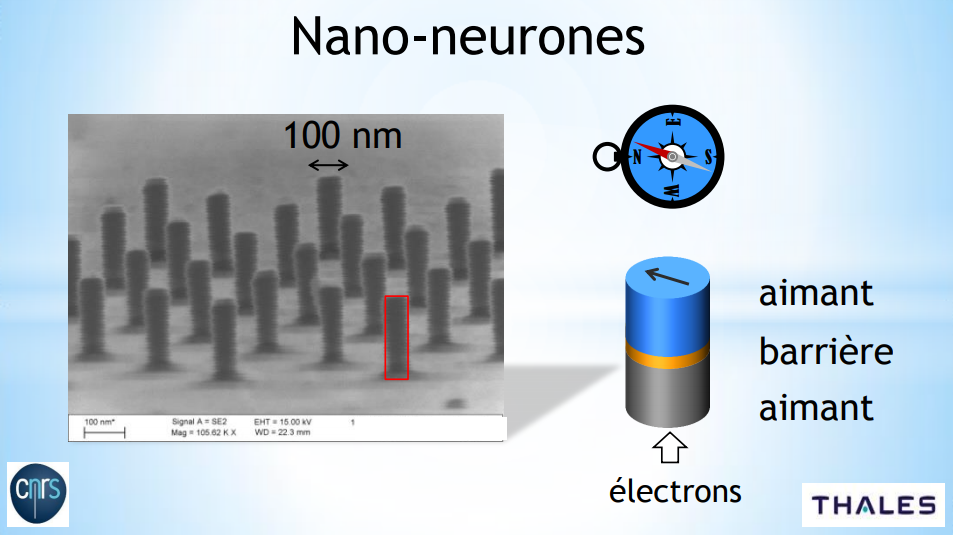

La taille des neurones que l'on retrouve dans des circuits est « entre dix et cent micromètres, le nôtre fait pour l’instant une centaine de nanomètres ». À titre de comparaison, le diamètre d'un cheveu est d'environ 50 à 100 micromètres et, pour rappel, un micromètre est égal à 1 000 nanomètres. Entre le nano-neurone de l'unité mixte CNRS/Thales et les autres, il y a donc un rapport allant de 100 à 1 000 tout de même.

Une différence de composition, une importante robustesse

La taille n'est pas le seul point différenciant. « Les neurones qui existent sont faits en électronique classique avec des transistors, il faut assembler énormément de transistors pour en faire un ». Ce n'est pas le cas du nano-neurone : « c’est un cylindre magnétique composé de deux aimants », et ne comprenant donc aucun transistor.

La chercheuse rappelle que, dans l'industrie, utiliser cette technique – spintronique – n'est pas nouveau : on retrouve les cylindres magnétiques dans des cellules de mémoire magnétique. Les puces peuvent comporter des milliards de cylindres (chacun représente un bit 0 ou 1), mais la composition n'est pas du tout la même : ils sont très espacés (enfin, à leur échelle) afin d'éviter toute interférence. Pour le stockage d'informations, l'intégrité des données est primordiale. Dans le cas d'un réseau de nano-neurones, il faut au contraire qu'ils soient proches les uns des autres afin de pouvoir interagir.

Un avantage important des matériaux magnétiques utilisés est « leur très grande stabilité, leur possibilité de retenir l’information même lorsqu’on enlève le courant électrique (pour la consommation, c’est un plus) et le fait qu'on la stocke dans un aimant ». On peut ainsi comparer ce dernier à une boussole pointant à gauche ou à droite et surtout n'introduisant pas de dégradation du matériau lorsqu'on change le sens de l'aiguille : « on peut écrire et lire presque une infinité de fois sans les détruire ».

À terme par contre, l'équipe utilisera certainement des transistors afin de réaliser un réseau de neurones complet. À l'heure actuelle, elle n'a présenté qu'un seul nano-neurone fonctionnel, il reste donc du travail avant d'en arriver là.

Un seul nano-neurone pour le moment, un peu d'astuce pour créer un réseau

Afin de réaliser des tâches cognitives avec leur neurone, les chercheurs ont utilisé une astuce : le multiplexage temporel (TDM en anglais). Pour simplifier, il s'agit de « découper » un nano-neurone dans le temps afin d'en émuler plusieurs. Dans le cas présent, le réseau était constitué de 400 nano-neurones virtuels afin de réaliser « du calcul cognitif et reconnaitre des chiffres prononcés par différentes personnes ».

Une solution possible car le nano-neurone est « très rapide, il fonctionne beaucoup plus vite qu’un neurone biologique » affirme Julie Grollier. « Un neurone biologique, ça fonctionne au Hz, là on est à la centaine de MHz. On utilise le même neurone plusieurs fois pour en imiter un ensemble, sans perdre tellement de temps ».

Le fonctionnement de la reconnaissance vocale

Avec leur réseau virtuel de 400 nano-neurones, les chercheurs ont pu se lancer dans de la reconnaissance vocale. Ils ont utilisé des fichiers audio comprenant des chiffres prononcés par plusieurs personnes. Le but de l'opération est de les identifier, peu importe l'accent du locuteur. Le résultat est concluant, avec un taux de réussite de 99,6 % selon le CNRS.

Julie Grollier nous détaille le fonctionnement de cette reconnaissance vocale, à partir d'un cylindre magnétique composé de deux aimants :

« Les fichiers audio sont convertis en un signal électrique qu’on accélère et qu’on envoie sous forme de courant électrique à travers nos cylindres aimantés. Ce sont deux nano-aimants séparés par une barrière électrique isolante. Quand on envoie un courant à travers cette structure, l’aimant du haut se comporte comme une boussole dont l’aiguille viendrait tourner.

Quand on envoie un courant électrique de manière permanente à travers ce cylindre, l’aiguille de la boussole tourne en permanence à une fréquence très élevée (quelques centaines de MHz). Mais quand on envoie des ondes électriques qui représentent les chiffres prononcés, l’aiguille de la boussole va transformer ce signal reçu de manière complexe, non linéaire et avec une sorte de mémoire de ce qui s’est passé avant. C’est ça qui va nous permettre de faire la fonction neurone. »

Le but est ensuite de réaliser des structures complexes avec plusieurs nano-neurones proches les uns des autres : « comme ils sont aimantés, ils rayonnent des champs magnétiques et ça leur permet donc de communiquer, tout comme des neurones communiquent par l’intermédiaire des synapses ».

Pour le moment, l'expérience ne porte que sur la fonction neurone, les synapses étant simulées sur un ordinateur. En laboratoire, l'équipe espère mettre au point de petits prototypes avec des centaines ou des milliers de neurones magnétiques dans les années qui viennent, c'est du moins « l'objectif qu'on se fixe » ajoute Julie Grollier.

De l'apprentissage en temps réel...

Le but n'est pas de remplacer les processeurs des ordinateurs, mais de proposer un complément dédié à des tâches spécifiques, notamment dans l'intelligence artificielle. L'équipe mixte du CNRS/Thales espère mettre au point des puces capables d'apprendre : « Suivant le flux de données qu’on va leur envoyer, elles vont apprendre à réaliser des tâches en théorie différente comme analyser des données médicales, des données de vidéo (pour guider des robots par exemple) ».

Actuellement, entrainer une intelligence artificielle demande énormément de ressources, aussi bien en puissance de calcul dans les datacenters qu'en quantité de données disponibles. Par exemple, Yann LeCun, patron de l'IA chez Facebook, expliquait qu'il fallait quelques millions, voire milliards d'images d'un objet (table, chaise, voiture, etc.) pour qu'une IA soit ensuite capable de le reconnaitre, en quelques milliards d'opérations.

Une des possibilités ouvertes par les nano-neurones serait de permettre l'apprentissage en temps réel. Attention, il s'agit d'un « espoir » pour l'instant, car personne ne l’a démontré, ajoute la directrice de recherche du CNRS. Dans tous les cas, il ne s'agit pas d'apprentissage non supervisé (ouvrant la voie à une IA forte).

... avec une efficacité énergétique décuplée

« Notre but n’est pas de mettre le cerveau humain sur une puce, explique Julie Grollier. Il s'agit vraiment de faire tourner les algorithmes qui existent, comme le deep learning, capables de trouver des corrélations utiles dans des données, et de le faire de manière beaucoup plus efficace du point de vue de la consommation énergétique ».

Niveau ordre de grandeur : « nos ordinateurs conventionnels consomment une énergie dix mille fois supérieure à celle du cerveau humain », selon le CNRS. Avec des nano-composants, les chercheurs veulent « repenser l’architecture interne de l’électronique ».

Thales se lance dans une comparaison (sans pour autant entrer dans les détails, voir capture ci-dessus) : le cerveau humain est capable de réaliser 10^16 opérations par seconde avec une consommation de 25 watts, contre respectivement 2x10^13 opérations par seconde et 25 watts pour le SoC Xavier de NVIDIA dédié à l'intelligence artificielle. Soit un rapport de 500 entre les deux.

Dans tous les cas, il reste encore du travail puisqu'un seul nano-neurone fonctionnel a été démontré (avec du multiplexage temporel). Les résultats sont néanmoins là et laissent entrevoir de belles perspectives. Rendez-vous dans quelques années afin de voir si le nano-neurone aura des millions/milliards de petits frères pour monter ensemble un réseau de neurones complexe capable de rivaliser avec le cerveau humain sur certaines tâches.

Commentaires (12)

#1

Moi perso, ça me fait flipper.

#2

donc on pourra enfin savoir si un cheval est rare  " />

" />

#3

Ce sous titre " />

" />

#4

#5

les synapses assurent la connexion et la transmission d’informations entre les neurones du cerveau

Déjà cette remarque me laisse perplexe : peut-on parler d’information à ce niveau ?

Deuxio, c’est aussi de super récepteurs à drogues diverses et variées

#6

Un signal électrique, un bit, un photon, tout ça est considéré comme information si il y a mesure. C’est le cas ici, d’autant plus que ces informations sont assez assimilables à des “bits analogiques” (dans la mesure où les “bits” sont sommés, comparés à des niveaux seuils et diminuent avec le temps).

#7

#8

Une information c’est lorsque l’on donne du sens à une donnée (signal éléctrique, bit ne sont que donnée). Ce n’est pas la mesure qui importe, mais la signification qu’on lui donne.

Les nano neuronnes font en effet transiter une information car le traitement qui lui a été donné (poids, fonction de seuils etc…) lui donne un sens :)

#9

#10

Ça m’avait complètement échappé, INtéressant ! " />

" />

#11

C’est très prometteur !

#12

Ah oui ok, j’avais pas vu le facteur sur le nombre d’opérations par secondes " />

" />

Néanmoins la comparaison de puissance cerveau vs CPU me fera toujours sourire… Cette notion de “puissance de calcul” est beaucoup trop vague pour être comparée. Quoi qu’on fasse et quoi qu’on dise, un CPU peut calculer 5000 décimales de PI en une seconde, un cerveau n’a même pas le temps de poser son calcul mental pour calculer une décimale ou deux. A côté de ça, le cerveau peut reconnaître une forme ou l’expression d’un visage en une fraction de seconde (1⁄10 environ), là ou il faudra plusieurs secondes à un CPU pour faire la même opération. Que peut-on en déduire ? Pas grand chose. Les 2 “entités” ont des avantages et des inconvénients selon le type de problématique proposé, selon les phénomènes qui entrent en jeu. Tout ce qui compte c’est de combiner et d’utiliser intelligemment les 2 !