La CNIL a délivré un satisfecit au ministère de l'Intérieur. Cependant, elle regrette la précipitation avec laquelle elle a dû rendre son avis, et attend que ses modalités précises soient définies par décret.

Comme nous le relevions dans notre décryptage, le projet de loi relatif aux jeux Olympiques et Paralympiques de 2024 « contient d’importantes dispositions sur les libertés publiques et la vidéosurveillance ». Et ce, alors que son étude promet d’être rapide : au Sénat dès le 24 janvier, le texte devrait être étudié à l’Assemblée dès fin février.

- Les desideratas des marchands de vidéoprotection

- Les Jeux olympiques, beta-test de la surveillance algorithmique

- Vidéosurveillance : il n'y aura pas de reconnaissance faciale aux JO 2024

- JO 2024 : le ministère des Sports confirme le recours à la vidéosurveillance « intelligente »

- JO 2024 : les expérimentations de vidéosurveillance algorithmique dureront jusqu'en juin 2025

La CNIL a donc été saisie par le ministère de l’Intérieur et des Outre-mer, ainsi que par le ministère des Sports et des jeux Olympiques et Paralympiques. Dans un communiqué, elle explique devoir donner son avis sur plusieurs articles qui « présentent des enjeux forts en matière de protection des données personnelles et de vie privée » :

- l’autorisation de l’examen des caractéristiques génétiques ou de la comparaison d’empreintes génétiques pour les analyses antidopages ;

- la mise en conformité du code de la sécurité intérieure (CSI) avec le RGPD et la directive « Police-Justice » ;

- l’utilisation de traitements algorithmiques sur les images captées par des dispositifs de vidéoprotection ou des caméras installées sur des drones (appelés également « caméras augmentées »). Ces traitements doivent servir à détecter et signaler en temps réel des évènements prédéterminés susceptibles de menacer la sécurité des personnes ;

- l’extension des types d'images de vidéoprotection que les agents des services internes de la SNCF et de la RATP peuvent visionner lorsqu’ils sont affectés au sein des salles d’information et de commandement relevant de l’État ;

- l’élargissement de la procédure de « criblage » prévue par le CSI aux fan-zones et aux participants aux grands évènements ;

- la possibilité de mettre en place des scanners corporels à l’entrée de certains évènements.

La CNIL a délivré un satisfecit, aux motifs que son avis et celui du Conseil d'État « ont conduit le gouvernement à modifier » le projet de loi et que ce dernier « prend en compte une large partie de ses recommandations ». La CNIL relève cependant ne pas s'être « prononcée sur cette nouvelle version du texte ». Par ailleurs, elle indique dans sa délibération :

« De manière générale, la Commission regrette d’avoir à se prononcer en urgence sur les évolutions envisagées par le projet de texte, compte tenu de la prévisibilité, largement connue à l’avance, de l’événement et des enjeux importants s’agissant de la vie privée des personnes concernées. »

Antidopage : les sportifs feront l'objet de tests génétiques

La CNIL note que l’autorisation de l’examen des caractéristiques génétiques ou de la comparaison d’empreintes génétiques du sportif aux fins de la lutte contre le dopage « répond au besoin de mettre en conformité le droit français avec :

- les dispositions de l’article 6-2 du code mondial antidopage (CMA) entré en vigueur le 1er janvier 2021 ;

- plusieurs règlements antidopage adoptés par l’Agence mondiale antidopage (AMA). »

« Si la transposition du code mondial antidopage est nécessaire », reconnaît la Commission, elle n'en a pas moins souligné aux ministères qu’il s’agirait de tests « particulièrement intrusifs, qui dérogent de façon importante aux principes encadrant actuellement les analyses génétiques dans le code civil ».

En France, et « hors l’hypothèse du matériel biologique qui se serait naturellement détaché du corps de l'intéressé », seules les personnes condamnées pour crime ou déclarées coupables d'un délit puni de dix ans d'emprisonnement peuvent en effet être « contraintes à se soumettre à la réalisation de telles empreintes sur réquisitions écrites du procureur de la République ».

De plus, l'exception introduite par l’article 4 du projet de loi est « beaucoup plus large que celles qui existaient antérieurement ». Ceci tant d'un point de vue quantitatif, puisque « sont visés ici tous les sportifs », que qualitatif, l’examen réalisé visant des « caractéristiques génétiques constitutionnelles d’une personne et non une simple identification par ses empreintes génétiques ».

La CNIL prend d'abord acte que les analyses des caractéristiques ou comparaisons d’empreintes génétiques – avec les traitements de données qui en découleront – « ne pourront être mises en œuvre qu’aux seules fins de mettre en évidence la présence et l’usage d’une substance ou d’une méthode interdite » en vertu de l’article L. 232-9 du code du sport : « toute autre utilisation de ces données est donc interdite ».

Si le projet de loi initial prévoyait que de tels examens puissent être effectués « même en l’absence de consentement du sportif concerné », cette formulation a disparu. La CNIL avait en effet opposé au ministère que « l’information du sportif, préalablement à sa participation à la compétition, portant sur la possibilité que ses échantillons puissent faire l’objet d’analyses génétiques », constituait une garantie suffisante à l'absence de consentement.

Les données génétiques analysées seront par ailleurs « détruites sans délai » lorsqu’elles ne révèlent aucune substance ou méthode interdites ou, en cas contraire, « au terme des poursuites disciplinaires ou pénales engagées ».

Une mise en conformité « nécessaire », mais « a minima »

La CNIL appelle à « une mise en conformité nécessaire » du code de la sécurité intérieure (CSI) avec le RGPD et la directive « Police-justice ». Dans son communiqué, elle souligne avoir « rappelé à plusieurs reprises » que différentes dispositions du CSI étaient « obsolètes » depuis l’entrée en vigueur, en 2018, du RGPD :

« En effet, elles ne permettent plus aux responsables de traitement de connaître l’état réel de leurs obligations en la matière ni aux personnes concernées de savoir de quelle manière exercer leurs droits, alors même que ces dispositions constituent le cadre juridique général en la matière. »

À ce titre, la CNIL déplore qu'il y ait eu besoin des JO pour qu'un projet de loi « prévoit que les enregistrements visuels de vidéoprotection respectent les dispositions applicables en matière de protection des données personnelles ».

Le ministère « a fait le choix de modifier a minima les dispositions existantes », constate la Commision. Une « réforme plus globale des traitements des images dans les espaces ouverts au public sera cependant nécessaire » pour sécuriser les acteurs et encadrer les usages.

De plus, estime la CNIL, le CSI « devra être complété pour prévoir un encadrement au niveau réglementaire de l’ensemble des droits des personnes concernées ».

Elle relevait en effet dans sa délibération qu'il conviendrait, « d'une part », et « notamment », d' « écarter explicitement, le cas échéant, le droit d’opposition, de prévoir une information des personnes concernées conforme à la réglementation relative à la protection des données, et de clarifier l’articulation entre le droit d’accès aux enregistrements tel que prévu par le CSI (consultation des images intègres, y compris le cas échéant avec la présence de tiers) et le droit d’avoir accès ainsi que d’obtenir copie des données à caractère personnel prévu par le RGPD et la loi du 6 janvier 1978 modifiée (accès aux seules images du demandeur) ».

En conclusion, la Commission « insiste » sur le caractère « indispensable » d’une « mise en conformité plus générale » du CSI pour « permettre aux responsables de traitement de connaître l’état réel de leurs obligations en la matière et aux personnes concernées de savoir de quelle manière exercer leurs droits ».

Un « tournant » en matière d'IA et de vie privée

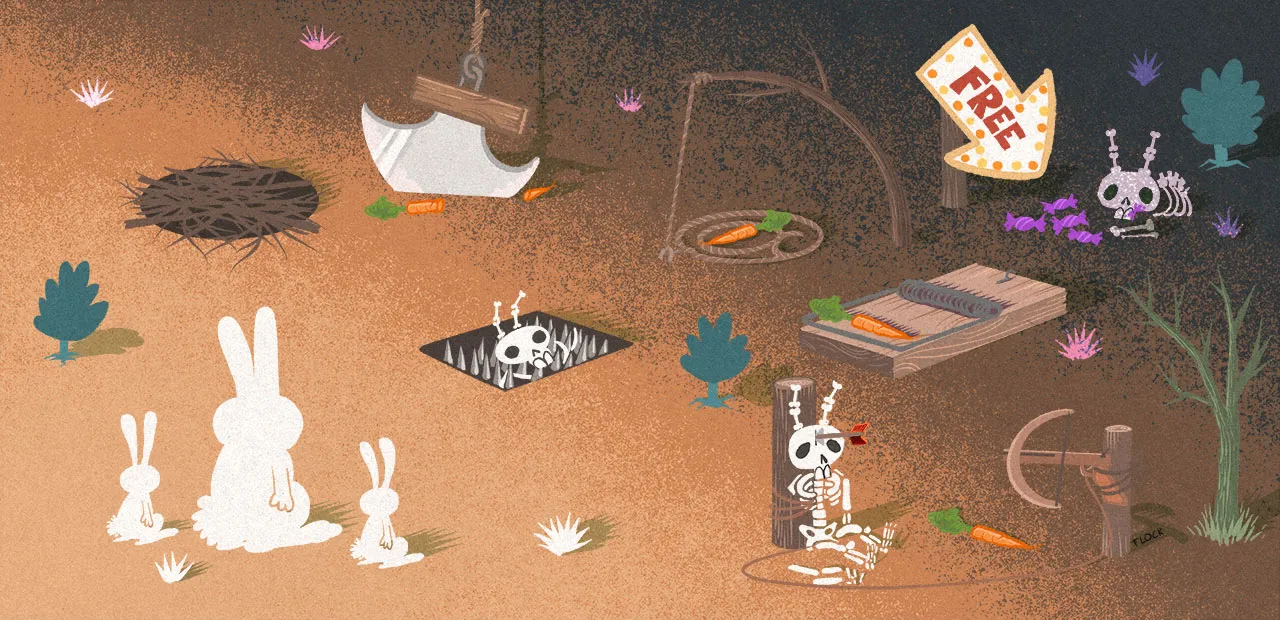

Le déploiement « même expérimental » de systèmes d’intelligence artificielle (IA), appelés « caméras augmentées », sera un « tournant », estime la CNIL. Celui-ci « va contribuer à définir le rôle général » attribué à ces technologies en particulier et aux IA en général.

Or ces technologies soulèvent des « enjeux nouveaux et substantiels en matière de vie privée ». En effet, ces outils peuvent « conduire à une collecte massive de données personnelles et permettent une surveillance automatisée en temps réel » :

« Ils auront pour objet l’analyse automatique des images en temps réel, par des algorithmes, pour détecter des évènements prédéterminés, par exemple la détection de mouvements de foules, de bagages, de gestes ou de comportements suspects, etc. »

Dans son communiqué, la CNIL estime que les garanties prévues par le projet de loi « permettent de limiter les risques » d’atteinte aux données et à la vie privée des personnes. Elle considère que ces dispositions vont dans le sens des préconisations formulées dans sa prise de position de juillet 2022, où elle avait appelé à « fixer des lignes rouges », pour se « prémunir de tout phénomène d’accoutumance et de banalisation de ces technologies de plus en plus intrusives ». Parmi ses recommandations :

- un déploiement expérimental ;

- limité dans le temps et l’espace ;

- pour des finalités spécifiques et correspondant à des risques graves pour les personnes ;

- l'absence de traitement de données biométriques ;

- l'absence de rapprochement avec d’autres fichiers ;

- l'absence de décision automatique : les algorithmes ne servent qu’à signaler des situations potentiellement problématiques à des personnes qui procèdent ensuite à une analyse humaine.

Le PJL reprend « une large partie » des recommandations de la CNIL

Dans sa délibération, la CNIL souligne que les traitements algorithmiques ne pourraient être mis en œuvre que par les services de la police et de la gendarmerie nationales, les services d’incendie et de secours, les services de police municipale et les services internes de sécurité de la SNCF et de la RATP dans le cadre de leurs missions respectives.

La CNIL se félicite que leur encadrement, tel que prévu par le projet de loi, prenne « en compte une large partie de ses recommandations ». En effet, celui-ci :

- relève du niveau législatif ;

- réserve les analyses automatisées à des « hypothèses restreintes », lors de manifestations présentant des risques exceptionnels pour l’ordre public, pour n'être déployé que dans « un ou plusieurs lieux précis, pour un temps limité et une finalité spécifique » ;

- prévoit en outre « un certain nombre de garanties à même de limiter les risques d’atteinte aux données à caractère personnel et à la vie privée des personnes ».

Conformément à l’article 9 du RGPD, tout traitement de données biométriques « aux fins d'identifier une personne physique de manière unique » est proscrit (« ce qui exclut notamment les dispositifs de reconnaissance faciale »). Par ailleurs, les outils en question ne procèderont à « aucun rapprochement, interconnexion ou mise en relation automatisée avec d’autres traitements de données à caractère personnel » et ne pourront « fonder, par eux-mêmes, aucune décision individuelle ni poursuites automatisées ».

Enfin, leur mise en œuvre est également « conditionnée à l’existence et à la robustesse de mesures de contrôle humain », ainsi que d’un « système de gestion des risques permettant de prévenir et de corriger la survenue de biais éventuels ou de mauvaise utilisation ».

Une expérimentation très encadrée

Les risques de dérives sont accrus lorsque les traitements algorithmiques sont effectués sur des images provenant de caméras installées sur des aéronefs – et donc des drones –, indique tout de même la CNIL. En effet, ceux-ci sont « eux-mêmes des dispositifs mobiles, discrets et dont la position en hauteur leur permet de filmer des lieux difficiles d’accès voire interdits aux caméras classiques ».

Le Gouvernement devra d'ailleurs mener une réflexion sur la mise en place d’un protocole d’évaluation permettant de « mesurer de façon rigoureuse, contradictoire et pluridisciplinaire » les technologies qu'il aura testées.

Le terme de l'expérimentation, lui, a été reculé au 30 juin 2025 et non plus au 31 décembre 2024 comme initialement prévu. Ceci répond à l'interrogation qu'avait formulée la CNIL sur la cohérence du calendrier prévu, puisque sa première version proposait une remise du rapport d’évaluation au Parlement « dans un délai maximum de six mois avant le terme de l’expérimentation », soit... avant la tenue des Jeux Olympiques et Paralympiques de 2024.

En l'attente du décret qui devra fixer les modalités de pilotage de l’expérimentation, d'évaluation et les indicateurs utilisés à cette occasion, la CNIL recommande que ce dernier contienne « a minima » :

- une exposition du protocole d’évaluation « afin de permettre un examen contradictoire fidèle à la méthodologie scientifique » ;

- une présentation de l’évaluation des mesures de contrôle humain et du système de gestion des risques « permettant de prévenir et de corriger la survenue de biais éventuels ou de mauvaise utilisation » ;

- des éléments relatifs à la mise en place de pseudonymisation ou de floutage des images et, « dans le cas où le choix serait fait de ne pas appliquer de telles mesures, une analyse démontrant que leur impact sur le niveau de performance de l’algorithme nuirait à l’atteinte des finalités des traitements » ;

- des éléments relatifs à l’information des personnes concernées (supports utilisés, éventuels motifs d’exclusion du droit à l’information…) et des indicateurs « quantitatifs et qualitatifs » concernant l’exercice des droits, ainsi que sur les mesures de sécurité mises en place afin d’assurer la disponibilité, la confidentialité et l’intégrité des données traitées.

Taux d’erreur importants, faux positifs et faux négatifs

La CNIL, qui recommande que l’évaluation soit conduite « en association avec des experts indépendants », réclame en outre une présentation détaillée :

- des résultats obtenus au regard des performances techniques en vue d'obtenir une « appréciation scientifiquement étayée » des outils développés après les phases d’apprentissage, de validation et de correction des paramètres des algorithmes (« taux d’erreurs, analyse et interprétation de ces erreurs, retours sur le gain en performance obtenu lors des différentes phases, mesures des biais discriminatoires, comparaison avec l’état de l’art, etc. ») ;

- des résultats obtenus au regard des besoins ou objectifs opérationnels afin de « mesurer, une fois ceux-ci déployés, l’apport véritable pour la ou les tâches à réaliser des outils développés et questionner l’impact des erreurs du dispositif pour l’atteinte de l’objectif. Une typologie des signalements remontés pourra notamment être réalisée, associée aux suites qui y auront été apportées » ;

- des résultats obtenus au regard des impacts sociétaux afin d’apprécier la perception des outils développés par (et « questionner l’impact des erreurs du dispositif pour ») les personnes concernées.

La CNIL se dit consciente du fait que « les traitements algorithmiques peuvent présenter dans certaines circonstances des taux d’erreur importants, rendant le recours à ces technologies moins efficace en conditions opérationnelles qu’une détection humaine ».

Elle souligne dès lors que « les évènements prédéterminés (mouvement de foule, détection de bagages, gestes et comportements suspects, etc.) » que les IA seront censées détecter devraient être sélectionnés au regard des performances des traitements algorithmiques, « d’après l’état de l’art de la recherche en la matière ».

Elle recommande en outre que l’utilisation des modèles conçus lors de la phase d’apprentissage « soit conditionnée à l’obtention d’un niveau de performance suffisamment élevé à son issue, tant en comparaison de l’état de l’art qu’au regard des besoins des équipes opérationnelles » :

« En particulier, ce niveau de performance devrait être évalué au regard de l’impact potentiel pour les personnes que peuvent avoir par exemple un faux positif ou un faux négatif à la sortie du traitement algorithmique. »

Cette expérimentation ne doit pas être pérennisée

Évoquant les risques de traitements biaisés tant lors des phases de validation que de correction, une fois les IA mises en production, la CNIL recommande également que « l’attention apportée à la fiabilité des données, à l’objectivité et à la pertinence des critères d’apprentissage, à la stricte nécessité des méthodes appliquées » soit « a minima » équivalente à celle apportée à ces mêmes problématiques lors de la phase de conception des IA :

« En effet, l’utilisation de données collectées en conditions réelles lors de ces phases comporte un risque particulier, dû par exemple à une dérive des données entraînant une modification des performances des algorithmes. La Commission considère qu’il convient d’encadrer cette utilisation par des mesures au moins aussi exigeantes que celles mises en œuvre lors de la phase de conception, et permettant de garantir que les modifications apportées aux algorithmes n’entraîneront pas leur dégradation. »

En tout état de cause, la CNIL insiste sur le fait que « cette expérimentation ne saurait en aucun cas préjuger d’une éventuelle pérennisation de ces systèmes » :

« Le cadre juridique prévu par le projet de loi doit, lui-même, être limité à la période expérimentale et temporaire et ne saurait préjuger d’un éventuel encadrement et du schéma de gouvernance applicables dans la perspective de la proposition de règlement pour l’intelligence artificielle actuellement en cours d’élaboration au niveau européen. »

La Commission précise par ailleurs qu'elle travaille à l’élaboration d’une « doctrine générale en matière d’intelligence artificielle » qui se traduira notamment par la publication de recommandations dans le courant de l’année 2023.

50 000 à 60 000 participants non sportifs seront « criblés »

L'accès aux fans-zones de « toute personne autre que les spectateurs », « notamment » les membres des délégations, bénévoles et prestataires techniques, sera par ailleurs subordonné à une enquête administrative impliquant la consultation des divers fichiers de sûreté, comme le précise l'article 10 du projet de loi.

Interrogé par la CNIL, le ministère explique que cela recouvrera « par exemple les acteurs, les sportifs mais aussi leurs équipes (entraîneurs, médecins, kinésithérapeutes, etc.) et les autres personnes participant au bon déroulement de l’évènement (arbitres, chronométreurs, etc.) »

Ce qui, estime la CNIL, « conduira à élargir de manière très substantielle le périmètre des personnes concernées par ces dispositions. Cela pourrait en effet représenter environ 50 000 à 60 000 participants pour les seuls Jeux olympiques et paralympiques selon le ministère » :

« Les données collectées dans ce cadre par le service national des enquêtes administratives de sécurité (SNEAS) pourront être conservées pour une durée pouvant aller jusqu’à cinq ans au sein du fichier mis en œuvre par ce service, dans le cadre du traitement automatisé de données à caractère personnel dénommé Automatisation de la consultation centralisée de renseignements et de données (ACCReD). »

Créé en 2017, il permet un criblage automatisé en autorisant l’exploitation de plusieurs fichiers. Parmi eux, celui des personnes recherchées, le TAJ, ceux de prévention des atteintes à la sécurité publique EASP, PASP et GIPASP, les objets et véhicules volés ou signalés, le fichier CRISTINA de la DGSI ainsi que celui de la DGSE, GESTEREXT, etc (la liste complète).

La CNIL rappelle à ce titre la nécessité de « mettre en place des garanties pour que l’automatisation des consultations des fichiers concernés ne conduise pas à ce que des avis ou des décisions résultent de la seule inscription d’une personne dans un traitement de données à caractère personnel » :

« En effet, des préjudices importants pour les personnes concernées peuvent découler d’un avis ou d’une décision défavorable à la suite de ces consultations. Elle prend acte de ce que le service en charge des enquêtes doit procéder à des vérifications complémentaires lorsqu'il prend connaissance de données pouvant a priori justifier un avis défavorable. »

Commentaires (8)

#1

Les recommandations semblent pas mal … mais vont elles être suivi

J’ai bien peur que une fois en place un décret surprise ne pérennise tout ça

#2

La Quadrature du Net est moins enthousiaste… https://www.laquadrature.net/2023/01/05/mobilisation-generale-contre-la-legalisation-de-la-videosurveillance-automatisee/

#2.1

C’est un sujet extrêmement important et je suis très pessimiste quant à l’avenir le concernant.

Quand je vois la facilité avec laquelle le passe “sanitaire” s’est installé et le peu de réactions qu’il a suscité (alors qu’il est une expérimentation qui s’intègre pleinnement dans ce projet) j’ai bien noté que ces organismes (CNIL et Quadrature du net entre autre) avaient des limites très vites atteintes.

Leur combat est juste mais j’ai arrêté de lire à la première occurence d’écriture inclusive. Ils n’ont de toute évidence pas compris le processus psychologique à l’œuvre derrière cette abomination. Leur combat ne portera donc pas dès qu’ils seront taxés d’un critère non polotitiquement correcte (complotiste, antisémite, raciste, misogyne…). Le plus important étant de ne pas “froisser” les communautés…

Force quand même…

#2.2

Doux euphémisme ! vous avez raison, la corruption systémique est généralisée, tant dans la justice, que dans les AAI qui ont validé des processus totalement inconstitutionnels ! On connait le projet…

#3

“L’accès aux fans-zones de « toute personne autre que les spectateurs », « notamment » les membres des délégations, bénévoles et prestataires techniques, sera par ailleurs subordonné à une enquête administrative impliquant la consultation des divers fichiers de sûreté”

Je trouve ce point très étrange…

Les spectateurs seraient moins contrôlés que le staff ???

#3.1

Logique, la capacité en terme de dégâts d’un membre des personnels de l’équipe est sans commune mesure à celle d’un quidam venu en transport en commun. Un employé possède des accès à des zones spécifiques, peut circuler plus librement dans des surfaces interdites au publique et peut, avec l’organisation qui va bien, transporter des explosifs et des armes à des lieux strategiques au besoin (et même avec des véhicules en fonction du poste).

Comme dans tout travail senssible, une enquête est réalisée sur les employés (cas des informaticiens dans l’armée par exemple).

#4

Merci pour cet article très exhaustif. J’ai quand un reproche à y faire pour la forme: la reprise, sans guillemet quand c’est possible de les mettre, du terme “vidéoprotection”, officiel certes, mais qui ne veut rien dire alors qu’il s’agit en réalité de vidéosurveillance. La “protection”, avec ce système, est très subjective (cf attentat de Nice…)…

#5

J’imagine que les personnes qui gèrent les fans-zones ont plus de “privilèges” que les simples spectateurs (accès aux zones techniques, aux “coulisses”) et donc il est peut-être nécessaire que ces personnes soient plus contrôlées, non ?