La Commission européenne a adopté récemment deux propositions visant à encadrer les règles de responsabilité à l’ère numérique. La première veut moderniser les règles existantes sur la responsabilité objective des fabricants de produits défectueux, l’autre tente – pour la première fois – de définir un cadre pour les erreurs commises par les systèmes d’IA. Nous nous penchons sur la seconde.

Encadrer les responsabilités en matière d’IA était un projet en gestation depuis longtemps à la Commission. Elle est d’autant plus attendue qu’elle doit permettre un essor des SIA (systèmes d’intelligence artificielle) en définissant clairement qui est responsable quand un tel système produit une erreur ayant des répercussions sur la vie des administrés. Un moyen considéré comme l’un des principaux vecteurs de confiance.

On se souvient, dans notre dossier sur le rapport du Conseil d’État, que le nommage d’une personne comme responsable des SIA d’une structure était l’une des recommandations phares. La haute juridiction estimait qu’il s’agissait d’une étape essentielle dans la constitution d’une chaine de responsabilité propre à générer la confiance, cruciale pour un essor sain des SIA en Europe et en France.

La seconde proposition de la Commission vient justement s’attarder sur ce chapitre important de la responsabilité, face à la question : « En cas d’erreur impactant ma vie, quel est mon recours ? ». Elle propose de moderniser le cadre actuel en matière de responsabilité civile, tout en introduisant des règles spécifiques aux dommages causés par les SIA.

Une double garantie

La proposition de règlement établit deux garanties, l’une sur la charge de la preuve, l’autre sur l’accession aux éléments de preuve.

La première (article 4) est cruciale : elle « dispense les victimes de s’acquitter de la charge de la preuve ». Comment ? En introduisent la « présomption de causalité ». Une personne s’estimant victime d’un SIA n’aura ainsi qu’à démontrer qu’il existe un lien « raisonnablement probable » entre l’erreur et une cassure dans les performances d’un système, donc qu’il y a faute probable du SIA, ce dernier n’ayant pas respecté ses obligations.

La personne responsable de ce SIA pourra renverser cette présomption, « par exemple en prouvant qu'une autre cause a entraîné le dommage ».

La deuxième (article 3) est presque aussi importante, puisqu’elle doit permettre une accession aux « éléments de preuve pertinents » quand des SIA à haut risque sont « soupçonnés d’avoir causé un dommage ». Les victimes pourront demander à la juridiction compétente la divulgation d’informations, qui à leur tour devront permettre d’identifier la personne responsable et, idéalement, la racine du problème. Ces informations seront protégées au besoin, par exemple si elles sont soumises au secret professionnel ou des affaires. Le plaignant n’y aura alors pas accès, mais elles seront accessibles à l’institution en charge du dossier.

La Commission estime que ces deux garanties devraient permettre d’instaurer la confiance dans les SIA en Europe en facilitant la recherche de la personne responsable et la capacité à demander des comptes si l’on s’estime victime d’un tel système.

Point important, les règles proposées s’appliqueraient à l’ensemble des SIA, sans distinction. La deuxième ne fait référence aux SIA à haut risque que pour montrer qu’aucun système ne serait plus une boite noire intouchable.

Des règles vues comme vectrices d’innovation

Si la Commission considère que cette proposition de règlement peut promouvoir l’innovation, c’est parce que cette dernière, selon elle, est indissociable de la confiance. En outre, la Commission estime que ces règles constituent un juste milieu entre besoin de progression et protection des populations.

Elle pointe notamment son choix des présomptions réfragables, considérées ici comme « l’outil le moins interventionniste ». Ces présomptions sont donc considérées comme valables jusqu’à preuve du contraire, comme quand on considère, à la naissance d’un enfant, que le mari de la mère est le père.

La Commission ne souhaitait pas renverser la charge de la preuve pour ne pas soumettre les fournisseurs, opérateurs et autres à une pression telle qu’elle aurait freiné toute innovation. Il s’agit donc d’une solution à mi-chemin, considérée comme idéale en ce qu’elle simplifie le parcours et allège notablement la charge de la preuve. L’objectif serait alors rempli : garantir aux victimes des SIA le même niveau de protection que dans les cas où ces derniers n’interviennent pas. Le droit de recours collectif serait ainsi garanti dans ce contexte.

Les administrés des pays membres de l’Union bénéficieraient alors d’une même protection sur les biens matériels et immatériels, avec les mêmes possibilités de recours. Et il est probable que des procédures naitront si cette directive est reprise en l’état par chaque pays membre. On pourrait ainsi voir des plaintes collectives contre des outils courants, comme Parcoursup, ou des procédures contre des agences de credit scoring en Europe. Et que dire des outils d’identification biométrique et leurs biais mainte fois démontrés ?

Dans la vision de la Commission, les entreprises ont également tout à y gagner. Elles seraient « plus à même d’anticiper la manière dont les règles de responsabilité en vigueur seront appliquées et, partant, d'évaluer et d'assurer leur exposition aux risques en matière de responsabilité ». En clair, elles sauraient enfin sur quel pied danser.

Et il y aurait de quoi, car le règlement rejaillirait sur la grande majorité des traitements automatisés. Si on note l’exception prévue pour les logiciels libres ne relevant pas d’une activité commerciale, tous les logiciels intégrés ou autonomes (y compris leurs mises à jour) ainsi que les services numériques seraient concernées. Un simple outil statistique entre dans cette définition. Cela entraînera bien sûr un vaste branle-bas de combat puisque les entreprises auront alors à se lancer dans un inventaire précis des traitements, comprenant les risques associés à chacun, et à nommer un responsable.

Pour l’instant, ce projet de directive prévoit une expiration de la période de responsabilité après 10 ans, sauf bien sûr si une procédure judiciaire a commencé avant ce délai. Ce délai peut être étendu à 15 ans si le risque est jugé « latent ».

Pourquoi une nouvelle directive en plus de la législation ?

« La législation sur l'IA et la directive sur la responsabilité en matière d'IA sont les deux faces d'une même médaille : elles s'appliquent à des moments différents et elles se renforcent mutuellement », explique la Commission.

Plus précisément, la législation – telle qu’elle est envisagée – vise à réduire autant que possible les risques et à prévenir les dommages. Cependant, il est impossible de parvenir au risque zéro. C’est dans ce contexte qu’a pris naissance la proposition de règlement sur la responsabilité en matière d’IA. Ces dispositions sont jugées « nécessaires […] pour que la réparation soit effective et réaliste ». La nouvelle proposition est le « filet de sécurité » de la législation.

On retrouve les mêmes éléments de langage dans les deux propositions, à dessein bien sûr. Ce qui plaira d’ailleurs au Conseil d’État qui, dans son récent rapport préconisant une utilisation plus intensive des SIA dans les administrations françaises, rappelait toute l’importance d’un socle linguistique commun. Les deux maintiennent une distinction entre systèmes à haut risque et ceux qui ne le sont pas.

La proposition de législation sur l’IA avait déjà une approche entièrement tournée vers la création d’un « écosystème d’excellence et de confiance », rejoignant des thématiques largement abordées dans nos colonnes à travers diverses structures, comme l’AFNOR et le Conseil d’État. Cette législation compte poursuivre des buts clairs, notamment la définition d’un cadre clair pour tout le monde et l’affirmation du modèle européen, jusqu’à l’établissement d’un leadership européen dans les secteurs jugés vertueux (développement durable, environnement, santé, agriculture…).

Mais il faut rappeler que cette législation reste pour l’instant une proposition, et qu’elle est soumise à modification. Elle a fait l’objet de diverses critiques, notamment de la CNIL et de ses équivalentes européennes. Elles demandaient par exemple que soient supprimées toutes les exceptions à l’utilisation de l’identification biométrique dans l’espace public. Elles appelaient également à une vigilance particulière sur l’articulation avec le RGPD, car les SIA sont la plupart du temps amenés à manipuler des données personnelles. Enfin, elles se positionnaient comme autorités de contrôle national de l’intelligence artificielle. Précisément ce qu’a recommandé en France le Conseil d’État, qui souhaite voir drastiquement étendus les pouvoirs et moyens de la CNIL.

En ligne de mire, les véhicules autonomes, entre autres

Difficile de ne pas penser aux véhicules autonomes, qui peinent à progresser sur l’échelle de l’automatisation. La voici pour rappel :

- Niveau 1 : assistance simple à la conduite, par exemple avec un régulateur de vitesse.

- Niveau 2 : automatisation de certaines tâches, comme la correction de la trajectoire pour rester dans une file ou l’aide au stationnement.

- Niveau 3 : autonomie dans certaines conditions, comme une accélération ou décélération automatique pour préserver les distances de sécurité, ou doubler un véhicule quand on actionne le clignotant.

Ces trois premiers niveaux ont en commun l’obligation de pouvoir reprendre le contrôle en cas de problème, imposant au conducteur le même degré de vigilance que s’il conduisait. Au contraire des deux niveaux restants :

- Niveau 4 : conduite automatisée presque totale, par exemple sur un certain type de voie, comme l’autoroute. Cette fois, le véhicule est censé faire face de lui-même aux problèmes qui se présentent, sans intervention humaine.

- Niveau 5 : automatisation totale, sans intervention, quelles que soient les conditions. La personne peut programmer une destination, le véhicule s’occupant de tout.

Pour donner la mesure de cette complexité, rappelons que les véhicules autonomes de niveau 3 peuvent rouler en France depuis le 1er septembre, mais seulement sous certaines conditions strictes. Pour résumé, le seul cas d’utilisation prévu est le maintien dans la voie de circulation, à une vitesse ne pouvant dépasser les 60 km/h. Pas question d’autoroute. Il n’y a de toute façon en Europe que très peu de modèles équipés, et la plupart sont en cours d’homologation, comme Tesla. L’EQS et la Classe S de Mercedez-Benz ont l’homologation, mais l’option n’est pas encore proposée en France.

Mais puisque les États-Unis comptent légiférer en début d’année prochaine sur une extension à 130 km/h de la vitesse maximale des véhicules de niveau 3, pourquoi pas en France ? L’avocat François-Pierre Lani résumait le mois dernier le problème à L’Usine Nouvelle : « En cas de danger, la voiture peut envoyer une alerte au conducteur. On considère qu’il faut environ 10 secondes pour reprendre en main le véhicule. Sur une autoroute à 130 km/h, c’est long… S’il y a un accident dans cet intervalle de 10 secondes, on ne sait pas qui est responsable. Le constructeur n’est pas en tort, il a envoyé l’alerte. Le conducteur non plus, il n’a pas encore eu le temps de reprendre le contrôle ». Il estime que la sécurité de ces véhicules devrait être comparable à celle constatée en aéronautique

La question de la responsabilité est donc centrale. Outre les simples limitations techniques, l’arrivée de véhicules de niveaux 4 et 5 demande que de nombreuses questions épineuses aient leur réponse. La proposition de règlement était très attendue pour poser le cadre dans lequel vont s’ébattre les constructeurs, mais ce n’est qu’une première étape, et elle ne répond pas à tous les cas de figure. Elle n’aborde d’ailleurs pas expressément le cas des véhicules autonomes.

Les questions éthiques restent entières

Elle plante quand même un décor au sein duquel les constructeurs sont clairement responsables de leurs SIA. Si l’un d’entre eux conduit à un accident, il faut pouvoir déterminer vers qui se tourner. La question de la responsabilité n’est d’ailleurs pas seulement légale, elle est aussi éthique.

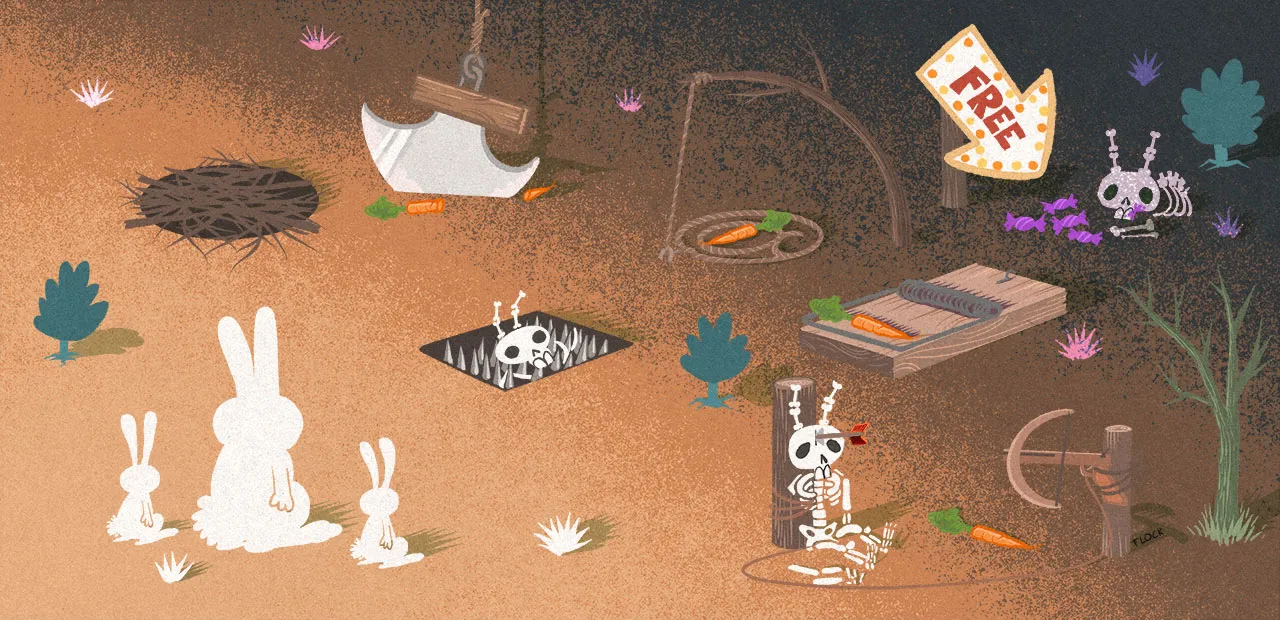

Un véhicule autonome peut se retrouver pris au piège d’un scénario dans lequel toutes les options sont mauvaises. Le SIA responsable de cette décision doit être développé avec tous ces cas figure. Autrement dit, l’équipe de conception devra déjà avoir à l’esprit que de telles situations peuvent se produire et pouvoir y répondre.

Quelqu’un, quelque part, aurait alors à trancher dans une problématique relevant du célèbre dilemme du tramway : préserver la vie d’un groupe de personnes au détriment d’une autre ? Ne doit-on retenir que le nombre ? Et s’il s’agit de préserver la vie de trois personnes âgées au détriment de celle d’une enfant de 6 ans ? Quels autres critères peut-on appliquer ? Mais le dilemme du tramway a été construit comme expérience de pure réflexion pour tester, en quelque sorte, les réactions de la population face à un problème en apparence « simple ».

Dans ce domaine, la question de la responsabilité renvoie directement à celle d’un accident mortel. Il y a donc, fondamentalement, un sac de nœuds éthique à débroussailler avant de pouvoir déterminer qui est en cause : la société qui a entrainé l’intelligence artificielle, le constructeur automobile qui l’a intégré dans sa voiture, le client qui l’a acheté, le conducteur qui a activé l’option… Un client potentiel aurait donc à se plonger dans les conditions d’utilisation d’un véhicule de niveau 4 ou 5, car ce dernier aurait dans ses entrailles électroniques des réponses précises à des questions cruciales.

Le contrat d’utilisation comporterait alors un volet l’informant, littéralement, de qui mourra quand une situation donnée ne peut aboutir qu’à un ou plusieurs décès. Le même client aurait alors à accepter que son véhicule ait pu entrainer une catastrophe, sans qu’il ait pu faire quoi que ce soit et – surtout – qu’il en soit responsable.

Il y a plusieurs année déjà, Mercedes-Benz a fait son choix et préfère être sûr de sauver au moins une vie – celle qui se trouve dans la voiture – plutôt que d'essayer d'en sauver plusieurs autres.

Dans ce contexte, le projet de règlement est crucial, car il est probable que des procédures judiciaires verront le jour, pour contester les décisions du SIA responsable de cette décision. On peut même se demander si des véhicules de niveaux 4 et 5 rouleront un jour en masse, car le temps que toutes ces questions aient trouvé des réponses emportant l’adhésion du plus grand nombre, la voiture perdra peut-être son statut de moyen de transport privilégié.

Et on ne parle ici que des voitures, qu’en sera-t-il des robots/drones tueurs autonomes ?

Aux États-Unis, la question de la responsabilité aussi sur le tapis

Le 4 octobre, la Maison Blanche a dévoilé une nouvelle déclaration des droits de l’intelligence artificielle, avec – dans les grandes lignes – les mêmes ambitions que le projet de directive de la Commission sur la responsabilité.

On retrouve le même numéro d’équilibriste entre protection des consommateurs et entreprises proposant des services et produits utilisant des SIA. Les Américains devront ainsi être protégés contre des systèmes jugés nocifs ou inefficaces, les algorithmes ne devront introduire aucune discrimination, et les SIA devront être utilisés tels qu’ils ont été conçus et de manière équitable. Des garanties devront être intégrées pour laisser aux utilisateurs la pleine maitrise de leurs données. Un point crucial quand on sait que les GAFAM sont toutes américaines.

On trouve d’autres points communs avec les projets de la Commission européenne, comme la possibilité de se retirer à tout moment d’un SIA pour une alternative humaine. Les personnes doivent être averties que leurs données feront l’objet d’un traitement par un SIA et disposer de recours en cas de problèmes.

Ce « bill of rights » est dans l’ensemble un mélange des deux propositions européennes de règlements, la première sur la législation, l’autre sur la responsabilité. Cependant, les deux propositions, modifiées ou non, finiront par être transcrites dans le droit de chaque pays membre de l’UE. La charte américaine pourrait avoir un destin plus chaotique et, surtout, elle ne fait que poser les bases d’une réflexion plus grande sur la responsabilité.

Elle a en effet été produite par l’OSTP (Office of Science and Technology Policy), département du gouvernement américain qui conseille le président sur les questions de sciences et technologies. C’est un plan de bataille, mais en aucun cas une loi. Pour qu’il en devienne une, le texte devra passer par le Congrès américain.

Prochaine étape pour le projet de directive, la navette vers le Parlement européen et le Conseil pour adopter la proposition.

Commentaires (2)

#1

Pour les voitures au moins, il y a une étape d’homologation avant la mise sur route. Est-ce qu’un SIA embarqué sera présumée conforme sur la base des déclarations du constructeur, ou bien est-il prévu une vraie mise à l’épreuve du SIA embarqué dans une voiture autonome ?

Évidemment même question pour les SIA non embarqués dans des voitures. On a pu voir par exemple avec Clearview qui ne reconnait pas aussi bien les visages selon la couleur de peau que des biais des SIA peuvent n’être découverts que lors de l’utilisation à grande échelle. Mais ici, un seul individu ne le saurait pas forcément, comment pourrait-il mettre en oeuvre en pratique cette présomption de causalité si le phénomène non-conforme n’est visible que depuis l’entité qui opère le SIA ?

#2

Le site Moral Machine est très pertinent sur le sujet ;) :

https://www.moralmachine.net/