L’association française de normalisation a son mot à dire dans le grand développement de l’intelligence artificielle, pour plusieurs raisons. Elle propose six axes qui doivent guider l’IA par des normes capables d’établir des bases de confiance et de gouvernance.

L’intelligence artificielle franchira dans les années à venir un cap important : la normalisation. La recherche tous azimuts laissée surtout entre les mains des grandes entreprises ne devrait pas en être ralentie, mais pour les décideurs, il s’agit maintenant d’établir un cadre clair dans lequel tout ce petit monde pourra s’ébattre. En ligne de mire, la confiance du public et des entreprises.

L’Afnor a son mot à dire. Dans le cadre du projet France 2030, le Secrétariat général pour l’investissement (SGPI) – chargé d'assurer la cohérence et le suivi de la politique d’investissement de l’État – a lancé le Grand Défi « sécuriser, certifier et fiabiliser les systèmes fondés sur l’intelligence artificielle ». Il s’appuie sur trois piliers : la recherche, les applications et la normalisation. L’Afnor intervient sur le troisième.

Ce troisième pilier veut « créer l’environnement normatif de confiance accompagnant les outils et les processus de certification des systèmes critiques à base d’intelligence artificielle ». L’Association doit y parvenir en structurant l’ensemble de l’écosystème, via une plateforme de coopération entre acteurs français de l’IA, des actions stratégiques en normalisation et le développement des coopérations européennes et internationales.

Elle a donc publié une feuille de route stratégique sur les étapes clés de cette normalisation, déjà bien entamée. Une quarantaine de pages au contendu dense et sans artifice : l'Association ne manque pas d'éclairer les zones d'ombre et les carences.

Un contexte très particulier

Les éléments de contexte donnés par l’Afnor sont presque aussi importants que les axes eux-mêmes. D’abord parce que l’Association regrette « la relative incompréhension nationale au sujet de la normalisation ». Une partie des entreprises s’en désintéresse, tandis que les start-ups, PME et ETI sont insuffisamment intégrés dans les écosystèmes de normalisation.

L’Afnor rappelle que la normalisation incarne une régulation volontaire « permettant aux entreprises d’inscrire leurs activités dans un contrat collectif compris et accepté par tous. La mise en conformité constitue ainsi une présomption de qualité, de fonctionnement et d’interopérabilité ». L’Europe poussant vers des normes harmonisées, l’absence d’implication est d’autant plus regrettable, déplore l’Association, car une participation plus massive des entreprises leur permettrait d’aider à définir les modalités des futures réglementations.

La normalisation de l’IA, en l’occurrence, est vue par l’Afnor comme un support technique à la future réglementation européenne. Autrement dit, un prélude obligatoire et nécessaire. Une étape logique pour l’organisme, dans la continuité en Europe du Data Governance Act présenté en novembre 2020, du RGPD actif depuis 2018 ou encore de l’étude du rôle de l’IA dans le Green Deal.

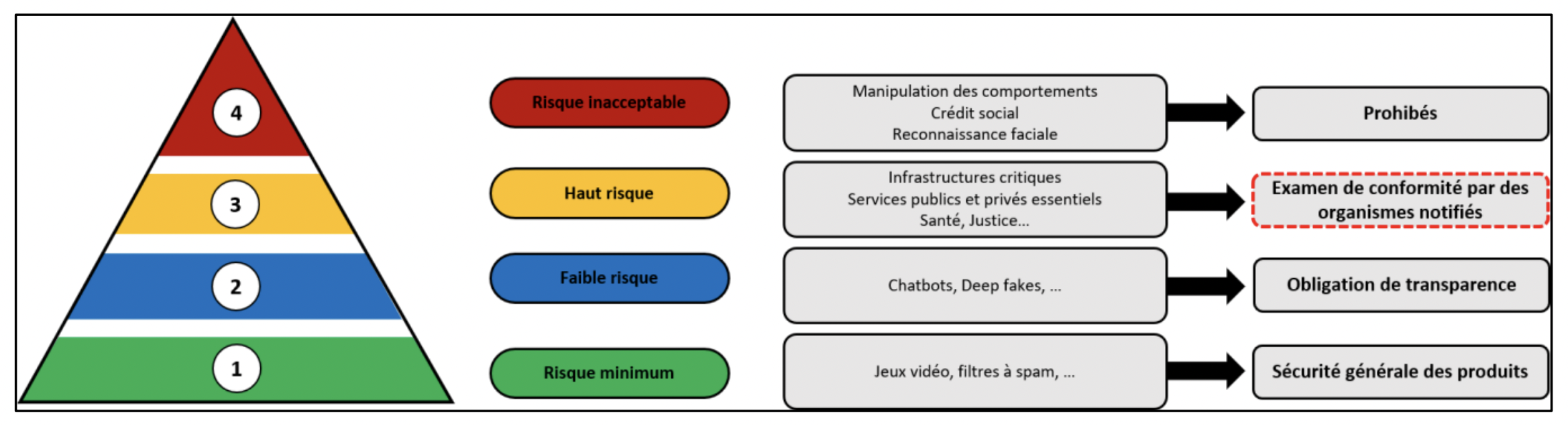

Le plan est actuellement de diviser les systèmes d’IA en quatre catégories, selon les risques représentés. Le niveau 4 représente un risque inacceptable et comprend des catégories de mécanismes aussi sensibles que la manipulation des comportements, le crédit social ou encore… la reconnaissance faciale. Les niveaux 1 et 2 représentent respectivement des risques minimums et faibles. L’IA d’un filtre antispam est ainsi de niveau 1, tandis que celle d’un bot de discussion est de niveau 2. Ils seront soumis à un simple code de conduite.

Le niveau 3 sera l’objet de toutes les attentions. Il concerne les systèmes à haut-risque. Services critiques, publics et privés essentiels, santé ou encore justice y seront présents. Dans ce niveau, tout système IA devra faire cette fois l’objet d’un examen de conformité par des organismes notifiés. Et, bien sûr, cette mesure de conformité se fera à l’aune des normes précédemment établies.

Leur élaboration est d’autant plus importante qu’un cadre clair empêche certaines entreprises de s’accaparer un marché en imposant des technologies devenant autant de « standards de fait ». L’influence de ces structures se fait quand même sentir pendant la création des normes, car chaque partie prenante tente de structurer le marché en faveur de ses propres technologies. L’Afnor le redit d’ailleurs : la participation d’un maximum d’acteurs est cruciale, puisque tout le monde a voix au chapitre.

La confiance comme « clé de voute »

Enfin, il est illusoire pour l’association de passer sous silence l’aspect politique des normes. Elle annonce la couleur : « L’enjeu pour l’Europe et pour la France est double : promouvoir leurs intérêts et leur économie au sein d’un monde de plus en plus polarisé par la rivalité sino-américaine, mais également incarner une position intermédiaire dans le rapport de force entre mondialisme et souverainisme ».

L’Association considère trois critères fondamentaux pour que l’IA puisse se développer de manière saine et pérenne : l’interopérabilité, la souveraineté des actifs liés et la confiance. Les deux premiers sont élémentaires, tandis que la confiance est vue comme la « clé de voute du développement de l’Intelligence artificielle ».

« Au regard de l’imbrication de cette dernière dans l’économie, chacun sera non seulement utilisateur et consommateur, mais également acteur de l’IA. Définir sa nature, son cadre d’utilisation, ses limites et ses objectifs s’impose alors comme une action prioritaire pour penser et choisir la place de l’humain dans ces écosystèmes d’IA », résume l’Afnor.

Ce que souhaite l’association ? Une organisation fondée sur la coopération, jugée « indispensable pour construire une vision forte et convaincante qui puisse être défendue au niveau européen et promue au niveau international ». Pour y parvenir, elle veut une feuille de route nationale proposant des stratégies d’influence, jugée « nécessaire pour promouvoir la position française et valoriser ses intérêts ».

L’Afnor s’est justement attelée à définir la confiance. La stratégie française a déjà sa liste de caractéristiques prioritaires : sécurité, sûreté, explicabilité (comprenant les aspects interprétable et auditable), robustesse, transparence, supervision, contrôlabilité et équité, ce dernier point renvoyant à l’absence totale de discrimination, quelle qu’elle soit. Chaque caractéristique fera l’objet d’une définition complète, d’une description du concept lié, des exigences techniques, ainsi que statistiques et contrôles associés.

Et si l’organisme tient tant à s’assurer de bases solides, c’est parce qu’il prédit un développement de l’IA dans un environnement toujours plus ouvert, qui se caractérise par « la variabilité des scénarios possibles et l’imprévisibilité de certains événements ».

Les grands axes stratégiques proposés par l’Afnor

Dans ce contexte, il n’est pas étonnant que le premier axe promu par l’Association soit le développement des normes portant sur la confiance. Même si la sécurité et la sûreté sont les deux critères de base, tous les autres feront à terme l’objet de normes. Par exemple, en précisant et normalisant le domaine d’emploi d’un algorithme, pour en définir les implications techniques et juridiques, et pour pouvoir définir évidemment la chaine de responsabilité.

Ce domaine d’emploi sera d’autant plus important qu’un même algorithme peut être conçu pour une utilisation particulière, puis être repris plus tard pour d’autres besoins. Ce qu’aimerait l’Afnor, c’est en quelque sorte un grand catalogue dans lequel l’alignement et la cohérence des différents domaines seraient référencés. Ils agiraient alors en première ligne d’analyse dans la recherche de responsabilité en cas d’accident.

Le deuxième axe concerne les normes sur la gouvernance et le management de l’IA. Les entreprises sont prévenues : l’analyse des risques va devenir essentielle, les obligeant à recouvrir à des dispositifs de management de la qualité et des risques. Mauvaise qualité des données, mauvaise conception, mauvaise qualification, mauvaise identification ou compréhension des risques… les dangers ne manquent pas.

Dans ce domaine, deux normes sont en cours de création à l’ISO : ISO 42001 porte sur le management de la qualité des IA, ISO 23894.2 sur le management des risques. Elles pourraient s’imposer sur le plan international, à l’instar d’ISO 9001 pour la qualité et devenir des normes harmonisées européennes. Leur caractère opérationnel reste à vérifier selon l’Association, qui précise que des compléments pourraient être nécessaires.

Troisième axe, le développement de normes sur la supervision et le reporting. Pour faire simple, il s’agit de considérer la place de l’humain dans l’ensemble de la chaine. Dans cet axe, on trouve tout ce qui touche à la capacité de reprendre la main (contrôlable), à la supervision (l’observable) et au reporting, soit la remontée d’une information sur un incident à la bonne personne, en temps et en heure. En somme, établir le cadre qui garantira qu’un système IA fonctionne comme on l’attend. On y trouve d’ailleurs tout ce qui touche à l’explicabilité, donc aux audits.

L’axe 4 est fondamental puisqu’il concerne les normes sur les compétences des organismes de certification. Ils vont être la pierre angulaire de l’écosystème de confiance, surtout pour les systèmes à haut risque. « La technicité de l’IA va mécaniquement entrainer un besoin de montée en compétence des organismes de certification qui devront donc embaucher, former leurs personnels, et disposer des méthodes et outils d’évaluation des systèmes d’IA propres à leurs secteurs d’activité », avertit l’Association.

Le cinquième axe porte sur la normalisation d’outils dédiés, notamment tout ce qui touche à la simulation, considérée comme essentielle « pour la spécification, la conception, l’entrainement, la validation, le test, la qualification et l’audit des systèmes à base d’IA ». Si la tendance se poursuit, ces outils deviendront aussi courants que les systèmes IA eux-mêmes et doivent donc faire l’objet de normes. Ces dernières devront permettre l’essor des jeux de données synthétiques, pour s’affranchir du même coup des données réelles. Sur cette base, un système pourrait être observé de manière inédite, par exemple une ville « dans toutes les bandes spectrales optiques et électro-magnétiques, sous différents angles, avec différentes météos à différentes saisons ou heures du jour ».

Enfin, le dernier axe veut simplifier l’accès et l’utilisation… des normes elles-mêmes. L’Afnor se dit consciente de la complexité du corpus règlementaire et normatif autour de l’IA, générant des craintes – jugées légitimes – chez de nombreux acteurs.

L’Association a donc prévu de se rapprocher des acteurs de l’innovation comme Hub FranceIA et France Digitale pour travailler sur leur implication dans le processus. Elle veut également s’assurer que les normes publiées soient opérationnelles (comprendre assimilables par les acteurs concernés et taillées « pour le réel »), rédiger des guides techniques d’accompagnement et préparer dès maintenant la future génération de normes électroniques, baptisées SMART Standards.

Ces derniers doivent permettre à terme un traitement automatisé des normes, avec un objectif ambitieux : que toute personne puisse trouver directement les exigences qui l’intéressent via des filtres et outils. Ce qui nécessite que toutes les normes soient structurées de la même manière, elle-même normée. L’Afnor ne s’emballe pas pour autant : ce projet « d’ampleur va probablement prendre de nombreuses années ».

L’Association n’oublie pas certains angles morts de la stratégie actuelle de normalisation. Il n’y a ainsi rien pour l’instant sur les données, leur interopérabilité, les transactions, les formats et conventions d’annotations, leur qualité ou leur traçabilité. Rien non plus sur les algorithmes ayant trait au développement durable, alors que le Green Deal européen est très ambitieux dans ses objectifs.

Commentaires (7)

#1

??? Ils arrivent un peu en retard. La reconnaissance facial = prohibée mais c’est ce que l’on a déja dans les aéroports, dans certains stades, etc…

#2

Prohibée, et en même temps potentiellement foireuse…

En 2016 quand Anis Amri (attentat de Berlin) est passé par la France, il a traversé le champs de plusieurs caméras de surveillance. Résultat : à chaque fois on croirait voir une personne différente, il était systématiquement méconnaissable si on nous disait pas que c’était lui (alors qu’il ne cherchait pas spécialement à se cacher, il se déplacait juste)…

#3

@Vincent : en complément à ce très bon article, sur la sous-thématique certification, une première tentative ici.

Le but n’étant bien évidemment pas de faire de la publicité pour l’organisme, plutôt d’alimenter la biblio et de citer les initiatives existantes et à venir sur ce sujet qui va prendre de l’ampleur

#4

”- OK Google, balance-moi Barry White.

#5

⚠️ Le lien ne marche pas pour la feuille de route stratégique

#5.1

Je ne sais pas s’il a été corrigé, mais là il marche.

#6

Merci :)