Si les composants des serveurs ne cessent de s'améliorer et de pouvoir traiter plus de données, encore faut-il les acheminer jusqu'à eux. C'est le rôle du réseau, que NVIDIA va désormais proposer à des débits de 400 Gb/s.

Avec le rachat de Mellanox, NVIDIA a mis les deux pieds dans le monde du réseau et des interconnexions. Un choix assumé, puisque cela lui permet d'entrer dans les serveurs à travers une nouvelle porte, que ce soit via ses SoC ARM ou ses GPU qui peuvent être placés sur ces cartes réseau pour en faire des « Super Smart NIC ».

La société croit en effet dur comme fer à sa stratégie du Data Processing Unit (DPU) visant à faire de la carte réseau le nouvel élément central du serveur, gérant tant le stockage que les échanges entre le système et l'hyperviseur. C'est tout le sens du travail avec VMware au sein du projet Monterey par exemple.

Notre dossier sur la GTC Fall 2021 de NVIDIA :

- GTC 2021 : de Drive Concierge aux AI avatars, NVIDIA fait des dizaines d'annonces

- NVIDIA dévoile son Jetson AGX Orin : Ampere, 12 cœurs ARM Cortex-A78, disponible début 2022

- NVIDIA passe à 400 Gb/s : le switch Quantum-2 est là, les cartes ConnectX-7 début 2022

L'ère du 400 Gb/s commence

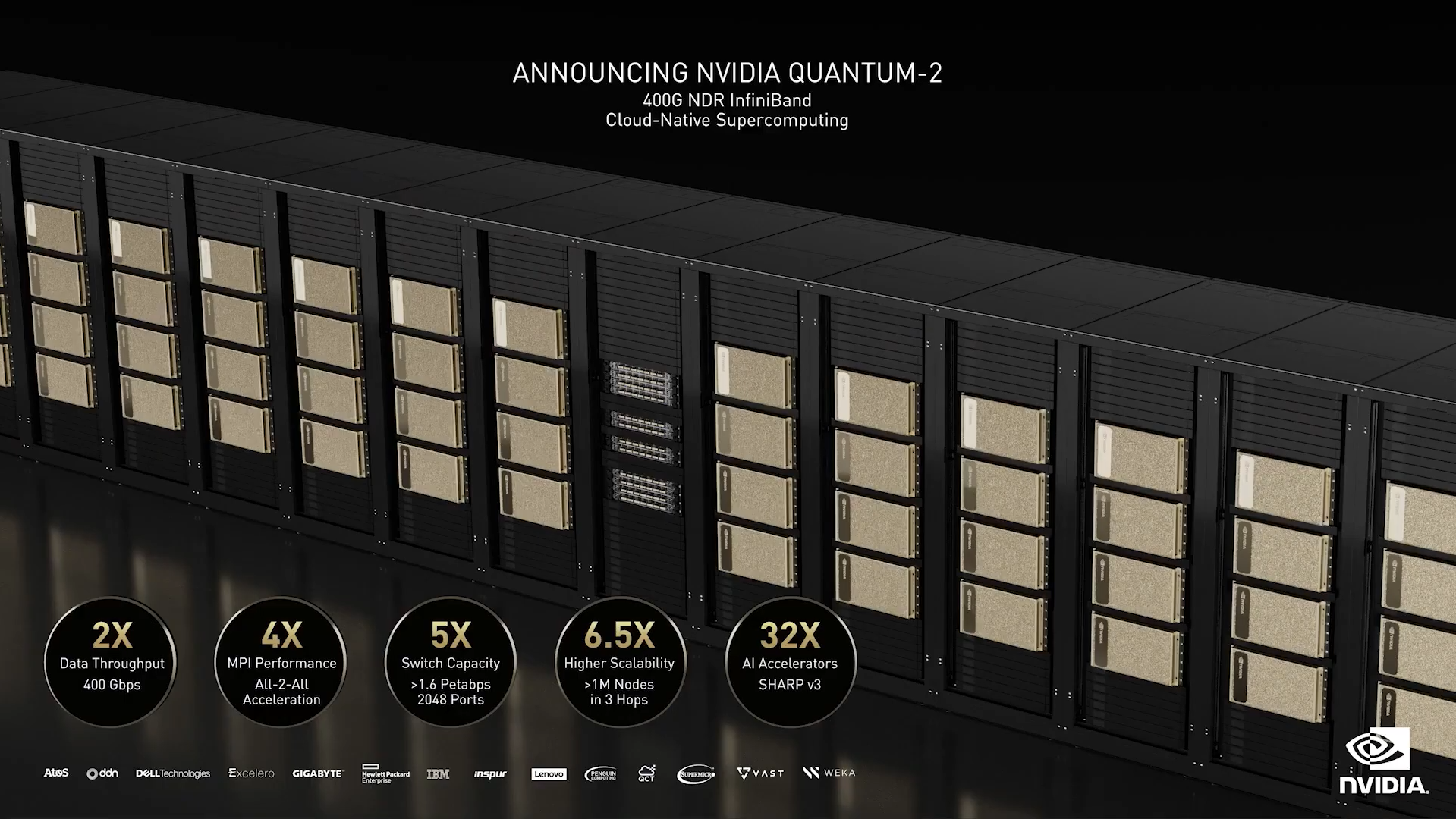

Mais le monde du réseau, c'est aussi l'évolution des débits et de la connectique, de manière plus basique. Ainsi, il y a quelques mois NVIDIA évoquait son passage à 400 Gb/s à travers ses nouveaux switchs InfiniBand Quantum-2. Les modèles QM97x0 (1U) penveut gérer 64 ports avec un débit total cumulé de 51,2 Tb/s.

Le constructeur vante l'intégration d'un composant maison, et pas des moindres : une puce de 57 milliards de transistors gravée en 7 nm. C'est plus que l'A100 rappelle NVIDIA (54 milliards).

Il est aussi question de la v3 de sa technologie SHARP (Scalable Hierarchical Aggregation and Reduction Protocol) qui décharge le CPU de certaines opérations et réduit les besoins d'échanges de données pour des usages spécifiques (MPI, Machine Learning). Quelle est l'amélioration ici ? Ce n'est pas détaillé. On sait seulement qu'on passe de 2 à 64 moteurs d'accélération. On a également droit à de la maintenance prédictive via UFM.

NVIDIA met aussi en avant sa gestion de précision à la nanoseconde pour la synchronisation des échanges ou la capacité de ses switchs à proposer de gros débits tout en isolant et répartissant la charge. « Jusqu'à maintenant, on disposait du débit ou de la gestion des flux, désormais on peut avoir les deux » a ajouté Huang.

Ces switchs embarquent aussi un Core i3 (Coffee Lake) d'Intel avec 8 Go de DDR4-2666 et 16 Go de stockage (S-ATA, M.2 2242). Leur alimentation, dont la puissance n'est pas précisée, est redondée. Les deux blocs sont échangeables à chaud. Il en est de même pour la ventilation, qui peut être assurée de l'avant vers l'arrière ou inversement.

On trouve deux ports RJ45 pour la gestion (dont un UART), un USB (I2C) et un USB 3.0. Le tout fonctionne sur MLNX-OS et peut être géré via une interface web ou en CLI, le switch étant compatible SNMP. NVIDIA précise que les 32 ports OSFP peuvent gérer 64 ports à 400 Gb/s ou 128 ports à 200 Gb/s.

Quatre déclinaisons sont proposées, managée (QM9700) ou non (QM9790) et selon le sens de la ventilation P2C/C2P (Power-to-Connector ou Connector-to-Power). Elles pourront être proposées via des systèmes modulaires CS-9500 comportant jusqu'à 32 switchs (2048 ports à 400 Gb/s). Aucun tarif n'a été annoncé.

Cartes réseau : PCIe 5.0, 400 Gb/s, débauche de transistors

NVIDIA précise que ses cartes réseau ConnectX-7, qui exploitent le PCI Express 5.0, passent elles aussi à 400 Gb/s (via Ethernet ou InfiniBand) et accompagneront ce produit. Elles embarquent pour leur part une puce de 8 milliards de transistors, gravée en 7 nm et seront disponibles à partir de janvier 2022.

La gamme de DPU BlueField 3, elle aussi en PCIe 5.0 et 400 Gb/s, mise pour sa part sur une puce de 22 milliards de transistors (7 nm), dont 16 cœurs ARM 64 bits. Elle sera disponible à compter du mois de mai.

Commentaires (15)

#1

C’est complètement fou comme matos. En même temps, les performances doivent être la…

Quand est-ce que Nextinpact test ça ??

#2

Ah Ah, celui-là c’est pas près d’arriver

#3

si le décompte des transistors inclue le cache, ça peut évidemment monter vite sans être très significatif à part niveau marketing

(illustration fictive : 64 Mo de cache par port donnerait 512 millions de transistors par port (1 transistor par bit), le tout multiplié par 64 port … on est déjà à 33 milliards de transistors)

#4

Je sais qu’on peut vite être blasé de la vie, mais même si 57 milliards d’une puce pour switch ce n’est pas 59 milliards de GPU (qui contient aussi du cache), ce n’est pas trivial à concevoir/produire pour autant, et dans tous les cas significatif côté coût et dans ce que ça permet.

#5

Moi j’attends la disponibilité. Comme d’habitude avec Mellanox, les annonces arrivent bien avant la disponibilité effective.

#6

Le switch a été annoncé il y a un moment là ils annoncent justement la dispo

#7

Ils annoncent la dispo sans prix ?

#8

Comment souvent dans le monde pro. C’est pas le genre de produit que tu achètes au détail, le marketing n’a aucun intérêt à annoncer un prix car de toute façon ça sera vendu dans des projets d’infrastructure, donc avec des ristournes à tire-larigot. Les clients ne paieront jamais le prix exact du produit.

#9

C’est quoi le marché de tel bête? Quel est sa taille?

#10

Sur un switch 64x 400G le prix c’est « contactez votre commercial Mellanox » (qui a déjà sans doute été capable de faire des quotations en avance de phase pour les clients visés par ce genre de produits)

Comme dit dans l’article c’est du format 1U. Dur de présumer qui en aura besoin ou non mais c’est surtout pour du DC et cœur de réseau été pense vu les débits. Et sûrement avec des workloads particuliers qui pourraient profiter de SHARPv3

#11

Il ne faut pas croire que ça ne vise que les gros datacenters qui vont en acheter des palettes entières.

Au boulot, on a des choses dans le genre pour de petits clusters. Là tu les achètes à l’unité, plein tarif.

#12

Je me demande quelle est la longueur max des câbles cuivre, de mémoire en HDR c’était 5m, si c’est maintenant max ~2.5m, en plus de vendre un rein pour le switch, va falloir en vendre un second pour les câbles fibre actifs

#13

Mais non je ne suis pas blasé, je m’émerveille encore de trucs comme ça : https://hardware.slashdot.org/story/21/11/13/2242240/cerebras-systems-wse-2-chip-26-trillion-transistors–850000-cores–the-fastest-ai-processor-on-earth :)

#14

C’est même disponible en cloud ;)

#15

J’achetais les switchs 10G 48 / 40G 2 / 100G * 4 moitié prix par 4, alors que je n’achetais que ça…

On arrive à avoir de bonnes ristournes quand même, même en étant une PME ^^