Si vous pensez qu'un serveur c'est un CPU, de la mémoire et du stockage plus ou moins dense, vous vous trompez. De plus en plus, la manière de connecter et de gérer des HDD/SSD évolue chez les professionnels. Les accélérateurs se multiplient, sous différentes formes. Certains essaient ainsi de se faire une place au soleil.

Dans les datacenters et serveurs, on a vu les cartes réseau prendre de plus en plus d'importance à mesure qu'elles étaient capables de prendre en charge un nombre croissant de traitements. On parle depuis lors de SmartNIC, certaines étant équipées de processeurs dédiés sous différentes formes : ASIC, FPGA, SoC Arm, etc.

- D'AWS Nitro à VMware Monterey : comment SmartNIC, DPU et IPU transforment les datacenters

- VMWare ESXi pour Arm : le projet avance, Ampere Altra 2P et Jetson Xavier de NVIDIA gérés

Mutations créatrices

Amazon Web Services (AWS) a été l'un des précurseurs en la matière. Marvell a également commencé tôt avec sa gamme Octeon qui existe depuis 2005. Mais c'est Mellanox, devenu NVIDIA Networking, qui a mis ces produits sous les feux des projecteurs ces dernières années, à travers ses Data Processing Units (DPU) et la gamme BlueField. Même Intel a récemment décidé de parler d'Infrastructure Processing Unit (IPU) pour désigner ces solutions.

De quoi générer un intérêt croissant dans une période où le secteur du stockage est entièrement en train de se repenser, des formats de HDD/SSD à la tendance à la désagrégation via des protocoles comme NVMe-oF en passant par la cohabitation avec les différentes formes de mémoire existantes ou à venir.

Même l'écosystème logiciel commencer à bouger à vitesse grand V. Premier concerné : VMware qui développe depuis quelque temps son projet Monterey pour décharger le CPU d'une partie de la charge de l'hyperviseur. D'autres comme le français Clever Cloud veulent déporter certains éléments sur de telles cartes.

De quoi faire de la place pour de nombreux acteurs innovants. Les projets et startups se sont multipliés et arrivent désormais au point où leurs produits doivent convaincre, prendre des positions et parts de marché, alors que la suite est déjà en préparation. On le voit à la multiplication des annonces ces dernières semaines.

Arm fait son retour chez Intel

Intel n'est pas franchement un petit nouveau dans le domaine du réseau ou même du SmartNIC. Il dispose déjà d'une gamme assez diversifiée avec des cartes intégrant tant des FPGA que des processeurs Xeon D pour prendre en charge divers traitements et formes d'accélération. Sans parler d'eASIC.

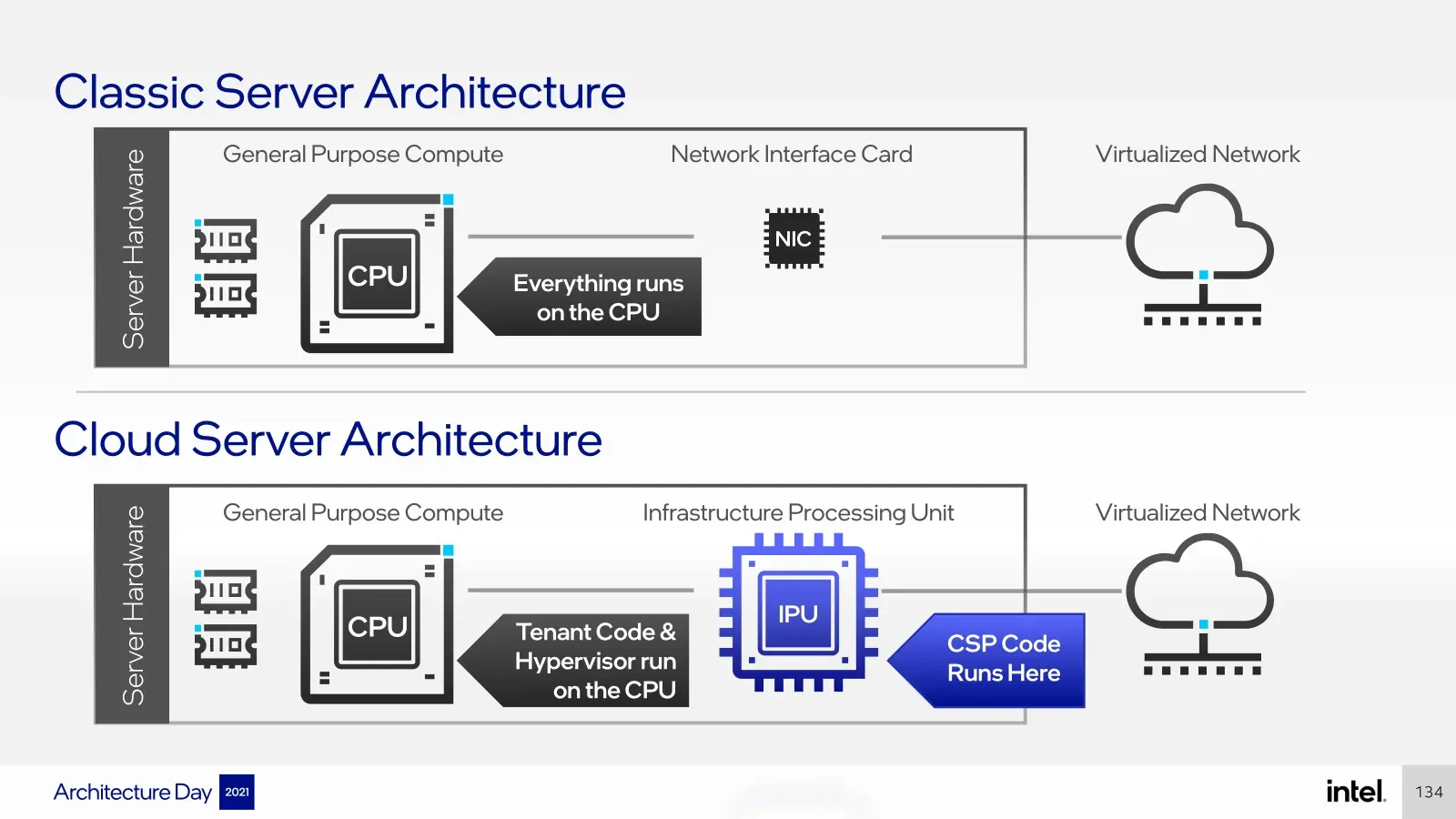

Avec ses IPU, il espère néanmoins aller plus loin. Quelle différence entre les deux ? C'est subtil :

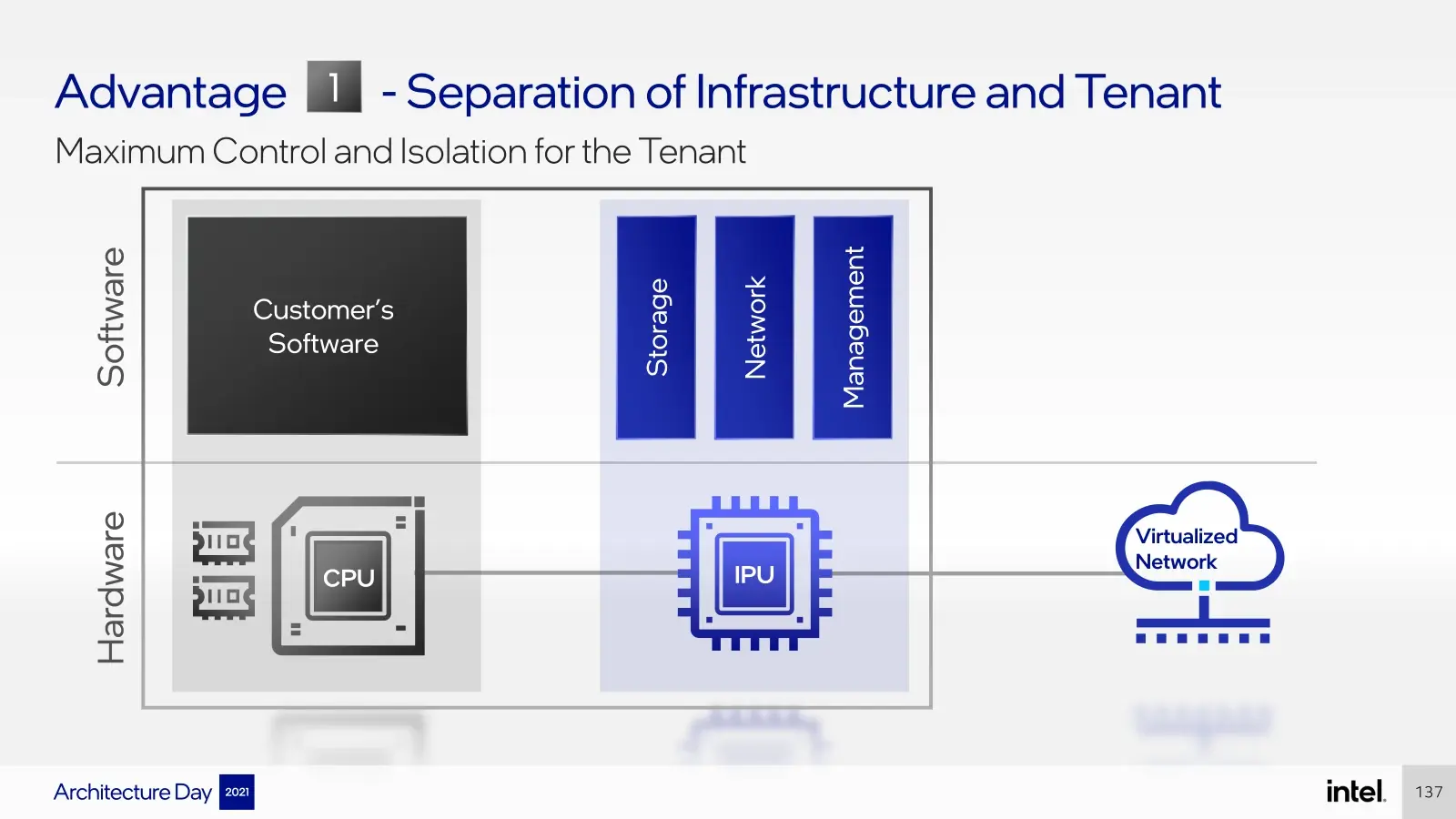

« L'IPU est capable de décharger l'hôte de l'ensemble de la pile d'infrastructure et de contrôler la manière dont il s'y attache. Le fournisseur de services dispose ainsi d'une couche supplémentaire de sécurité et de contrôle, renforcée au niveau matériel par l'IPU. Une SmartNIC possède des capacités de mise en réseau et de déchargement similaires à celles de l'IPU mais reste sous le contrôle de l'hôte en tant que périphérique. »

Car l'un des objectifs à terme de certains des acteurs de ce domaine est que l'hôte ne démarre plus sur un CPU mais directement sur leurs accélérateurs avec un OS dédié. Ces derniers disposent en effet d'une puce principale, de mémoire, sont parfois rattachés à du stockage... « la carte réseau est la nouvelle carte mère » en quelque sorte.

C'est en partie le sens du travail de VMware autour de Monterey, mais bien d'autres initiatives prennent la même direction. Pour les fournisseurs de services cloud (CSP), cela peut avoir un avantage de taille : libérer des cœurs CPU pour les machines virtuelles (VM) de leur client, le tout avec du matériel dédié à des usages précis.

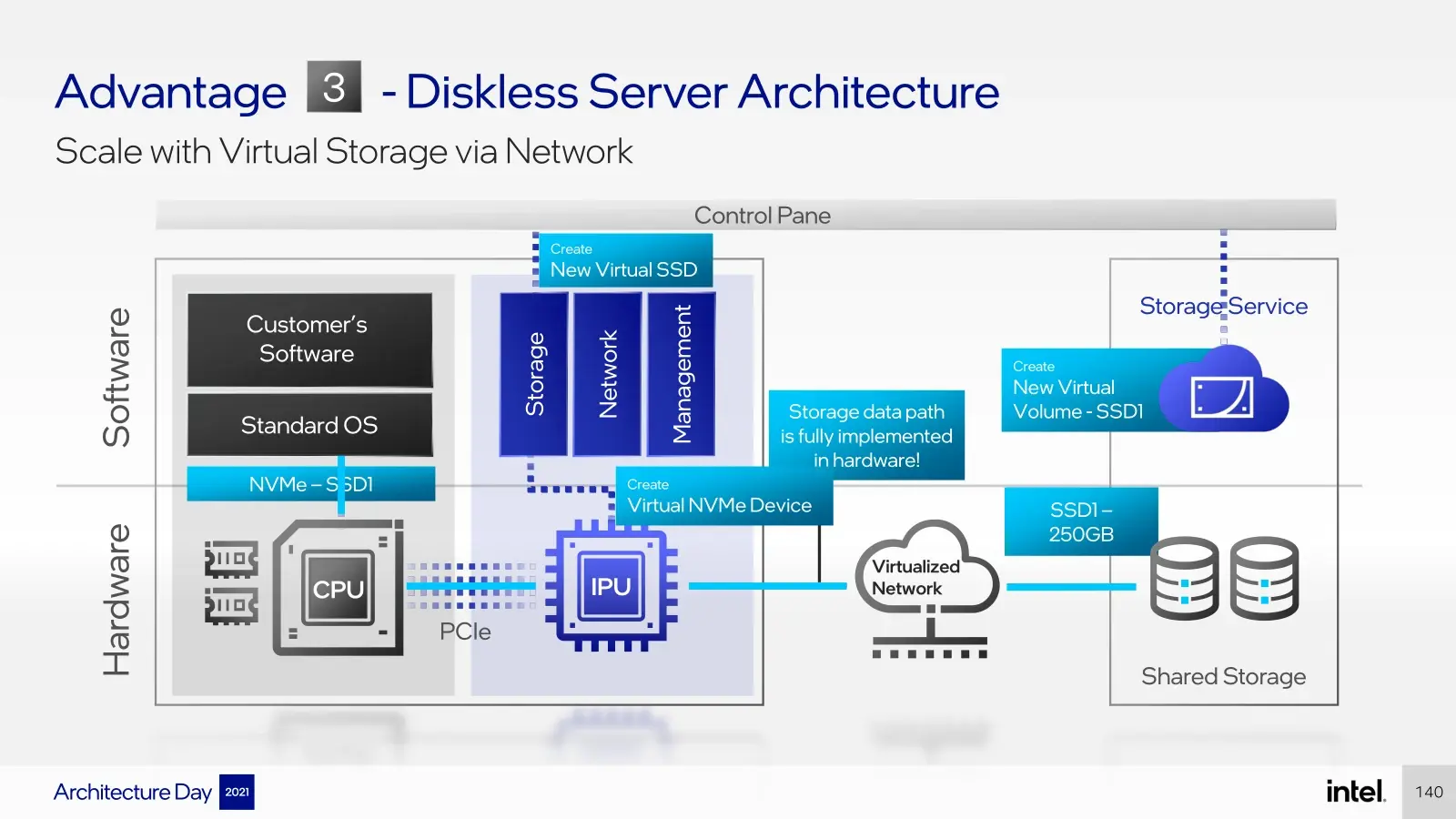

À l'occasion de son Architecture Day 2021, Intel est revenu sur la manière dont il perçoit les transitions en cours et la place que pourrait être celle des IPU dans des infrastructures sans disques locaux. Mais pour le moment, comme tous les acteurs de ce marché, il attend de voir où la « mayonnaise va prendre » et multiplie les produits d'ici là.

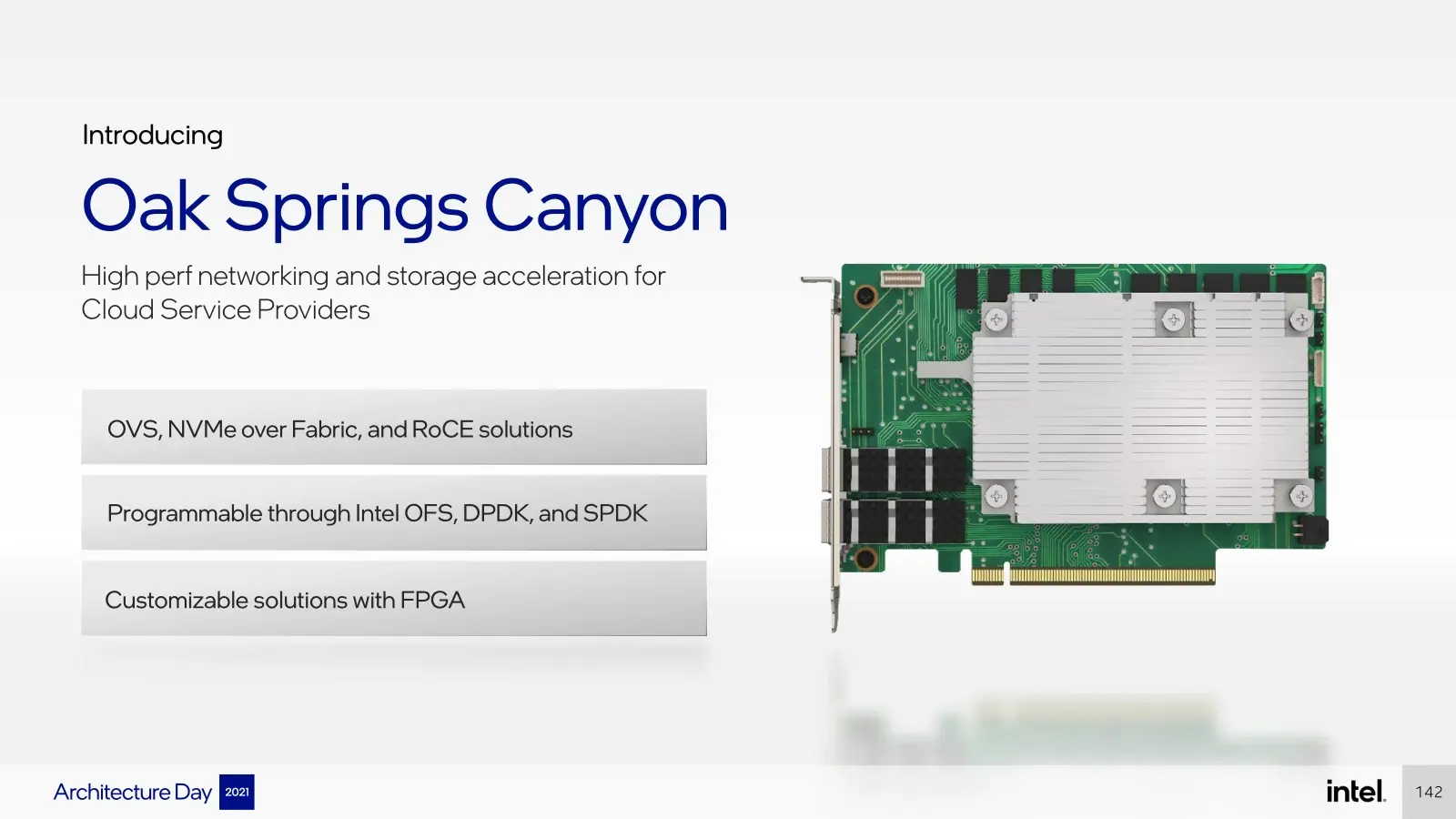

Il a ainsi dévoilé Oak Springs Canyon et Arrow Creek, deux cartes au format PCIe 4.0 x16. La première se focalise sur le stockage avec 2x 100 Gb/s (QSFP28/56), une gestion de NVMe-of, RoCE, DPDK, SPDK, etc. Elle embarque un FPGA Agilex et un Xeon-D, chacun étant accompagné de 16 Go de DDR4. La seconde vise plutôt le monde du réseau avec son contrôleur Intel E810 (2x 100 Gb/s, QSFP 28/56), du precision clocking et des FPGA Agilex et Max 10.

Mais son grand projet du moment est Mount Evans, un IPU maison comportant 16 cœurs Arm N1, trois canaux de LPDDR4, 200 Go/s pour le réseau des accélérateurs de chiffrement et compression de données, pour le traitement NVMe (avec gestion de RoCE v2), IPSec, capable de gérer des hôtes dotés d'un maximum de 4 processeurs Xeon.

Une solution créée en collaboration avec un fournisseur de services cloud, qui exploitera tant les solutions open source SPDK et DPDK que P4 Studio issu du rachat de Barefoot Networks.

Kalray : le français qui mise sur manycore

En France, un acteur se démarque sur ce marché : le Grenoblois Kalray (Montbonnot-Saint-Martin plus exactement). Créée en 2008, il s'agit d'une société cotée en bourse, valorisée à un peu moins de 200 millions d'euros. Elle conçoit un processeur dit « manycore », qui en est actuellement à sa 3e génération avec Coolidge (MPPA3).

Au départ, ses solutions étaient très utilisées dans le domaine de l'IA et de l'automobile, avec des investisseurs comme Safran, Renault-Nissan-Mitsubishi ou NXP, mais l'entreprise se cherche d'autres débouchés. Depuis 2018 elle dispose d'une certification de la NVMe Express Association et mise depuis sur le stockage pour s'étendre.

Sa dernière puce est gravée en 16 nm chez TSMC il dispose de 5x 16 cœurs maison (64 bits-VLIW), d'un contrôleur réseau 8x 25 Gb/s et d'une interface PCIe 4.0 x16. Le tout est présenté comme facilement programmable, avec notamment un SDK AccessCore basé sur l'outil open source SPDK. Le système est indépendant, ne nécessitant pas de CPU pour fonctionner puisqu'une distribution Linux maison est exécutée sur une portion des cœurs.

Ce DPU est commercialisé sous la forme d'une carte low profile (K200-LP) 2x 100 Gb/s (QFSP28) à utiliser au sein de serveurs de votre choix, mais aussi de solutions plus clé en main comme la Flashbox annoncée récemment avec Viking. L'ensemble annonce jusqu'à 12 MIOPS avec 6 cartes (deux nœuds de 3), jusqu'à 2x 12 SSD PCIe (NVMe), une latence de 30/50 µs et une consommation de 30 watts par carte. NVMe-oF est bien entendu géré, dont NVMe/TCP.

Kalray travaille également avec des Français comme Clever Cloud, Vates ou Scaleway à des implémentations de sa technologie, même si pour le moment rien n'a réellement été concrétisé. C'est d'ailleurs tout l'enjeu de son avenir. Nous aurons d'ailleurs l'occasion d'y revenir plus en détail à l'occasion d'un article dans notre magazine #3.

Fungible : MIPS64 au programme

Fin septembre, l'américain Fungible (créé en 2015 par d'anciens d'Apple/Juniper) annonçait son Storage Initiator (SI) pour faciliter l'accès à NVMe/TCP, qui a de plus en plus d'adeptes dans le secteur.

Ce constructeur propose un DPU F1 doté de 52 cœurs MIPS64 (Release 6) gérant jusqu'à 8x 100 Gb/s, de l'offload TCP/RDMA, 32 lignes PCIe 4.0 (ou 64 PCIe 3.0), pouvant être virtualisée (SR-IOV), jusqu'à 512 Go de DDR4, 8 Go de HBM et une consommation de pas moins de 120 watts cette fois.

Une version 2x 100 Gb/s (35-50 watts) existe également avec des caractéristiques plus « légères », comme le nombre de cœurs MIPS64 R6 qui tombe à 16 et 32 lignes PCIe 3.0/4.0. Ce S1 est commercialisé au sein de cartes PCIe x16 : les FC50, FC100 et FC200 (selon le niveau de débit réseau supporté).

Le F1 est pour sa part intégré au Fungible Storage Cluster (FSC) FS1600 qui promet 12 MIOPS et 60 Go/s via 24 SSD PCIe (NVMe) et une latence ajoutée (et non totale) de 10 µs.

GRAID : une accélération matérielle via... un GPU NVIDIA

Avec sa carte SupremeRAID, GRAID opte pour une attitude différente. Plus jeune, l'entreprise taiwanaise n'a pas conçu une puce mais utilisé une puce graphique de NVIDIA pour exploiter ses capacités de calcul et d'IA avec une couche logicielle maison pour en faire un contrôleur RAID pour SSD PCIe (NVMe) locaux ou non. Elle dit être capable de gérer jusqu'à 6 MIOPS et 10 Go/s par carte, mais ne prend cette fois pas en charge le réseau.

Elle a néanmoins convaincu de grands noms du secteur de travailler avec elle, comme Kioxia ou Seagate, mais aussi Gigabyte qui vient d'annoncer proposer un nouveau serveur R282-Z9G qui intègre la carte et jusqu'à 20 SSD CM6 de Kioxia, avec jusqu'à deux processeurs EPYC 7003. De quoi fournir jusqu'à 91 Go/s en lecture séquentielle et 7 Go en écriture avec du RAID 5. En RAID 10 on peut atteindre respectivement 104 Go/s et 30 Go/s promet Gigabyte.

Cet été l'entreprise disait viser 3 millions de dollars de revenus en 2021, trois fois plus en 2022 et pas moins de 672 millions de dollars d'ici 5 ans. Des prévisions qui impliquent là aussi que des clients soient progressivement convaincus.

Commentaires (6)

#1

“dans le serveur, la guerre du stockage fait rage”

Ce n’est pas pour rien qu’en anglais on appel ça “storage” ;)

#2

C’est pas gentil de spoiler mes jeux de mot

#3

Ces évolutions sont intéressantes d’un point de vue technique mais quid de la sécurité de l’ensemble ?

J’entends par la que la volonté étant clairement de remplacer l’OS pour un grands nombre d’algorithmes, n’y a t-il pas une fenêtre grande ouverte à tout type de portes dérobées (Chinoises, Israéliennes, NSA[CloudBackup]…) intégrées directement dans le matériel/micrologiciel embarqué en lieu et place de logiciels sous GPL ?

Ce point est-il un sujet d’inquiétude dans l’industrie ou le bénéfice financier qui en découle suffit à relayer ces considérations au rang d’élucubration de geek (cf contrat Open bar MS/armée) ?

#4

C’est toujours un Linux qui tourne ou un système complet à la VMware, je ne vois pas le rapport avec des algorithmes ici ? Pour les portes dérobées, le risque est le même que pour n’importe quel switch non ?

#5

Si tu fais du stockage réseau pour VMware, typiquement, ce sera sur un réseau isolé. La surface d’attaque est donc limitée.

Saches que, de toutes façons, avec les menaces de cryptolockers, les stockages sont devenus cruciaux et sont loins d’être une affabulation de geek: la direction écoute normalement relativement bien.

#6

Par algorithme, j’entendais l’accélération matérielle des DPU (les calculs sont effectués par eux et non le CPU/OS si je suis bien). Si ces derniers ont de plus en plus “d’intelligence” (SmartNIC) avec un système intégré, ils peuvent, à priori, aussi apporter une plus grande surface d’attaque (volontaire ou non) et ce, sans qu’un quelconque logiciel de sécurité exécuté sur le serveur n’y puisse rien.

Tout à fait, ça ne fait que multiplier le risque encore un peu plus.

Dans ce cas oui. J’imagine qu’avec un accès à d’autres machines pas forcément sous contrôles c’est plus compliqué.