Après avoir été longtemps mis de côté, NVMe/TCP semble peu à peu gagner ses lettres de noblesse. Le protocole est désormais adoubé par le duo Dell EMC/VMware qui veut le développer au sein de sa gamme de produits mais aussi à travers un écosystème. Ils s'associent d'ailleurs à Intel et Lightbits Labs.

Alors que VMWorld 2021 approche à grands pas, VMWare et son « partenaire » Dell EMC, viennent de déclarer leur amour commun à NVMe/TCP. Il s'agit pour rappel de l'un des standards de NVMe-over-Fabrics qui a l'avantage de ne nécessiter aucun matériel spécifique : les commandes NVMe sont encapsulées dans un flux TCP/IP classique.

- NVMe-over-Fabrics (NVMe-oF) : partagez vos SSD NVMe sur le réseau

- NVMe/TCP : partagez vos SSD depuis Ubuntu Server, notre script pour vous y aider

Dell EMC dit avoir fait de choix initial parce que NVMe/TCP « offre un niveau de performance similaire à NVMe/FC (Fibre Channel), avec la possibilité d'atteindre de bien plus gros débits pour un tarif beaucoup plus modéré ». Tout en affichant des résultats bien plus élevés que le classique iSCSI qui n'est pas adapté aux SSD PCIe (NVMe).

De bonnes performances, une intégration aux petits oignons

Selon les chiffres avancés par le constructeur, NVMe/TCP offre un nombre d'IOPS 2,5 à 3,5 fois plus élevé avec une latence réduite de 70 à 75 %. L'utilisation CPU serait aussi moindre à mêmes performances (-40/50 %). Mais nous n'aurons pas de chiffres bruts pour apprécier ces données et les comparer à d'autres solutions.

Dell EMC a donc développé une offre NVMe IP SAN qui sera disponible à compter du 18 novembre prochain. Elle sera tout d'abord disponible via ses serveurs PowerStore, les gammes PowerMax et PowerFlex suivront, même si aucune date n'a pour le moment été donnée. La société dit d'ailleurs avoir développé tout un écosystème autour de cette solution, dont son Smart Fabric Storage Software (SFSS) qui doit centraliser la gestion des hôtes et targets NVMe/TCP.

Il doit répondre à ce qui a été identifié par la société comme l'un des plus gros points bloquants lorsqu'il faut gérer une infrastructure complète : savoir quelles machines partagent quoi, qui peut y accéder, etc. En effet, l'outillage NVMe/TCP est encore relativement primaire et nécessite pour le moment d'être largement complétée.

L'idée est ainsi de proposer une équivalence aux fonctionnalités actuellement accessibles via Fibre Channel. Bonne nouvelle, l'américain semble décidé à avoir une approche ouverte sur le sujet puisqu'il dit vouloir faciliter l'émergence d'une communauté sur GitHub autour de ce projet, pour mettre à disposition une documentation pour l'API REST de SFSS, des outils et scripts utiles aux développeurs et pourquoi pas une version « lite » de SFSS.

Dell EMC est d'ailleurs mainteneur du projet open source nvme-stas qui sera en charge de gérer la découverte au sein de différentes distributions Linux. Il sera rendu disponible d'ici la fin de l'année. Dernière bonne nouvelle : la société dit travailler avec plusieurs autres constructeurs à la gestion du boot depuis une target NVMe/TCP.

VMWare suit, vSphere mis à jour, Lightbits Labs certifié

De son côté, VMWare vient d'annoncer vSphere 7 Update 3 avec des améliorations pour la gestion de la mémoire persistante, des vGPU via Kubernetes, ou un nouveau plug-in pour NSX. Mais là aussi l'une des grandes nouveautés est le support de NVMe/TCP. Tout comme Dell EMC, l'entreprise vante ses performances et sa flexibilité.

Elle indique également voir un intérêt dans l'utilisation d'un protocole robuste et connu comme TCP (même si certains attendent avec impatience l'émergence de NVMe/QUIC). Pour elle, le soutien de ce standard par plusieurs acteurs importants du marché, qui permet son développement continu, est aussi un facteur clé.

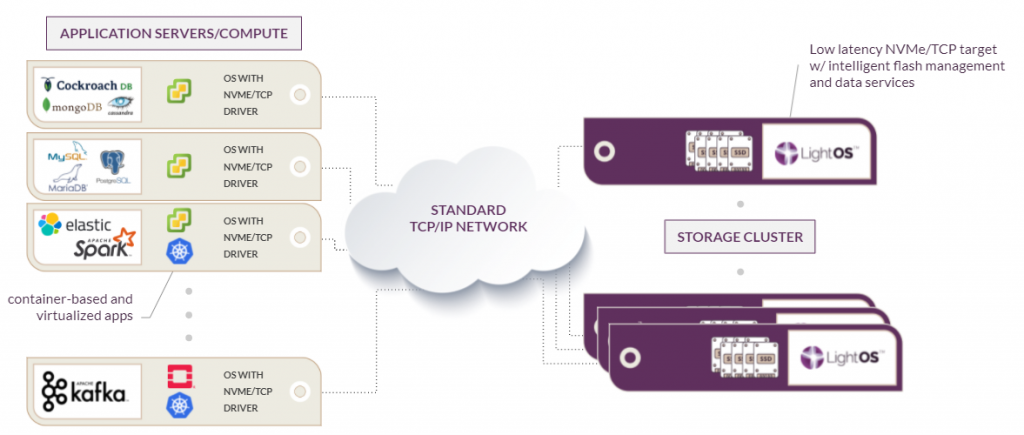

On pense notamment à Intel, qui est un acteur important de l'écosystème open source dans le domaine du réseau et du stockage (notamment avec SPDK et DPDK), qui travaille au support des différents protocoles NVMe-oF, dont NVMe/TCP ces dernières années. VMware dit d'ailleurs travailler avec l'entreprise et Lightbits Labs, dont le LightOS est désormais une solution certifiée Day 0 software-defined storage pour VMware vSphere 7 Update 3.

Elle est pour rappel optimisé pour les processeurs Xeon d'Intel et ses cartes réseau de la série 800, qui profitent tous deux d'accélérations diverses pour la gestion du NVMe-oF. L'ensemble est donc recommandé pour le stockage « désagrégé » en complément de serveurs prenant en charge tout ce qui touche au traitement des données.

Commentaires (10)

#1

C’est la raison de cette suite d’article ou c’est une coïncidence ?

#2

Je ne savais pas que ces annoncés arrivaient. Après peut être qu’ils l’ont décidé suite aux articles, on sait pas (en vrai ça fait un moment que je travaille sur le sujet mais ça s’est débloqué cet été avec l’arrivé du switch 25G et mon travail sur les scripts NVMe/TCP)

(en vrai ça fait un moment que je travaille sur le sujet mais ça s’est débloqué cet été avec l’arrivé du switch 25G et mon travail sur les scripts NVMe/TCP)

#3

C’est encore trop tôt pour parler de nvme2 sur pcie5 ? Ou est-ce justement une preparation à l’utilisation future via des solutions concrètes ?

#4

Le PCIe 5.0 c’est plutôt fin d’année voir début 2022

#5

Quel est le réel avantage pour un datacenter ?

Pouvoir mettre le stockage dans une zone plus froide qu’au coeur des serveurs déjà bien chaud à cause des CPU et GPU ? Ou il y a d’autres raisons ?

#6

Ca permet de decoupler le stockage du compute (cpu/ram). On peut alors déplacer à volonté des applicatifs (VM, conteneurs, paas, …) non plus d’un processeur à un autres, mais carrémment d’un serveur à un autre, quasi instantanément, car les données peuvent suivrent en détachant simplemement le stockage correspondant du serveur source au serveur destination.

#7

Il n’ a pas de règle générale, ça dépend des besoins. Mais rien qu’un hébergeur utilise ce genre de solution pour ses offres de bloc storage par exemple (en iSCSI ou via des solutions spécifiques comme en Ceph/RADOS). C’est aussi assez courant de voir des VM avec des “datastores” externalisés, jusqu’à maintenant surtout via iSCSI ou des protocoles fichiers comme NFS.

Ce que tu vois apparaître aussi ce sont des baies avec du matos spécialisée dans les accélérations liées au réseau/stockage, qui ne sont pas forcément les mêmes que dans une baie “compute”. Reste la question du débit réseau, parce qu’un SSD actuellement ça sait faire du 4⁄8 Go/s tout seul en lecture séquentielle, donc 32⁄64 Gb/s. Un seul suffit à saturer un seul lien 40G.

Mais en pratique ce n’est pas toujours de gros accès séquentiels et de toutes façons ça peut être une bonne solution pour compléter du stockage local forcément limité physiquement. Potentiellement une machine peut monter l’espace de stockage de plusieurs baies externes, elles ne pourrait pas les accueillir. Et c’est tout le principe du réseau que d’ouvrir de tels accès.

Ici par exemple j’ai en général un SSD local et potentiellement un HDD dans la machine. Pour le reste je monte des périphériques sur le réseau selon les besoins (NVMe/TCP ou iSCSI).

#8

Et bien en faite ça correspond assez bien a une évolution d’une architecture en cluster avec une baie SAN.

Par exemple, il existe chez HPE des baie 2U pas trop cher genre MSA qui permette de gérer tout le stockage a un seul endroit sur laquelle tu peux venir greffer jusqu’à 4 serveurs. Donc plutôt que d’avoir 4 fois le même stockage qu’il faudrait en plus synchroniser en temps réel, là t’as juste une baie de 24 slot 2.5”. Les systèmes de fichier des hyperviseurs permettent justement aux hôtes d’accéder a un espace de stockage simultanément. C’est ce qu’on appel un système convergé, le calcul et le stockage séparé. Si un hôte crame, bas osef, ça redémarre ou ça s’arrête tout simplement pas si t’as de la FT (Fault tolérence chez VMWare).

Sauf que voilà, le SAS ou le FC sur de plus gros modèle ça coute cher et c’est pas hyper optimisé pour le flash. La par ex on pourrait s’affranchir du SAS ou du FC et avoir quelques chose d’un peu plus optimisé.

Bon c’est comme ça que je vois les choses… c’est peu être pas le meilleur cas.

Par contre ce qui me pose question c’est les cartes contrôleurs. Comment ça va marcher ? les E1.S seront branché comment et sur quoi ? un DPU ? va y avoir la possibilité de faire du RAID ? comment ça se passe le RAID hardware et le NVMe d’ailleurs ?

#9

La question méritait d’être posée, ça peut être un communiqué de presse sous NDA qui t’as donné envie de faire quelques articles introductif

Donc merci pour la réponse, et a Myrddinlefou pour la question

#10

Oui pas de souci je comprends tout à fait. Mais pour être honnête, quand ça se fait suite à des échanges avec un constructeur en particulier, ce qui peut arriver, on le dit clairement.

Mais j’ai une curiosité assez naturelle pour les sujets tordus avec lesquels je saoule une partie de l’écosystème Parfois ça aboutit juste au bon moment

Parfois ça aboutit juste au bon moment