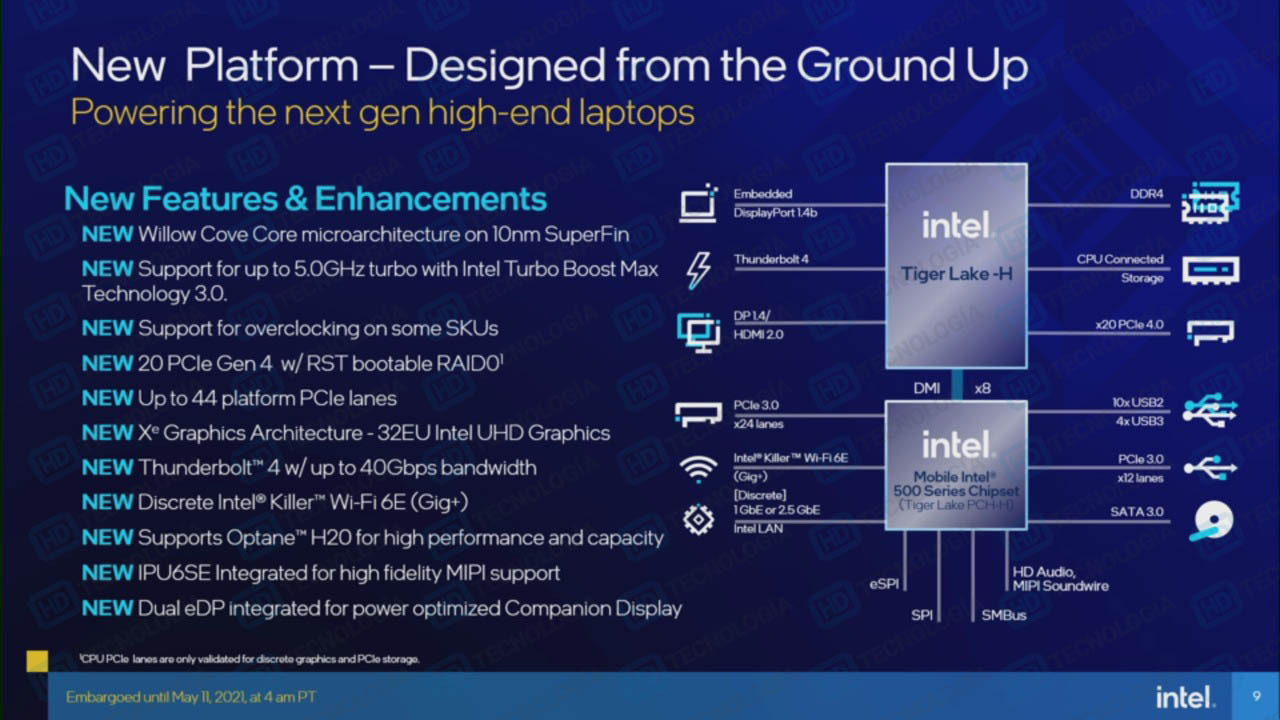

Intel va passer la seconde dans le domaine des processeurs pour PC portables, dévoilant la version haut de gamme de Tiger Lake la semaine prochaine, avec des TDP de 35/65 watts. Mais la présentation du constructeur a été dévoilée par HD Tecnología, ce qui nous permet de savoir en détail à quoi s'attendre.

Depuis qu'ASUS a vendu la mèche, on sait que le lancement des prochains processeurs mobiles haut de gamme d'Intel, nom de code Tiger Lake-H, doit se faire le 11 mai prochain. L'idée est pour le constructeur de sortir cette génération des seuls ultra-portables et de les adapter à des machines plus abordables, visant les joueurs, etc.

Mais aussi d'éviter qu'AMD soit seule à occuper le terrain avec ses Ryzen Mobile 5000, exploitant les architectures Zen 2 et Zen 3. Pour cela, cinq nouvelles puces vont être mises sur le marché, avec 6 ou 8 cœurs selon les cas. Une solution attendue depuis les premières annonces concernant Tiger Lake, sur laquelle Intel était resté assez discret.

Le détail des Core i5-11260H, i5-11400H, i7-11800H, i9-11900H et i9-11980HK - Crédits : HD Tecnologia

Côté TDP, il est question de 35 watts pour l'ensemble des références, sauf le Core i9-11980HK, complètement débridé et pouvant atteindre 5 GHz. Il peut ainsi grimper à 65 watts et s'intègrera donc à des châssis plus costauds. Pour rappel, ces puces sont bien gravées en 10 nm SuperFin, avec une architecture Willow Cove, contrairement aux Core de 11e génération pour PC de bureau (Rocket Lake-S, Cypress Cove, 14 nm).

Ils partagent néanmoins un même choix technique : afin de laisser plus de place aux coeurs CPU, le GPU est limité à 32 unités d'exécution (EU), contre 96 pour Tiger Lake-U.

- Tiger Lake : Intel détaille l'architecture Xe, Willow Cove et certaines nouveautés

- Rocket Lake-S : les processeurs Core de 11e génération en précommande, dès 190 euros

20 lignes PCIe 4.0 sont exploitables par le CPU, avec RAID 0 bootable pour des SSD NVMe. On retrouve le Thunderbolt 4, les DP 1.4 et HDMI 2.0b. Le lien avec le chipset (série 500 mobile) est de type DMI x8. Ces puces ajoutent jusqu'à 24 lignes PCIe 3.0, 10 USB 2.0, 4 USB 3.x, une intégration aisée du réseau à 2,5 Gb/s et du Wi-Fi 6E (Killer AX1675).

Intel vante l'arrivée de PC portables avec des dalles jusqu'à 360 Hz (1080p) ou 120 Hz (4K), l'intégration des dernières puces graphiques tierces (ses propres GPU Xe indépendants n'étant pas encore finalisés) et le support de l'API Direct Storage de Microsoft qui doit faciliter le traitement des données directement par le GPU sous Windows.

On espère que ces puces arriveront également rapidement dans des Mini PC et autres solutions compactes, leur TDP étant parfaitement adaptés à de tels usages. Il faudra sans doute attendre la semaine prochaine pour le découvrir.

Commentaires (28)

#1

Le tableau liste de nouveau CPU tels que le i7-11800H 45W, mais pourtant il y a déjà des Tigerlake-H 35W de sorti tel que le i7-11370H ou i7-11375H déjà commercialisé dans certain modèle (exemple : Dell Nouveau Inspiron 14)

Comment se positionne les tigerlake-H 45W vs tigerlake-H 35W vs les tigerlake-U basse conso?

Ca aurait été intéressant d’avoir un tableau comparatif dans ce style : https://technical.city/fr/cpu/Core-i7-11370H-vs-Core-i7-11800H

#2

Ce sont des modèles à quatre cœurs dont tu parles (ils ont été annoncés au CES). Ceux annoncés la semaine prochaine seront en 6⁄8 cœurs comme indiqué dans l’article. Pour les comparatifs, tu auras tout sur ARK une fois que les CPU seront officialisés.

#3

J’ai un peu de mal à voir l’intérêt d’un processeur mobile à 65W de TDP c’est juste énorme ! et le prix risque de l’être aussi vu le peu de performance en plus que ça risque de donner

Le 4K pour PC portable est juste marketing, Aucun intérêt pour ma part vu la résolution élevée sur un petit écran…

#4

Il faudra voir les designs qui seront annoncés. Le souci du CPU à 65 watts c’est surtout qu’avec un gros GPU ça peut vite coincer. Ce sera intéressant de voir les choix des constructeurs en la matière.

#5

C’est comme une génération un peu sacrifié la génération 11 au vu de sa durée de vie. Ca me rappel la génération Broadwell qui a durer peu longtemps parce que Skylake est venu rapidement.

Après la différence, il y a plus de marketing que Broadwell en a eu.

J’espère que Intel rattrapera le coup avec sa génération Alder Lake, ça fera du bien à tout le monde la concurrence dans son milieu. Surtout avec ARM qui pointe son nez.

#6

A court/moyen terme, je ne pense pas que l’architecture ARM présente un grand danger. Déjà parce qu’en dehors du M1 d’Apple, les performances sont trop faibles pour prétendre à se comparer frontalement aux solutions x86.

Ensuite parce que le parc applicatif n’est pas prêt (au sens porté) pour du ARM.

Le réel combat actuel est (de mon point de vue) entre Intel et AMD.

#7

A 4K on est à la limite physiologique humaine, il n’y a que 4 millions de capteurs couleur dans un œil. Donc quand on utilise un écran on doit être à 2K car on n’est pas immergé dans l’écran !

#8

C’est évidemment bien plus complexe que ça.

La question finale étant quelle utilité on trouve à une finesse d’affichage permettant de ne plus percevoir les pixels (associé au la taille de la dalle et à la distance de l’écran).

Perso, j’ai un 32” en QHD. Un des intérêts d’une telle taille est de ne pouvoir me passer du port de mes lunettes (myopie moyenne+astigmatisme léger) quand je bosse sur mon écran (8h par jour pour le taf + le temps perso). Je suis à environ 70cm de mon écran.

Malgré ça, je n’aurais rien contre une résolution de 6k voire 8K pour avoir la même finesse d’affichage que je retrouve sur mon macbook (écran retina) ou ma surface pro (équivalence retina).

#9

Plus a long terme en vrai, pour l’instant c’est seulement Apple, mais on commence à avoir une montée en force d’ARM sur les PC portables.

Selon moi il n’existe aucune supériorité d’ARM face à X86, si Intel n’avais pas eu de monopole, je pense que Apple n’aurai jamais passé à ARM et que nos CPU X86 serait bien plus puissant qu’aujourd’hui.

#10

La supériorité du ARM M1 sur le x86 concernant les machines mobiles ou avec des contraintes thermiques/consommation (comme le mac mini) me semble assez évidente.

La question à mon sens est de savoir si Apple va réitérer son coup de force avec les machines qui n’ont pas ces contraintes, et qui vont affronter de manière directe les gammes x86 desktop axes perf. Si c’est le cas, Apple va devenir un nouveau fondeur majeur.

Mais si on exclut Apple de l’équation, Qualcomm ne semble pas pour le moment en mesure de fournir une solution qui puisse rivaliser de près ou de loin avec le monde x86 actuel.

Quant au monopole d’Intel pendant quasiment une décennie, oui, il semble clair que ça a été particulièrement néfaste.

#11

Pour tous ceux qui utilisent Linux (à titre pro ou perso), le portage n’est pas un souci et si ARM se met à occuper la niche de la performance (déjà qu’ils sont les plus forts sur la performance/watt), ça va être vite adopté.

Ça me fait toujours sourire ce genre de propos, comme si continuer à faire progresser la puissance des processeurs était trivial et qu’Intel n’avait pas essayé… Ils bossent énormément la question, sinon ils vont se faire balayer, et c’est le cas depuis… presque toujours. Là on sait qu’ils ont des soucis de gravure depuis quelques années.

#12

Avec un problème de myopie comme j’ ai, les capacités de pointage précis sur une zone augmentent du genre facilité à enfiler un fil dans le chas d’ une aiguille par rapport à une personne ne souffrant pas de myopie.

Donc on perçoit mieux les différences de granularité et la moindre pixellisation.

D’ autre part le cerveau a des capacités élastiques aptes à se développer si elles sont stimulées qui font que chaque personnalité développe ou pas dans son jeune âge un domaine bien particulier pour une intelligence bien particulière.

Tout est affaire de circonstances dans le vécu parental qui influe frocément sur les dispositions filiales.

Ce ne sont pas les mêmes capacités qui sont nécessaires pour un musicien que pour un photographe ou un peintre et quans ces capacités ont pu etre exercées dès le jeune ou très jeune âge, ledit photographe aura des qualités dans le domaine dont ne jouira pas un autre.

Le principe de la vie consiste à s’ adapter mais ce n’ est pas avec de vieux croutons qu’ on peut créer des oeuvres d’ art et ce qu’ on imagine impossible pour certains se vérifient comme faux pour d’ autres.

#13

Pour être franc, j’avais exclu Linux de l’équation, pour la simple raison que dans le monde pro, je doute que l’on passe avant (à minima) 5 à 10 ans sur de l’archi ARM, vu que l’on parle d’une utilisation (il me semble) globalement serveur, qui font eux même tourner des applicatifs servers en x86.

Et je n’ai pas l’impression que Linux arrive à s’imposer en quoique ce soit sur la partie desktop, dans le pro comme chez le particulier. Mais je me goure peut être ?

Même si c’est le cas, il faudra tout de même que les applis utilisées en desktop soit portées sur ARM. Dans le cas d’apple et de son écosystème plus restreint et maîtrisé, il subsiste malgré rosetta 2 encore pas mal d’incompatibilités partielles et totales.

Ce n’est évidemment pas trivial, mais le fait est qu’Intel s’est endormi sur ses lauriers pendant sa trop longue phase de monopole, et a enchaîné les décisions foireuses, et notamment les projets tués dans l’œuf parce que le développement n’allait pas assez vite selon le CEO de l’époque.

Et même si la situation ne peut pas être si simplement résumée, c’est majoritairement la faute d’Intel si AMD à pu ressurgir de la sorte, et également une erreur considérable d’Intel de ne pas avoir planché sur le renouveau de l’architecture actuelle dont la base remonte tout de même au centrino de 2003 (lui même basé sur le P3).

Sans même parler de l’incroyable hold up d’une décennie ou on nous a vendu des CPU avec 10% de perf de plus annuellement, quand on avait du bol.

Un gros dossier de CPC hardware d’il y a 2⁄3 ans avait listé toutes les erreurs du CEO, la fuite des cerveaux , etc. Ils avaient prédit qu’Intel payerait le prix de sa gestion calamiteuse, et partirait dans le rouge, à voir s’ils ont vu juste ou non.

Quelque part, je me réjouis à titre personnel de l’enlisement d’Intel, car AMD n’aurait sans doute pas pu revenir dans la course, et le monopole n’est jamais bon en quoi que ce soit.

#14

Je le répète, mais autant les portages ont souvent été difficiles dans le monde Windows (et peu fréquents, on a eu vers le DEC Alpha à une époque pour Windows NT, et là on a du portage vers de l’ARM qui existe), autant côté Linux c’est pas tellement un problème, au mieux c’est une simple recompilation, au pire il y a un peu d’adaptation mais c’est pas réellement une énorme tâche.

La plupart des applications serveurs tournent sous Linux je le rappelle, et beaucoup sont en Open Source donc recompilables (dans les datacenters et le monde “Cloud” c’est assez clair et ça ne date pas d’hier).

C’est pourquoi si ARM fournit à prix compétitif des serveurs ARM ça va bien se vendre ; dans mes connaissances hébergeurs il y en a qui espèrent dans ce domaine (et qui ont déjà essayé par le passé pour des serveurs de puissance moyenne).

Je n’ai pas parlé du desktop.

J’aimerais avoir des éléments un peu plus concrets comme quoi Intel se serait endormi. Pas sûr que leur gros effectif de R&D était payé à ne rien faire.

Et les autres non plus n’ont pas spécialement fait de progrès pendant le même temps. Là on a AMD qui vient de faire un bond, apparemment c’est en partie grâce à leur partenariat avec un fondeur qui a réussi à affiner la gravure (là où Intel butte malgré ses moyens).

Personne ne t’obligeait à acheter de l’Intel.

Et si c’était si facile de faire mieux que 10 %, pourquoi personne ne l’a fait ?

#15

Dans le domaine de l’hébergement certains se sont déjà essayé à ARM, et on est loin du “oh c’est facile c’est OSS tout est recompilable”. D’ailleurs, on voit rien qu’au support des différents SoC/archis que l’on l’est bien loin d’une telle vision idyllique. Cela ne veut pas dire qu’ARM n’a pas d’avenir. Simplement que son avenir passera par une gestion plus stricte de ses évolutions/architectures.

#16

Oui j’ai présenté une version un peu “parfaite” car un hébergeur que je connais et qui a essayé a eu (il y a quelques années) quelques petits soucis, dommage j’ai oublié lesquels précisément.

Cela dit la portabilité dans le monde POSIX/Linux est quand même assez élevée (on peut ajouter la famille des NetBSD/FreeBSD, même si le premier a sans doute perdu en notoriété).

On est loin du monde propriétaire où on doit attendre la bonne volonté des éditeurs (et qui souvent ont un code moins portable que dans le monde OSS, ce qui n’aide pas, enfin ça a dû évoluer depuis 20 ans).

#17

Et Fugaku alors ?

ARM arrive tout doucement dans le monde pro, mais sûrement.

Si l’ARM doit arriver dans nos ordinateurs, ça sera en passant d’abord par les serveurs. Ces machines sont le plus souvent dédiées à une tâche particulière, il est alors plus simple de designer une puce destinée à l’accomplir. Puis le scope s’élargira au fur et à mesure.

Les grandes distro Linux sont compatibles ARM grâce à la popularité du Raspberry Pi et le monde Linux connait très bien l’ARM grâce à Android. Les logiciels les plus populaires sont compatibles (On peut installer une distro desktop complète sur Pi, ça répond à toutes les utilisations basiques d’un ordinateur) aussi et la compatibilité des plus petits arrivera là aussi à mesure que la plateforme devient populaire (dans le sens “d’autres machines que des cartes de dev”).

SI Apple a réussi sa transition c’est parce qu’ils maitrisent cette plateforme depuis des années grâce à l’iPhone et ont donc pu fournir tout les outils et explications nécessaires aux dev. Linux est exactement dans le même cas : plateforme connue, système compatible, outils fonctionnels.

Pour le coup je te rejoins, On ne manque pas de news de Brian Krzanich qui torpille des projets ou vire des membres clés de la R&D car pas d’accord avec lui.

AMD a réussi, et pas uniquement grâce à une gravure plus fine. Je ne dis pas qu’il est possible d’avoir +20⁄30% chaque année, mais Intel aurait pu sortir une nouvelle archi bien plus tôt et réussir leur transition vers le 10/7/5nm bien plus vite. Si le plus gros fondeur historiquement en avance de 2⁄3 ans finit par avoir un retard sur ses concurrents, ce n’est pas parce que la techno est inaccessible, sinon les concurrents aussi galèreraient.

Le plus flagrant est de voir à quelle vitesse Intel a retourné sa veste vis à vis de sa gamme grand public passant de “i7 4 coeurs ou rien pour les 10 ans à venir et le reste c’est du bridage logiciel” à “oh regardez nous aussi on sait faire du 8⁄10 coeurs (enfin presque)”.

#18

Bien sur qu’il y a eu monopole de Intel vu les parts de marché. Pourquoi sortir une nouvelle architecture si le concurrent ne propose rien de tangible.

AMD s’est ramassé sur l’architecture Bulldozer (innovante certes, mais pas efficace en pratique) et Intel à juste continué sa route en faisant pas grand chose si ce n’est des légères amélioriations et surtout des boosts de fréquence.

La finesse de gravure ne sert à rien si l’architecture CPU derrière est nul. C’est comme pour un plat, si tu as des bons produits mais que tu ne sais pas cuisiné et bah ça sert à rien. L’exemple des GTX 900 avec l’architecture Maxwell le prouve. Nvidia (et AMD) sont longtemps résté en 28nm pour leurs cartes graphiques, et Nvidia a réussi en restant sur la même gravure a proposé un saut de performance assez dingue pour l’époque avec en plus une réduction des consommations (encore plus dingue du coup).

Pour Fukagu c’est encore autre chose. Il est bon mais uniquement dans son domaine, à la différence d’un CPU X86. C’est en soit, ce qu’Apple à fait avec son M1 qui est bardé d’accélérateur en tout genre qui sont très efficace et peu gourmand (en même temps c’est leur but).

Je pense que le futur passera par ce genre de solution pour accélérer les performances, à moins que quelqu’un sorte une architecture miracle qui solutionne tous les problèmes (ce dont je doute assez fortement).

#19

C’est ce que je dit, ARM arrivera en entreprise en passant par des puces hyper spécifiques pour commencer, avant de devenir suffisamment polyvalent pour être un processeur “classique”. On peut imaginer par exemple des baies SAN en ARM, vu que la seule chose à savoir faire c’est gérer beaucoup d’I/O.

C’est justement ce que prépare Intel avec des gammes de processeurs avec des FPGA intégrés à la demande du client : https://www.intel.fr/content/www/fr/fr/products/details/fpga.html

#20

Comme je le disais, il y a un dossier assez conséquent et documenté chez CPC hardware, je te laisse t’y intéresser si tu t’interroges sur la question.

Je m’étonne de ta question. Parce qu’AMD était à l’ouest (c’est un euphémisme), et qu’il n’y avait aucune concurrence.

C’est ce que l’on appelle un monopole. Ou plus justement, un oligopole.

Ceci dit, je peux comprendre ton scepticisme sur mon ressenti, mais il y a d’une part un réalité technologique (le arm c’est bien mais pas quand on veut de la perf pure “métier”), et en plus un effet d’inertie qui fait que les SI sont frileuses à l’idée d’investir lourdement dans des technos qui ne sont pas validées.

Dis toi qu’actuellement, malgré le fait que l’on soit à plusieurs générations d’AMD qui ont fait leur preuve, Intel continue à être privilégié sur le renouvellement d’infra. Alors un changement aussi radical que ARM… Ca arrivera, si l’archi ARM fait ses preuves, mais ce n’est pas sur les 2⁄3 ans à venir.

#21

Parce que le concurrent travaille de son côté et qu’on ne sait jamais ce qu’il peut sortir. Le marché est concurrentiel et personne n’a intérêt à “s’endormir”.

Évidemment que ça sert et que ça a énormément servi : plus de transistors (plus de cache et de logique et de prédictions), plus de vitesse, moins de consommation.

#22

(je bosse dans le même domaine)

De quelles solutions métiers tu parles ?

La plupart de celles que je vois tourner sont Open Source.

Si AMD était “à l’ouest”, c’est bien que ce n’est pas facile de faire des progrès (ou ce n’est plus facile depuis quelques années, ce qu’il est facile de constater). Et il y a toujours eu de la concurrence (sinon AMD n’existerait plus).

Sur la masse, non (il faut aussi amortir le matériel), mais certains acteurs eux migreront relativement rapidement.

#23

Pour mon client actuel, un peu en vrac : entre les solutions développées en interne (dont celles historiques figées dans le marbre) et celles qui ne seront jamais portées vers une nouvelle architecture, ça fait du monde. Sans même parler de la partie infra comme des moteurs SGBD comme Oracle ou sql server, ou même weblogic, il est clair que le switch n’est pas pour demain.

Mais je te rejoins sur un point, si prochainement l’archi ARM devient la nouvelle référence, les acteurs majeurs s’adapteront.

Facile non, mais AMD a fait énormément d’erreurs à une période (l’archi Bulldozer de mémoire), et ils en ont payé le prix. Pour être franc, s’il n’y avait pas eu les xbox et playstation pour se refaire une santé, je ne suis pas certain qu’AMD tel qu’on le connaît aurait survécu.

Et oui, AMD étant présent à l’époque sur le marché, c’est une forme de concurrence, mais ça reviendrait à dire que MacOS est un concurrent pour Windows. La situation a évolué (heureusement), mais pendant longtemps, les CPU AMD n’étaient vraiment pas recommandables, quel que soit le marché.

#24

Dans la théorie oui.

Donc il aurait suffit de plus de transistors pour faire de Bulldozer une bonne architecture ? La finesse seule ne permet pas de miracles.

L’inverse n’a jamais été dit.

Dans les faits, sur le moyen et haut de gamme, il n’y a eu aucune conccurence. AMD sortait des produits pour faire acte de présence mais les parts de marchés étaient acquises à Intel qui n’avait aucun effort à faire (volontairement ou non). Sans parler des quelques affaires ou Intel a été reconnu coupable d’abus de position dominante.

#25

On pourrait faire des économies d’échelle mixtes.

Par exemple, imagine un cluster de virtualisation:

Ainsi, tu as des machines x86 classiques, dont la sécurité classique est assurée par un équipement réseau ne mangeant pas les ressources de calculs.

Et petit à petit, des fonctions seront déportées vers des puces ARM de cette manière.

On voit déjà ça dans les switchs Dell haut de gamme où tu as un noyau linux qui tourne en parallèle de l’ASIC dédié au réseau (routage et commutation), le configurant et réagissant à la volée. Les Smart-NIC & les Smart-SSD en sont un autre exemple.

Pour moi, l’avenir d’ARM est là: un complément dévoué et économique sur les tâches les moins spécifiques à l’entreprise.

Bref, vive tout le monde, et ensemble, pour qui en a besoin.

#26

J’aimerais voir ça ;-)

Sur le fond de ton commentaire, c’est possible.

#27

Dans ton cas en effet ; de mon côté je vois essentiellement du MySQL/MariaDB et du PostgreSQL.

De plus en plus de boîtes réalisent qu’on n’a absolument pas besoin du “gros” (et onéreux) Oracle dans une grande quantité de cas.

De fait dès 2005 j’avais entamé le remplacement d’un Oracle qui tournait sur un WindowsNT par un Postgres tournant sur Linux ; j’avais suivi une formation d’une semaine sur Oracle quelque temps auparavant. Parmi ce qui m’avait frappé, c’est que ça prenait littéralement des heures d’installer un Oracle, là où un PostgreSQL prenait 10-15 minutes configuration comprise et sans se presser, et disposait déjà de pas mal de fonctions (procédures stockées, triggers, etc.) grâce à quoi une migration depuis Oracle n’était pas forcément si compliquée.

#28

Non, tant que tu n’a pas des bases critiques dont les perfs ont un impact majeur sur les traitements métier.

Par contre, dès que c’est le cas, oracle te permet de choper à peu près toutes les infos imaginables sur le traitement d’une requête, de son interprétation par le moteur sgbd, pour te permettre de pointer la problématique afin de résoudre le problème de façon efficace.

Après, il faut les compétences nécessaires, et pouvoir se payer un dba, voire un dba spécialisé en perfs.

J’aurais bien voulu citer le support oracle dans les qualités du produit, mais ça, c’est plus compliqué

Ce qui est long dans l’installation d’un sgbd oracle, c’est la partie “moteur”, et notamment le respect des pré-requis OS (entre que les packages de preinstall oracle aident pas mal).

Une fois que ton environnement est prêt et normalisé, tu peux déployer des bases via des scripts dans un temps assez court. Même via l’interface graphique de création, ça doit se faire à peu près dans cet ordre de temps.