Nouveau mois, nouvelle GeForce RTX de série 30. NVIDIA continue de déployer son architecture Ampere sur l'ensemble de sa gamme. Avant de s'attaquer aux PC portables, le constructeur baisse d'un cran avec une RTX 3060 Ti. Une référence « mythique » qui devra être à la hauteur.

Dès qu'une nouvelle architecture NVIDIA est mise sur le marché, les joueurs cherchant un bon rapport performances/prix guettent la sortie des modèles xx60, surtout celui marqué d'un « Ti », indicateur d'un produit en général bien « balancé ». Et autant le dire tout de suite, la RTX 3060 Ti annoncée aujourd'hui ne fera pas exception.

Sur le papier, un modèle classique

NVIDIA laisse donc (pour le moment ?) tomber la dénomination « Super » principalement utilisée lors du refresh de sa série 20, une sorte de retour aux sources. Pourtant, en regardant du côté des caractéristiques techniques, ce nouveau modèle n'a rien d'extraordinaire. Il utilise le GA104 de la RTX 3070 et ses 17,4 milliards de transistors, 8 Go de GDDR6 et annonce une consommation maximale (TGP) de 200 watts.

La carte de référence a d'ailleurs droit au même châssis que sa grande sœur, avec trois DisplayPort et un HDMI, nécessitant un connecteur d'alimentation PCIe 12 broches. Ses deux ventilateurs s'arrêtent au repos, la carte est également silencieuse en pleine charge.

Annoncée à 419 euros avec un an de GeForce Now mais sans jeu offert, la RTX 3060 Ti est 20 % moins chère que la RTX 3070, avec une puissance de calcul 20 % inférieure environ (16,2 TFLOPS contre 20,3 TFLOPS) :

- RTX 3060 Ti : 4 864 CUDA Cores, 38 RT Cores, 152 Tensor Cores, 152 TU, 80 ROP, 1 665 MHz (Boost), 448 Go/s

- RTX 3070 : 5 888 CUDA Cores, 46 RT Cores, 184 Tensor Cores, 184 TU, 96 ROP, 1 725 MHz (Boost), 448 Go/s

- RTX 2080S : 3 072 CUDA Cores, 48 RT Cores, 384 Tensor Cores, 192 TU, 64 ROP, 1 815 MHz (Boost), 496 Go/s

Sur le papier, on s'attend donc à une carte au rapport performances/prix du niveau de sa grande sœur, située entre la 2080 Super et la 2080 Ti. Pour le vérifier, nous avons utilisé notre nouvelle machine « milieu de gamme » à base de Ryzen 5 5600X et d'ASRock B450M Pro4 avec 2x 8 Go de DDR4 à 3,2 GHz. Installée sous Windows 10 20H2.

En pratique, un très bon produit

Mais dans la pratique, nous n'avons pas obtenu le résultat attendu. La RTX 3060 Ti s'en est bien mieux tiré que nous le pensions. Pour le vérifier, voici deux résultats face à ses deux concurrentes et une Radeon RX 5700XT d'AMD :

La carte est bien située entre les deux autres GeForce, mais les écarts constatés sont plus faibles, la 3070 est 10 à 15 % plus performante selon les cas, la 3060 Ti est au pire au niveau de la RTX 2080 Super, parfois bien au-dessus. On voit que la Radeon RX 5700 XT est ici en retrait, se destinant plus à s'opposer à une éventuelle RTX 3060.

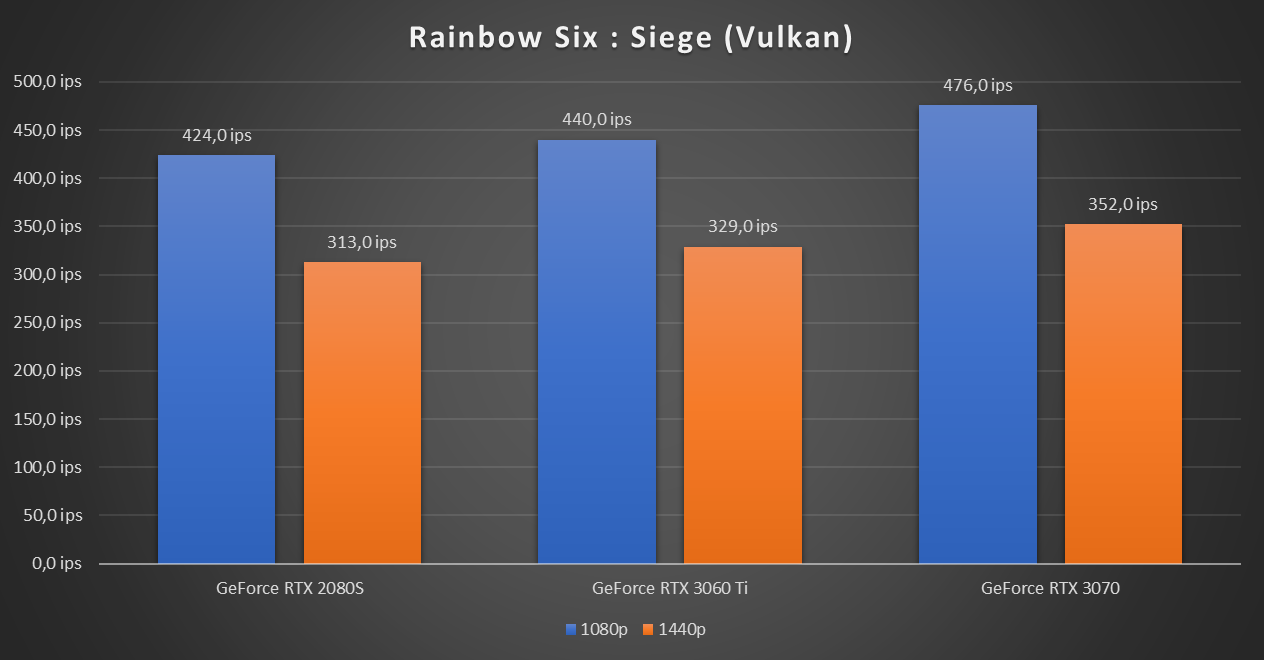

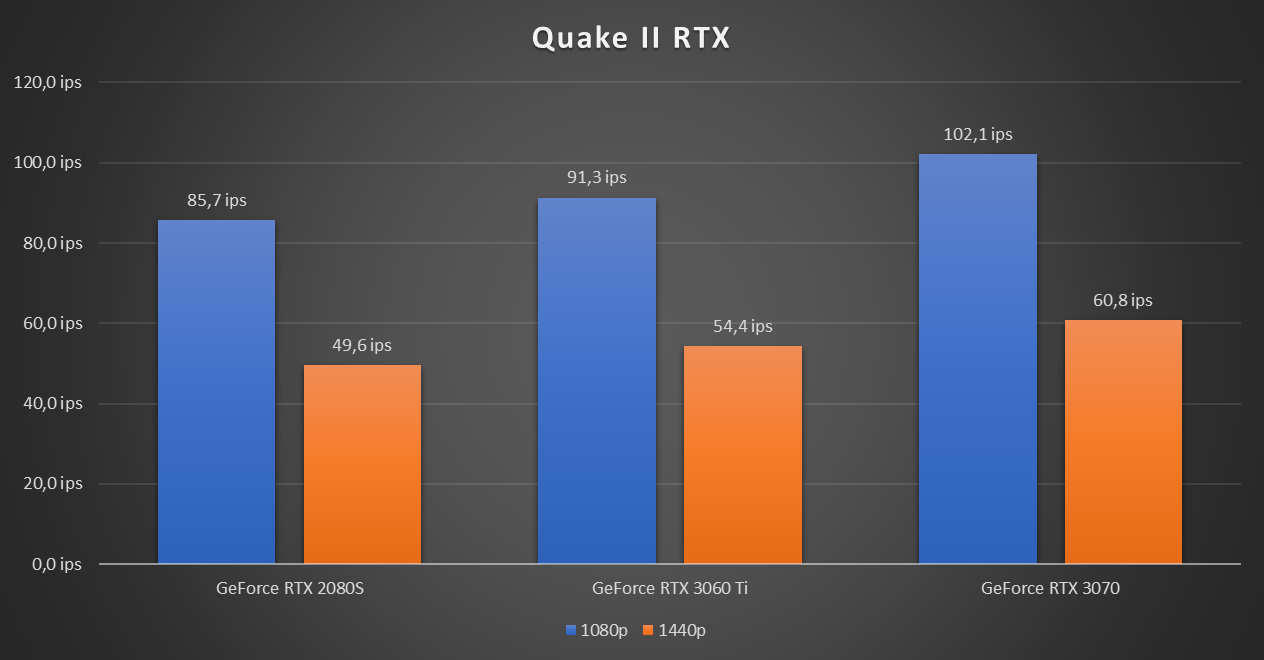

Dans les jeux, même constat. Sur les cinq que nous avons utilisés, la 3070 n'est en général devant que de 6 à 14 %, pour 9,71 % en moyenne. La RTX 3060 Ti est systématiquement au-dessus de la RTX 2080 Super, parfois de justesse, parfois de près de 10 %. Elle est aussi plus économe en énergie que cette dernière.

Sur la scène de test de Borderlands 3 en 1440p nous relevons ainsi à la prise 347 watts pour la 2080 Super, 304 watts seulement pour la 3060 Ti et 326 watts pour la 3070. C'est donc cette dernière qui permet d'avoir la machine la plus efficace, mais de peu : 3,14 joules par image contre 3,19 joules par image pour sa petite sœur.

Sous Blender le rendu de la scène bmw27 ne demande sur 19 secondes à la RTX 3060 Ti contre 17 secondes pour la RTX 3070 et 27 secondes pour la RTX 2080 Ti. Le tout avec une consommation à la prise de 222 watts, au niveau de la 2080 Super (219 watts) et sous la 3070 (243 watts). Là encore, le titre de carte la plus efficace lui échappe de peu.

Elle nécessite en effet 1,17 Wh pour le rendu complet contre 1,15 Wh et 1,64 Wh pour ses deux concurrentes.

Une carte qui devrait vite disparaître des stocks

Au final, on se trouve donc avec une carte 24 % moins chère que la RTX 3070 mais 7 à 15 % moins performante. Les chiffres montrent qu'elle est parfaitement adaptée au 1080p « tout à fond » et peut également être utilisée pour du 1440p si vous acceptez parfois de faire quelques sacrifices.

Elle bénéficie bien entendu de tous les avantages des GeForce RTX de série 30 et de l'écosystème NVIDIA : Broadcast, Reflex, CUDA/Optix, DLSS, Shadow Play, etc. De quoi lui promettre un certain succès, d'autant qu'AMD n'a pour le moment pas de Radeon RX 6700 (XT) à lui opposer. Cela devrait néanmoins venir assez rapidement.

Au final, il faut donc s'attendre à ce que nombreux soient ceux qui vont craquer pour cette nouvelle GeForce de série 30, qui ne devrait pas faire long feu dans les stocks demain à 15h, même si de nombreuses cartes sont attendues. Nous reviendrons sur ce modèle face à l'offre Radeon d'AMD dans un prochain article.

Commentaires (101)

#1

A viser par préférence en cas de montage d’une nouvelle machine pas trop excessive quoi.

#2

A viser si ça se vend un jour quelque part ?

#3

A ce tarif le modèle x60 c’est tout de même très largement éloigné du milieu de gamme.

Une 960 Ti c’était autour de 200 € à sa sortie pourtant les 980 Ti était sensiblement au même tarif que les x80 actuelles…

#4

Yep, vu la différence de prix j’aurai certainement pris une 3070 si il y avait des stock …

#5

Du coup on peut penser que les version itx (~170mm de long) ne seront qu’à partir de la 3060 voire 3050 ?

J’aimerais bien me faire une micro config, genre 4-5L

#6

Très intéressant ce modèle pour du 1080p 144fps tout à fond, de quoi remplacer ma 980TI…

Mais mon petit doigt me dit que les stocks ne suivront pas et les prix vont s’envoler.

#7

Comme dit, il y a pas mal de stock, donc normalement ça devrait tenir. On verra combien de temps (je ne fais pas trop de prévision là dessus, trop de risques )

)

Ca fait des années que le marché du GPU c’est entre 150 et plus de 1000 +. Si pour toi milieu de gamme c’est 200 euros, je pense que le souci n’est pas trop à voir dans l’article ;)

J’ai vraiment du mal à comprendre pourquoi certains pensent qu’une stratégie commerciale doit être figée dans le marbre. Elle ne l’est pas, ne l’a jamais été. Il y a eu des GPU vendus avant la mode des x60, des modèles vendus à 200 euros, d’autres plus chers. Ce ne sont que des stratégies commerciales et marketing qui n’ont de sens qu’à l’instant “t” pour les marques.

Pour le reste, comme déjà dit, si ton budget GPU est de 200 euros, tu avais une 960 Ti avant, tu as une série 1650 sur la gamme actuelle, peut être une 3050 d’ici quelques mois. Chacune étant plus performante que la précédente.

Comme on l’a montré récemment, à 500 euros avant on avait une 980, maintenant on a une 3070. La fin de la référence change… et alors ? Cette dernière est trois fois plus performante au même tarif que la précédente. Son nom serait 3080 pour les mêmes specs que ça n’y changerai rien.

Regarde la taille des PCB, il ya déjà matière à du Mini ITX ;) Mais ça arrivera sans doute dans un second temps chez les partenaires.

Voir ma réponse plus haut ;)

#8

#9

J’en reste à mon idée de ne jamais oublier qu’une référence de produit n’est qu’un élément décidé en fonction du marketing de la marque, rien d’autre et que ce n’est donc pas un indicateur majeur

#10

Est-ce que l’alimentation se fait à l’arrière de la CG ou sur le côté ?

#11

ça serait con que la RTX800€ soit vendue à 1000€ parce que l’approvisionnement ne suit pas la demande

#12

Le connecteur est clairement visible à l’opposé du PCI-E sur la vue sans le radiateur.

#13

Oui mais je me dis que si la FE fait cette taille c’est que le TDP doit être trop important pour qu’un dissipateur aussi court que le PCB suffise ^^

#14

ça dépend des modèles, sur la FE c’est comme la 3070 (même châssis) : au milieu de la carte (vu que PCB court)

NVIDIA a maximisé la surface de dissipation, mais ça m’étonnerait qu’on ne puisse pas le faire dans un format plus court. On verra bien ce que proposeront les constructeurs de toutes façons ;)

#15

Je ne sais pas ce que tu as ou compte utiliser comme boitier, mais il y a un paquet de boitiers mini-ITX dans lesquels on peut parfaitement monter une carte graphique haut de gamme, dont le dissipateur occupe deux voire trois emplacements PCIe.

#16

#17

Même la future (improbable) RTX 3030 (à 200 balles ) va se faire dévaliser au clic sur les sites de commandes dès son apparition… Pôv’ vie…

) va se faire dévaliser au clic sur les sites de commandes dès son apparition… Pôv’ vie…

#18

Ça serait intéressant de donner les framerate en 4K, au moins pour les jeux qui tournent à plus de 100 FPS en 1440p

#19

Le marché des cartes graphiques est devenu un truc de dingue.

Pour le seul prix d’une 3080 aujourd’hui, on avait une config déjà bien balaise il y a dix ans.

J’avoue qu’entre les Smartphone et les GPU à 1000 balles, j’ai du mal à saisir la notion de crise économique et de perte de pouvoir d’achat..

#20

Chez Zotac il y a déjà des références à 22 cm, peut êtree que d’autres, plus courtes, arriveront ailleurs ou plus tard, ou les deux.

#21

Ca me rappelle la bonne époque du rebadging des séries 8000

#22

Peut-être car 80% des smartphone sont vendus à 200euros et les CGU à 300euros?

#23

C’est clair que s’ils les vendent, c’est qu’il y a un marché.

Les crises ne touche pas tout le monde de la même façon et chacun peut également choisir ses priorités.

(tu aime les porches roses ? ;) )

Je me suis surpris à glisser doucement d’un prix moyen de 250€ il y a 10 ans à plutôt 350€ la dernière fois que j’ai changé de carte. Mais même si financièrement je pourrai me le permettre, je trouve que l’usage que j’en fais et le temps que j’y consacre ne valent pas d’y mettre 400-500€ (ou plus), en tout cas en ce moment. Mais ça reste très, très subjectif.

En plus, j’ai eu une phase de transition juste sur un iGP à jouer entre autre à FTL, Invisible inc. ou Minecraft qui était très sympa.

Je trouve très cool qu’il y ai la possibilité de prochainement jouer à Cyberpunk 2077 dans de très bonnes conditions. Mais chacun est libre de suivre cette tendance, ou pas.

Dans mon cas j’espère déjà arriver à me remettre à Witcher 2 d’ici fin 2021, et que le 3 fonctionnera TàF sur ma prochaine carte à moins de 350€ lorsque je le commencerai.

#24

Augmentation de la masse monétaire… = Inflation

Avez vous envisagé que l’inflation gonfle le prix des références, sans que les salaires ne suivent le même rythme ?

#25

Il y a ça mais ça n’explique pas une augmentation de 50% du prix en 5-6 ans, c’est plutôt dû au fait que Nvidia fasse lentement glisser ses numérotations en les montant en gamme pour exploiter une de nos nombreuses faiblesses psychologiques : “j’avais une xx70, je ne vais pas descendre de gamme à une yy60, il me faut au minimum une yy70”. La bonne démarche serait d’ignorer les numérotations marketing mais ces salauds ne rendent pas la tâche facile

#26

Peut être que ta carte graphique coute plus cher, mais te demandes-tu si le reste de ton pc a progressé?

Parce que les licences Windows avec les mises à jour gratuites (y compris que tu conserves quand tu fais évoluer doucement ton pc), les disques de stockage SSD largement abordables, les disques durs encore moins, les processeurs moins haut de gamme nécessaires, la ram moins cher, les cartes mères à prix constant, …

Y’a pas si longtemps, combien de personnes jouaient / faisaient de la bureautique avec un G4560 à 70€ et des 1060 ? Aujourd’hui, un i3 à 130€ est très bien pour la plupart des usages.

Franchement, si on parle en morceaux de smic (qui fait plus concret que les euros constants), je ne pense pas que ça ait tant progressé.

Surtout qu’il y a 10 ans, on jouait en 1680x1050 maximum (1600x1200 pour quelques personnes), le full HD était rare, le 1440p un mystère et le 4K la conquête de mars.

Nous sommes donc passés de 1764000 pixels à 2073600 (+17%) pour les normaux, 3686400 (+109%) pour les exigeants et 8294400 (+370%) pour ceux qui ont trop d’argent. Avec toujours plus de détails, de textures, de fonctions avancées, etc…

Tu ne veux pas acheter une 3080? Joue à plus basse résolution et joue avec les générations d’avant: tu seras déjà ravi

#27

+1, bien résumé

#28

Faut aussi tout remettre dans le contexte de l’époque, à l’époque le Full HD était le max et je dis peut être des bêtises mais je pense qu’on pouvait jouer en Full HD avec une carte haut de gamme de 300€ de l’époque.

Maintenant la 4K est courante (un écran 4K c’est abordable), par contre la CG pour jouer en 4K c’est 600€, soit le double d’il y a 10ans.

J’ai bien compris que tant que les gens sont prêts à payer les sommes actuelles les fabricants seraient idiots de pas faire des produits adaptés à ce segment de prix. Mais on peut aussi admettre que les prix ont flambés pour jouer avec l’écran presque courant de nos jours. J’ai un écran 4K pour travailler, c’est hyper confortable, par contre j’ai pas envi de mettre 600€ pour un GPU pour pouvoir aussi jouer avec, et descendre la résolution sur un LCD on sait ce que ça donne :(

#29

Entre la 980 (542 euro) et la 3080 (719 euro), il y a une augmentation de 32%, le SMIC a progressé entre 2014 (1445) et 2020(1539) de 7%, donc les prix ont bien explosé a euro constant. Les smartphones c’est bien pire mais ils sont des fonctionnalités qu’ils n’avaient pas avant, ce n’est pas le cas des CG et la différence de prix devient de plus en plus énorme avec la génération de console correspondante.

#30

Peut-être parce que la perte de pouvoir d’achat n’existe pas vraiment…

Et peut-être que les gens qui achètent les appareils que tu mentionnes économisent sur d’autres postes de dépenses…

Je dis ça comme ça…

#31

Je n’ai jamais craché sur la 4K, je dis juste qu’il y a un contexte, des besoins et des concessions.

Perso, avec une nvidia, je mets en 4K par 4 pixels: pas de flous, juste des pixels plus gros (grossissement par processeur graphique, pas par l’écran). Essaie tu verras

#32

Faut atterrir 5 min et arrêter de dire des chiffres au hasard. Il y a 10 ans c’était la sortie de la GTX 580 pour 500€ minimum (donc pas deux fois moins) et ça galérait à faire tourner les gros jeux en ultra à 60fps en FHD encore. Et à l’époque on était en plein boom du SLI/Crossfire donc les grosses configs multipliaient le prix de la partie GPU par deux/trois. Retournez voir les benchs d’époque vous verrez (j’en ai choppé un au pif sur anandtech).

Et la 4K n’est pas si abordable que ça aujourd’hui, les écrans entrée de gamme OK mais le milieu de gamme reste un peu couteux comparé aux autres résolutions. Le vrai bon rapport qualité/prix en ce moment à mon goût c’est le 1440p

Aujourd’hui on utilise les CG pour du calcul, du réseau neuronal et de la compression/décompression vidéo, pas en 2010 (NVenc/dec est apparu deux ans plus tard seulement avec Kepler).

#33

Sauf que jouer en 1080p sur un écran 2160p c’est propre puisque le ratio est niquel.

#34

Euh, non, ça rend l’image floue comme n’importe quel autre upscaling. 1 pixel de l’image 1080p à afficher ne devient pas 4 pixels parfaits sur la dalle 2160p.

#35

j’aurai tendance à penser qu’il y a un mauvais réglage quelque part alors

si avant de lancer le jeu, on bascule en 1080p sous windows, je vois pas pourquoi l’écran ferait autre chose qu’afficher 4pixels sur la dalle pour 1 sur la source, à moins qu’il tente lui-même de faire un traitement, qu’il faudrait désactiver du coup

éventuellement la mise à l’échelle de l’interface sous windows 10 pose problème, faut remettre à 100% avant de tout lancer

le mieux c’est de tester :)

#36

Ca a déjà été mentionné, mais je pense que les changements dans les résolutions et taux de rafraichissements sont l’une des causes de la glissade des prix et des gammes.

A sa sortie la 980 arrivait péniblement à 50-60fps sur des jeux gourmands en 1440p de l’époque, la 3060 Ti qui est l’objet de cet article arrive à 60+fps sur tout les jeux gourmands récent que j’ai pu vérifier rapidement pour 419€ (bon, en théorie…). Donc si tu joues dans les mêmes conditions qu’à l’époque de la sortie de la 980, ça te coûte actuellement moins cher et non plus cher pour des performances équivalentes.

Maintenant si tu es monté en gamme sur ton installation et que tu veux profiter de ton écran 1440p 144hz ou 4k, effectivement il faudra augmenter aussi l’investissement sur le GPU.

#37

Je comprends pas pourquoi on doit comparer avec les mêmes conditions (résolution, fps), prends une tv par exemple, on est passé du 1080p au 4k pour le même prix. Qui irait acheter un forfait mobile a 25 euro pour 1 GO par mois en 3G ?

Pour tous les objets du quotidien, il y a des évolutions a prix constant, pourquoi faire un cas spécial des CG ?

La seule explication que je vois c’est que c’est un marché de niche pour utilisateurs geeks/fortunés et peu regardant sur le tarif (dont je fais partis avec ma 3070 …)

#38

Je dois avouer ne pas y avoir regardé depuis des années car je joue en 2160p native sur PC, et ça ne m’avait dérangé que les quelques mois où j’avais encore une GTX970 qui ne pouvait pas faire tourner grand chose en 2160p.

De mémoire, le problème venait des cartes Nvidia qui ne traitaient pas bien l’upscaling d’entiers comme dans le cas 1080p vers 2160p avec un ratio parfait de 1:4, et le seul moyen de contourner le problème était de bidouiller le driver de l’écran pour faire croire à Windows que le 1080p était sa résolution native.

#39

4 x FHD = 4K, donc non, pas de flou. Quand on passe un blueray non-ultra-hd, sur une TV 4K, ca sort juste une résolution native FHD avec 4 pixels pour 1.

Un écran 4K pour travailler (n’importe quel IPS ou VA fait l’affaire), c’est pas du tout le même prix qu’un écran 4K pour jouer (bon IPS ou bon VA, 144Hz, <5ms, Freesync, etc…) , tu peux multiplier le prix par 3 ou 4 au moins.

La différence avec “avant”, c’est qu’avant, l’écran servait à la fois pour jouer et travailler. Maintenant, si tu veux optimiser, il faut un écran pour jouer et un écran pour travailler.

De plus, si tu veux jouer en 4K, c’est un peu comme rouler en Ferrari, ca coute plus cher à la base, mais tout ce qu’il y a autour coute aussi plus cher.

Perso, j’ai une config double écran, 170€ le 27” 1440p pour bosser + jeux RTS/strategie/gestion et 170€ le 27” 1080p gaming pour jouer aux FPS. Pour le GPU, j’espère arriver à avoir une 3060ti (419€) pour remplacer ma GTX1070 (550€ à l’époque). Au final, j’arrive à 759€ pour le GPU et les deux écrans (qui me servent aussi a travailler), soit le prix d’une RTX3080 seule pour jouer en 4K.

Euh non, avec le nvenc, tu peux encoder de la vidéo en temps réel. Mais aussi les algo d’IA qui entrent en jeux comme le DLSS. Les GPU durent aussi plus longtemps. En acceptant de descendre un ou deux paramètres graphiques, tu peux jouer très confortablement avec une GTX1650 à 140€. La “vieille” GTX1070 fait tourner Cold War à 90/100FPS avec quasi tout au max.

#40

Le même prix en comparant quel modèle de TV avec quel modèle ? Pour une même diagonale il y a des TV 4k qui vont de 400€ à plus de 3000€.

Les cartes graphiques ont progressés également à prix constant, afficher 60FPS en 1440p sur un jeu de 2020 ce n’est pas pareil que sur un jeu de 2014… Et puis il y a DLSS, l’IA, le RT et toutes les autres technos qui sont apparues entre temps.

Pour le moment d’après les stats de steam les deux tiers des gens utilisent toujours un écran 1080p, les GPU adapté pour le jeu en 1440p ou plus sont donc effectivement pour une cible de niche.

#41

Et bien c’est un problème technique que tu as eu car comme les autres le font remarquer 2160p c’est 4 fois 1080p.

#42

Le prix de ton abonnement dépend de ce que ton opérateur peut te fournir comme service. Ca ne se compare pas à un objet que tu utilises sans service de la part du fabricant (on parle pas de SAV).

Et comme le fait remarquer Anachron les prix des appareils du quotidien aussi ont glissé vers le haut ET vers le bas.

#43

Bon il est 15h on en trouve ou?

rien chez ldlc ou amazon

#44

déjà tout vendu avec une spéculation de fou de la part des marchands.

Pas vu passer les FE malgré une surveillance assidue

#45

Sur LDLC.be il reste quelques références.

#46

Les FE ont été mises en ligne, mais c’est parti assez vite, en quelques minutes comme les autres fois. Pour les autres références le stock tient, mais certains tarifs sont assez élevés (Zotac avait un modèle au prix chez Top Achat par exemple)

#47

C’est infernal de se monter une config un peu optimal prix/perf, en ce moment, il y a beaucoup d’articles phares sous tension (r5 3600, cg …), du coup les prix montent, le nombre de ref en CG et cpu qui sont en ruptures dans la plupart des boutiques, c’est assez inhabituel.

#48

Je suis d’accord, j’avais rien contre attendre quelques semaines à la sortie des RTX3xxx, mais là ça commence à être ridicule…

Je ne suis allé voir que sur hardware.fr et 45min après lancement, tout est déjà en rupture ou à + de 15 jours. Ça commence à faire long pour changer de CG.

#49

Finalement même pas besoin de choisir, je ne prends aucune des 2 :)

#50

45mn… Le stock est parti en 7mn, et encore, c’est le temps que les gens arrivent à passer toutes les étapes de la commande, tellement le site était lent.

J’ai réussi à aller au bout de la commande sur LDLC pour une FE, mais le mail de validation me met “dispo +15 jours”… D’autres on réussi à aller au bout?

#51

Sans blague, je n’avais pas remarqué que le 2160p était pile 4x du 1080p…

C’est pas parce que sur papier ça tombe pile sur un entier “facile” comme 4 que tu vas avoir d’office de l’interpolation “nearest neighbor”, et j’sais pas pour toi, mais quand j’achète un écran de PC, je ne regarde pas forcément les types d’interpolation qu’il peut utiliser pour les résolutions non-natives. Et des 7-8 modèles d’écrans UHD que j’ai déjà eu entre les pattes, aucun ne faisait de l’interpolation NN où 1 pixel 1080p devient 2*2 pixels de la même couleur en 2160p, il y avait chaque fois un traitement qui rendait l’image floue. C’est un peu comme à l’époque des écrans 16:10 en 1920x1200, où beaucoup n’avaient pas d’option pour afficher du 1920x1080 avec des bandes noires et étiraient le 16:9 en 16:10.

Et suite aux messages, j’ai d’ailleurs été vérifier côté Nvidia, à première vue, ils ont seulement ajouté l’integer scaling en beta dans leurs drivers en août 2019 avec la version 436.02, et cette option n’est dispo qu’avec les cartes Turing et plus récentes, avec encore des limitations…

#52

c’est moche cette histoire

d’un autre coté je pige pas pourquoi, quand on branche un truc qui sort du 1080p (un raspberry pi ou un ordi portable par exemple) sur une tv samsung (1080p aussi) on se retrouve avec … un cadre noir autour de l’image et il faut aller jouer dans les réglages pour retirer ce cadre, bon sang c’est du 1920*1080 de bout en bout et y’a un maillon de la chaîne qui fait comme si c’était de l’analogique

(j’ai vu ça assez systématiquement sur des samsung, de série / génération différentes pourtant, moins sur d’autres marques)

t’es peut-être tombé sur un truc du genre :s

#53

C’est marant parce que sur les TV ca passe niquel. J’ai ma switch, ma PS3 et une mibox sur ma TV 4K et aucun problème pour gérer le FHD. Pour moi, c’est pas à la source d’envoyer du 4K FHD, mais bien à la destination de savoir gérer le signal FHD.

Je vais essayer de passer ma switch en 720p sur mon écran de PC 1440p pour voir s’il sait gérer ca comme ma TV.

#54

C’est pas qu’il est tombé sur un cas spécifique, mais c’est le fonctionnement général de tous les écrans/GPU. Le support de l’Integer Scaling est assez récent, et pitoyable chez certains (Nvidia…). Tu peux tester sur tous tes écrans, passer à une résolution / 2 (1920 -> 960 par exemple) et tu trouveras l’image floue. Je n’ai personnellement jamais vu d’écrans (que ce soit TV, moniteurs ou PC portables) qui permettait de faire un scaling au plus proche.

Y’a un bon résumé ici : https://tanalin.com/en/articles/integer-scaling/

#55

l’affichage des PC sur TV, grand mal du siècle dernier. Jamais vu une télé d’environ 2000-2010 gérer l’affichage d’un PC correctement.

#56

ça tiens, c’est vite dit… au bout de dix min il ne restait plus que des cartes avec une disponibilité à plus de 15 jours, soit à une date indéterminée…

#57

les 3060Ti sont pratiquement aussi chére que les 3070 au moment de leur sortie… ( les 3070 se sont rattrapés depuis)

#58

Il ne faut pas oublier que le bas de gamme est occupé par les Gpu intégrés donc ils ne se concentrent que sur le milieu de gamme/ haut de gamme. D’ailleurs le jeux vidéo a explosé et n’est plus un concept de jeune adulte/étudiant. Aujourd’hui ça va de 8 ans à 40+ sachant que les jeux compétitifs ont pris pas mal d’importance et l’exigence a un prix surtout que pas mal de gens continue à jouer alors qu’ils ne sont plus étudiants et ont donc plus d’argent pour s’y investir et faire comme les pro et streamer qui sont de belles vitrines.

Tout ça pour dire que le marché a grossi et la population du marché a vieilli et elle gagne plus d’argent, donc elle peut investir plus et son plus nombreux. De plus le lancement est de plus en plus espacé, ça fait quasiment deux ans qu’on n’avait pas eu de vrai nouvelle carte graphique.

#59

Pour les intéressés pas trop loins de la frontière, il reste pas mal de références disponibles sur le site d’Alternate Belgique. S’il est à jour, bien sûr.

#60

Honnêtement, j’avoue ne pas avoir tout saisi de ton message.

Ce que je voulais juste mentionner, c’est que, pour faire simple, le HDG en dix ans sur le marché des cartes graphiques a doublé. Une GTX 980 fin 2014, c’était 550€. Une 3080 en 2020, c’est 900 balles. Une HD 7870 fin 2011, c’était 300€ .

Je ne parle pas des processeurs, etc, je parle de ce marché spécifique des GPU.

Ensuite, pour répondre à la remarque sur l’inflation, je ne suis pas certain de sa pertinence : j’aurais bien aimé, à position équivalente dans la chaîne alimentaire, que mon salaire de 3000€ en 2011 soit à 10000 aujourd’hui. Malgré une progression significative dans la chaîne, mon salaire n’a pourtant pas atteint ce sommet…

Enfin, évidemment, il ne faut pas comparer des choux avec des patates. Le HDG en 2014 n’était pas fait pour jouer sur du 4k, évidemment…

Bref, tout ça pour dire que je suis assez sidéré par le prix en 2020 d’une carte graphique haut de gamme.

#61

En fait tout dépend si tu laisses faire l’écran ou la carte graphique.

Sur les Nvidias: Panneau de configuration NVidia, Régler la taille et la position du bureau, Mise à l’échelle (sur l’écran souhaité), Mise à l’échelle par nombres entiers.

Ce réglage est juste indispensable quand on ne joue pas sur la résolution maximale d’un écran.

Je veux juste dire que le besoin n’est pas la carte graphique mais l’ordinateur qui fait ce qu’on a besoin. Le prix des composants, finalement, s’équilibrent quand un prends du galon.

Ca d’accord, mais n’oublie pas que les GPU servent de plus en plus de GPGPU. Les chercheurs, développeurs, graphistes, cinéastes, etc.. sont putains de content des prix des 3080 et des 3090.

#62

Peut être que les gilets jaunes 50 samedi de suite c’ est juste une fiction ….

S’ amuser à perdre des yeux pour devenir borgnes ?

Franchement ils exagèrent !!!

#63

Après réflexion, je pense que le souci c’ est la mondialisation de la consommation de cartes graphiques de qualité sans la création d’ usines capables de les produire en masse.

Et donc une offre / demande du marché défavoable à la demande en termes de prix.

Beaucoup de “managers” croient qu’ en délégant une partie des taches de l’ entreprise à des sous traitants pour obtenir une réduction des coûts.

Mais là je crois que dans le domaine technologique, le manager moyen a forcément tort.

Si les usines ont la main parce qu’ elles ne sont pas si nombreuses à se retrouver en capacité de graver ce qu’ elles veulent à quelques nm près, elles aussi peuvent imposer leur prix de façon d’ autant plus justifiée que le coût de construction d’ une usine de ce type est d’ un montant faramineux.

Vus les prix demandés et les centaines de milliers de cartes graphiques à vendre, il s’ agir là d’ un business du futur plus qu’ excellent.

Le fond de la discussion sera obsolète dès qu’ Intel qui a toujours eu beaucoup d’ usines pourra de nouveau technologiquent entrer en comptétion avec Samsung ou TSMC pour nous apporter des cartes graphiques capables de jouer les trouble fêtes.

On trouve encore des gtx 730 en vente et même des cartes moins puissantes encore que cela comme s’ il n’ y avait pas eu de progrès depuis l’ époque de leurs créations.

La régulation des prix du marché par le marché, tout ce qu’ adorent les amerloques va s’ occuper du problème pour une partie des gammes dans les deux ans qui viennent.

Vivement que ça arrive pour que la compétition reprenne là où l’ ont laissé certains plus pour l’ amour du pognon que du client.

#64

Pour rappel à l’époque des 980 on avait déjà la Titan X à 1 300 balles. C’est un peu usant d’avoir à le répéter, mais le marché des GPU s’est étendu, touche le marché pro et la zone grise entre pro et grand public depuis un moment. Mais les noms des cartes changent, c’est la vie. C’est du marketing.

On s’en fout un peu, parce que sur le fond, ce n’est pas ça qui guide les choix. L’important pour un utilisateur, c’est s’il trouve mieux selon son budget de génération en génération et quand il veut changer. La réponse est : oui.

PS : on trouve aussi des CPU à 3 k€ désormais, ça n’empêche pas ceux qui ont 200⁄300 euros (ou moins) à mettre dans un CPU de trouver chaussure à leur pied.

#65

Et ben c’est de la grosse merde cette histoire…

#66

Bon ba plus de stock chez personne, c’était à prévoir remarque ^^

Mais je dois quand même avouer que de mémoire de gamer, j’ai pas souvenir qu’une nouvelle génération de matériel gaming (CG/console/Proco) soit autant touchée par la pénurie en si peu de temps avec une inflation aussi galopante des prix =|

#67

Sortie de consoles + nouvelle finesse de gravure + COVID = pénurie.

Donc ce n’est pas la bonne génération de GPU pour changer de config, pour ceux pour qui le rapport qualité(performance)/prix(réel) est important

#68

Je l’ai vue disponible une dizaine de minute sur LDLC.

Je l’ai ajouté au panier vers 15 h 04, payement vérifié à 15 h 05 et commande validée à 15 h 06, confirmée un peu plus tard. À 15h 14 elle était indiquée comme en rupture.

Il y avait 2 références tiers qui sont apparu dans la recherche à 15h03 mais directement en rupture pour moi. La FE n’apparaissait pas dans la recherche par-contre, je suis passé par la boutique officielle Nvidia pour avoir le lien.

#69

Hé bien, moi qui voulait me faire plaisir pour Noël en montant ma première config depuis presque 20 ans (souvenir de ma Geforce4 Ti 4200 ), il va falloir que j’attende encore “un peu”..

), il va falloir que j’attende encore “un peu”..

#70

Marrant, il y a toujours 7 références disponibles sur Alternate Belgique et d’autres qui arrivent. J’ai un pote qui vient d’en prendre une et qui sera livré demain. Etrange qu’il n’y ait absolument rien de dispo en France.

#71

OK, je suis ravi d’avoir tout juste renouvelé mon abonnement après de longues hésitations, tout ça pour me faire sermonner à mon troisième commentaire après renouvellement, avec du “pour rappel”, et du “c’est usant”.

Je ne dis absolument rien sur ce qui est dit concernant l’utilisation, l’extension des GPU du marché au milieu professionnel, aux fermes GPU, à tout ce que vous voulez bien dire, soit, c’est factuel, mais je n’ai rien dit à ce sujet.

Je n’ai fait qu’une comparaison très simplement, en prenant un HDG grand public à deux époques différente. Je ne vois pas bien en quoi je mérite de me faire rembarrer de cette façon et de me voir opposer des arguments sur des faits qui sont hors de mon propos.

Et puisqu’on parle du Titan, on peut aussi parler de la RTX 3090 dans ce cas, qui vaut dans les 2000 euros…

C’est dingue, je fais une simple comparaison tarifaire entre deux GPU HDG à quelques années d’intervalle en disant que le prix du HDG a quasiment doublé en 10 ans, du point de vue d’un consommateur lambda.

Vous avez fait une comparaison en faisant du GTX 980 vs 3070 en 2020, je suis pas venu pourrir l’article pour autant en disant que c’est usant de faire des comparaisons hors contexte, et que pour rappel, la GTX 980 ne coutait pas 520⁄540 euros à sa sortie.

Entre le fond et la forme, je suis ravi après 14 ans d’inscription et 7 ans d’abonnement de me faire faire la leçon comme un enfant.

#72

Ce qu’il essaie de dire, c’est que ta comparaison n’est pas ISO.

Le haut de gamme d’il y a 10 ans n’est pas le haut de gamme de 2020 tout simplement parce que le marketing a cree ce haut de gamme de toute piece entre temps.

Si les choses n’avaient pas bouge, le haut de gamme d’il y a 10 ans serait quelque part dans le milieu de gamme de 2020.

La 3080 ou 3070 se positionne quelque part vers la Titan X qui est une carte pro si mes souvenirs sont bons. En gros on a des perfs de cartes pro pour moins chers qu’une carte pro un truc comme ca.

Si je peux me permettre une comparaison bagnolesque, c’est comme si tu comparais la Golf 1 a la Golf 7. Elles ont le meme nom mais ne sont plus du tout dans le meme segment.

La golf 1 serait plus a comparer a une polo de 2020 par exemple voir meme a plus petit.

Donc pour quelqu’un qui voudrait l’equivalent d’une golf 1 (prix, gamme, prestige) s’il prend une golf 7 ca sera plus cher et surdimmensionne, mais il ne devrait pas regarder la golf 7 car pour rester dans ses criteres il devrait plutot regarder une polo.

voila my 2 cents

NOTE: je sais pas combien coute une golf 7, j’aime pas ca de toute facon…

#73

Faut dire que ce faux débat reviens à chaque news… c’est usant.

L’explication de Notice me Senpai est pas mal, enfin une comparaison bagnolesque!

#74

Effectivement c’est plutot bien expliqué :) Et je comprends David, ca doit etre lourd de voir systématiquement la moitié des commentaires d’une news qui sont à la fois répétitifs et inexacts.

Sinon, est-ce qu’il est prévu d’analyser les cartes custom ? Car certaines 3060 Ti sont aux prix d’une 3070, est-ce justifié ?

#75

Je n’avais pas acheté de matériel depuis quelques années (sauf des souris, j’use beaucoup…) j’avais décidé de changer de carte vidéo pour noël. J’achète des revues en kiosque, je me ballade sur les sites internet, je me fais quelques idées.

Je vais sur LDLC : filtres de 400€ à 1000€ (large non ? ) - deuxième filtre : dispo.

AUCUN RÉSULTAT

Pour moi c’est hallucinant (ou leur filtres sont merdiques) je reste avec ma 1080, tant pis pour eux.

#76

Oui, j’ai bien saisi l’idée.

Dans ce cas, on peut le voir autrement : quelle carte faut-il en 2020 pour jouer en Ultra/4K vs quelle carte fallait-il en 2012 pour jouer en Ultra/1680*1050, et quel budget faut/fallait-il y consacrer ? Sous cet angle, en 2020 un HDG c’est 3080/1000€, en 2012 c’est 7870/350€

Évidemment et heureusement qu’à chaque renouvellement, le milieu de gamme d’une génération sera plutôt équivalent à du haut de gamme de la 4/5/n-ième génération précédente.

Il n’empêche que son positionnement dans sa génération est celui d’un milieu de gamme. C’est pour cela que je parlais de deux hauts de gamme.

Je suis absolument d’accord pour dire qu’une Golf 7 est incomparable en termes de services rendus/qualité/performances est incomparable à une Golf 1, il n’empêche qu’en terme de positionnement dans leurs gammes respectives, elle sont à des niveaux similaires.

Le prix du HDG n’a cessé d’augmenter depuis le milieu des années 2000.

Il suffit de voir la terminologie utilisée.

Prenons le marché du CPU, c’est assez similaire, un i7 3770k était le HDG à 350€ en 2012. Aujourd’hui, on te dit tranquillement que “ça n’empêche pas ceux qui ont 200⁄300 euros (ou moins)” à consacrer à un CPU. Bref, qu’avec le même budget, tu peux te contenter d’un truc qui conviendra.

Enfin. Je ne vais pas élaborer davantage, je crois que c’est bon :-)

#77

Ce n’est pas un sermon, juste un rappel face à un propos. Note au passage que le fait d’être abonné (récent ou pas, je ne check pas le statut de tous ceux avec qui j’échange dans les commentaires), lecteur ancien ou récent n’a pas à influer sur la manière dont on répond aux lecteurs. Je répond au propos, pas au statut.

Pour le reste, ta comparaison n’était pas correcte, tout comme ton propos sur le fait que le tarif du haut de gamme a doublé. Je ne fais que te le faire remarquer. Et effectivement, il m’arrive souvent d’avoir à le répéter, mais certaines idées reçues ont la vie dure. C’est une raison de plus pour ne pas les propager.

Concernant l’article sur la GTX 980, les liens de l’époque sont dans l’article, la carte a été mise sur le marché en France à 542 euros avec le relevé de prix que j’avais fait dans des boutiques lors de ce lancement.

De manière plus générale : les marchés dont on parle ici ne sont pas une religion qui devraient suivre de saintes écritures. Ils évoluent. Le marché PC d’il y a 20 ans, d’il y a 10 ans, d’il y a 5 ans n’ont rien à voir avec l’actuel. A une époque on dépensait des sommes folles dans des cartes son, ce n’est plus le cas. On payait une bonne partie du budget pour le stockage, ce n’est plus le cas. On dépendait de multiples cartes filles, ce n’est plus le cas.

On a jamais eu autant de puissance pour si peu cher. Voir les SBC, les machines complètes à 100⁄200 balles (licence incluse), etc. Ne voir que des hausses c’est ne raconter qu’une partie de l’histoire.

Le marché du CPU et du GPU ont pris de l’ampleur, les lignes entre offre pro et grand public sont devenues plus floues parce que c’est ce qui correspond aux besoins d’une partie des acheteurs. On trouve des CPU à 64 cœurs parce qu’il y a un public pour de tels produits. C’est la vie. Comme on en trouve à quelques dizaines d’euros qui donneraient des sueurs à des Core i7 d’il y a quelques années. Penser que le marché devrait se limiter à la vision que l’on en a à titre personnel n’a aucun sens.

Comme dit, la seule chose qui importe, c’est que sur le segment de prix qui nous intéresse on trouve notre bonheur et que ce soit mieux qu’avant. Tout le reste n’est que considération statutaire, dépendant principalement de stratégies marketing des constructeurs (ce qui n’a pas vraiment d’intérêt).

Tu vois dans mon propos le fait de se “contenter”, ce n’est pas le cas. C’est simplement que chacun a un budget et qu’il doit faire des choix pour s’y tenir selon ses priorités. Pour certains c’est le GPU, le CPU, l’écran, le clavier… c’est assez personnel et il n’y a pas de règle fixe. Voilà tout. Et si tu vois du mépris dans le simple fait d’énoncer la réalité de tous ceux qui ont un achat à faire, je n’y peux rien.

#78

Existe t-il un nom pour le point Godwin mais quand on parle de bagnole?

Si ca n’existe pas encore, je propose: Le point Schumacher.

#79

On refait le film :)

J’avais un auto-refresh sur le site de nvidia toutes les 5s, dès que le bouton vert a pop, je dirais à 15h03, j’ai commandé sans réfléchir. Entre la page du GPU, la mise dans le panier, l’affichage du panier, validation, la correction de l’adresse postal qui n’était plus bonne, validation et pour finir la CB, avec 30 secondes de de chargement de chaque page à cause de l’affluence, la commande est passé à 15h11 (inscrit dans mon mail de récap). Juste après la commande, je suis retourné voir si il en restait, la carte graphique avait déjà disparu du site… Il restait encore quelques custom disponibles mais clairement pas à 419€.

En faite, quelqu’un qui arrivait à 15h05 n’avait aucune chance de passer toutes les étapes de commandes, tout s’est joué sur les deux premières minutes je pense.

A part ca, de plus en plus, je me dis que les prix abusés ne sont pas due qu’à la pénurie.

J’ai l’impression que ces cartes à édition ultra limité, c’est juste pour pouvoir afficher un tarif sur les slides et dire “vous voyez, on est pas cher” vis à vis d’AMD, mais dans la réalité, les founder edition sont volontairement en quantité ultra limité et les puces GPU sont surtout vendu aux marques custom qui mettent les tarifs qu’ils veulent.

C’est comme un magasin qui vendrait des PS5 à 200€, mais seulement 3 en stock. Une fois que les gens se sont mis en tête d’acheter une console, et une fois dans le magasin, bah certain la prendront plein pot, d’autre prendront d’autres choses (bon la différence la, c’est qu’il n’y a même plus “autre chose”).

PS: minuit est passé, la livraison est prévu pour aujourd’hui en ce qui me concerne. J’ai hâte de tester ça.

#80

Personnellement, ce que j’ai du mal à comprendre c’est la disparition fulgurante de toute la gamme Turing.

Tout est passé en rupture. A croire que les cartes ont disparues du jour au lendemain.

J’ai du mal à croire qu’il y’a eu un engouement pour ces cartes surtout vu leurs prix…

Quand on voit les reportages sur le nombre de produits détruits par les géants de la distribution pour ne pas avoir à baisser les prix… Il est donc difficile de ne pas faire un parallèle et se méfier.

Le marché de l’occasion suit le même délire. Sérieux y’a des gens qui achètent des cartes ayant servi 2 ans à plus de 50% de leur valeur initiale? C’est surréaliste… Si je suis ce que je lis, je pourrais revendre ma 1050 quasi au même prix que son achat…

Hors toutes mes cartes ont lâchées entre 2 et 3 ans… C’est d’ailleurs le composant le plus fragile de toutes mes configs. Et aujourd’hui on veut nous faire croire que ce sont des lingots d’or à la valeur fixe et stable dans le temps?

#81

C’est encore la faute des Allemands !

#82

Ça c’est joué à pas grand chose…

Moi j’avais mis mon adresse le matin même et fait une commande bidon (tout de suite annulée) pour enregistrer ma CB (on peut pas l’ajouter dans son profil). Ça m’a permit de tout valider très rapidement.

Je l’ai réceptionné ce matin, il me manque plus que tout les autres composants autour

#83

Michou !!!!! Ou aussi Hamilton vu q’il est passe devant

#84

Il me semble que cette pratique est interdite, Si un magasin annonce un produit à un certain prix, il est obligée d’avoir un stock suffisant au prix annoncé. La c’est plus compliqué car il n’y a peu de stock… Il faudra voir lorsque les stocks seront là si on trouve des cartes au prix des FE.

#85

Mon exemple est peut être mauvais :) On va dire que la promo est sur la PS5 à 200€ mais qu’en arrivant au magasin, il n’y en a que 3. Mais il y aussi plein de pack PS5 avec 2 manettes et un mois de PSN à 600€. Tu peux être sûre que certain repartiront avec le pack a 600€.

Je suis persuadé que les micro stock des FE est volontaire et que c’est uniquement pour annoncer un ratio prix/perf sur leurs slides marketing en disant “Regarder, on est trop puissant et pas cher”, sauf que dans la vrai vie, les seules cartes dispo sont/seront les cartes custom à 100/200€ de plus.

#86

Doublon, pardon.

#87

Je reviens donc sur le sujet, d’une part parce que ton premier commentaire ne répondait pas vraiment à ce que j’évoquais, et d’autre part pour compléter mon propos de façon plus précise.

Sur le premier commentaire que tu fais en réaction au mien.

1/ “Pour rappel à l’époque des 980 on avait déjà la Titan X à 1 300 balles”

Pour rappel, à l’époque des RTX20XX on avait des Titan à 2000 balles, et pour rappel à l’époque des 3080, on a des RTX 3090 à 2000 balles.

2/ “On s’en fout un peu”. Ben moi non, pardon, ça m’intéresse. Parce que cette démarche tarifaire a un impact sur le reste de la gamme inférieure. Quand on pouvait acheter une HD4770, considérée comme du milieu de gamme, qui faisait le job sur la majorité des jeux pour moins de 100€, aujourd’hui le milieu de gamme qui fait tourner la majorité des jeux, la RTX2060, se paie 400€. Si je prends la GTX1660, on est à 200€. Et la RTX2060 est le ticket d’entrée à l’heure actuelle, il n’y a pas de CG plus bas dans la gamme.

3/ “on trouve aussi des CPU à 3 k€ désormais”. Oui, si on part sur le marché serveur, c’est sûr, on peut même claquer beaucoup plus si on veut. Cela étant, ce que tu dis sous-entends que ce n’étais pas le cas en 2010. Je regardé rapidement, si on reste du Intel i9 980X 2020 vs Intel i7 980X en 2010, on est sur du 1000 vs 1200€, soit une légère augmentation.

4/ “le fait d’être abonné (récent ou pas, je ne check pas le statut de tous ceux avec qui j’échange dans les commentaires), lecteur ancien ou récent n’a pas à influer sur la manière dont on répond aux lecteurs. Je répond au propos, pas au statut.”

Soit, ce que je sous-entends c’est que durant ce laps de temps, je ne crois pas jamais avoir fait l’objet de remarques aussi désagréables et désinvoltes. Je souligne simplement une évolution dans la façon de communiquer.

5/ “Pour le reste, ta comparaison n’était pas correcte, tout comme ton propos sur le fait que le tarif du haut de gamme a doublé. Je ne fais que te le faire remarquer.”

Bien, alors en partant d’une mise sur le marché à 350€ d’une HD5870, à 549€ d’une 980, je veux bien recevoir l’argument qui explique qu’une 3080 à 900€ n’est pas plus chère que les hauts de gamme de ces dix dernières années.

Encore une fois, moi aussi je m’use à répéter :

Voilà, donc je veux bien débattre, mais je regrette cette façon de clore un débat de façon expéditive et désagréable.

#88

C’est exactement ce qui est, ou était, interdit.

Tu fais une fausse promos avec un stock très limitée, pour faire venir les clients, et une fois sur place tu lui vends autre chose, que ce soit le même produit ou quelque chose de tout a fait différent n’a pas d’importance.

J’avais amis avocat qui c’était fais la spécialité de récupérer des produits en promotion. 9 fous sur 10 il repartait avec le produit, soit disant épuisés, le reste du temps il repartait avec un produit équivalent ou mieux…

#89

Ce que tu dis est globalement faux. Tu peux jouer a Call of Duty Cold War, sorti il y a 3 semaines, a 80 fps avec une pauvre GTX1650 à 150€ en qualité medium en Full HD. Tu peux aujourd’hui “investir” dans une carte graphique a 500€, elle te fera facilement 5 ans, là où il y a 10 ans, il fallait changer tous les deux ans pour garder un truc a peu prêt potable.

Maintenant, le gaming PC s’est démocratisé massivement, à l’époque, seuls les gamins fauchés qu’on était jouaient sur PC. Maintenant, on continue de jouer, mais avec un plus gros portefeille, un nouveau marché s’est créé, NVidia apporte une réponse. Mais il n’empêche que tu peux aussi te faire plaisir avec une configuration très modeste avec un budget moins conséquent qu’à l’époque.

#90

Encore une fois tu ne compares pas les bons indicateurs. Le i9 9980XE c’est \(2000 au lancement, pas 1200. Et si le 10980XE n'est qu'à \)1000 c’est uniquement à cause du sur place technologique d’Intel et de le pression d’AMD. C’est d’ailleurs chez AMD qu’il faut regarder pour voir la vraie grille tarifaire de l’ultra haut de gamme “grand public”, avec le Threadripper 3990X à $4000 (car oui la gamme Threadripper est axée grand public. C’est Epyc les processeurs serveurs).

#91

On se calme hein, je ne suis pas agressif moi. Donc j’atterris et je prends vos chiffres, 500€ pour une CG haut de gamme de l’époque, la RX 6900 est annoncée a 1000$, les 6800Xt sont presque à 1000€ actuellement mais ok ça n’a pas doublé.

Quant aux écrans 4k pas abordables, j’ai acheté une TV 4K 43” à 400€ samsung ya 1 an, je sais pas ce qu’il vous faut… Trouver un écran de cette taille ya 10ans c’était pas le même prix clairement. Comme je disais, maintenant pour trouver une CG qui permets de jouer en définition native, c’est pas 200€ comme ce que je dépensais il y a 10 ans pour accompagner mon écran.

Ben pas sur ma TV, pourtant on dit que les TV upscale mieux que les écrans PC… C’est baveux crados quand on est pas en résolution native, comme tous les LCD que j’ai croisé jusqu’ici.

Je suis au courant des astuces de mise à l’échelle par la CG mais étant sous Linux et avec une carte AMD, je sais pas si c’est possible de faire pareil que sous Windows. Mais le débat n’est pas là, ce que je voulais dire c’est qu’à l’époque une CG haut de gamme permettait de jouer en résolution native d’un écran “normal” de l’époque, alors que maintenant faut viser le double de budget.

Je te garantie qu’avec ma pauvre TV entrée de gamme Samsung je joue dans de très bonnes conditions. Aucun input lag, contraste top (dalle VA), pas de rémanence. Et pourtant avant j’avais une Sony FHD haut de gamme, clairement la samsung fait mieux. Donc non pas besoin de 2 écrans (m’en fou du freesync et compagnie). J’ai choisi samsung car je sais que l’input lag est correct et que la dalle est bien calibrée.

#92

On est bien d’accord.

Quand aux réponses de David_L, on également d’accord, il n’y a plus de débat possible avec lui je trouve. Il a un avis sur un sujet, si on est pas du sien ben on a tort point barre, et pas de débat possible c’est toujours expéditif. Je suis vraiment déçu, les articles sont en général intéressant par contre ses réactions dans les commentaires sont très souvent désagréables et gentillement agressives.

Il se plaint de répéter toujours la même chose, mais c’est peut être qu’il n’a pas écouté/compris ce que les gens lui disent, ou qu’il ne détient pas forcément la vérité absolue.

#93

Il ne peut y avoir de débat sur des faits.

#94

Tu compares des cartes et des contraintes d’il y a 10 ans avec des cartes et des contraintes de maintenant. Y a 10 ans, on parlait à peine de FHD.

En faite, ton problème, c’est que t’as acheté un écran 4K sans te poser la question de savoir quel prix t’aller devoir mettre dans le GPU. Et malheureusement, bah les contraintes industrielles sont ce qu’elles sont, et un gros GPU (taille physique du die) gravé en 7/8nm pour faire tourner de la 4K, c’est cher, car c’est difficile, c’est aussi simple que ca.

T’aimerais une carte à 1000€ pour 200€. Mais c’est juste pas possible. Si tu veux pas lâcher 1000€ dans une carte graphique, contente toi du FHD et basta.

Et au final, avec ta dernière phrase, je comprends toujours pas ta logique, car tu te plaint, mais tu travail et joue “dans de très bonne conditions” sur ta TV 4K. Il est où le problème?

Et pour info, Freesync et le DLSS de Nvidia, c’est justement ce qui permet de faire tourner des jeux gourmand dans de bonnes conditions pour compenser le manque de puissance brut.

Freesync: permet de lisser le rendu (tearing) sans avoir recours à l’archaïque vsync et ses contraintes

DLSS: en cas de drop de framerate, calcul un image dans une résolution plus basse et applique un algo d’IA plutôt bien foutu pour upscale à la résolution voulu. On perd légèrement en qualité, mais le résultat est la, ca tourne.

Donc oui, aujourd’hui le confort de jeu ne se base plus uniquement sur la perf brut, mais aussi sur les astuces sur le rendu (ce qui compte au final). Si t’en veux pas, c’est ton choix, mais essaye pas de réinventer l’histoire, les faits sont ce qu’ils sont et t’as beau l’interpréter comme tu veux, ca ne changera pas la vérité.

#95

Pour la deuxième fois : les configs HDG de l’époque, c’était 2/3/4 GPU, contre 1 seul aujourd’hui (le multiGPU ne sert plus qu’au calcul, nVidia a officiellement annoncé la fin des profils SLI).

A “perf équivalente” tu payes la même chose qu’à l’époque. En 2010 tu prenais mini 2 GTX580 pour jouer en FHD presque à fond pour un total de $1000 minimum. Soit le prix d’un GPU d’aujourd’hui pour jouer à de la 4K presque à fond. On s’y retrouve. Et si tu veux comparer au prix d’une GTX580 seule bah tu as la RTX3070 pour jouer en réglage moyen+, comme la GTX580 à l’époque.

Si on veut comparer le marché à deux époques différentes, il faut le faire correctement.

#96

On peut débattre de tout. Mais comme dit plus haut, débattre ne veut pas dire inventer des faits et penser qu’un avis peut être à même de tordre la réalité. Pour le reste, je suis plus gentil qu’agressif, mais je suis plutôt d’un naturel franc (avec tous les lecteurs : habitués ou non, abonnés ou non)

#97

Oui c’est bien de ça dont il est question :)

Qui a dit que je n’étais pas au courant quand j’ai acheté mon écran ? Ce que je disait simplement c’est que les GPU ne semblent pas avoir évolués suffisamment par rapport au reste, peut être parce qu’il n’y avait pas de compétition dans le haut de gamme. Bizarrement pour tous les autres composants PC on a pas eu ce problème, faut aussi se poser la question non ? Après les développeurs de jeux peuvent aussi s’adapter tout n’est pas la faute des concepteurs de GPU hein je dis pas ça.

Ok merci, tu peux presque rajouter “ferme la”, sympathique le débat. A nouveau tu es persuadé que c’est techniquement pas faisable de faire un GPU a 300€ qui saurait faire de la 4K dans les jeux récents, mais je pense de mon côté que s’il y avait plus de concurrence pendant ces 5⁄10 dernières années, on en serait peut être pas là. Il n’y a qu’a voir les évolutions de perf côté CPU avec les générations de Ryzen, les GPU j’ai pas l’impression que ça ai bougé autant.

Oui parce tu me répondais plus haut qu’un écran 4K n’est pas donné et hors de porté pour du gaming, ce qui est faux. C’est le GPU qui va avec qui est cher, pas l’écran. Et donc oui avec des jeux un peu ancien je joue parfaitement bien en 4K avec cet écran.

Quant à la comparaison Ferrari/écran 4K, faut être sérieux 2s… 400€ mon écran, c’est clairement pas du haut de gamme niveau tarif moniteur PC.

Sauf que perso le vsync off me dérange pas, quant a DLSS je n’en profiterai pas vu que je veux pas de carte nvidia car driver pas open source sous Linux. Mais oui je comprends ton idée, reste que DLSS n’est pas compatible avec tous les jeux donc ce n’est pas la solution parfaite.

J’ai pas dit ça. Voir plus haut, freesync j’ai pas la TV compatible mais rien de grave vu que sans vsync ça me va. Pour le reste des techniques j’ai jamais dit que ça m’intéressait pas, c’est juste que tu me parlais qu’il fallait un écran de jeu et un écran de bureautique “pour optimiser”, faudra m’expliquer la logique. Payer 2 écrans (sans compter l’aspect écologique de la chose), s’encombrer de 2 écrans, etc tout ça pour avoir un compatible freesync qui est dans une résolution plus faible (donc au final moins bien) ? Mouai.

Après je pense qu’on peut s’arrêter là, pour toi les prix sont normaux et les GPU ont évolués correctement, j’ai pas le même point de vue mais je cherche pas à te convaincre, tu as peut être raison.

#98

D’après ce test ça n’a pas l’air d’être le cas, une seule GTX580 suffit pour jouer souvent à plus de 60fps en FHD :

https://www.anandtech.com/show/4008/nvidias-geforce-gtx-580⁄15

Sans dire ça méchamment quand on avance des choses d’un ton sûr le mieux est de mettre ses sources, je ne remets pas en cause ce que tu dis mais du coup j’ai pas les mêmes chiffres quand je fais une recherche perso.

#99

J’ai dit que j’avais choppé un bench au pif sur Anandtech, tu viens juste de le linker :)

Donc si on regarde bien les benchmarks d’Anandtech (un peu en diagonale quand même on a pas le temps) on remarque que :

*les plus gros JV du moment n’atteignent pas le 60fps en FHD (“ça galérait à faire tourner les gros jeux en ultra à 60fps en FHD encore.”)

*les config en SLI sont communes dans le HDG (“En 2010 tu prenais mini 2 GTX580 pour jouer en FHD presque à fond”)

Je ne vois pas en quoi cela infirme mon propos et pas le tien.

#100

Tu as raison de dire en diagonale parce que si tu le lis correctement cet article, en FHD avec 1 seule GTX 580 :

Wolfeinstein : 112 FPS

Mass Effect : 85 FPS

DIRT 2 : 110 FPS

Stalker : 63FPS

BFBC 2 : 82 FPS

Civ 5 : CPU limited (précisé par l’auteur), donc aucun intérêt

Hawk : 172 FPS

Metro 2033 : 42 FPS (enfin un jeu sous les 60 FPS !)

Battleforge : 90FPS

Crysis Warhead : 57 FPS (oui le jeu mythique qui mettait à genoux tous les PC pendant des années)

Donc sérieux, si tu sais pas lire tes propres sources je peux plus rien pour toi. Tu es vraiment de mauvaise fois.