Au sein d’un livre blanc, Apple livre des informations sur la manière dont la chasse aux images pédopornographiques va s’intensifier sur iOS/iPadOS 15 et macOS Monterey, notamment à travers un mécanisme de recherche locale nommé NeuralHash.

Des rumeurs circulaient depuis hier. Le chercheur en sécurité Matthew Green avait publié plusieurs tweets sur l’arrivée probable d’un outil local permettant à Apple de repérer sur les iPhone, iPad et Mac des images à caractère pédopornographie pour prévenir les forces de l’ordre en cas de trouvaille.

Avant de plonger en détail sur cette mécanique – confirmée par Apple hier soir –, rappelons que des demandes sont formulées par ces mêmes autorités depuis des années. Comme l’indique Green, le chiffrement de bout en bout a envahi petit à petit de nombreux services sur les smartphones. Et si cette protection apporte un avantage très clair en matière de sécurité et de vie privée, elle a rendu certaines enquêtes bien plus complexes.

Le problème est connu et pousse depuis des années de nombreux représentants des forces de l’ordre et politiques à réclamer des portes dérobées (backdoors). On l’a dit et répété, ce type de demande ne peut qu’entrainer à terme une baisse notable du niveau de sécurité, car il est impossible de garantir qu’une telle porte ne sera utilisée que par les autorités compétentes. Tout pirate pourrait la trouver, engendrant des catastrophes en cascades.

Cette thématique pose depuis longtemps la question du curseur entre sécurité et vie privée. Le terrorisme et la pédopornographie sont souvent mis en avant pour justifier les demandes de portes dérobées. Le sujet ressort chaque fois qu’une entreprise fait une annonce sur le chiffrement de bout en bout, comme Facebook en 2019. L’entreprise avait alors confirmé que ses messageries seraient unifiées, mais qu’en plus elles seraient protégées par le fameux chiffrement. Le plan n’est toujours pas concrétisé, mais on se souvient des angoisses affichées par certains gouvernements devant une telle perspective.

En matière de lutte contre la pédopornographie, Apple arrive en fait un peu après tout le monde. Mais la position du constructeur, désormais très claire, fera tache d’huile.

L’analyse locale des empreintes d’images

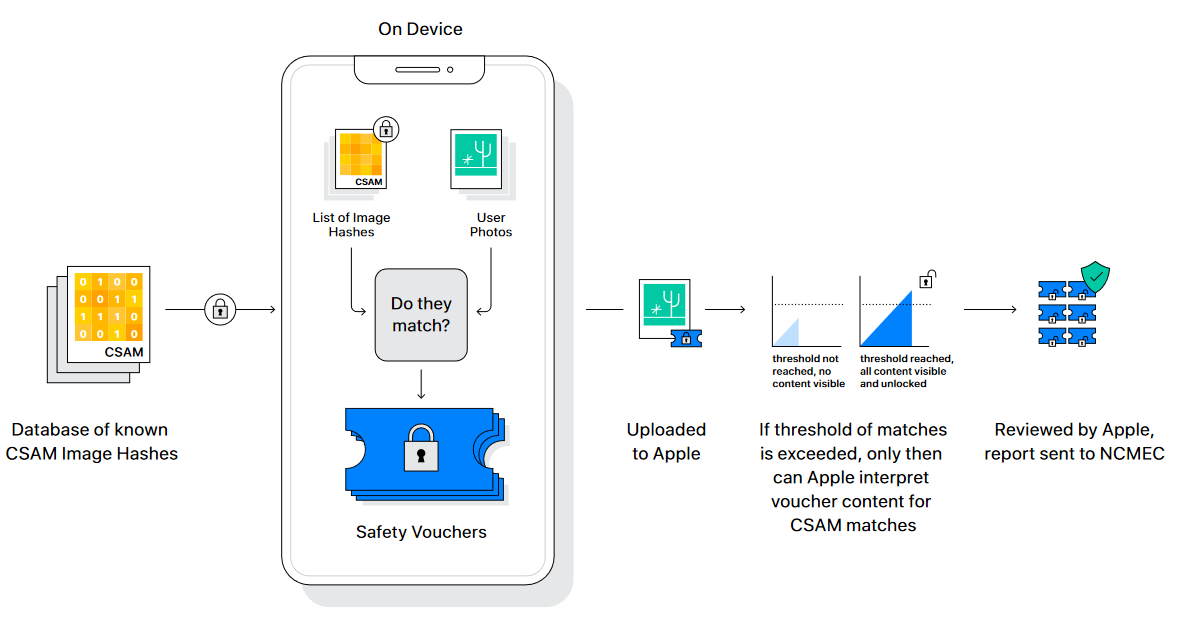

Dans son livre blanc, Apple a annoncé trois mécanismes. Commençons par le premier et le plus important : l’outil permettant de comparer localement les empreintes des images avec celles présentes dans une base de données. Un outil de type CSAM (Child Sexuel Abuse Material) spécifiquement conçu pour les nouvelles versions des systèmes que la firme publiera en septembre ou octobre.

La technologie d’Apple est baptisée NeuralHash. Son principe est simple : récupérer une base auprès du NCMEC (National Center for Missing and Exploited Children) qui permettra de vérifier que les téléphones, tablettes et ordinateurs de l’entreprise ne contiennent pas d’images marquées comme pédopornographiques. Cette base sera stockée de manière sécurisée et les utilisateurs ne pourront pas y accéder.

NeuralHash génère une empreinte volontairement « floue », de manière à repérer quand même des photos qui auraient été retravaillées, notamment recadrées. Changer les couleurs (par exemple passer au noir et blanc) ne modifiera pas non plus l’empreinte.

Pour chaque correspondance trouvée, le système génère un jeton cryptographique. Il va non seulement accompagner l’image lors de son ajout à iCloud Photos (nous y reviendrons), mais également être envoyé à Apple. Dans le livre blanc, la société indique ensuite qu’une fois un certain seuil dépassé (aucune précision n’est donnée), un employé sera chargé d’examiner manuellement les correspondances.

Il y a donc une visibilité des clichés marqués comme potentiellement problématiques. Apple insiste cependant : ne sont vues que les images identifiées comme pédopornographiques par NeuralHash, qui lui-même ne manipule que des empreintes, soit des suites de chiffres. De plus, l’outil serait très précis, n’aurait qu’un très faible taux d’erreur et serait bien plus respectueux de la vie privée que l’analyse des images sur les serveurs d’iCloud.

La mention d’iCloud est importante pour deux raisons. D’une part, Apple analyse déjà depuis des années les sauvegardes faites sur ses serveurs à la recherche de ces contenus. On savait déjà que les données ainsi mises à l’abri étaient inspectées, Apple étant en mesure de donner aux forces de l’ordre ce qu’elles demandent avec un mandat dûment délivré par un juge.

Pour rappel, l’affaire de San Bernardino avait provoqué la colère du FBI parce que le terroriste avait coupé iCloud et qu’Apple était dans l’impossibilité de récupérer les contenus locaux (le code PIN participe à la création de la clé de chiffrement).

D’autre part, NeuralHash ne fonctionne – pour l’instant en tout cas – que si iCloud Photos est activé. En somme, l’outil ne fait que rapatrier localement la capacité des serveurs. En cas de coupure d’iCloud, on revient à la case départ.

Précisons en outre que ce mécanisme ne sera dans un premier temps actif qu’aux États-Unis.

Peurs sur le potentiel de l’outil

Certains aspects de NeuralHash peuvent « rassurer ». D’abord le garde-fou de l’analyse a posteriori sur la base de clichés existants. Il ne s’agit pas de repérer, via du machine learning, des images potentiellement pédopornographiques. Ensuite la visibilité des seules images affichant une correspondance avec la base du NCMEC, ce qui signifie une vérification humaine avant signalement aux autorités.

Les autorités, justement, ont de quoi se réjouir. Il était reproché à Apple d’avancer à reculons dans un domaine où tous les grands noms de l’informatique sont impliqués depuis longtemps. Facebook, Google, Microsoft ou encore Twitter analysent tous les images transitant par leurs réseaux en vue de débusquer ces images.

Mais là où certains approuvent, d’autres déchantent. « Apple peut expliquer en détail comment son implémentation technique préservera la vie privée et la sécurité dans sa porte dérobée proposée, mais en fin de compte, même une porte dérobée minutieusement documentée, pensée avec soin et au ciblage précis reste une porte dérobée », pointe l’Electronic Frontier Foundation.

L’EFF se dit « très déçue » par Apple, qui était jusqu’ici une « championne du chiffrement de bout en bout ». Surtout, elle craint un glissement vers une utilisation abusive de l’outil, maintenant que la porte est ouverte et que le signal a été envoyé aux gouvernements, y compris ceux à la tête de régimes autoritaires.

Rien n’empêcherait alors un gouvernement condamnant pénalement l’homosexualité de détourner l’outil pour chercher des images incriminantes en vue d’une chasse aux personnes LGBTQ+. Même chose avec les images satiriques et autres éléments de protestation.

L’EFF rappelle que de tels détournements ont déjà eu lieu, par exemple dans le cas de la fameuse base de contenus « terroristes » à laquelle peuvent participer toutes les grandes entreprises tech. À la source de cette base se trouve un outil créé initialement pour repérer les contenus pédopornographiques.

« Les gouvernements vont le demander à tout le monde »

Cette peur est partagée par Matthew Green. Dans une série de tweets publiés hier, il revient notamment sur l’impossibilité de marier véritablement vie privée et sécurité, et la généralisation des analyses de données avant qu’elles soient chiffrées, y compris sur les terminaux (fixes ou mobiles). Une « surveillance décentralisée » et limitée à des empreintes, mais qui revient au même : « Oui, l’analyse côté client est meilleure que sur des images en clair et l’analyse sur les serveurs. Mais, dans une certaine mesure, la fonctionnalité est la même. Et sujette aux abus… ». Même son de cloche chez Edward Snowden.

On retrouve le point central dénoncé par l’EFF : « Quiconque contrôle la liste peut chercher le contenu qu’il veut sur votre téléphone et vous n’avez pas vraiment de moyen de savoir ce qui est sur cette liste puisqu’elle est invisible ». Quand bien même on obtiendrait cet accès, on ne récupèrerait qu’une liste de « nombres opaques ».

Le chercheur affiche plusieurs craintes, dont celle de voir le mécanisme s’étendre aux images chiffrées localement, même si iCloud Photos est désactivé. « Posez-vous la question : pourquoi Apple dépenserait autant de temps et d’efforts pour concevoir un système spécifiquement fait pour analyser les images existant uniquement sur votre téléphone, s’ils ne prévoyaient pas de l’utiliser en fait pour des données que vous ne partagez avec eux ? ».

Lui aussi craint le signal « très clair » envoyé par la firme : « Selon leur (très influente) opinion, il est bon de bâtir des systèmes pouvant scanner les téléphones des utilisateurs à la recherche de contenus prohibés. C’est le message qu’ils envoient aux gouvernements, aux services concurrents, à la Chine, à vous ». Il ne fait aucun doute pour lui que « les gouvernements vont le demander à tout le monde ».

Une protection dans iMessage quand il est utilisé par un enfant

Deux autres mécanismes sont prévus pour cet automne avec les nouveaux systèmes. D’abord une protection pour les enfants disposant d’un appareil compatible, quand les conditions sont remplies : avoir moins de 18 ans et un compte estampillé Famille. En clair, un appareil relié au compte des parents. Autre condition, mais qui devrait varier dans le temps celle-là : être un utilisateur américain.

Cette protection repose sur un algorithme de machine learning qui pourra détecter si l’image envoyée ou reçue entre dans la catégorie « sexuellement explicite ». Si c’est le cas et que l’enfant a moins de 13 ans, une notification sera automatiquement envoyée aux parents. Entre 13 et 17 ans, aucune notification ne sera envoyée.

Dans les deux cas, un avertissement sera affiché sur l’écran de l’enfant. Il devra décider s’il veut vraiment envoyer ou recevoir l’image, qui restera floue. C’est seulement en cas de confirmation que la notification parentale sera envoyée. Si cette étape est franchie, la photo ne pourra pas être effacée tant que les parents ne le feront pas eux-mêmes. Dans ce mécanisme, Apple ne voit pas les images.

Là encore, l’EFF se dit déçue. Apple a choisi de passer par du machine learning « notoirement difficile à auditer ». La technologie aurait, selon la fondation, fait la preuve depuis des années de sa capacité à générer des faux positifs. Or, aucun mécanisme de contrôle humain n’est prévu, même si le cas contraire aurait déchaîné les passions. On imagine les tensions familiales générées par des images faussement reconnues comme à caractère sexuel. Sans parler de la sensation, comme pointé par l’EFF, qu’ « Apple regarde par-dessus notre épaule ».

Difficile pour elle, dans ces conditions, de considérer qu’iMessage est toujours une messagerie chiffrée de bout en bout. Que l’analyse intervienne avant ou après le chiffrement des données n’est vu, pour l’EFF, que comme une « manœuvre sémantique » ne changeant rien au fond du problème.

Enfin, dernier mécanisme annoncé par Apple : Siri et la recherche dans iOS/iPadOS 15, macOS Monterey et watchOS 8 fourniront des liens pour rapporter des cas d’exploitation sexuelle de mineurs si l’utilisateur en fait la demande. Il s’agit davantage d’une rationalisation de l’information que d’une réelle nouveauté.

Progression de la sécurité contre régression de la vie privée

On peut s’en douter, les avis divergent fortement sur les annonces d’Apple. Même la communication de l’entreprise est sujette à débat. Il est probable que les explications aient été rendues publiques pour calmer d’avance les discussions passionnées qui ne manqueraient pas de suivre si la fonction était découverte autrement.

Finalement, c’est toute la campagne marketing d’Apple basée sur « Ce qui se passe sur votre iPhone reste sur votre iPhone » qui est à jeter aux orties. En intervenant directement sur l’appareil, Apple ne peut plus se prévaloir de préserver quoi qu’il en coûte la vie privée des utilisateurs sur leur téléphone.

Il n’est pas certain que la firme aurait pu maintenir cette position encore longtemps. On imagine aisément les pressions exercées par les gouvernements pour que l’entreprise ploie enfin devant leurs demandes. Difficile décidément de positionner le curseur quand le même appareil peut être utilisé pour des raisons autant légitimes que criminelles.

Mais d’un strict point de vue technique, c’est bel et bien une régression de la vie privée, alors que la société fait de cette dernière un argument fort de sa communication. Le journaliste Dan Gillmor n’y va pas par quatre chemins : « Cela trahit complètement les pieuses assurances de l’entreprise sur la vie privée. Ce n’est que le début de ce que les gouvernements demanderont partout. Toutes vos données seront des cibles légitimes. Si vous pensez autrement, vous êtes définitivement naïfs ». Le chercheur en sécurité Alec Muffett, interrogé par le Financial Times, parle de son côté de « mouvement tectonique ».

Apple occupe une place à part dans l’industrie technologique. Ses choix sont surveillés et de nombreuses entreprises suivent ses mouvements comme autant de directions à prendre en compte, au minimum. Qu’une telle société, avec son historique particulier sur la vie privée, bascule dans la recherche de contenus sur les appareils n’a pas fini d’inquiéter. Les autres répondront que c’est une immense victoire dans la chasse aux réseaux d’échanges d’images pédopornographiques.

Commentaires (119)

#1

J’espère qu’ils vont avoir un retour de bâton aux US, la fonction d’alerte pour les mineurs qui envoie des images c’est une chose, mais NeuralHash c’est clairement du vol potentiel de photo privée.

Si NeuralHash fait une erreur, par exemple des photos privées de toi et ton conjoint/conjointe, il y aura en fin de course un type de chez Apple et NCMEC qui vont voir cette photo.

J’espère en tout cas que ça n’arrive jamais en Europe ce truc.

#1.1

Le risque n’est pas dans les faux positifs, il est clairement dans la base de données comme l’indique l’article : pas de risque pour vos photos intimes mais attention demain à des tracts de protestation contre un gouvernement autoritaire.

#2

Je ne sais pas trop quoi penser de ce truc.

Je n’y ai pas cru quand j’en ai entendu parlé la 1ere fois il y a qq jours et je prenais ça pour une rumeur.

Force est de constater que ce n’est pas qu’une rumeur et même si les détails d’implémentation ne sont pas mal, le principe même est très inquiétant.

Je ne comprends pas la stratégie d’Apple sur ce coup… C’est tellement à contre-sens de ce qu’ils essayent de construire depuis des années

T’as pas bien lu l’article visiblement… le fonctionnement de la techno se trouve même dans son nom…

#2.1

J’ai bien compris qu’il utilise le hash de l’image dans la base de donnée et qu’en théorie tu ne peux pas faire d’erreur de cette maniere mais jusqu’a preuve du contraire, modifier une photo, par exemple de couleur à noir / blanc, va modifier le hash, pourtant leur sytème fait toujour le lien, c’est du bulshit donc, il y a bien une analyse qui va plus loin que juste le hash.

#3

Espérons juste que ce soit annulé ou tous du moins qu’apple annonce éventuellement pourquoi ce déplacement du scan (exemple, photo chiffrée sur leur serveur donc scan sur l’appareil).

Mais il est sur qu’il ne pourront juste pas faire l’autruche sur cette histoire.

Loins de moi l’idée de faire le moralisateur du 20e siècle, mais ce genre de photo devrais se trouvé sur un appareil dédié (photo) ou tous du moins sur une machine n’ayant aucun accès a internet (si on veux être sur qu’elle ne fuite pas), car rien ne prouve qu’ils (Google Apple & CO) n’ont pas déjà accès a toute les information du téléphone et l’ont juste bien caché (peut probable mais pas impossible).

Edit:

En effet, mais un bug est envisageable (exemple inversion des photo fautive/innocente suite a une erreur dans un if etc).

#4

Et au prochain attentat islamiste, qui permettra d’ailleurs le passage du pass sanitaire au pass citoyen/républicain/laïcité, Apple fouillera vos données pour être sûr que vous n’êtes pas un méchant complotiste radicalisé.

La question ici c’est de quel droit Apple fait elle la police ?

Je ne paie pas Apple pour faire la police dans mon smartphone.

J’aime bien la direction totalement full-police que prend notre civilisation des lumières. Confiance nul part, surveillance partout. C’est bizarre parce que ceux qu’il faudra surveiller, on ne les surveille pas (genre Macron & co). Et ceux qui factuellement n’ont rien à se reprocher, on les suspecte et on les surveille.

A quel moment Apple fouillera-t-elle iMessage pour censurer les messages jugés complotistes (quand vous dites que les vaccins sont expérimentaux par exemple) ?

J’ai besoin de l’info pour prévoir à peu près le temps et le budget pour retourner à des téléphones + libres.

#5

Pareil, j’ai du mal à suivre leur logique pour le coup (sans compter le côté potentiellement dangereux du truc)

Et pourtant il y a énormément de trucs qui circulent via les machines connectées. C’est LA raison qui fait que je refuse catégoriquement d’être un jour un noeud TOR (à moins que le fonctionnement n’ait changé, quand on est noeud, on sert aussi de cache pour les autres. Et il est impossible de savoir ce qui est stocké dans le cache), d’ailleurs. Bien trop dangereux.

#5.1

C’est HS mais je te rejoins pour TOR. Sur des fils de discussion du libre on me dit que non j’ai rien compris blablabla, mais quand tu regarde, chaque PC d’utilisateur sert de nœud ou de relais. Alors j’ai vite appris qu’être pour l’open source c’est bien différent d’avoir des valeurs ou des principes (beaucoup veulent juste tout gratuitement, et téléchargent à gogo), mais pour moi TOR revient à louer ta chambre à un mac et dire que tu sais pas ce qui se passe, c’est pas tes affaires.

Pour le reste, la fonction pour les mineurs c’est super bien. Pour le reste je suis mitigé. Je ne suis pas du tout pour la protection de ces gens, mais un truc qui check tes photos (voir plus) voilà quoi. Et ceux qui disent qu’il y’a aucun risques, que c’est juste ceux qui ont rien compris, Snowden à déjà réagit dessus. Pourtant je pense qu’il à compris la techno. Après c’est pas le messie hein, mais bon…

#6

Oui mais que les gens qui stocke leur photo intime dans leur téléphone ne se plaignent pas si elle fuite ou sont scanner, si on joue avec le feu parfois on se brûle et ça fait très mal.

#6.1

Je ne suis malheureusement pas sûr que les utilisateurs aient une éducation/sensibilisation suffisante sur le sujet. Il n’y a qu’a voir certains de nos politiques qui font joujou avec leur kiki en filmant avec leur téléphone portable.

#7

Il n’y a pas un projet ou une étude à l’UE pour faire un truc dans le même genre(scanner tous les espaces numériques) afin de traquer les contenus pédopornographiques? )

)

Il me semble avoir lu un article sur le sujet (je vais bien passer pour un con si c’était sur NXI

C’est quand même franchement inquiétant de constater l’apparition de ces manières de faire au prétexte de lutte contre la pédopornographie/terrorisme (après ce n’est plus une nouveauté depuis très longtemps).

Nous sommes en train de perdre la liberté et la sécurité.

#8

La cohérence occidentale : on veut scanner les contenus numériques de tout le monde pour dénicher des pédophiles, quand on refuse d’inquiéter les pédophiles lorsqu’ils sont au pouvoir ou lorsqu’ils sont potes avec Epstein.

#9

#10

J’ose imaginer que les tests seront assez sérieux pour éviter des bugs aussi évidents et aussi énormes sur les use cases de base

#11

C’est vraiment chaud cette histoire. J’attends de voir où ça va mais perso je réfléchis au pire à revendre tout mon matos Apple (mais c’est clair que ça va être demandé à tout le monde), au mieux ne plus rien acheter chez eux. Et pourtant je suis bon client.

#12

#13

Est-ce que ce n’est pas prendre le problème à l’envers ? En remplaçant “téléphone” par “album photo”, la situation change beaucoup : l’album photo est considéré comme un bien privé. Pourquoi devrait-il en être autrement de nos appareils, fussent-ils connectés ?

Au delà de tout cela, effectivement, cela confirme bien que nos appareils ne sont plus à nous … Et malheureusement, je ne crois pas qu’il existe beaucoup d’alternatives ?

#14

Car un album photo n’est pas copier automatiquement dans une bibliothèque gigantesque d’un bâtiment Apple du coup d’attendre à 0 fuite dans ce contexte est une hérésie en soit

#15

(reply:1889586:Wingi)

Passé les librem 5 et les pinephone (si ils sont épargnés) en effet ça va devenir compliqué de conserver une souveraineté sur nos données perso. Ou au prix d’un sacrifice technologique important, voir même social*.

*par exemple avec le 3615 mylife: heureusement que l’appli tousanticovid n’est pas obligatoire, je n’ai pas les gapps sur mon téléphone.

#16

Outre les diverses craintes et interrogations évoquées ici dans l’article et les commentaires, j’ajouterais que cela signifie que le smartphone va devoir utiliser des datas & de l’espace de stockage pour récupérer & stocker la base NeutralHash… Certes ce sont des hashs, mais j’imagine qu’ils seront plus lourd que 256 ou 512 octets, et j’imagine que ladite base officielle doit être … volumineuse, malheureusement.

#17

Tu n’as vraiment rien lu de l’article en fait…

#17.1

ou que tu ne comprend pas ce que je dis

Mon probleme c’est qu’on comprend par les indication d’apple qu’ils envisagent dans un nombre de cas tres faible qu’une analyse manuel par un employé soit naicessaire, je vois pas commment on peut justifier qu’un type dans une boite privé puisse avoir accès aux images.

“Pour chaque correspondance trouvée, le système génère un jeton cryptographique. Il va non seulement accompagner l’image lors de son ajout à iCloud Photos (nous y reviendrons), mais également être envoyé à Apple. Dans le livre blanc, la société indique ensuite qu’une fois un certain seuil dépassé (aucune précision n’est donnée), un employé sera chargé d’examiner manuellement les correspondances.”

“Using “threshold secret sharing,” Apple’s “system ensures that the contents of the safety vouchers cannot be interpreted by Apple unless the iCloud Photos account crosses a threshold of known CSAM content,” the document said. “Only when the threshold is exceeded does the cryptographic technology allow Apple to interpret the contents of the safety vouchers associated with the matching CSAM images.”

“While noting the 1-in-1 trillion probability of a false positive, Apple said it “manually reviews all reports made to NCMEC to ensure reporting accuracy.” Users can “file an appeal to have their account reinstated” if they believe their account was mistakenly flagged.” Source ArsTech

#18

Donc si j’en déduis en ayant essayer de comprendre après avoir lu l’article.

Apple génère à partir des photos sur l’appareil un hash flou/à précision modérée de façon à avoir des hashs identiques pour des photos similaires. Principe du réseau de neurone qui reconnait un chat même si la photo est tronquée/a l’envers/avec une colorimétrie zarbi.

Ensuite il compare ce hash avec ceux stockés localement sur l’appareil.

Vu le nombre de photos ciblées qui circulent, la base de hash ne doit pas être minimale, même si la taille individuelle des hash reste probablement faible en raison de la précision voulue précédemment.

Donc on compare avec des photos déjà identifiées.

J’ai quand même dans l’idée que les principales cibles de ce scan ne se trimballent pas avec des photos connues sur leur appareil, mais avec des photos fraiches prises justement avec l’appareil.

Donc à moins que le scan fasse de la reconnaissance, avec tout les biais possible et imaginable, je vois pas trop comment cela va être efficace pour débusquer les possesseurs de photos ?

#19

Le but étant justement de 1 prendre en flags les moins instruit et remonté les nids de ces salle eaux (faute volontaire).

Pour ce qui est de la base de hash je suppose qu’elle fonctionneront comme le safe browsing, version minimal du début des hash et téléchargement complet des hash commencent par la meme chose en cas de potentiel détection.

C’est dommage cela dit qu’apple ai pas annoncé un iCloud/iCloud photo & backup E2E coté serveur, cette annonce serait devenue “moins négative” car la perte due au scan auraient été largement contre balancée par celle gagnée niveau privacy.

#20

Comme ça les gens iront vers des services de cloud zéro-knowledge. Ils poussent les gens toujours plus loin dans la sécurité 🤭

#21

En soit je n’ai pas de réel problème avec ça car le contexte est plutôt carré. Contrairement à ce que peut laisser entendre le titre, il ne s’agit pas de pull, mais bien de push. Cela ne fonctionnera que si l’user a activé l’upload (push) sur iCloud.

Et c’est là où je tique : concrètement ça veut dire que ça ne permettra d’attraper que les individus qui, non seulement sont en possession de photographies connues, mais en plus décident de les uploader sur iCloud. Autant dire de sacré idiots.

Sans remettre en cause le bienfondé de la lutte contre la pédo-pornographie, on a l’impression qu’Apple sort l’artillerie lourde pour seulement quelques individus pas très malins.

Et pour ce faire, ils ouvrent une porte très problématique sur la vie privée de millions d’utilisateurs.

Résultat je ne vois pas comment il ne pourrait y avoir une quantité bien plus importante de faux positifs (avec potentiellement des conséquences désastreuses) que de criminels réellement attrapés.

#21.1

Comment le système va t il repérer des photos du couple Macron / Brigitte ?

Si les utilisateurs de ce genre de photos ne sont pas punis, ce truc ne sert à rien.

#22

Je ne dis pas le contraire, mais y’a plus de chance que j’ai des photos des gamins des voisins ou d’inconnu(e)s prises dans le parc que des photos récupérées sur le net et donc identifiées/identifiables.

Donc sans scan d’analyse mais juste un scan de comparaison des photos, je crains que cela ne sorte que le menu fretin. C’est déjà çà, on est d’accord.

Mais ça ouvre une porte à d’autres utilisations qui me semblent dangereuses.

dsl, je suis pas doué pour les citations croisées.

#23

Les photos intimes, ce n’est pas ce qui me gêne. Par contre me retrouver dans une situation compliquée parce que mon noeud a mis en cache des photos pédopornos sans que je n’en sache rien…

(Et la situation d’Apple ici est dangereuse, elle peut très facilement amener à des dérives graves)

#24

J’en conviens, pour le cas d’apple c’est pour ca que je trouve dommage qu’il ai pas déployé le E2E coté serveur pour poussé cette “nouveauté”, car les gains aurais été supérieur au perte.

Pour tor je vais plus loins j’ai activé le DPI de ma Dream Machine pro pour intercepté et envoyé a /dev/null la totalité du traffic tor.

#25

Apple, chantre du respect de la vie privée.

Évidemment :

J’emploie volontairement le futur sans mise en doute, car ça me paraît 100% évident que ça va se passer comme ça.

#26

Sinon, qu’en pensent Danny la pastèque, Duhamel, Finkielkraut et autres ???

#27

ou pas … personne ne connais l’avenir et dire cela se passera comme ca est une preuve d’extreme dans les idée apple = mal et autre = bien, le monde n’est que nuance de gris.

De plus le CSAM est non étatique … et ne fait aucun profit, la ou les liste terroriste sont gouvernementale, je me demande meme si les hash des fichier pédo sont meme pas open source dans certaine liste (on a juste (et heureusement) pas les images de base).

Donc je demanderais des preuve de cette affirmation a 100%.

Car plusieurs d’entre nous sont des “moutons” apple comme tu le dit si bien et pourtant on est (dans certain cas ni contre ni pours et dans d’autre totalement contre) ce qui démontre que ton 100% sur vaut pas grand chose au final.

#27.1

Des preuves du futur ?

??

On me disait pareil il y a 1 an quand on avait prédit le pass sanitaire, puis son extension. “Y’a plein de gens contre, ça n’arrivera pas”. Mouais.

Ici c’est juste de la logique. Quand tu crées une brèche, ça s’engouffre derrière. Surtout sur un sujet comme ça qui a l’a double caractéristique d’être reclamé par les états depuis longtemps, et d’être un cheval de Troie notoire pour d’autres sujets.

Allez pour te faire plaisir : pas sûr à 100%, mais 99%

#27.2

Oui, mais la pédopornographie ce n’est pas contagieux. Tu ne peux pas la refiler à quelqu’un sans qu’il ait rien demandé.

#28

rapport entre un traçage d’un vaccin contre un virus mortel dans certain cas et un scan de hash d’image pédo ?

Car hormis tombé dans le biais d’intention (ou intentionnalité) et de partir du principe que les autres veulent nous controlé, je voit vraiment pas …

Preuve du future ? Exact y’a donc aucune preuve ce n’est donc que pure spéculation.

#28.1

de la speculation certes, mais avec beaucoup d’historique derriere. Il a dit justement que plusieurs choses passee pour de la lutte contre la pedopornographie ont ensuite ete etendues a d’autre domaines.

Quand au pass tu lui fais dire ce qu’il n a pas dit.

Il a juste dit qu’il avait predit l’instauration d’un passe sanitaire et de l’extension de son domaine d’application ensuite. Il n’a jamais parle de vaccin.

qu’on parle de maladie ou de pedo porno, c’est le meme principe au fond. on introduit quelque chose avec un but A qui est ensuite etendu a B, C… etc etc parce que la mecanique est deja en place et que pourquoi s’en priver.

Apres moi ca m’agace que mon tel scanne mes photos meme si “personne” ne regarde, parce que ca sera ensuite scanner mes emails, mes sms, puis pourquoi pas foutre un keylogger… c’est a peu pres ca qu’il denonce comme derive.

C’est comme pour la vitesse qui tue en voiture. ca me fait chier qu’on depense un pognon monstre en radar pour une efficacite derisoire et qui emmerde tout le monde.

Si la vitesse est tellement un probleme, on equipe toutes les voitures avec des limiteurs avec GPS qui appliquent la bonne vitesse max, comme ca plus personne ne peux aller plus vite que 30 en ville.

#28.2

C’est pas un biais d’intention mais une certitude : les autres veulent nous contrôler. En particulier les États, c’est pas comme si ils ne communiquaient pas là dessus plusieurs fois par an depuis des années, voire en menaçant de manière à peine voilée les Apple et consort, cf affaire San Bernardin et bien d’autres.

Si tu refuses cette évidence là, même pas la peine de me répondre.

Sinon oui, quand on parle du futur on ne peut que spéculer, ça aussi c’est tellement evident que je ne vois même pas pourquoi le relever, c’est intrinsèque à la notion de futur. Demander des “preuves” du futur c’est soit idiot, soit un procédé rhétorique malhonnête (mais qui ne trompe personne de sensé).

Sinon je viens de relire tes messages. En fait toi tu as lu mon post comme “Apple = mal”, alors que rien a voir que ce soit Apple. OSEF, le sujet est ailleurs. De là à y voir du fanboyisme mal placé de ta part, c’est un pas que je ne franchirai pas, bien évidemment …

Enfin si, en y réfléchissant le fait que justement ce soit Apple est significatif en fait : si même eux qui basent leur stratégie com sur le respect strict de la vie privée en viennent là , ça donne une idée assez claire sur ce qu’il risque fort (à 99% donc, mais spéculation désolé, j’ai perdu mon tarot et ma boule de cristal) de se passer.

#29

J’ai plutôt compris qu’au delà d’un seuil, le contrôle se fera sur la photo, et pas le hash, qui lui est testé automatiquement.

Je crois qu’Apple a abusé du hash

#30

On prend toujours les régimes autoritaires en exemple. Mais cela permet surtout aux “pays gentils” d’utiliser ces fonctionnalités…

Sinon, qu’est-ce qui empêche un pédo de supprimer ce contenu de son appareil, et de désactiver son icloud ? Je suppose quand même qu’ils font un minimum gaffe, donc quand on annonce une techno qui peut les démasquer, je ne vois pas comment ils pourraient ne rien faire.

#31

ok je vais pas parlé de ca plus longtemps t’es baisé de base via une théorie du complot des méchants qui veulent nous controlé

#32

Bah tous les pédo sont pas technophile donc pas tous au jus de l’update

#33

Ah ouais. Complotiste direct.

Bravo. On a un gagnant là, mais pour être honnête je m’en doutais à ton premier post.

Sentiment confirmé par ta conjugaison hasardeuse. Un verbe qui finit par -é, ca peut être une coïncidence. Mais deux en moins de 3 lignes, c’est un champion. Et je ne parle meme pas des autres posts.

Effectivement, cesse donc de parler. Si pas d’écrire.

#33.1

Avec certains intervenants, souvent des saints Thomas, on est vite catalogué comme complotiste quand on évoque des tendances difficiles à prouver sans une enquête sectorielle nécessitant plusieurs années… C’est la mode ce mot juste pour diminuer et discréditer l’idée du discours, sans parler de l’incompréhension des problématiques abordées. Bref, le bashing et le brainwashing ont de beaux jours devant eux.

#34

Quel que soit le but et la manière de faire, ça fait quand même grandement tache par rapport à la ligne de com d’Apple en ce moment…

#35

ad hominem classique… en meme temps venant d’une personne qui pense que “ils” (indéfini et sans preuve) veulent nous controlé …

#35.1

Tu me traites de complotiste et tu t’attends à des bisous ?

Apprends à écrire correctement déjà, ça va souvent de pair avec penser correctement.

Hint : un verbe du premier groupe ça finit par -er, pas par -é.

Au moins, je te dois l’honnêteté de reconnaître que complotiste, tu l’as écrit correctement à défaut de savoir ce que ça signifie. Comme l’argumentum ad hominem.

#36

Quand est-ce que vous allez cesser d’être un mouton à répéter des erreurs au lieu de vous cultiver bordel ?!

(On ne dit pas argumentum ad hominem mais argumentum ad personam) dans le cas que vous pensez l’utiliser.

L’infinitif, ça te parle pas ?

Errare humanum est, perseverare diabolicum

#37

A aucun moment, ils parlent de regarder les photos…

#37.1

Faut-il t’encourager à relire l’article, te mettre en gras ce qui t’échappe «Il y a donc une visibilité des clichés marqués comme potentiellement problématiques. Apple insiste cependant : ne sont vues que les images identifiées comme pédopornographiques par NeuralHash, qui lui-même ne manipule que des empreintes, soit des suites de chiffres.» ou bien simplement considérer que tu es un fanatique de la marque et de ce fait, tu ne comprendras jamais qu’elle fasse l’objet de critique(s) ?

#38

L’avantage du PinePhone (et du libre en général) est qu’on peut changer l’OS comme de chemise en quelques minutes. Et comme ceux-ci ne sont pas basés sur une dépendance du terminal à un système centralisé détenu par un acteur hégémonique, peu de risques qu’ils soient un jour touchés par ce genre de dangereux système.

Et si ça venait à arriver, les forks pour le retirer se mettraient à pleuvoir. Un peu comme les navigateurs basés Chromium qui retirent une bonne partie des Googleries de ce dernier.

Mais bon, ce sont des entreprises qui nous veulent que du bien pour nous faire vivre dans le meilleur des mondes, donc y’a pas de risque qu’il y ait de dérive.

#38.1

Ha bin j’avais pas fait attention sur les os possibles sur les pinephone, mais déjà de base on a le choix entre plusieurs OS.

En fait dans ma réaction de mon dernier post ce n’était pas l’entreprise (enfin les entreprises) qui me posait questions, mais les législations qui peuvent tomber sur ces entreprises (avec les prétextes habituels).

Par contre l’idée des kill switches, c’est top !

#39

#39.1

Je suis pas du tout expert, mais il me semble. Chaque utilisateur devient un maillon de la chaine. J’avais également entendu dire que tu pouvais pénalement être tenu responsable de ce qui passait sur ton réseau. Si c’est vrai, sur TOR ça fait bobo. On l’utilise pas pour aller sur Youtube…

Bon après j’y connais rien, mais justement, tant que je comprend pas le truc je préfère pas trop y toucher. Oui, je fais l’inverse des “militants” actuels…

#39.2

Si vous voulez parler de TorBrowser, non, l’utiliser ne fait pas de votre ordinateur un relais : https://community.torproject.org/relay/

#39.3

J’aime énormément ton avatar

#40

ouais attaque l’orthogafe (oui je le fé esprit) car tes a kour d’argument

#41

la politesse visiblement ca te parle pas non plus mais bon

#42

Parce que “prouve moi le futur” et “sale complotiste” ce sont des arguments, peut-être ?

“Bouh tu me fais remarquer que J’emploie des mots latins que je ne comprends pas et que j’ai le niveau de conjugaison d’un eleve de CM1 raté. T’es méchant c’est pas poli”

Effectivement des arguments d’une telle qualité, j’en manque. Mea culpa.

#43

L’intention est louable. Sauf que c’est une énorme porte ouverte à une dérive insidieuse sans aucun rétro contrôle de l’utilisateur.

Aujourd’hui nos smartphones ne nous appartiennent plus. Le pire c’est que cela fait tâche d’huile… Windows semble suivre le même chemin.

On achète des appareils parfois très cher mais le système d’exploitation nous traite comme si tout lui appartenait.

Aujourd’hui cela me choque au point de me dire que plus tard il faudra que je m’intéresse à Linux et de bien compartimenter l’usage de mon smartphone vu que je suis incapable de maîtriser ce qu’il fait dans mon dos.

#44

Pourquoi ne pas t’y intéresser dès maintenant ? Pourquoi attendre que les choses empirent ?

Vraie question.

#45

Pourtant il a clairement raison, ca fait qques temps que tu vires clairement complotiste, en mode “ILS sont partout, ILS veulent nous surveiller” (sans jamais qualifier précisément les ILS en question)…

#45.1

Attends t’es con ou bien ?

Quand je dis ils, c’est évidemment des États dont je parle, comme dit plus haut. J’ai écrit “en particulier les etats” ou je ne l’ai pas écrit ?

Alors, petit cours de français : “en particulier”, c’est une qualification. Pas de ma faute à moi si vous sautez un mot sur 2 de ce que vous lisez.

Donc toi tu affirmes sans trembler des genoux qu’il n’y a pas, dans le monde, une volonté de contrôle accrue des états depuis qques temps, utilisant toutes les possibilités technologiques à leur portée. Sérieux ?

Question directe : nies-tu ceci ?

Vous devenez tous débiles c’est pas possible : dès qu’on pointe un problème, quand bien même il est evident, on est complotiste.

#45.2

D’accord avec toi. Ca leur fait toujours du bien de traiter les autres de complotistes tout en niant l’évidence, droit dans leurs baskets.

Fouiller dans mon téléphone, quel qu’en soit la raison, c’est pour moi une violation de ma vie privée. Pour qui se prend Apple pour aller voir ce qui se trouve dans mon téléphone? Ils se prennent pour la police mondiale de la bien-pensance? Même notre police françiaise n’a pas le droit de le faire, et c’est pour de bonnes raisons, présomption d’innocence, respect de la vie privée, …

Je suis vraiment déçu du move d’Apple. J’étais naïvement content de me dire qu’Apple prenait le problème au sérieux et était intransigeant (vs Google). Et bien plus maintenant…

Ce qui fait peur, c’est qu’il n’y a aucune prise de conscience des gens en général. J’ai beau prêcher la bonne parole dans mon entourage, leur expliquer le plus succinctement et clairement possible, même a des amis “technophile”. Ils ne nient pas, juste s’en foutent.

Avec un peu de recul, j’en conclu que leur problème, ça n’est pas de sacrifier de la liberté pour de la sécurité, mais de sacrifier du confort pour de la liberté.

Le plus triste, c’est de voir que sur NXi, malgré les articles chaque semaine sur la surveillance, les backdoor, les magouilles politiques, l’espionnage étatique, il y ai des gens ici qui pensent que tout ça, c’est pour notre bien et nous traite de complotiste.

#45.3

“Avec un peu de recul, j’en conclu que leur problème, ça n’est pas de sacrifier de la liberté pour de la sécurité, mais de sacrifier du confort pour de la liberté.”

Terriblement juste…

#45.4

J’oubliais, le raisonnement par l’absurde n’est pas bien toléré non plus. Comme si les problématiques devraient abordées tout le temps de la manière la plus rigoureuse.

C’est un peu drôle quand on sait que les grosses découvertes sont le fruit du hasard (cf. colle de la société 3M pour les Saint Thomas) ou par des autodidactes qui ont suivis leurs intuitions en tâtonnant (cf. Thomas Edison).

#46

Outre cette mesure inquiétante sur le principe, profitons-en pour démystifier un mythe : Tous les pédophiles ne sont pas des monstres, la plupart des personnes ignorent que beaucoup d’entres eux ne passent jamais à l’acte, les agressions sexuels sur mineurs sont majoritairement commises par des personnes adultes n’ayant pas d’attirance physique pour des corps prépubères, la raison est que les enfants sont des proies faciles, c’est très étroitement lié au sadisme, pas à la pédophilie. Si certains ne maîtrisent pas leurs pulsions et passent à l’acte, beaucoup d’autres sont juste des personnes terriblement seules, qui vivent volontairement en marge de la société et qui en souffres.

#46.1

Merci.

C’est du bon sens, mais méfies toi quand même : de nos jours, avec ce genre de discours, on est vite taxé de complotiste pedo-friendly.

Mais sinon non, peu de gens ignorent ce que tu décris, simplement comme ça ne va pas dans le sens de leurs idées, ils l’eludent (“ils” qualifiant les gens qui ne l’ignorent pas, pour Patch) tout simplement. C’est une réaction humaine à une forme de dissonance cognitive.

#46.2

Sans compter que cette histoire navigue sur les réseaux de dangereux complotistes (pizzagate) alors que la plus grande partie agissent au sein même de leur famille.

Cela donne l’impression que l’on sort l’artillerie lourde pour tuer une mouche (je ne minimise pas les cas, je dis hélas que c’est tout juste la partie émergée de l’iceberg) et laisser le gros du sujet de côté.

Tiens, quitte à faire un truc pour les enfants, une réflexion pour que certains puissent facilement signaler leurs propres abus.

#47

Je serais moins affirmatif, il faut de sacrée ressources pour remplacer toutes les googleries et les flux de données qui partent de Google grâce à Chromium ou ASOP.

Le projection /e/ n’a pas encore enlever toutsles éléments de Google et les nouvelles versions d’ASOP font de plus en plus appel aux serveurs de Google pour l’IA.

Je pense que seule des grosses entitées comme Samsung, MS & Co peuvent réussir à épurer Chromium et ASOP des éléments de Google qui peuvent s’avérer être des mouchards. Mais c’est souvent pour mettre leur mouchards à la place!!

Bref il faudrait une version EU, RGPD friendly avec une vrai volonté politique pour produire un ASOP et un Chromium dénué de GAFAM et de mouchard.

#47.1

J’ai indiqué “une bonne partie”, pas toutes ;)

Concernant Chromium, Vivaldi en dégage pas mal : cf. ce post au sujet de la version Android), un autre de 2017 expliquait les deux seuls cas où il se connecte aux serveurs Google, désactivables aussi. Evidemment, FloC a été retiré aussi de Vivaldi, ils ont fait partie des premiers à le communiquer.

Concernant AOSP, c’est hors sujet pour le PinePhone. PostmarketOS est basé sur Alpine Linux et sinon il peut aussi accueillir Manjaro. Même UBPorts qui était basée sur le kernel Android (héritage d’Ubuntu Touch) dispose du sien désormais il me semble.

#48

Concernant cette nouvelle mesure, dans l’absolue, je ne suis pas contre le contrôle et le retirement d’images pédopornographiques, c’est aussi du bon sens, à condition qu’elles illustrent des victimes réelles (un dessin ne compte pas) mais des techniques inadéquates, qui manquent de rigueurs techniques et scientifiques sont utilisés, de plus, comme l’a dit un membre dans les commentaires précédant, cela concernera d’après ce que j’ai compris, uniquement ceux qui auront uploader leurs images connues dans iCloud, en résumé, une mesure qui ouvre une brèche sur la vie privée d’un tas d’utilisateurs de iOS pour cibler une poignée d’individus, mais en fait, c’est juste le principe de la surveillance de masse, ce n’est pas bien différent de la surveillance des URLs et des communications électroniques (heures d’appels, à qui, quand etc) pour la prévention du terrorisme (officiellement). Affaire à suivre.

#49

J’ai un peu le même sentiment d’un point de vue général, ils le savent, mais la commodité à trop pris le dessus et je peux le comprendre, cela favorise l’addiction à un produit, surtout quand il est efficace et répond aux besoins.

Les smartphones sont anti-privées presque par conception, je l’ai déjà écrit ici, mais pour avoir de la sécurité ET une vraie bonne protection de sa vie privée, la seule solution véritablement viable est de prendre un Google Pixel puis de flasher CalyxOS ou GrapheneOS, CalyxOS est l’option la moins brutale, GrapheneOS est le plus sécurisé mais aussi le plus radicale.

#50

J’adore les gens qui viennent dans un espace commentaire, qui est censé servir à débattre d’un sujet, et qui expliquent au gens que s’ils ne sont pas d’accord avec eux ce sont des débiles…

Vous ne voulez pas débattre, vous voulez juste imposer votre point de vue.

Sinon, plutôt que de pointer les fautes d’orthographes/conjugaisons de tes interlocuteurs, y a un moment où tu avances des preuves sur le fait que le gouvernement a envie de savoir ce que j’ai bouffé la veille, où je suis allé hier soir, dans quel resto, avec qui, qui j’ai pris en photo, qui j’ai appelé, à qui j’ai envoyé un SMS, etc ?

Pour l’instant tes “preuves” se résument à :

Donc, pour pouvoir débattre avec toi, il faut forcément qu’on accepte comme une évidence que le gouvernement cherche à avoir un contrôle total sur nos vies. Si on n’est pas d’accord avec ce point tu refuses de débattre.

On en revient donc au point mentionné au début de ce post : tu ne veux pas débattre, tu veux imposer ton point de vue et refuses toute contradiction.

#50.1

Je suis quelqu’un de modéré et j’essaye toujours de tempérer ou de remettre la balance au milieu pour privilégier la réflexion. Mais dans le cas présent, il n’y a pas de débat à avoir. On en est où de l’état d’urgence vis à vis du terrorisme? La loi renseignement? On en est où des boites noires? La loi sur la sécurité globale? Tant de mesures injustifiées et complètement disproportionnés.

Le problème n’est pas de savoir si notre gouvernement, ou le prochain, sache ce que t’as bouffé ou chié hier soir, mais de voir la mise en place d’outils techniques et légaux pour qu’un gouvernement puisse le faire d’un claquement de doigt sans aucune justification.

#51

Si j’ai bien compris, Apple va scanner tous les fichiers stockés en local sur les Iphones et les Macs pour vérifier que ce ne soit pas du contenu pédopornographique. Ils ont beau enrober ça avec leur histoire de hash en expliquant qu’aucun humain ne verra le contenu des images scannées (sauf celles positives), je trouve ça plus que moyen comme manière de faire.

Sans compter que je rejoins l’avis des précédents commentaires sur l’efficacité réelle de cette fonction.

Ça me paraît un brin disproportionnée comme mesure.

C’est comme si on scannait le courrier de tout le monde pour trouver des terroriste…

Je suis curieux quand même de voir comment cette nouvelle fonctionnalité va être acceptée par la communauté Apple.

Mais quand je vois une de mes amies, qui s’est étonnée de voir que Androïd lui affiche tous les jours un montage photo de plusieurs photos tirées de sa galerie, galerie qui s’est automatiquement synchronisée avec le cloud de Google, mais qui au final s’en fiche un peu que toutes ses photos soient envoyées automatiquement sur les serveurs de Google, je me dis qu’il ne va pas y avoir tant de grogne que ça.

#52

Le PinePhone (et les autres produits de Pine64) fait partie des rares appareils à être entièrement open source pour le coup, les specs et plans du SoC et des composants sont eux aussi disponibles.

Par contre, forcément, il est encore loin d’être prêt pour un usage quotidien. Surtout qu’il est principalement low-cost et que ses perfs sont anémiques.

Mais l’alternative aux grands constructeurs / éditeurs d’OS existe. Elle est a encore du chemin à faire, mais elle est là, et perso, je la soutien.

#53

Apple va chercher des contenus pédopornographiques dans les iPhone américains …

…pour l’instant !

‘c’est plus !!!

!!!

#54

Je suis assez d’accord, c’est pour ca que (dans mon cas) j’aurais préféré qu’il annonce un End-to-End sur les iCloud photo coté serveur, au moins ca aurais expliqué le “pourquoi” il font ca, apple pourrait dire “on fait ca pour améliorer votre vie privée sur nos serveur”, mais la annoncé ca sans réel contre partie ca me parait étrange comme action de leur part.

edit: mais bon d’un autre coté j’ai que des photo de famille sur iCloud, mes photo borderline ou totalement intime sont stockée sur un disque hors ligne (car si hors ligne au moins ca risque pas de se faire hack), donc ca me concerne, mais pas au point de crier a l’anti apple, car Google, microsoft & co le font depuis des années sans l’annoncé, au moins apple l’a annoncé et nous a pas pondu la fonction en mode fufu.

#54.1

“Apple” pourrait dire : “on fait ça pour améliorer votre vie privée sur nos Serveur”…

heu..

je ne suis pas sûr ‘de ce que j’ai compris’ ?

#55

Disons que l’avantage d’apple sur le coup c’est la sécurité avancée qu’on les outils apple, par exemple l’Apple Watch est plus sécurisée que la majorité des montre connecté (full encryption + secure boot + bluetooth a connection chiffrée etc) sans la moindre interaction de l’utilisateur dommage que toute les alternative open source veulent tellement être ouverte qu’elle préfère oublier ces mesure de sécurité. (par défaut j’entend).

bah oui ils ont raison les autres sont des moutons ou font partie du système avec le grand méchant gouvernement qui cache des chose (quand on voit qu’un président sait pas caché ses activité extra conjugale (hollande) ou un président américain qui se fait une jeune, un complot mondiale sans aucune preuve) ? la bonne blague.

#55.1

Comparer des histoires de cul, dont une belle majorité adore les détails croustillants, à de l’influence de masse par des puissants, extrêmement plus diffus (cf. Les industriels du tabac vs la nocivité de la nicotine pour les êtres humains en inhalation active et passive, pour les saints Thomas), ça frise la malhonnêteté intellectuelle.

#56

Et ?

#57

Habituellement je réserve ma position dans ce domaine.

Mais là je suis tout de même assez inquiet. C’est clair que la notion de vie privée ne veut déjà plus dire grand chose, et demain, ne vaudra strictement plus rien.

Le pire sans doute, c’est le sacrifice de cette vie privée sur l’autel du business, puisque les concepteurs puis fabricants et ensuite les vendeurs, n’hésitent pas à vous dire n’importe quoi pourvu que vous achetiez.

Aujourd’hui c’est “ce qui est dans votre iPhone reste dans votre iPhone” (ce qui ne voulait rien dire en fait, mais admettons), demain c’est “faites ce que vous voulez, parmi le catalogue des choses acceptables que nous vous proposons”.

En fait lors de l’arrivée sur le marché de ces produits, la plupart d’entre nous n’en avions ni le besoin, ni l’envie immédiate de l’acquérir. A force de nous inventer des trucs tous plus indispensables les uns que les autres (et tout ce petit monde qui gravite autour des produits de cet univers, afin de gagner sa vie - dont NextInpact au passage …), nous succombons désormais quasiment tous à l’illusion de l’utilité numérique quotidienne.

Et nous allons bien nous y perdre, réduit peut-être à l’état d’automates, mais certainement orientés par des algorithmes tout azimut.

L’homme augmenté dont rêvaient les pionniers du monde cyber, sera en fait un homme ajusté, aseptisé, normalisé.

#57.1

Et oui, bienvenue dans le monde du tout connecté…

Ce qui m’a toujours étonné c’est de constater à quel point des gens qui sont toujours prêts à “gueuler” à la violation de la vie privée et à la surveillance vont se répandre sans limite sur les RS et confient leurs données personnelles (peu importe lesquelles) à des serveurs dont ils ne savent rien, ce fameux “cloud”. Ils se croient très protégés car ils ont coché quelques cases, c’est pathétique…

On ajoute à ça cette frénésie sur l’utilisation des objets connectés que si tu ne demandes pas à Google, Apple ou Amazon d’allumer tes chiottes ou de surveiller le contenu de ton frigo, c’est que t’es complètement “has-been” .

Et oui mais ça c’est pas de la surveillance, c’est juste le progrès !!

On ajoute à ça cette impatience qu’ont plein de gens d’avoir des véhicules entièrement autonomes qui seront forcément plus que surveillés mais là, bien sûr, ça ne sera que pour notre bien n’est-ce pas…

Et ouais les gens, dès qu’on fout les pieds sur internet (dont je ne nie pas du tout l’intérêt) on est fliqués… Faut juste en être conscient et essayer dans la mesure du possible de ne pas “offrir” plus que ce qu’on vous demande et ça c’est loin d’être le cas pour une immense majorité d’utilisateurs qui ne manqueront cependant pas de gueuler à la dictature et à la surveillance pour tout et surtout pour rien…

Perso, sur mon smartphone (forfait minimum B&Y), le trafic de données est désactivé car il ne me sert que pour téléphoner et quelques SMS et certainement pas à naviguer sur internet. ça met pas à l’abri de tout mais ça limite un peu les risques , enfin je crois.

#58

Mon commentaire était ce sur j’aurais voulu qu’il fasse pas ce qu’il ont fait

#58.1

ouf !

#59

Justement ça prouve qu’il sont incapables de garder des secrets

#60

Je me suis arrêté là. Insulte dès la 1ere phrase : le reste ne vaut pas la peine d’y perdre son temps.

Assez comique de qqu’un qui reproche aux autres de faire dans l’ad personam (et pas hominem qui ne veut rien dire)…

#60.1

T’as raison, arrête toi sur la forme. Le fond, c’est pour les complotiste.

#60.2

LOL.

C’est surtout pratique pour ne pas répondre quand on te fait remarquer, citation directe à l’appui, que tu ne lis que ce qui t’arrange, ce qui te fait écrire des âneries.

Confirmé justement par ton post : si tu avais lu plus d’un mot sur 2, tu aurais pu voir que justement je ne reproche pas l’ad personam à mon contradicteur, mais que c’est lui qui me le reproche à moi.

Mais bon, lire tous les mots d’un texte de 10 lignes c’est déjà compliqué : les mettre en ordre dans sa tête ensuite, c’est bon seulement pour les complotistes apparemment.

Ce post n’étant pas insultant, go answer now please.

#60.3

avec, toutes ces expressions, ( laquelle est la bonne ? )

on ne sait plus quoi dire, alors, je m’abstiens !

#61

Oui, dans mon cas j’ignore tout commentaire qui dans l’ordre (sans dire que j’ai raison ou quoi):

Par contre j’utilise hominem, simplement car 2 fois sur 3 j’oublie personam du coup vaut mieux un truc qui vaut rien dire (mais se faire comprendre), que tenté d’expliqué ce que je veux dire avec des mots flou.

#62

Ca c’est parce qu’ils veulent te contrôler et te font perdre la mémoire à chaque fois pour mieux y arriver

Quand ca insulte, il n’y a ni forme, ni fond : juste des insultes. Quand ca insulte, c’est qu’il n’y a strictement que du vide derrière. Donc aucun intérêt de continuer.

Si tu es maso au point d’aimer te faire insulter, tant mieux pour toi. Mais ce n’est pas le cas de tout le monde, loin de là…

#63

Il est forcément plus facile d’intégrer tous ces éléments quand tu maîtrises tout la chaîne de valeur de ton produit, Apple étant fabriquant et développeur du software c’est donc évident qu’ils puisse se permettre de faire tout ça.

Ceux de Pine64 sont fait pour des développeurs et bricoleurs, comme Raspberry, c’est donc logique qu’ils soient ouverts à l’extrême pour permettre justement à ce public d’y construire les solutions. Le publicet la finalité ne sont absolument pas les mêmes. Pour rester sur l’exemple de la montre connectée, la PineTime est proposée à ce titre en deux versions : une unitaire scellée pour l’étanchéité (celle que j’ai) et un kit de dev comprenant cette même version et une non scellée pour permettre l’accès aux interfaces de debug. Le fabricant avertissant justement d’éviter de chercher à flasher le firmware de la version scellée car le risque de brique est élevé. (et la démonter compromet évidemment l’étanchéité)

Développer sur une boîte noire me paraît assez compliqué, c’est tout le problème qui a existé (et existe encore) depuis des années sur les soucis de compatibilité de certains hardwares avec Linux faute de spécification ouverte. Le travail se faisant alors par rétro ingénierie, comme pour le pilote graphique libre Nouveau par exemple.

Je ne suis pas spécialement d’accord avec le propos disant que l’open source oublie par défaut la sécurité… Elle est incluse dedans, mais libre à l’intégrateur de l’exploiter. Il ne faut pas voir l’open source comme une entité pensante unique comme l’est une corporation. C’est un ensemble de projets qui communiquent plus ou moins entre eux (évidemment quand ils sont maintenus par une entreprise ça aide à une meilleure cohérence) et charge à l’intégrateur d’en tirer le meilleur parti.

Par exemple, le fabricant allemand Tuxedo Computers (chez qui j’ai acheté mon PC Pro) propose ses machines avec une distribution Linux maison basée sur Ubuntu qui est nativement fournie avec disque chiffré et autres mécanismes activés par défaut. Tout comme dans la famille Red Hat tu vas te retrouver avec SELinux en mode actif par défaut et qui bloque tout ce qui sort des clous. (et quand je vois des tutos qui disent de le désactiver au moindre soucis, j’ai envie de les brûler)

Ce sont des visions totalement différentes qui ont chacune leurs avantages et inconvénients.

#64

Oui désolé je me suis mal exprimer, j’entendais par la que je trouve dommage que quand l’utilisateur obtiens le produit en mains toute ses technologie de sécurité (obligatoire chez apple (et bientôt microsoft)) ne soit pas forcément activée par défaut, il est possible d’être ouvert ET sécurisé (voir Fedora ou tout autre linux avec secure boot) mais même ces linux plus sécurisé que les autre n’intègre toujours pas (par exemple) l’utilisation de la puce tpm2 pour le stockage des clefs de chiffrement.

C’est ce qui m’a personnellement poussé chez apple, toute les technologie sont obligatoire et activée (sauf firewall et chiffrement) par défaut sur leur machine de manière simple (un clic) et ne risque pas de cassé a chaque update (voir les tpm qui casse après une update linux etc), c’est ca que je regrette de la concurrence open, oui c’est possible de le sécurisé pareille mais c’est pas fait par défaut.

#64.1

Je ne suis jamais intéressé au sujet des puces tpm2 donc j’éviterai de trop en dire dessus pour éviter les conneries. Cela dit, en regardant vite fait, j’ai vu des tutos expliquant comment les utiliser sur de la famille Red Hat.

Et vu qu’ils parlaient de CentOS 7, ça signifie que le support semble déjà assez “ancien” (c’est une mamie qui a bientôt 10 ans) mais j’ignore le degré de maturité à ce sujet. J’ai vu d’autres articles évoquant la possibilité d’utiliser ces puces pour le chiffrement du filesystem avec LUKS.

Après on en revient à la maîtrise de la chaîne de valeur.

#65

Est-ce qu’on pourrait être plus clair : quand on dit « désactiver iCloud », on entend absolument TOUT iCloud ou bien uniquement la partie Photos qui synchronise la bibliothèque d’images ?

#66

Faut juste se demander pourquoi les discussions stratégiques internes ont abouti à penser que ça devenait plus rentable pour la boîte, i.e. les actionnaires, de ne plus défendre cette ligne.

La communication n’a que pour but d’essayer de vendre ce que l’entrepise pense qu’elle peut te vendre.

La sensation d’appartenir à une élite, certains diraient une secte, permettait déjà de gonfler les prix.

ça va être intéressant de voir le comportement de la fanbase apple tradi : va-t-elle se révolter ? Va-t-elle trouver un moyen de justifier ça “pour le bien” comme biais cognitif standard ?

Car hormis des débats de spécialistes, il y a fort à parier que cela aura peu d’influence sur les ventes en tant que telles immédiatement.

#66.1

C’est assez juste.

Mais j’ajouterais (TW : complotisme), le cas San Bernardino ayant mis en lumière une négociation (un bras de fer à peine voilé, plutôt) avec le FBI et les autorités américaines en general sur les questions de backdoor à usage “judiciaire” (gros guillemets), qu’il s’était intéressant de savoir à quelle hauteur cette donnée là a joué dans la décision.

Mon sentiment profond (TW : spéculation) c’est plutôt qu’en faisant ça, Apple s’est dit qu’il gagne sur tous les tableaux : c’est un joli argument marketing qu’on pourra utiliser quand nécessaire, c’est raccord avec la stratégie d’Apple de mettre le focus sur la famille, ca calmera les autorités un peu, et qu’effectivement comme tu le sous-entends, la base d’acheteurs n’étant pas technophile mais plutôt sensible aux arguments relatifs au confort, ça passera relativement inapercu.

Sachant qu’en plus, argumenter contre une mesure supposement antipedophile est extrêmement glissant, au regard de la profonde émotivité sous-jacente, peu de gens se risqueront à critiquer ça frontalement.

Bref, gros gains potentiels avec peu de risques : tout benef .

#67

N’exagérons pas.

Ne pas offrir plus que ce qu’on nous demande ? C’est à dire ?

Le trafic de données ? Les données mobiles je suppose ? Je ne suis pas sûr que le désactiver change réellement quelque chose, si tu es soucieux de ta vie privée, tu ne devrais pas utiliser les SMS sauf si tu n’as pas le choix pour une raison x ou y, utilise Signal. Si tu veux un bon navigateur sur Android avec protection contre les empreintes digitales et adblocker intégré, je te conseille Bromite, sur iOS, Brave.

#67.1

Ce que je voulais dire c’est que dans notre monde tel qu’il est, c’est à dire entièrement basé sur le fric, le vrai “gratuit” n’existe pas ou alors à titre très exceptionnel.

Donc si on nous propose des services sans rien demander en échange c’est tout simplement parce que on nous prend beaucoup en contre partie sans rien nous demander non plus et “à l’insu du plein gré” de ceux qui veulent ignorer ça…

Si facebook pèse près de 1000 milliards de dollars en valeur boursière, ce n’est pas vraiment du hasard…

Et non, Zuckerberg n’est pas un philanthrope, c’est fou non ?

Je parle de facebook mais c’est vrai pour tous les services soi-disant “gratuits” qu’on peut trouver sur internet.

Comment peut-on encore douter de cette évidence ?

#68

Je terminerais en disant que c’est donc à chacun de mesurer le ratio “bénéfices/risques” mais passer son temps à gueuler à l’atteinte à le vie privée, ça ne sert pas à grand chose quand on est plus ou moins consciemment complice de ces pratiques…

#69

Etre connu et donner à quelques associations / aides humanitaires est un bon point de départ pour être déclaré philanthrope par les médias, peu importe ce que tu fais à côté.

Je suis d’accord que râler constamment à l’atteinte à la vie privée ne sert à rien, tout comme compter sur des lois comme le GDPR n’est pas suffisant, prenons en exemple les fenêtres de l’enfer pour la gestion des cookies, soyons honnête, l’intention est bonne mais ça ne fonctionne pas, c’est chiant et selon comment le site est configuré, refuser les cookies ne change rien, la seule approche que j’ai vu et qui me semble viable est quand le site refuse les cookies tiers par défaut et que l’utilisateur n’a rien à modifié, c’est le cas pour le traducteur en ligne Deeplr.

#70

Est-ce le fait que j’ai mis utilisé le mot « bordel »pour exprimer mon agacement qui te choque ou bien de te reconnaître comme mouton ?

À mon sens, la première des politesses est de réfléchir avant de poster sur un forum comme celui-ci.

#71

Tu ne veux sans doute pas voir à quel point c’est comique, car j’ai t’ai connu volontairement injurieux. Un petit coup d’oeil à ton historique tant à montrer que ta nouvelle résolution est très récente.

Ainsi qui a écrit le 30 juin 2021 : Rassure nous : tu fais exprès de jouer au grand débile, non?

Tu as en effet une prédilection pour le mot «débile». Dans le sud de la France, le mot «débile» doit être une plus grande insulte que «con» pourtant. Comme quoi tu ne veux voir ce que tu veux bien voir (ou non).

Ainsi, tu te permet d’insulter des millions de personnes pour leur foi.

Remarquons au passage que tu ne cible pas les deux autres religions monothéistes qui ont le même dogme de ce côté là…

Quand elle viennent de toi les invectives lié au caca présumé deviendraient miraculeusement respectables…

Des comme ça tu nous en a pondu foultitude, je m’arrête là, comprenne qui peut comprendre, merci pour le franc sourire que m’a inspiré ton soudain revirement à la volonté de courtoisie quand Drepanocytose te pose une question à laquelle tu ne souhaites pas répondre.

#72

Amuse toi à sortir les dossiers si cela t’amuse pendant ce temps t’arrêtera de poudre des âneries visiblement y’a vie doit être vraiment fun pour remonter l’historique des gens (ou avoir 0 arguments)

#72.1

Décidément vous n’avez aucun honneur et aucune honte.

Merci pour votre démonstration de tartuferie.

Les arguments tu ne veux surtout pas les voir.

Tous les technophiles savent que monde Apple est une prison dorée.

Récemment un ami a voulu me transmettre une photo en bluetooth, mais ça ne fonctionne qu’entre les appareils Apple…

La suite est déjà écrite, après le sujet du jour ce sera la recherche d’activité «terroriste» etc, puisque l’appareil reste finalement la propriété d’Apple.

L’idée de confort a gagnée sur l’intelligence, qui nécessite des efforts, elle.

La masse préférant croire qu’elle obtient celle-ci facilement en achetant un appareil à tout faire…

#73

Votre commentaire est encore une fois une démonstration flagrante que vous n’avez pas lu/compris l’article, et que vous ne comprenez rien a l’informatique en générale.

Appeler quelqu’un pour régler votre magnétoscope au lieu de remonté l’historique des gens et dire n’importe quoi sur des forum sensé être visité par des gens qui s’y connaisse un minimum en technologie.

#73.1

Et ça se plains des attaques “ad hominem” :)

J’achète, encore stp !

#74

Tu ne serais pas Nadine Morano en vrai dit ?

Je te demande ça parce que ton honnêteté et tes facultés intellectuelles sont convergentes avec ce personnage.

Montre nous encore que tu n’as aucune conscience de ton ridicule !

#75

Ce n’est pas comme si les gouvernement de nos démocraties (ou pas) ne nous avait pas habitué à la promulgation de Lois scélérates..

C’est comme le la lutte contre le terrorisme, la lutte contre la pandémie, la lutte contre…

Le motif est toujours indiscutable (encore que, ira t-on jusqu’à la lutte contre la Mort?) mais l’application entraine des dérives et aucuns des Etats ne revient en arrière une fois l’adoption de mesures pourtant liberticides (et évidement temporaire…).

Je pense qu’il faut vraiment envisager de pouvoir se retirer sur une ile sans connexion au Net (un LAN sera parfait) en petit comité (<1000 pers.) parce que les grands ensembles créent en réalité de la tyrannie.

#76

J’espère qu’elle ne s’appellera pas Waco

#76.1

Suis pas un gourou..

#77

1°) Il n’y aura jamais assez d’îles pour tout le monde.

2°) Il faut que ce soit très inférieur à 1000, car comme l’a dit Brassens, “sitôt qu’on est plus de 4 on est une bande de cons”…

3°) La démographie démesurée de l’humanité est incontestablement son plus gros problème ainsi que celui des autres espèces animales ou végétales.

Quoi qu’il arrive, la planète s’en sortira toujours au moins jusqu’à ce que le soleil prenne la grosse tête.

#77.1

Pas faux! J’escompte que tout le monde ne partage ce plan que je viens de rendre public..

#78

C’est de Desproges, le sketch c’est “Gardez Sakharov”…

Edit… oui, brassens, le pluriel… je l’avais oubliée…

#79

N’oublie pas la consommation électrique, l’usure du téléphone et la consommation de données.

Ca n’est pas facturé à Apple ni à autre que toi.

#79.1

Faut pas deconner, ils ne vont quand meme pas depenser pour espionner alors qu’ils peuvent glisser la facture au client