L'intelligence artificielle est sans aucun doute une technologie d'avenir qui soulève de nombreuses questions, mais aussi des craintes. Dans tous les cas, la France compte être un des moteurs de son développement et le gouvernement lance ainsi des groupes de réflexion à travers son projet « France IA ».

Ce matin, le gouvernement organisait une conférence de presse afin de lancer son projet « France IA ». Il s'agit de définir « les orientations stratégiques de la France dans le domaine de l’intelligence artificielle ». Comme nous avons déjà eu l'occasion de l'évoquer à de nombreuses reprises, cela touche de très nombreux domaines, avec d'importants débouchés, mais aussi des problématiques liées à l'exploitation des données.

La France veut être présente et Thierry Mandon tire la sonnette d'alarme

Avec plus de 200 start-ups recensés dans le domaine de l'intelligence artificielle, la France veut continuer à jouer un rôle important... mais aussi éviter une fuite de ses cerveaux et entrepreneurs à l'étranger. Thierry Mandon explique d'ailleurs que la recherche « est en grand danger » et qu'aujourd'hui, les centres français « sont pillés ». « Leurs chercheurs sont débauchés par des sociétés qui ne sont pas françaises et qui ont le bon goût de ne pas payer d'impôt en France » tonne-t-il.

Sans être directement cité, on lit entre les lignes qu'il est notamment question de Facebook. Pour rappel, fin 2013, le réseau social a justement recruté le français Yann Le Cun comme directeur pour son laboratoire de recherche sur l'intelligence artificielle.

L'intelligence artificielle, entre fantasmes et peur

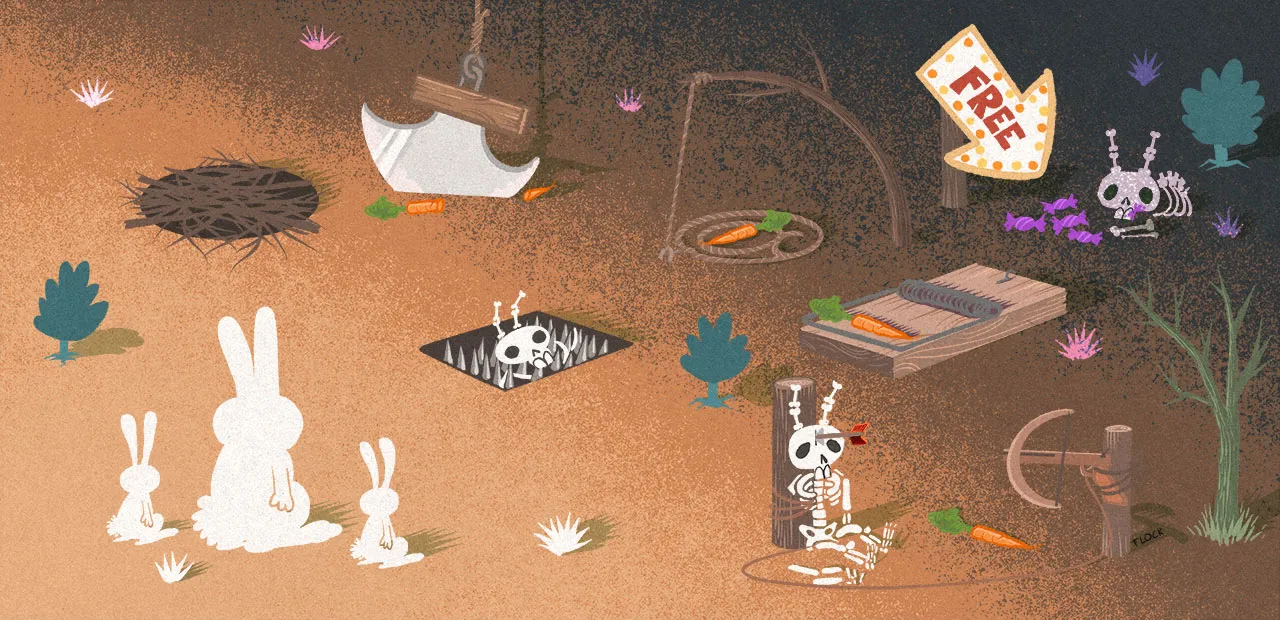

Pour entrer dans le vif du sujet, notre confrère Jacques Henno explique qu'autour de l'intelligence artificielle, il y a « toute une série de fantasmes et de peurs, sur les robots tueurs ». Derrière cette idée, deux concepts : symboliques d'abord avec des risques sur les emplois, et plus terre à terre ensuite avec les armes.

Mais, comme le résume Axelle Lemaire un peu plus tard durant la conférence, « l'intelligence artificielle en soit, ce n’est pas bien ou mouvais, c'est une technologie et comme tout outil ça dépend de ce qu'on veut en faire ». Un sujet que nous avions déjà largement abordé dans nos colonnes.

Une crainte largement plus présente en France qu'aux USA

La secrétaire d'État au numérique et à l'innovation souhaite justement que la France continue à jouer un rôle de locomotive : « l'intelligence artificielle est là, elle va se développer avec un potentiel extraordinaire ». Mais elle rappelle également que c'est un sujet sensible. Elle cite ainsi une étude (sans aucune précision) selon laquelle « 65 % des Français ont peur de l'intelligence artificielle », contre seulement 22 % des personnes aux États-Unis.

Isabelle Falque-Pierrotin, la présidente de la CNIL était également sur place, et rejoint Axelle Lemaire sur la préoccupation des Français. Dans un sondage demandé à Ipsos, mais qui ne sera dévoilé que lundi prochain à l'occasion du premier grand débat sur les algorithmes (qui sera diffusé sur YouTube), elle explique qu'il ressort « des chiffres un peu préoccupants ». Lesquels ? Il faudra attendre la semaine prochaine pour le savoir...

La délicate question des données (personnelles)

Il y a au moins une raison à cela : « les données c'est le cœur de l'IA » rappelle la présidente de la Commission nationale de l'informatique et des libertés. Pour rappel, afin d'apprendre à reconnaitre un objet dans une image, il faut qu'une intelligence artificielle dispose d'une base de données de plusieurs millions ou milliards d'images de référence. Dans le cas de Facebook par exemple, les photos que vous publiez sont une aide précieuse et surtout... gratuite pour le réseau social.

Mais qui dit données, dit également informations personnelles. Rand Hindi, entrepreneur et membre du Conseil National du Numérique, ne s'en cache pas : pour que les assistants numériques fonctionnent correctement, il faut qu'ils aient « accès à un maximum de données sur la vie des gens ». Néanmoins, il ajoute rapidement cela ne veut pas dire qu'il faut pour autant laisser complètement tomber sa vie privée. Par exemple, les données pourraient très bien être traitées localement sur les machines.

Le chiffrement homomorphe à la rescousse

Et ce n'est pas tout, il est également possible de « faire du machine learning sur des données chiffrées récupérées de plusieurs utilisateurs différents ». Cette technologie porte d'ailleurs un nom : le chiffrement homomorphe. Ainsi, chaque utilisateur peut envoyer des données chiffrées qui servent de base pour des calculs, sans avoir besoin d'être déchiffrées pour cela.

Au-delà du traitement des données (chiffrées ou non), Jean-Louis Fréchin, designer numérique et fondateur de NoDesign.net, explique qu'il faut ouvrir « la boite noire », c'est-à-dire laisser accessibles les algorithmes afin que chacun puisse vérifier comment les données sont utilisées. Plusieurs géants du secteur ont d'ores et déjà commencé à ouvrir leurs algorithmes... mais pas leurs données, qui sont pourtant le carburant des intelligences artificielles.

Attention à la « bêtise artificielle »

Si la donnée est la base de base de l'intelligence artificielle, Laurence Devillers, professeur d'informatique et membre du CNRS, explique que cette matière première qui peut engendrer « des dégâts énormes » suivant l'utilisation qui en est faite. Il faut ainsi bien s'assurer que les données soient neutres et n'induisent aucun biais dans les algorithmes. De l'intelligence artificielle, on peut facilement se retrouver à « faire de la bêtise artificielle » lâche-t-elle.

Se pose également la question de l'éthique de l'intelligence artificielle, un sujet déjà abordé avec la problématique du choix des victimes par une voiture autonome en cas d'un accident mortel (voir cette actualité). Isabelle Falque-Pierrotin rappelle que ce débat n'est pas simplement franco-français : « tous les pays sont en train de toucher du doigt » cette question, « on a un fil rouge vraiment mondial sur cette question de l'éthique de l'intelligence artificielle et des algorithmes ».

En guise de conclusion de cette partie sur la présentation de l'intelligence artificielle, Jean-Louis Fréchin explique que « même s'il y a des risques, il faut y aller ». Il sera d'ailleurs rejoint par Thierry Mandon en fin de conférence : « Il faut y aller maintenant, sinon ça sera trop tard ». France IA est justement là pour établir un plan de bataille.

Sept groupes de travail sur l'intelligence artificielle

Afin de déblayer le terrain, sept groupes de travail ont ainsi été annoncés, chacun centré sur un sujet précis :

- Établir une cartographie nationale des activités en intelligence artificielle

- Identifier et définir la priorisation des sujets de recherches

- Identifier et définir les priorités sur les besoins en formation

- Préparer l'industrialisation de l'intelligence artificielle (mettre en relation les centres de recherche et l'industrie)

- Développer l'écosystème de l'intelligence artificielle en France

- Définir les règles de souveraineté et de sécurité nationale

- Anticiper les impacts macro-économiques et sociaux, notamment sur les emplois

Comme on peut le voir, il s'agit principalement d'organiser les différentes institutions (publiques et privées) autour d'un projet commun : l'intelligence artificielle. David Sadek, qui préside le premier groupe, explique que « quand on veut livrer bataille, il faut faire l'inventaire de ses forces ». Une manière de présenter sa mission principale (cartographier l'IA en France), mais qui peut facilement s'étendre à l'ensemble de ce projet.

Notez que des regroupements plus petits seront également de la partie afin de plancher sur des sujets plus précis. Il est notamment question des véhicules autonomes, du monde de la finance, de la relation client, etc. Rien n'est définitif et des ajustements peuvent être faits si nécessaire.

Un rapport sera présenté fin mars

Ces groupes devront rapidement rendre leur premier bilan puisque la fin des travaux est prévue pour le 14 mars 2017. Le 21 mars aura lieu une réunion du comité d'orientation afin que les responsables de groupes puissent présenter leurs conclusions. Enfin, le 28 mars sera le jour de la remise du rapport. Il sera alors temps de faire le point sur les propositions qui seront faites.

Commentaires (31)

#1

C’est quand même plus dangereux que la création d’une machine lambda. Il s’agit ici de munir une machine d’un libre arbitre.

#2

Un de mes rêves c’est de mettre Sky Net au monde.

#3

#4

Ou, c’est plus des machines à deviner ce que cet idiot d’humain veut qu’autre chose pour la plupart. Pour ensuite te proposer ce que tu voulais vraiment. On peut appeler ça simplifier les ihm.

Le libre arbitre, c’est encore vague pour une IA.

#5

Comme ça a été dit avant moi on en est pas encore là (mais peu importe car ça viendra, effectivement).

Cependant, ça n’est pas plus dangereux que mettre au monde un être humain qui pourra potentiellement devenir un tyran coupable de génocide, cela étant une loi naturelle, le débat n’existe pas mais la problématique au fond est la même.

#6

#7

#8

#9

#10

C’est pourtant bien une comparaison que tu fais en parlant des limites de l’un et de l’autre, mais là c’est de la sémantique.

Après, on peut débattre sur la notion de risque (il y a par exemple le potentiel de nuisance et la probabilité que ça arrive). De mon côté je pense que le potentiel de nuisance est le même (un humain pourrait tout a fait avoir le pouvoir d’anéantir l’espèce humaine) en revanche effectivement, une machine suffisamment intelligente et autonome pourrait certainement y arriver plus facilement si elle le souhaitait.

Il y a cependant énormément de “si” dont certains relèvent de la philosophie et qui ne trouveront probablement jamais aucune réponse, encore moins si l’on essaie pas. Une IA, générique, reste une technologie beaucoup plus neutre que la bombe atomique par exemple. Refuser les IA ou vouloir les brider très tôt, c’est comme si la recherche liée à la nature de la matière avait été stoppée avant la découverte de l’atome, histoire d’être sûr de ne jamais mettre au point la bombe A; ça n’a pas de sens.

Considérant l’état de l’art tel qu’il est aujourd’hui, ça relève encore du débat assez creux, il faut encore avancer pour en discuter différemment; et je trouve ça bien que ça fasse d’ailleurs partie d’une certaine façon des missions de FranceIA.

#11

Je parlais de la reproduction en tant que loi naturelle, pas du génocide évidemment.

Encore que, c’est plus une question philosophique qu’autre chose dans la mesure ou l’homme est bel et bien une création de la nature, désolé.

Mais je comprends bien que l’idée sous-jacente est qu’un génocide prémédité n’est pas une catastrophe naturelle au sens où on l’entend.

#12

Tu oublies les fourmis

#13

#14

Un algo de machine learning qui te classifie une image et te dit si c’est un humain ou pas utilise grossos modo les mêmes principes d’apprentissage que l’être humain. La seule chose qui change, c’est l’échelle des connaissances acquises et du “cerveau” utilisé pour faire l’opération. Mais à la base, c’est bien une machine qui prend une décision (parfois à tord).

Le libre arbitre, finalement, c’est un peu la liberté de prendre les décisions que l’on veut. Si demain on prend un algo de machine learning et qu’on l’utilise pour prendre la décision de quel algo de machine learning utiliser, c’est extrêmement proche du principe du libre arbitre, mais là encore à une échelle différente de ce que fait l’être humain.

#15

Une machine a les limites physiques qu’on lui donne. Tu peux rendre ta tour super intelligente, si tu la déconnectes d’internet son champ d’action sera bien limité, bien plus que celui d’un humain.

#16

Ce qui relève de la sémantique c’est le fait que tu fasses une comparaison tout en disant que ce n’est pas comparable; pas la comparaison en elle même bien sûr.

Ton exemple avec les rats de labo est plutôt mal choisi, puisque justement on mène ces expériences, on ne les arrête pas. Il n’y a pas vraiment d’équivalent aux rats de labo pour l’IA mais qui te dit que les règles de déploiement d’une éventuelle IA suffisamment perfectionnée ne seront pas aussi sécurisantes (pour ce que ça a de comparable…) aux études sur animaux avant de passer à l’homme?

De mon point de vue, il ne s’agit pas de dire que les IA ne poseront jamais aucun problème à l’humanité, mais en avoir peur aujourd’hui et vouloir déjà les limiter, c’est une peur irrationnelle qui n’a pas de réelle substance.

#17

#18

#19

C’est un abus de langage anthropomorphique.

La destruction d’une colonie par une autre colonie ne se faire que lorsqu’il y a raréfaction des ressources. C’est tuer ou mourir.

On retrouve les mêmes comportements chez d’autres espèces qui sont prêtent à se mettre sur la gueule jusqu’à la mort quand la pression du milieux est trop importantes.

Ce qui rend le phénomène “spectaculaire” chez les fourmis c’est que ça se passe non pas entre quelques individu isolé ou entre groupes, mais bien entre colonies entières (bha oui c’est des fourmis !)

Mais tout ça pour dire qu’un génocide humain n’a pas du tout les même motifs et que c’est un abus de langage.

C’est pareil que si l’on dit qu’un trou noir avale une étoile, c’est un abus de langage anthropomorphique.

#20

Former des pionniers en la matière : checked

Voir ses pionniers aller bosser ailleurs : checked

prendre du retard : in progress

créer un drama sociétal : in progress

pleurer que les autres nous pillent : starting process

créer une exception française : waiting

#21

Le calcul homomorphe c’est théoriquement simple, il s’agit d’outils mathématiques qui permettent par exemple de répondre au besoin suivant :

Tout ça pour dire que je ne vois pas le rapport avec la choucroute

#22

#23

Question bête, c’est quoi la différence entre une Intelligence Artificielle spécialisée (comme on voit Google le faire sur différent produits: traduction, lecture sur les lèvres, etc) et un “simple” réseau neuronal ?

#24

Le calcul homomorphe permet surtout de faire des opérations sur des données chiffrées.

Exemple : C1 est le chiffré de V1 (C(V1)) et C2 le chiffré de V2 (où Vx est un nombre quelconque). Le chiffrement homomorphe permet des opérations du genre C3 = C1 + C2 = C(V1 + V2) <= les opérations + n’étant pas forcément des additions au sens entendu mais des opérations définies selon le chiffrement utilisé.

Ce type de chiffrement permet d’agréger des données chiffrées sur lesquelles on peut travailler sans pour autant révéler les valeurs individuelles. C’est utile pour le machine learning qui a besoin de données pour construire des modèles.

Par contre je ne suis pas à jour dans les algos homomorphes mais il me semblait que les tailles de clés étaient astronomiques pour que le chiffrement ne puisse pas être cassé en 2 secondes.

#25

Justement, je ne vois pas ce que l’on peut faire sur les données agrégées sans les déchiffrer ? Et être capable de les déchiffrer donne (potentiellement pour rester gentil) la capacité de déchiffrer les vecteurs en entrée, non ?

#26

Ou alors maintenant, grossomodo avec les approximations d’un ciboulot le vendredi soir, si on suppose pour faire simple deux signaux en entrée :

On applique une transformation opposée aux deux signaux (pour empêcher de les retrouver) puis on les chiffre de deux manières ‘opposées’ d’une certaine manière.

Le système homomorphe applique l’opération qui va bien qui à la fois :

#27

#28

Merci pour cette réponse très détaillée ! " />

" />

#29

En fait c’est un des principe du chiffrement homomorphe de pouvoir déchiffrer les résultats ensemblistes sans pouvoir le faire de manière individuelle.

JE vais donner l’exemple avec un système de vote utilisant ce chiffrement : chaque votant envoie le choix de son vote chiffré. Le système central récupère les données et peut appliquer des opérations sur les différents choix. A la fin, le système peut dire qui est le gagnant du vote sans pour autant pouvoir dire qui a voté quoi.

Le procédé mathématique de ce genre de chiffrement me dépasse. Les cours d’introduction à ce genre de chiffrement m’a valu le claquage d’un bon paquet de neurones.

Pour en revenir au sujet, je reste sceptique quant à l’utilisation des données personnelles chiffrées de cette manière, premièrement parce que le chiffrement homomorphe reste assez facilement décryptable (sauf nouveaux algos dont je n’ai pas entendu parler) et qu’il y a toujours la question de la génération de clé. Qui la fournit ? Qui fournit ces données personnelles ? Parce que je me vois mal perdre du temps pour mettre en place un système que je ne considère pas sûr et qui utilisera massivement mes données.

#30

#31

“Les fourmis sont les formes de vie parmi les plus agressives de la planète, basant leur politique étrangère sur l’agression ininterrompue, la conquête territoriale constante et l’annihilation des colonies voisines par génocide, et ceci dès que possible.

Depuis 100 millions d’années, les fourmis se livrent des luttes sans merci et conquièrent la quasi totalité de la surface habitable.

Elles représentent en nombre quelques 10 millions de milliards d’individus.

Elles correspondent en biomasse à près de 4 fois la biomasse de tous les vertébrés terrestres, et près de 20 % de celles de l’ensemble des insectes.

Preuve, s’il en fallait, de l’omniprésence et de la puissance adaptative de ces éternels constructeurs et guerriers.”

Drees M. B., Knutson E. (2002). Potential biological control agent for the red imported fire ant. Texas A&M University. College station, Texas.