Alors que les processeurs Zen 3 d'AMD seront mis sur le marché la semaine prochaine, Intel commence à évoquer le remplaçant de ses processeurs Core de 10e génération pour les PC de bureau. Son nom de code était déjà connu : Rocket Lake-S.

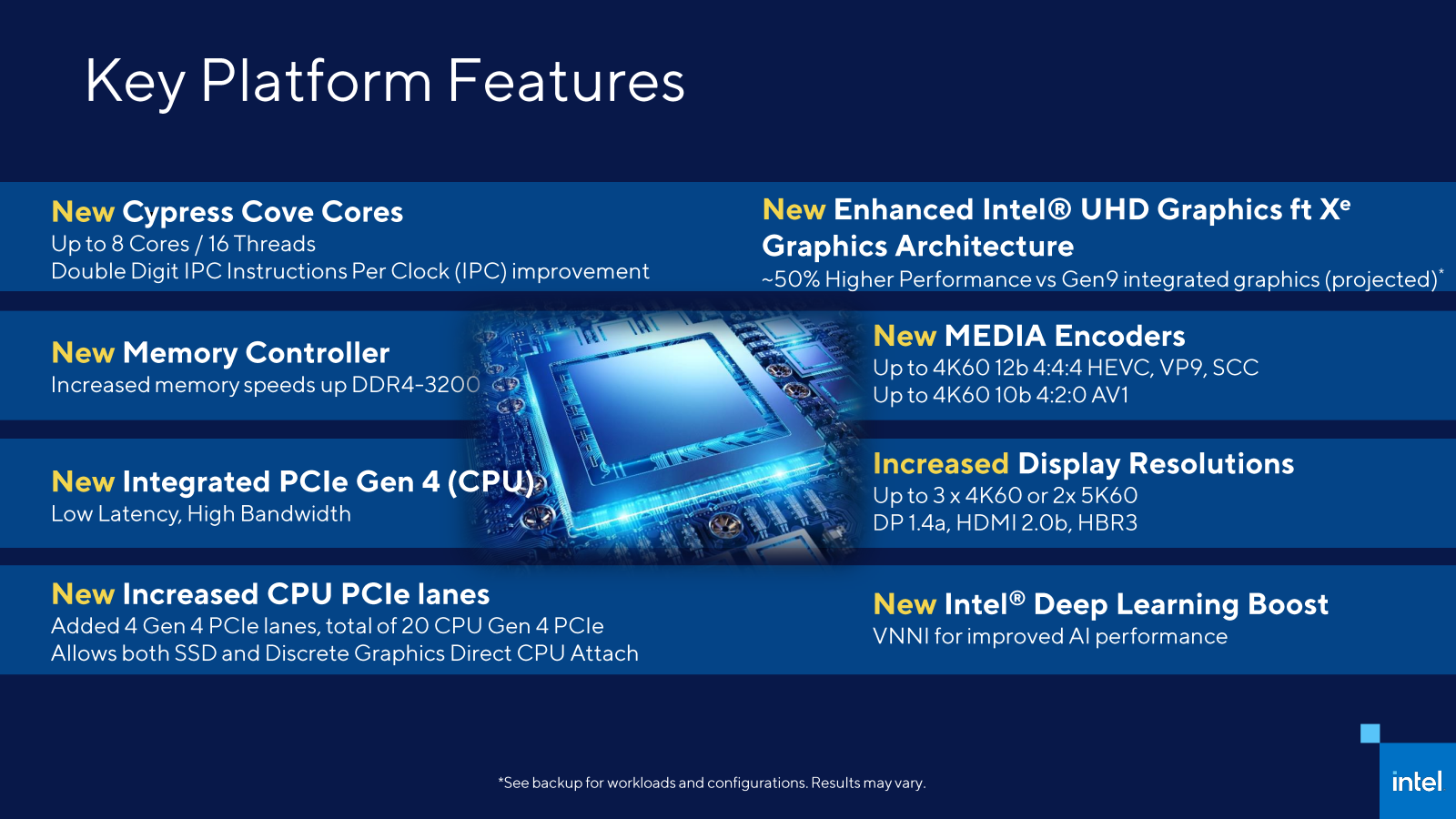

On savait déjà que la prochaine génération de CPU Intel serait sur un socket LGA 1200, mais avec du PCIe 4.0, une partie graphique intégrée Xe, de nouveaux chipsets de série 500 et des fonctionnalités avancées.

Intel confirme aujourd'hui ces informations. Tout comme celles sur les 20 lignes PCIe 4.0, les instructions Deep Learning Boost/VNNI et l'USB 3.2 2x2 à 20 Gb/s intégré. Les cœurs Cypress Cove (la version 14 nm de Willow Cove) seront au nombre de huit au maximum, toujours avec trois écrans gérés (HDMI 2.0b ou DisplayPort 1.4).

Pour le moment, Intel ne donne aucune nouvelle information et peu de détails sur les fréquences, la consommation ou les performances de ces puces qui devraient être dévoilées dans un second temps, sans doute autour du CES. On sait simplement que l'IPC grimpe d'un rapport à deux chiffres, ce qui peut être 10 % comme 15 % ou 35 %.

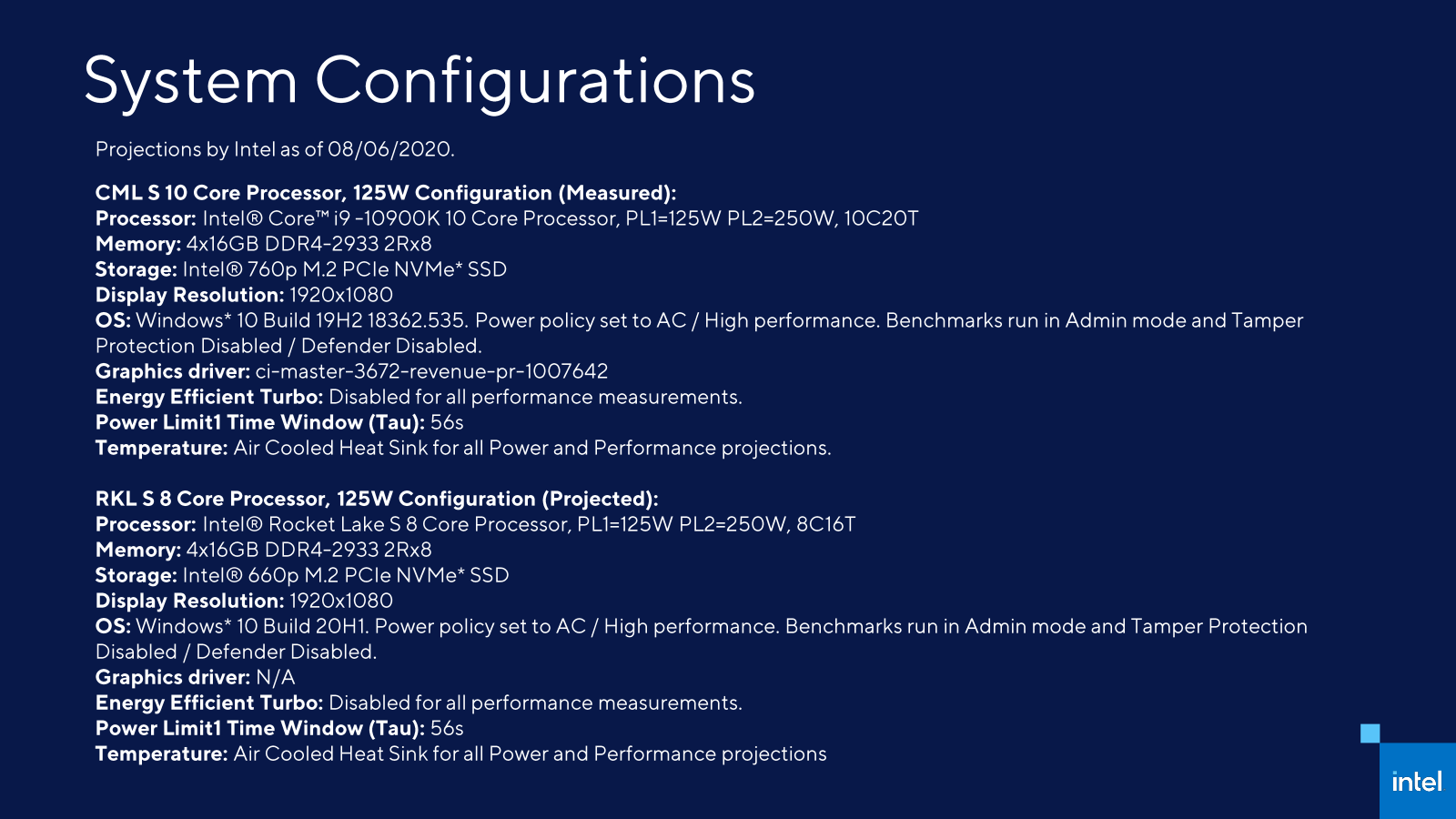

Le constructeur évite aussi soigneusement de parler de la finesse de gravure de sa puce. Interrogé, il nous confirme qu'il est bien entièrement en 14 nm. Autre indication : les estimations de performances se font pour le moment sur la base d'un PL1 de 125 watts et un PL2 de 250 watts avec un Tau de 56 secondes.

La disponibilité de Rocket Lake-S est toujours attendue pour le 1er trimestre 2021.

Commentaires (39)

#1

“Autre indication : les estimations de performances se font pour le moment sur la base d’un PL1 de 125 watts et un PL2 de 250 watts avec un Tau de 56 secondes”

Quelqu’un peut expliquer ce que ça veut dire ? Merci.

#2

Dans la configuration recommandée par Intel, sur une forte charge le processeur peut consommer jusqu’à 250W pendant 56 secondes (si le dissipateur est suffisant pour maintenir une température acceptable), puis est limité à 125W, donc voit ses fréquences baisser.

Certaines cartes mères configurent par défaut un Tau plus élevé, voire illimité.

#3

Ok merci, je ne savais pas ce qu’était le Tau.

#4

14nm donc si on a un IPC à 2 chiffres, je suis prêt à parier qu’on aura du 10% tout pile.

#5

Tu sais que si c’est 10.01 % ton pari sera perdu ?

#6

2035, AMD sort son premier CPU gravé en 250Å, pendant que Intel sort son I9-35900K gravé en 14nm+++++++++++++++++++++++++++++++++.

#7

Et quand est-ce que la finesse de gravure chez Intel diminuera à moins de deux chiffres ?

(oui je sais le 14 nm d’aujourd’hui est du 14 nm ++++++ bien meilleur que le 14 nm, oui je sais cette valeur n’a rien d’une grandeur physique, oui je sais ce nombre n’est pas comparable entre les fondeurs, blablabla… N’empêche que c’est toujours du 14 qu’ils nous vendent )

)

#8

bon, j’allais en rajouter une couche sur le 14nm, mais au fond, bien qu’ils enfilent les + comme des perles, leur process en 14 est ultra optimisé et sort des très bonnes fréquences.

quand (si ) ils passeront sur du 7, ça pourrait liberer un gros gap de puissance

) ils passeront sur du 7, ça pourrait liberer un gros gap de puissance

#9

Ben si j’ai bien compris c’est les portables qui seront en 10nm dans un premier temps donc pour les pc fixes ça risque d’être dans un bout de temps…

#10

L’année prochaine ;)

Les portables sont déjà en 10 nm sur une bonne partie de la gamme depuis Ice Lake (Core 10e Gen), Tiger Lake (11e Gen) qui sort là est aussi en 10 nm.

#11

https://fr.wikipedia.org/wiki/%C3%85ngstr%C3%B6m

250 Angström = 25 nm, soit proche de la techno 22nm de 2012-2014

#12

ce rocket lake, un ‘back-port’ de cpu mobile 10nm en desktop 14nm, et avec aussi lAVX512 en standard, s’annonce surtout comme un énorme chauffage.

Entre ça et les RTX 30xx de nVidia, cela va être la fête pour les vendeurs de grosses alimentations!

(je viens de regarder la video de Linus qui teste 2 RTX 3090 en SLI sur un i9, cela fait sauter l alim de 1000 W!)

Et on est censé aller dans une ère de meilleure efficacité énergétique :(

Les annonces d AMD de ce côté sont heureusement plus réjouissantes…

#13

Zzzzzzz… un pti’ refresh en somme.

#14

Ca me fait marrer les gens qui qualifient les 14nm de chauffage… Tu as dû oublier l’époque du pentium 4 ^^;

#15

Bonne nouvelle, ces CPU comme tous ceux d’Intel depuis des lustre sur le grand public, ont un IGP. Tu n’auras donc même pas à utiliser une carte graphique ;) Il y aura même des déclinaisons à petit TDP économes en énergie.

Oui et non, c’est quand même la première implémentation de Willow Cove/Xe sur Desktop, en soi ce n’est pas rien et loin d’un simple refresh ;)

#16

0.11% ça compte ? Le service marketing dit oui

#17

En vrai pour l’efficacité énergétique, si on prend la métrique performance/watt, alors je pense que ça à quasiment toujours été une évolution vers le mieux.

#18

Après, le 250W, c’est avec le XE qui tourne? Parce que si 125/250W c’est avec la partie graphique, c’est pas si mal, surtout que la partie graphique est intéressante (y compris en GPU) de ce que je lis en ce moment.

#19

Va pour un gros refresh alors. Mais j’attends de voir les détails sur banc d’essai.

#20

De ce quye je comprends, Intel met en prod peu à peu sa nouvelle architecture * Cove qu’il entend décliné dans les offers desktop et laptop et qui est censé optimisé plus l’IPC que le gain en fréquence.

Mais pour le moment est encore au milieu du gué donc si je ne dis pas de bêtise, soit on opte pour une CPU Desktop basé sur Skylake mais qui a fait ses preuves soit on opte pour une CPU intermédiaire qui se rapproche peu à peu de ce que sera Alder Lake et qui embarquera Golden Cove pour les HTPC possiblement 3th/2021.

Donc pour le moment Zen3 contre Skylake/Cypress Cove puis mi /fin 2021 Zen4 contre Alder Lake/Golden Cove.

J’ai bon?

#21

Rien que pour la partie graphique ça fera un gros changement (Xe étant plus performant que les IGP récents d’AMD). Après sur la partie CPU face à Zen 3, Intel devrait rester en retrait (modulo la fréquence, mais il y a peu de chances que l’écart soit en faveur d’Intel hors des accélérateurs).

Là où Intel fait des choix intéressants, c’est sur le fait de ne pas aller sur le terrain de l’excès de cœurs (tout le monde n’ayant pas besoin de 12⁄16 cœurs, même si ça leur fait mal sur le segment HEDT) mais plutôt des accélérations ici où là exploitables par les apps (un peu comme NVIDIA sur les GeForce face aux Radeon). Ce n’est pas le meilleur choix pour CineBench, mais ça pourra avoir des intérêts pratiques.

A voir quand tout sera dispo et testable ;)

Alder Lake ce sera autre chose, les puces seront plus focalisées sur l’aspect modulaire et hybride de l’architecture. Rocket Lake est juste une solution de court terme parce qu’Intel ne peut pas encore produire d’équivalent en 10⁄7 nm pour Desktop (donc à haute fréquence et beaucoup de cœurs).

Je ne comprends pas trop les remarques sur Skylake par contre. Actuellement on est sur l’un de ses dérivés (Comet Lake-S, 10e Gen), ce ne sera plus le cas pour la 11e Gen.

#22

250W c’est pour la puce.

L’énorme nouveauté des core i a été celle qui a permise le mode turbo: la gestion thermique du processeur (je ne parles pas de la sécurité thermique, mais réellement de gestion).

Ta puce a une enveloppe quelle doit ou pas dépasser pendant un temps convenu. Que ce soit CPU 100%, CPU 90%+GPU 10%, CPU 50%+GPU 50%, CPU 10%+GPU 90%, on s’en fout. Le cpu va lui-même se réguler.

250W pour une puce (j’évite volontairement le nom de processeur), c’est super. Ca te permet d’avoir un refroidissement dimensionné ou non, et d’avoir la puce qui réagit en conséquence, créant une réelle ambivalence tout en profitant des réels bénéfices (supposé) du Xe intégré. Franchement, j’attends de voir les résultats des Xe pour voir le bénéfice (tout comme j’ai une carte nvidia RTX pour les tensors: je ne joue pas quasiment, alors le raytracing… xD)

L’architecture de la partie processeur est peut être pas super meilleure, mais l’Xe l’est. Le GPU de nos jours est un coprocesseur qui aura un accès, ici, privilégié au bus processeur. Là où le GPU en serait la maitresse, l’IGP en serait la femme…

Le challenge est tellement grand d’un point de vue GPU et la barre est tellement haute là où est nvidia qu’Intel n’as pas le droit de décevoir. Imagine si Intel arrive à créer un Xeon intégrant un GPU spécialisé GPGPU virtualisable par SRV-IO pour serveur? Nvidia perdrait du terrain dans un monde où il règne en maitre absolu.

Le particulier n’est qu’un cobaye rapport aux ambitions… Et tant mieux pour nous sur ce coup: nous n’aurons que des bénéfices

#23

Je voulais souligner qu’Intel était en transition. Du coup, pour l’offre desktop, quel est l’intérêt des CPU Intel du moment? Autant attendre la prochaine génération ? J’ai vraiment du ml à comprendre le positionnement marketing de Rocket lake si ce n’est de limiter la casse face à l’offre AMD du moment.

Personnellement, je dois changer une machine (base I7-3770k), l’offre Zen3 me parait de plus en plus incontournable à 6 mois. C’est peut être moi mais il y a un manque de visibilité de la part d’Intel.

#24

Il y a une règle en informatique : il y aura toujours mieux dans six mois. Certes il y a des générations plus intéressantes que d’autres, de meilleures moments pour se monter une machine. Mais globalement, on peut passer des années à se dire “allez, la prochaine fois c’est la bonne”.

Certains ont besoin de PC maintenant, dans 3 mois, dans 9 mois. On choisi à ce moment là en général, sur des critères concrets. Par exemple tu évoques Zen 3 mais tu oublies que ces puces sont sans IGP, avec un tarif minimal qui reste élevé (sans parler de la carte mère).

Toutes performantes qu’elles soient, elles n’adressent qu’une partie du marché. Si dans six mois tu as besoin d’un PC avec partie graphique intégrée, Zen 3 ne sera pas un choix viable. Il faudra alors regarder du côté des APU d’AMD (toujours en Zen+ sur Desktop pour rappel hors OEM) ou l’offre d’Intel.

#25

Pour ceux que ça intéresse, il s’agit de cette vidéo : https://www.youtube.com/watch?v=i1dGQiNfCAc et l’alimentation déconnecte un peu après 7’30 ; il explique que c’est dû aux sursauts brefs de consommation, ce qui a motivé les recommandations d’AMD et nVidia en terme d’alimentation, toujours avec une certaine marge par rapport à la puissance nominale.

#26

En même temps une alimentation il faut toujours de la marge, surtout avec de tels composants. Quand tu colles 2x 350 W de GPU et 1 CPU qui peut grimper à 250 W sur une alimentation à 1000 watts, tu cherches les problèmes. Mais bon, ça permet de faire réagir.

Après ceux qui trouvent ça trop pour un PC (ce que je comprends), rien n’oblige personne à mettre 72 TFLOPS de puissance GPU dans un même PC avec un CPU haut de gamme. Et comme ça, il n’y a pas besoin de 1000 watts d’alimentation ;)

#27

Puis bon pour les gens qui trouvent que la consommation d’un ordi est un problème, en été peut-être mais en hiver ça permet de baisser les radiateurs à iso-température donc on s’y retrouve

#28

Mon bureau valide cette théorie

#29

🤣🤣🤣🤣🤣🤣🤣🤣🤣🤣🤣

#30

Je suppose que tu as pensé picomètres (pm soit 10^-12) plutôt que Ångström (10^-10), ce qui équivaudrait à 0,25 nm (ça va être dur :-) ).

#31

C’est justement ça la blague.

#32

Enfin, intel revient dans la course. Il était temps, c’est vraiment insupportable cette situation où AMD bloque tout en inventant rien.

Et puis le 14nm vs 7, on sait tous que c’est du pipeau. Et si intel était si mauvais, ils n’auraient pas toujours autant de PDM, c’est évidemment que leurs produits sont de très haute qualité avec un suivi irréprochable.

Les failles de sécurité d’intel sont des faux problèmes, tiens, comme par hasard, on ne parle plus du tout des failles AMD. Coïncidence ?

Bref, il était temps qu’ils reviennent, au moins avec intel et NVIDIA, on est certain de la qualité de nos produits.

#33

Je commence à me méfier des instructions-set spécifiques à un CPU, combien de programme exploitent réellement AVX ?

TSX a-t-il eu le temps d’être exploité avant d’être bloquer à l’arrache par un une màj de microcode (pour cause de faille) puis de disparaitre totalement des nouveaux CPU.

Ces innovations sont belles sur le papier, mais ont plusieurs pb :

L’innovation la plus majeure est sans doute AMD64 : qui a amélioré sensiblement le PGCD des CPU: Si ça tourne en 64bit y’a forcément du SSE2.

#34

Les avancées en la matière ne sont pas toujours spécifiques à un constructeur, et on est bien content d’avoir des accélération AES dans tous les CPU modernes (entre autres). Pour AVX, c’est souvent utilisé là où c’est utile, mais pas toujours mis en avant (voir Blender récemment par exemple avec Embree).

Après si tu te méfies des jeux d’instructions brevetés/sous licence et limités d’accès, tu peux abandonner x86 (et sans doute presque l’intégralité du marché). Dans tous les cas, chaque innovation prend du temps pour être exploitée par les compilateurs/développeur, c’est la vie. Mais pas une raison pour stagner.

#35

Mon propos n’avait pas de vocations rétrogrades :) A chaque nouvelle génération on nous bassine avec les nouveaux set d’instructions et des benchmarks alambiqués, et tout le focus est mis là-dessus. Le fait est que ces nouveautés architecturales sont rarement utiles au quotidien. C’est trés bien que blender utilise AVX mais ça reste assez anecdotique par rapport aux articles qu’on a pu lire sur ce sujet (à la sortie d’Haswell ?) Combien de personnes ont choisis ce modèle parce qu’un bench synthétique montrait 20% de plus que le concurrent. 10ans plus tard seuls certains softs spécifiques commencent à exploiter ce set. Il est probable que nombre d’Haswell achetés sur ce critère soit déjà enfoui dans une décharge :-/

Bref ces évolutions sont bonnes à prendre, mais le principal choix reste la perf brute.

#36

En même temps les instructions de vectorisation des calcul ne sont pas trop faites pour le quotidien, pas plus que le calcul sur GPU (à quelques exceptions près). Ce n’est pas pour autant qu’elles ne sont pas utiles ou qu’il ne faut pas travailler sur de telles solutions.

Après je suis le premier à regretter la pertinence des choix en matière de CPU, mais je doute qu’AVX soit vraiment le premier critère à retenir concernant les bêtises que l’on peut lire en la matière Puis bon, les accélérateurs divers sont ce qui fait la force des SoC mobiles, que ce soit en photo, audio, vidéo, etc. Le PC suit la tendance, que ce soit via les GPU, instructions CPU ou autre puces parfois dédiées.

Puis bon, les accélérateurs divers sont ce qui fait la force des SoC mobiles, que ce soit en photo, audio, vidéo, etc. Le PC suit la tendance, que ce soit via les GPU, instructions CPU ou autre puces parfois dédiées.

Mais oui, l’IPC reste le principal. Mais ce n’est pas le seul facteur. Pas plus que la fréquence, le nombre de cœurs, la plateforme, les tarifs, le perf/W, etc. Un composant c’est un ensemble de critères dont l’importance varie d’un utilisateur à un autre. Comme dit, ce qui est intéressant dans la position d’Intel, c’est qu’on arrête aussi de penser que le nombre de cœurs et Cinebench sont le must have et qu’il n’y a pas d’usage du quotidien qui mérite un peu plus d’attention.

#37

l AVX256 sorti avec Haswell est aussi utilisé par les algorithmes de compression video: les écarts étaient assez marqués. Et d ailleurs l AVX256 n est arrivé qu avec le Zen2 chez AMD, et a accentué l ecart entre zen+ et zen2.

Avec l AVX512, c est plus compliqué à mettre en oeuvre si j ai bien compris.

Intel a pendant longtemps conservé l AVX512 sur les CPU premium.

On voit avec RocketLake la généralisation dans toute la gamme, ce qui va donc favoriser son usage.

Par contre, l AVX512 a tendance à bcp consommer et donc faire bcp chauffer, c est pour cela que je parlais d un beau système de chauffage…

#38

L’ouverture aux produits grand public est antérieur, puisqu’on avait déjà AVX-512 sur ICL et TGL. C’est juste que comme RKL repose sur une déclinaison du même cœur… on l’y retrouve ;)

#39

Sur certains usages, ces instructions changent la donne. Quand les premiers CPU avec AES sont sortis, presque personne parmi les particuliers ne chiffrait ses disques durs… Désormais, chiffrer est très fréquent (Bitlocker, Veracrypt…). Pareil pour la virtualisation : VT-x, VT-d et cie permettent de faire tourner des VM même sur des CPUs assez peu véloces dans de bonnes conditions (genre pentium N3700 4C/4T : pour peu qu’on ait assez de ram, c’est tout à fait correct). Dans le monde des serveurs, c’est une révolution qui s’est mise en place grâce à un très faible impact de la virtualisation.

C’est sûr que selon les profils, peu de monde utilise tous ces raffinements à la fois.