Un an après l'annonce de Navi qui équipait les Radeon RX 5000 avec l'architecture RDNA, AMD vient de dévoiler la seconde phase de son plan de reconquête du marché du GPU. Le constructeur veut aller plus haut à tous les niveaux : taille de la puce, fréquences, performances, mémoire et... prix.

Depuis cet été, les joueurs sont focalisés sur les GeForce RTX de série 30 de NVIDIA. Avec Ampere, le constructeur a fait fort, doublant la puissance de calcul, allant plus loin dans les performances en jeux, renforçant l'efficacité de son architecture... tout en baissant ses prix et en proposant de nouveaux outils (Broadcast, Reflex, etc.).

- NVIDIA dévoile RTX IO et ses GeForce RTX 3070, 3080 et 3090 dès 519 euros

- GeForce RTX 3070, 3080 et 3090 : Ampere expliqué techniquement et simplement

Navi 2X : AMD de retour sur le haut de gamme

De son côté, AMD semblait dans la panade. Ses Radeon RX 5700 XT sont loin d'être au niveau. DirectX Raytracing est toujours aux abonnés absents deux ans après son annonce, comme la plupart des nouveautés de DirectX Ultimate. Aucun équivalent de DLSS n'existe, la stack logicielle pour le calcul et le rendu 3D est largement en retrait...

Ce, alors qu'Intel se prépare à débarquer sur le marché en force dès l'année prochaine, après une première incursion de son architecture Xe dans les PC portables dès cette année. Il faut donc revenir au score et frapper fort. C'est l'objectif de RDNA 2 et des Radeon RX 6000 pour le grand public, CDNA arrivant plus tard pour les Pro.

L'Infinity Cache pour booster les performances

Ce soir on a découvert les grandes lignes de ces nouvelles cartes qui devraient être équipées de puces bien plus grosses, bien plus performantes, toujours gravées en 7 nm. Le nombre d'unités de calcul est doublé, pouvant atteindre 80 Comput Units (CU). On ne sait pas pour le moment comment ils sont organisés, leur cache, etc.

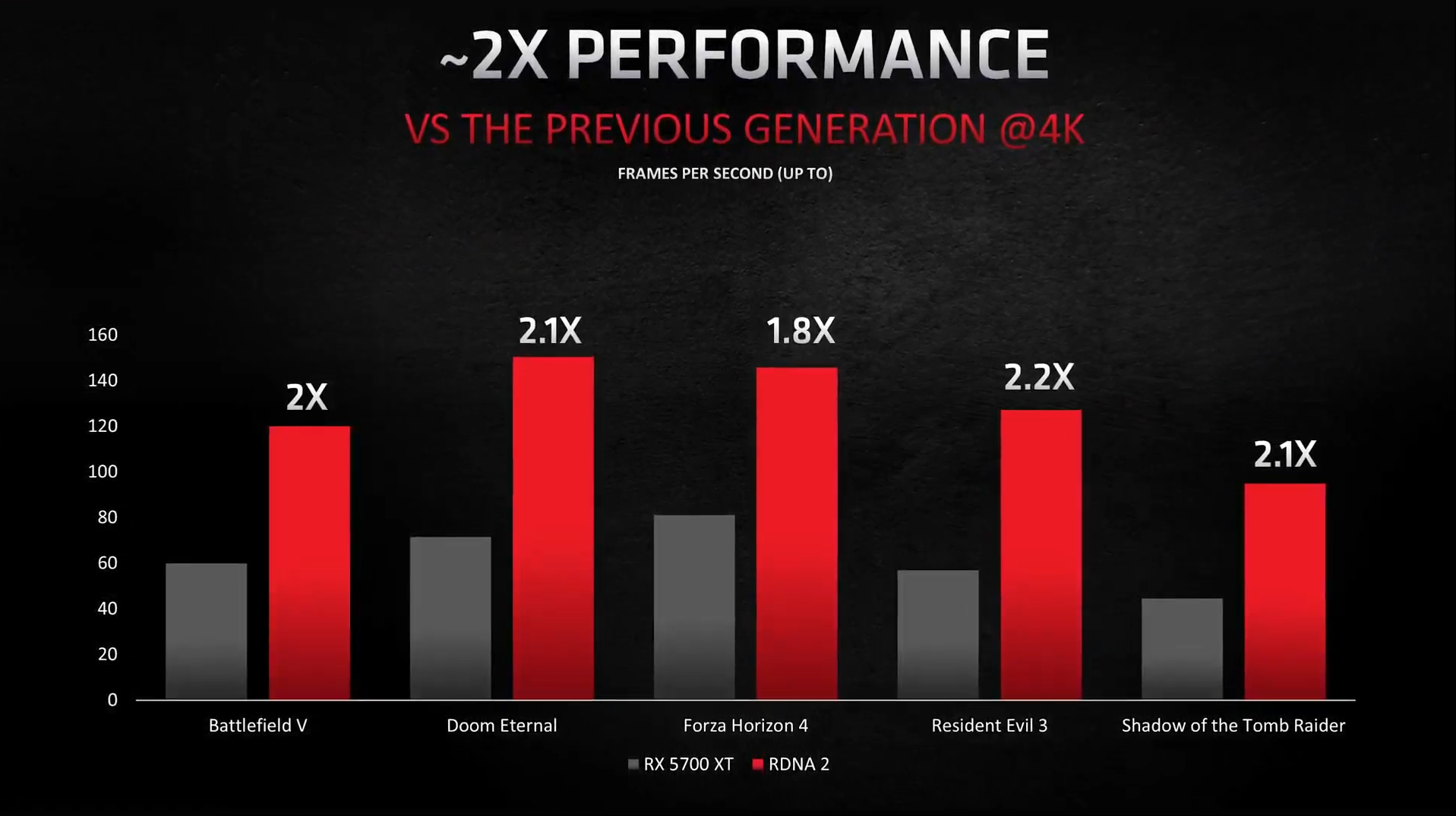

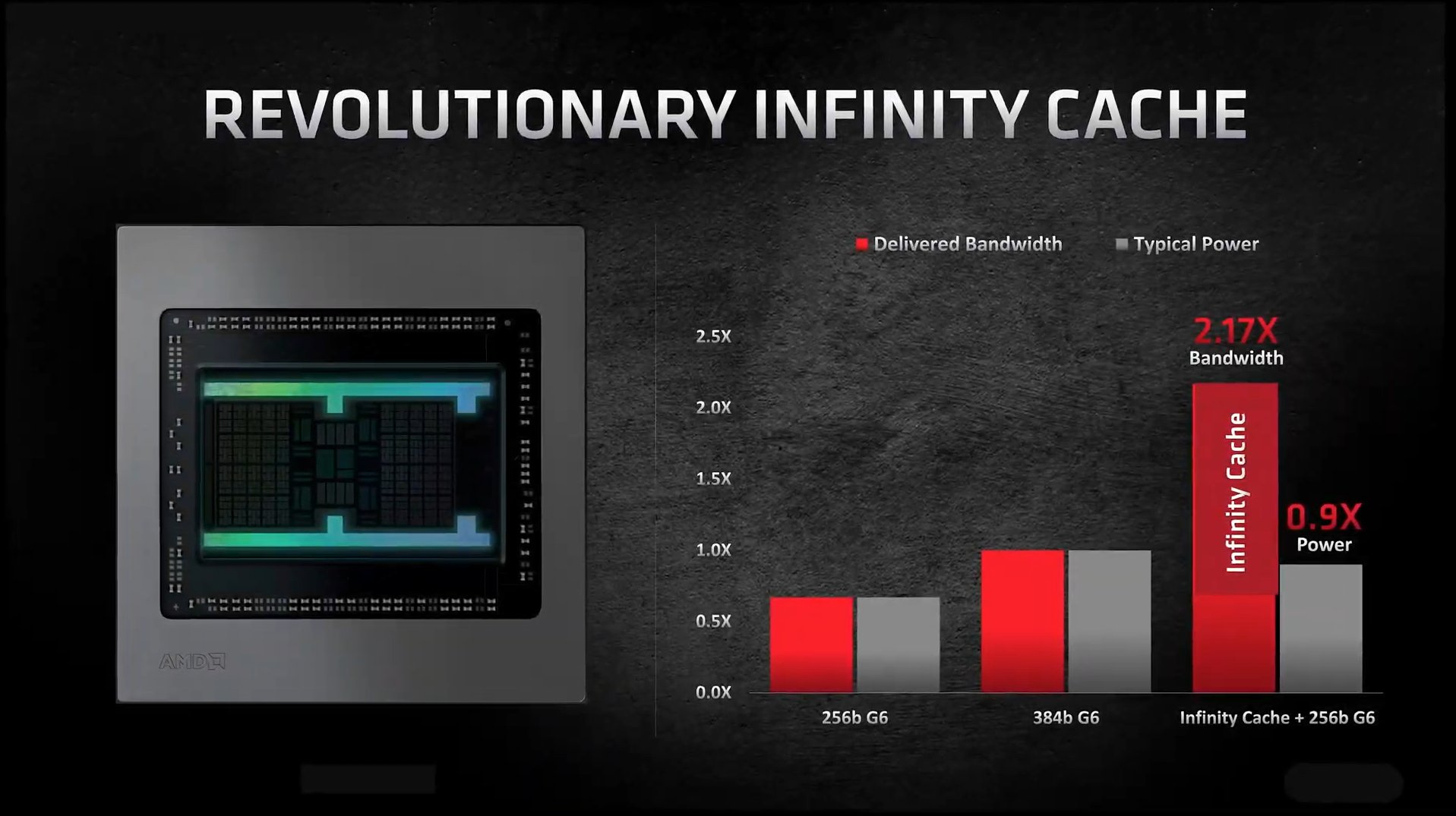

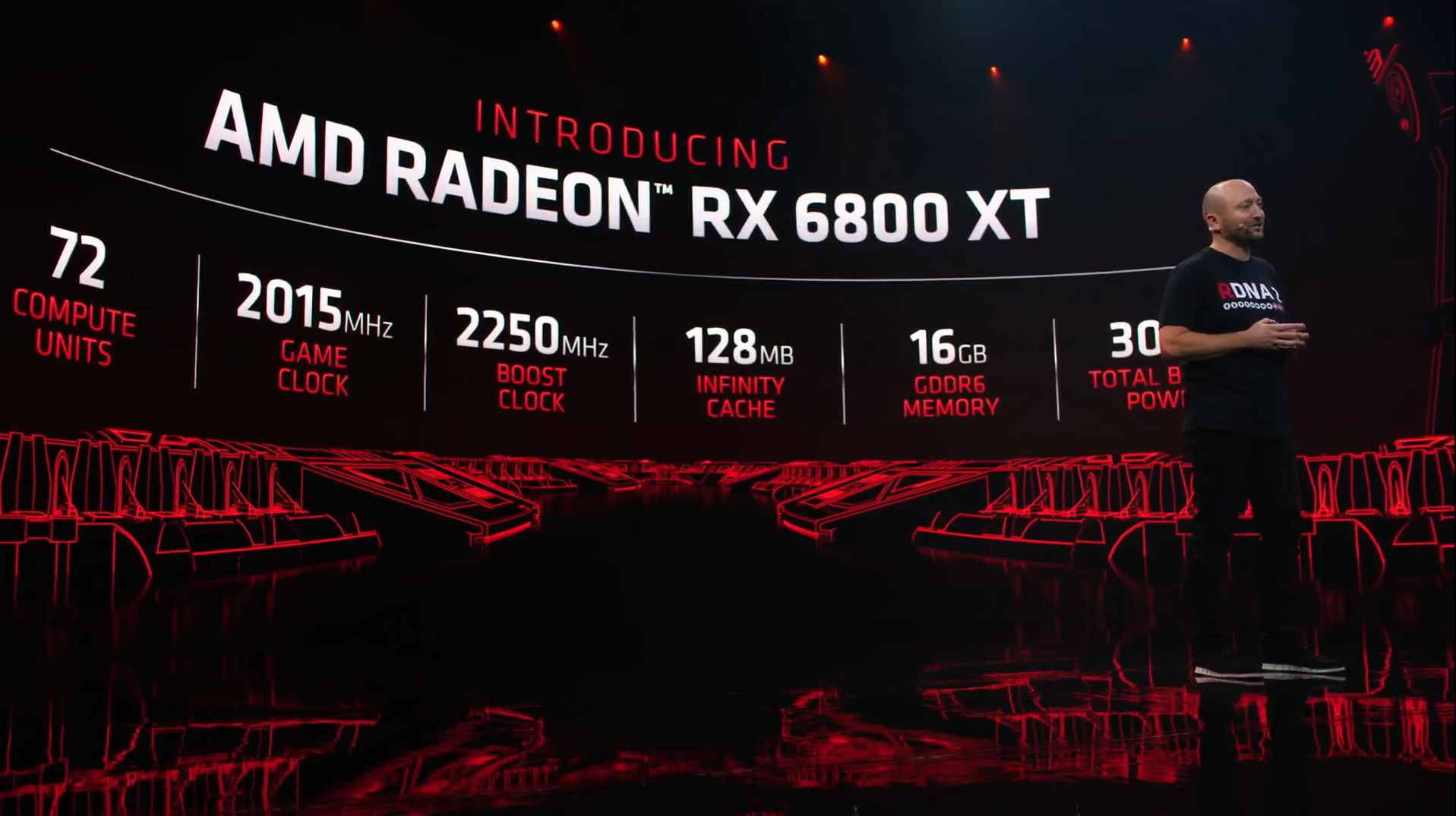

AMD a rappelé que le rapport performance/watt de sa nouvelle architecture a grimpé de 50 % grâce à la montée en fréquence, l'optimisation du design et Infinity Cache. Si l'on sait peu de choses concrètes sur l'architecture, il s'agit d'un cache de 128 Mo intégré aux trois modèles annoncés ce soir : les Radeon RX 6800 (XT) et 6900 XT. Le constructeur annonce 1 664 Go/s de bande passante effective. Ce sera à vérifier lors des tests.

Il doit permettre de doubler la bande passante effective à consommation électrique constante. Il accompagne les 16 Go de GDDR6 intégrés à tous les modèles. Pourquoi autant ? Sans doute pour ne pas se limiter à 8 Go et aller au-delà de ce que propose NVIDIA. D'autant que l'argument marche toujours assez bien auprès du public.

La puce (Navi 21) se compose de 26,8 milliards de transistors, contre 28,3 milliards pour un GA102 (RTX 3080/3090). Avec 5 120 unités FP32, sa puissance de calcul est de 23,04 TFLOPS, contre 20,3 TFLOPS pour une RTX 3070.

Trois cartes graphiques, dès 579 dollars

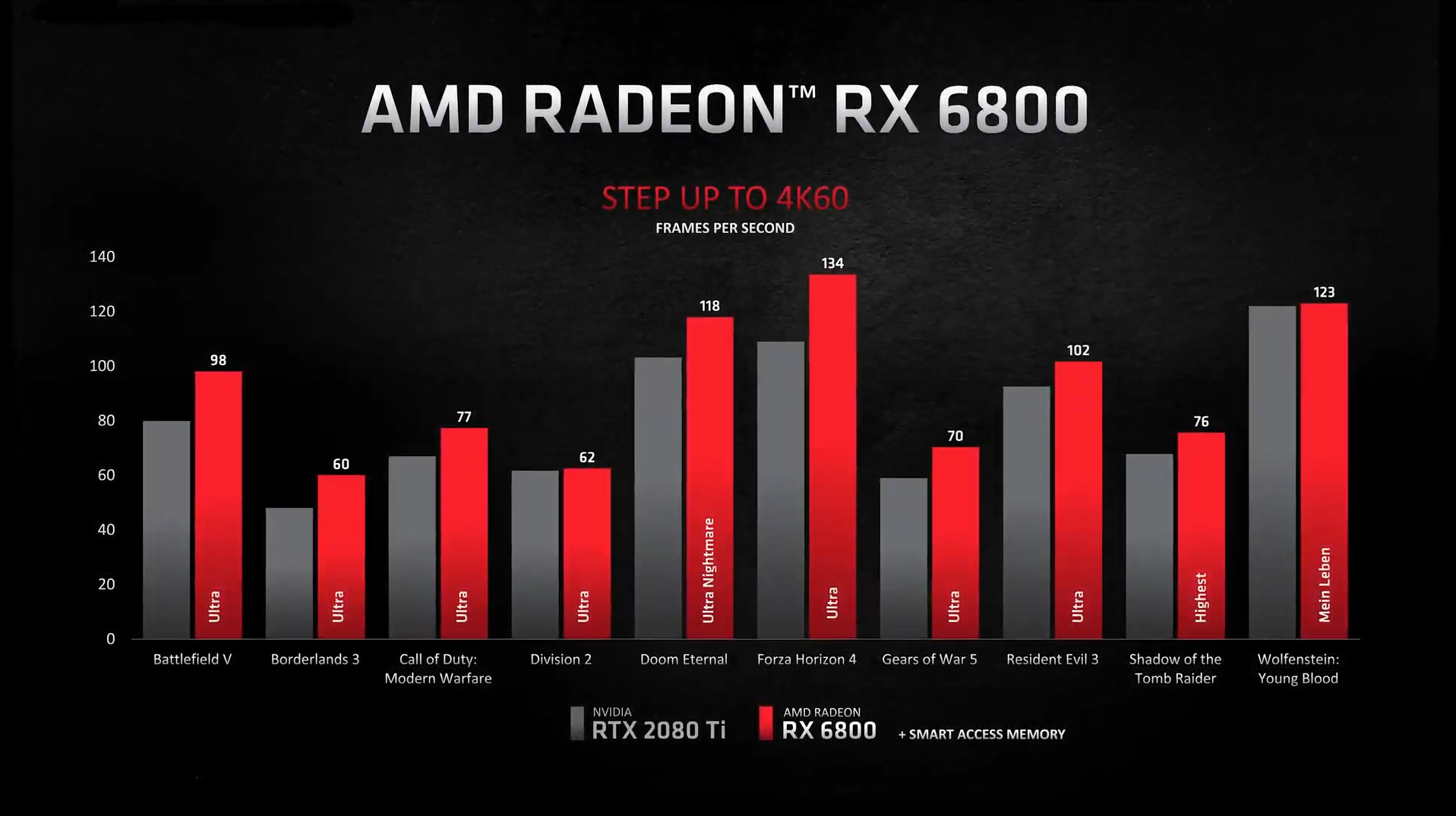

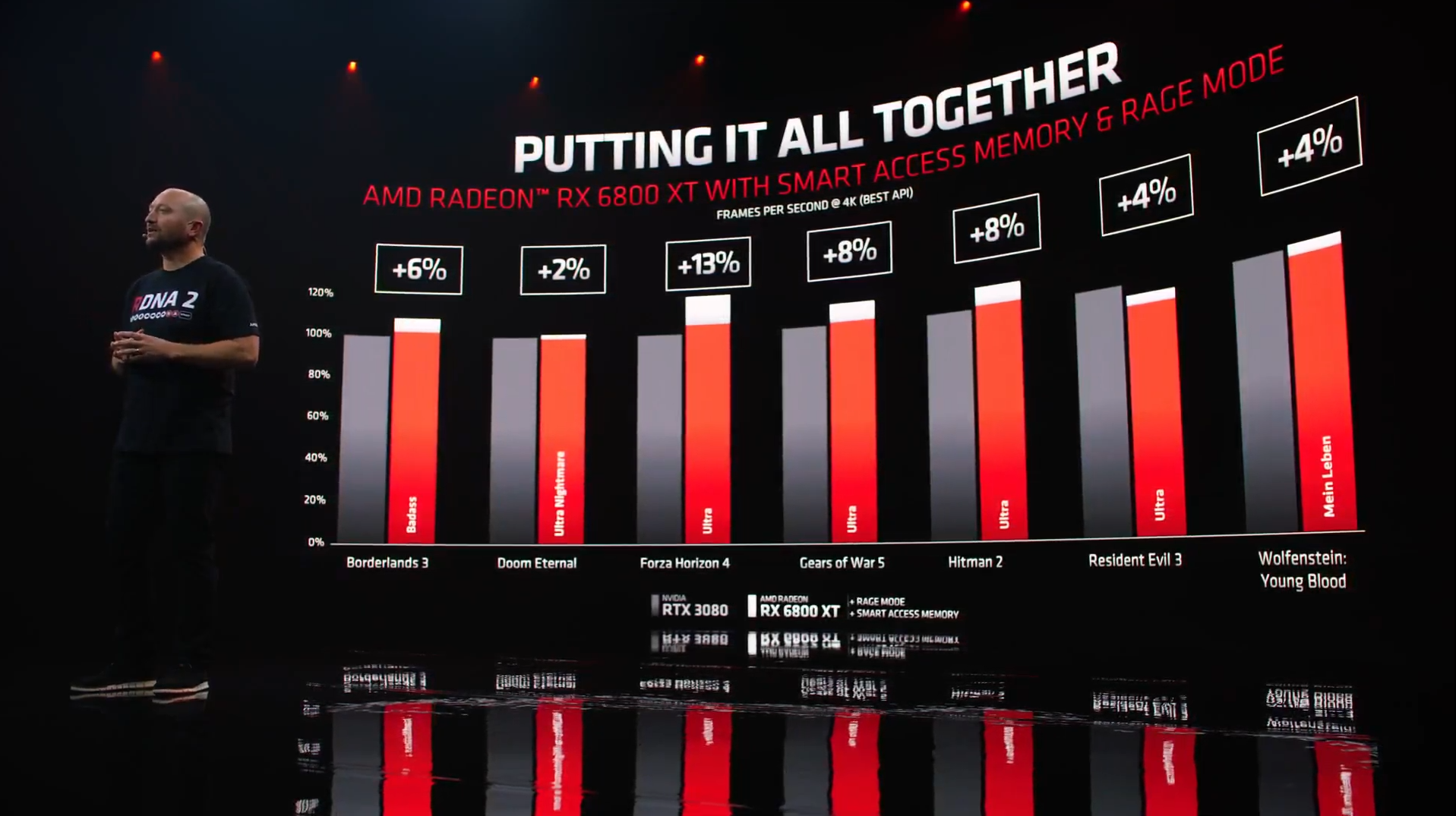

Car c'est bien de cela qu'il était question : montrer qu'AMD est de retour face à son concurrent. Les trois cartes s'affichent ainsi à des niveaux similaires aux RTX 3070, 3080 et 3090 dans quelques résultats soigneusement sélectionnés. Aucun ne mentionne de ray tracing, presque totalement absent du discours du constructeur.

On a par contre eu droit à des mentions (notamment dans certains résultats) de solutions d'O/C automatiques (rage mode) et d'un smart access permettant de mieux profiter d'un Ryzen 5000 avec une Radeon RX 6000. De quoi grappiller quelques pourcents. Il faut donc se méfier des chiffres pour le moment annoncés et attendre les tests.

La stratégie d'AMD est donc claire, comme l'on s'y attendait : la société a utilisé toute la surface de sa puce pour le jeu vidéo afin d'arriver au niveau de son concurrent, grimpant à une fréquence pouvant atteindre 2,25 GHz, mettant de côté le reste : le calcul, le rendu 3D, l'IA, etc. Des sujets mis de côté ou vite balayés.

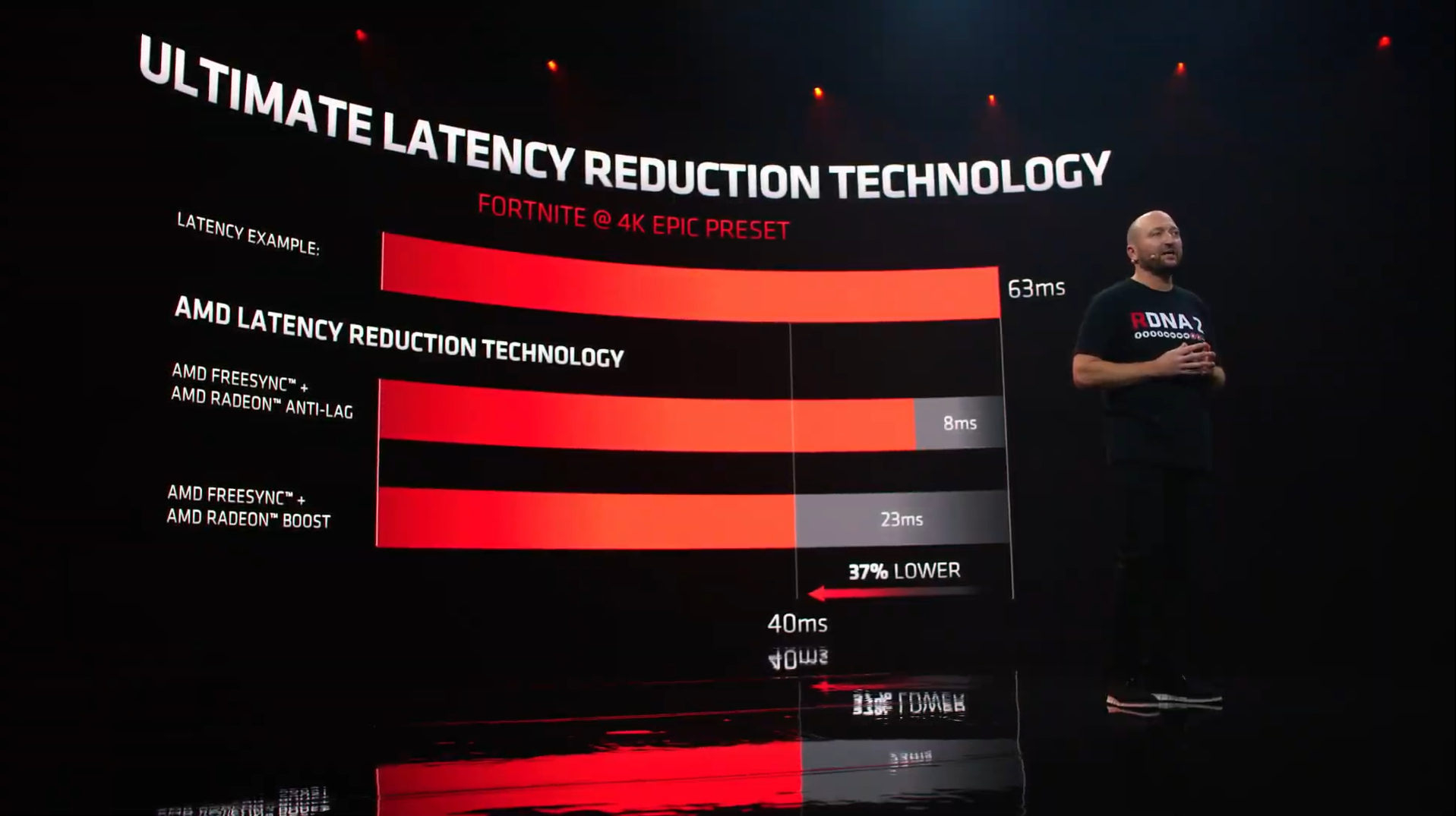

Concernant la latence par exemple, la société rappelle qu'elle propose (comme son concurrent), de la réduire via une fonction dans ses pilotes et Radeon Boost « sans besoin d'une API propriétaire ou de modifier le moteur des jeux ». C'est justement pour aller au-delà de ce que cela permet que NVIDIA a introduit Reflex.

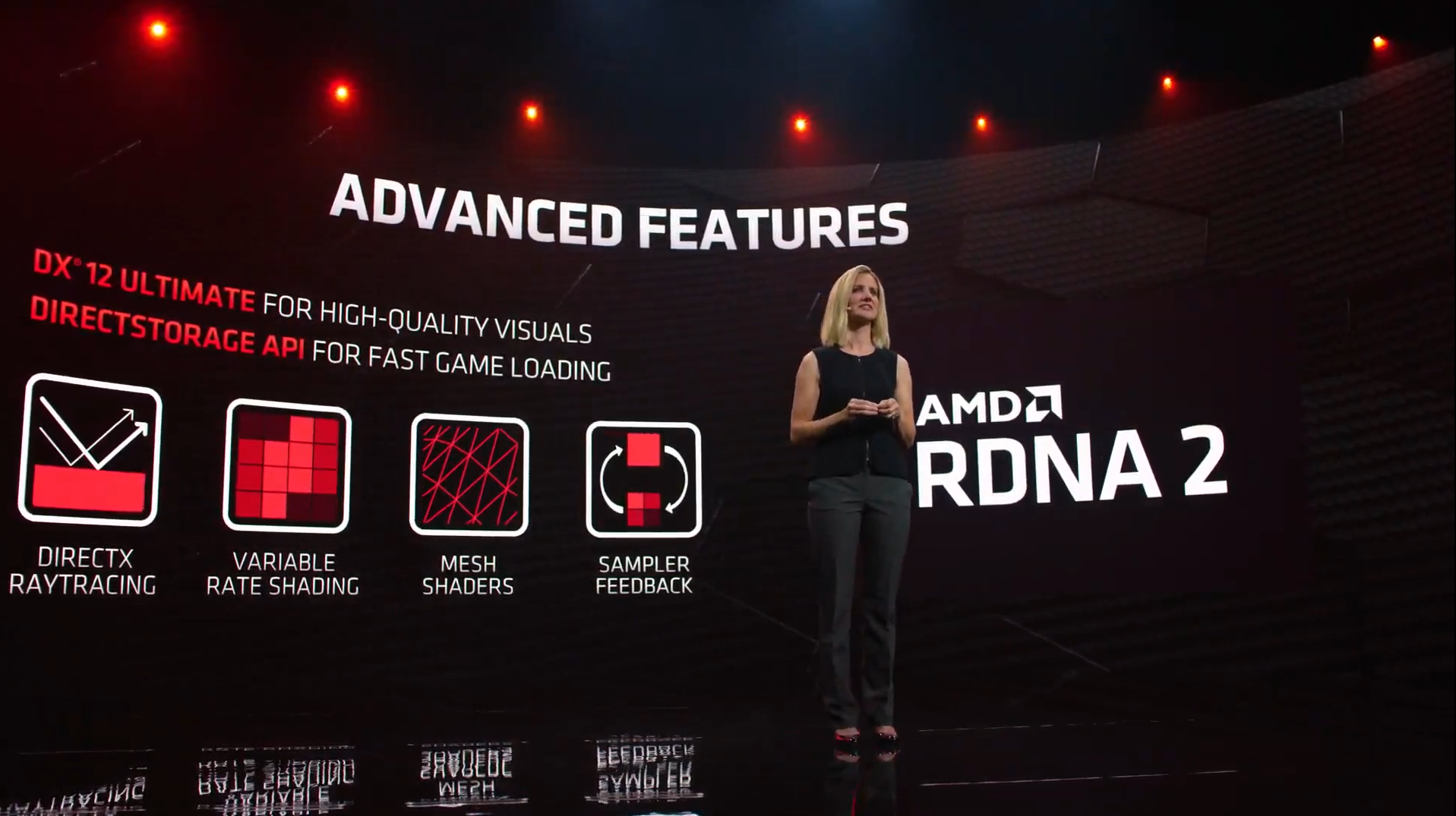

Rien n'a été dit non plus sur le moteur vidéo pour la (dé)compression matérielle des différents formats (AV1 est géré) ou le support (promis depuis des années sur les Radeon) du HDMI 2.1. Les fiches des cartes publiées sur le site d'AMD après la conférence nous apprennent qu'il est bien présent, mais que le DisplayPort reste à la version 1.4, avec un port USB Type-C (comme prévu). Mais aussi qu'il y a autant de « ray accelerators » que de CU.

Dans ses notes de bas de page, il est indiqué que selon ses mesures avec l'exemple Procedural Geometry du SDK de DirectX Raytracing, ses cartes RDNA 2 affichent un résultat de 471 ips en accélération matérielle contre 34 ips pour la versions sans accélération. Des chiffres qui semblent en-deça de ceux de NVIDIA.

Côté tarif, le père des GeForce a usé de son stratagème habituel : laisser de gros écarts entre ses premières cartes pour qu'AMD s'y positionne, ce qui a été fait. Les trois cartes sont ainsi annoncées à 579 dollars, 649 dollars et 999 dollars, contre 519 dollars, 719 dollars et 1 499 dollars pour les RTX 3070, 3080 et 3090. Il faut donc s'attendre à ce qu'une réponse soit rapidement apportée avec des modèles Super/Ti.

AMD mise sur les joueurs et la rastérisation avant tout

Pourquoi un tel écart entre 6900XT et RTX 3090 ? Parce que ce qui fait l'atout du modèle de NVIDIA, à savoir ses 24 Go de mémoire, CUDA ou les différents accélérateurs (RT/Tensor) exploitables dans des applications professionnelles fait encore défaut à AMD. Et combler ces lacunes ne semble pour le moment pas au programme.

L'objectif d'AMD est néanmoins atteint : la société propose enfin des cartes haut de gamme, qui ne devraient pas avoir à rougir de la concurrence... tant que l'on ne cherche pas à sortir des sentiers battus. De quoi contenter les joueurs qui cherchent avant tout un rapport performances/euros.

Il faudra maintenant attendre les tests pour savoir si toutes les promesses faites ce soir sont tenues, et ce qu'il est de la consommation réelle de la carte, la chauffe et la performance des nouveaux ventirads. Pour cela, rendez-vous le mois prochain, les cartes étant attendues pour les 18 novembre (6800 (XT)) et 8 décembre (6900 XT).

D'ici là, nous devrons aussi éclaircir le sort réservé aux actuelles Radeon RX 5700 (XT). Dans tous les cas, la suite est déjà prévue, puisqu'AMD a confirmé être en train de travailler sur RDNA 3.

Commentaires (174)

#1

Et bah j’ai envie de dire pari tenu pour AMD

#2

6900XT bonjour !

#3

Ca sent plutôt bon sur le terrain des performances. Mais ils racontent pas grand chose sur les détails. Aucune info sur le Ray Tracing, ou sur des technos annexes (ML/DLSS/…) là où Nvidia y va dans tous les sens, c’est assez perturbant.

Assez intrigué aussi par la conso annoncée identiques entre la 6800 et la 6900

#4

Si leur chiffres se vérifient, ils ont bien rattrapé leur retard, même si pas un mot sur d’éventuelles capacités RTX.

#5

c’est un poile court, pas de détaille sur le fonctionnement des GPU.

#6

Je ne m’attendais pas à ce niveau de performance. AMD a vraiment assuré et certainement que les marchés remportés pour équiper PS5 et Xbox One ont du leur permettre d’obtenir les ressources nécessaires pour y parvenir.

Pour récapituler :

AMD Radeon RX 6800 est supérieur à la Geforce RTX 2080 Ti et probablement à égalité avec la Geforce RTX 3070 pour une consommation de seulement 250W et un form factor 2 slots..

Prix : 579 USD.

AMD Radeon RX 6800 XT fait jeu égal voir légèrement supérieur à la Geforce RTX 3080 pour une consommation de seulement 300W et un form factor 2 slots.

Prix : 649 USD

AMD Radeon RX 6900 XT fait jeu égal voir légèrement supérieur à la Geforce RTX 3090 pour une consommation de seulement 300W et un form factor 2 slots.

Prix : 999 USD.

AMD a développé un bus mémoire spécifique GPU - CPU utilisable avec les Ryzen 5xxx qui permet de gagner quelques % supplémentaires.

#7

bonjour,

d après la présentation qu il viens de se terminée, rx6800 xt 2a 13% de mieux que la rtx3080 bon faut voir si les test indépendant dise la même chose, pr 579\( et une conso de 250 watts le rapport perf/prix/durabilité/conso m intéresse.

Et pr la rx6900xt ca sera 300watts pr 999\)

#8

Si, les Big Navi incluent toutes les spécifications de Direct X 12 Ultimate dont le Ray Tracing.

#9

Je parlais bien de détails. On sait depuis bien longtemps qu’il y aura le RT.

#10

bas je suis nul en en anglais mais apparemment de ce que j ai compris la carte sera totalement compatible Direct X 12 Ultimate donc pr le raytracing ca devrais le faire et puis jouer en raytracing ca deviendra viable que dans 2 ou 3 ans c’est pas les cartes Rtx3080/Rx6800xt qui nous permettront de jouer en raytracing temp réel mais bon si le raytracing actuelle leur permet de nous faire de belles vidéos de transition de fin de niveau d un jeu vers le niveau suivant je suis preneur ^^

#11

Sur ce point, certainement que les Compute Unit en moins sur les 6800XT sont simplement sur le design de la puce mais désactivés.

#12

Le PrIcInG dE nViDiA eSt CoRrEcT

Je rigole encore de quand on me disait ici que les prix de Nvidia étaient vraiment bas, que je ne voyais que le côté marketing. AMDles a explosé là, non seulement sur le côté perf/prix, mais en plus avec 16Go de mémoire vidéo à chaque fois, quand AMD se permet encore de ne mettre que 8Go sur des cartes où ça devient très limite pour de la 4K/VR.

#13

Ps pr ce qui de Dlss dans les 3 ou 4 technos cité de direct 12 ultimate doit bien y avoir l équivalent dx12ulti du dlss

#14

Même si ce n’est pas encore limitant, AMD inclue 16 Go de GDDR6 sur toutes ses nouvelles cartes.

Si en plus la dispo assure courant novembre, je crois qu’AMD va remporter la bataille du chiffre d’affaires de vente.

#15

de quelle carte parle tu en disant “ que 8 go “?? si tu parle des carte 5700xt pr moi ce sont encore des cartes pr jouer en full 1080, la vrai generation 4K commence seulement avec les Rtx3080/Rx6800xt

vouloir faire du 4k avec des 2080ti/5700xt c est limite je trouve

#16

Je suis sûr qu’AMD sera capable de répondre à Nvidia si ces derniers lançaient des version SUPER avec plus de RAM et de fréquence.

Chez NVIDIA on doit passer une mauvaise soirée ce soir.

#17

Finalement j ai bien fait d attendre au lieu d acheter une 5700xt ^^

#18

Oui je voulais dire Nvidia

#19

Perso j’achète une rtx pour la technologie nvidia. Si AMD ne divulgue pas les benchs en comparatif raytracing c’est qu’il y a un problème de perfs non ?

#20

Bon sur la 6900 XT en terme de placement de prix et de consommation contre la RTX 3090 c’est 1500 USD vs 1000 USD en faveur d’AMD et 300W de consommation, c’est une victoire par KO d’AMD contre NVIDIA.

#21

Sur Borderlands 3 en 4k ultra:

Ça fait cher pour 13fps de plus

#22

Et chez NVIDIA ça fait encore plus cher pour 1x fps

#23

Faudra attendre un peu avant de conclure aussi vite…

1/ attendre les specs complètes

2/ surtout attendre les tests

3/ attendre que les moteurs de jeu et les applis se mettent à bien supporter AMD.

Bref je ne peux pas trop te donner tord pour le moment si tu es pressé. Mais ce n’est pas forcément fichu pour AMD comme tu le prétend.

#24

Ca reste un excellent produit visiblement, surtout côté vram. Je ne sais pas si les possesseurs de rtx 3080 10 Go vont payer à terme cette différence de gddr. Mais sur le raytracing ça ne me choque pas que nvidia reste devant.

#25

J’espère sincèrement que tous les chiffres balancés se vérifieront, ca me manquait une CG AMD.

#26

Perso quand je joue (en 4K ou en VR) les 8 Go de ma 1080 sont tout le temps au max, 16 Go ça permet d’avoir une bonne marge.

#27

C’est inutile, surtout marketing. Surtout dans des GPU sans réelle capacité pour le Compute et le rendu 3D. Espérons sur ces points qu’AMD a gardé des détails d’ici les tests (idem pour le RT).

Oui cça va être le souci de la 6900XT. Trop chère pour être intéressante. Pas assez intéressante pour être comparée à la RTX 3090. Mais c’est parce que son ennemi est à venir ;) Ne pas oublier que NV a laissé de gros écarts entre ses premières cartes. Ce n’est pas pour rien. C’est pour qu’AMD s’y place et répondre ensuite avec de nouvelles cartes. Je comprends d’ailleurs mal le tarif de la 6800.

Ce qui sera réellement intéressant à voir lors des tests : le perf/watt, le niveau de bruit du ventilateur, les performances en RT (dont il est assez inquiétant qu’elles ne soient même pas évoquées).

Attention au “+smart access” dans certains résultats. D’ailleurs quelque chose me dit qu’AMD ne va envoyer ses nouvelles Radeon qu’à ceux qui auront été sélectionnés pour tester Zen 3 Du coup il faudra mettre à jour toute sa machine pour avoir ces scores.

Du coup il faudra mettre à jour toute sa machine pour avoir ces scores.

#28

moi dans mon pc actuel c est une bonne vieille Asus radeon hd 6970(acheter en janv2012 donc on peut dire que j ai bien amorti les 400€ qu elle ma coutée a l époque ^^) mon objectif changer tout le pc complétement y compris le boitier même si mon aerocool xpredateur est en E-atx je cherche un autre Eatx voir Xl-atx

#29

De toute façon AMD a le choix de baisser ses prix si NVIDIA joue à intercaler des cartes dans les interstices ou à sortir des 6x50 pour les contrer donc je ne me fais aucun soucis de ce côté là.

Et en ce qui concerne la cible : Dans le marché de masse des utilisateurs et joueurs PC : Qui fait de la 3D à haute dose, du deep learning ou du R à gros volume et je ne sais quoi ? Les 90% et plus jouent et donc se contrefoutent des Tensor Core ;-)

#30

Ce n’est pas marketing 16 Go, j’ai déjà eu des soucis en VR car ma mémoire vidéo (8 Go) était saturée. Quant à dire que la 6900XT n’est pas intéressante face à la 3090, je ne comprend pas là, on n’a pas dû voir les mêmes chiffres, ni les mêmes prix, ni même conso d’ailleurs…

#31

je comprend pas votre fixette sur le raytracing je dis pas que le raytracing est inutile mais il est pas primordiale non plus sinon depuis le temps qu il existe sur les carte Nvidia ( quand meme 2 ans ) les editeurs de jeu avaient largement le temp de faire un jeu contenant un minima de raytracing et d aprés ce que j ai lu sur different forums les jeux avec du raytracing on en compte actuellement que 2 ou 3…….

#32

et encore sur les 2 ou 3 CONTENANT du raytracing doit en avoir au moins 2 encore en cours de développement….

#33

Le raytracing n’est qu’un argument marketing poussé par NVIDIA lors de la génération précédente. C’est comme DirectX 12 “ultimate”, ça en devient ridicule à ce niveau là.

#34

Oui mais produire en 7 nm une puce de 28 milliards de transistors ce n’est pas gratuit. C’est ce qui explique sans doute les tarifs de départ élevés. C’est pas du yakafokon tarifaire.

On verra les ajustements qui arriveront d’un côté comme de l’autre, mais comme dit plus haut, tout ça c’est juste du positionnement. Ce qui sera intéressant c’est la performance intrinsèque de RDNA 2 face à Ampere dans différentes situations.

Y’a pas de fixette, c’est une carte DirectX Ultimate et AMD ne parle pas des performances RT. En soi c’est un indicateur intéressant de sa stratégie. Après ceux qui s’en foutent sont la cible d’AMD qui a fait le choix d’une puce sans doute utilisée à plein pour du FP32 et donc sans unités dédiés à d’autres types de calcul, ce qui lui permet d’être plus agressif avec de bons résultats en raster.

PS : la plupart des prochains gros titres utiliseront DXR.

Je ne dis pas que 8 Go sont toujours suffisant. Je dis que 16 Go ne sont jamais nécessaires. Mais AMD était sans doute coincé par son but 256 bits avec du 8 ou 16 sans alternative possible. Ce qui explique ce choix, qui n’a pas trop d’intérêt sur de tels produits (sauf marketing + éviter les 8 Go comme évoqué).

DirectX 12 Ultimate c’est une évolution de l’API de MS. Utilisée par les Xbox Series, Turing, Ampere et RDNA2. Et celka ne couvre pas que le RT (notamment VRS aussi qui manquait également à AMD).

#35

Vu la sortie des nouvelles consoles en ce moment, je pense que les jeux des 4 ou 5 prochaines années seront conçus avec l’objectif de 10 TFLOPS et pas beaucoup de Ray tracing

#36

Tu dois très mal compter alors 😀

Perso si je change de CG c’est justement pour le Raytracing, et surtout le DLSS qui permet d’améliorer les performances.

Mais sinon c’est cool si AMD revient dans la course.

#37

Ne pas oublier non plus que les résultats de la 6900XT sont “overclockés” avec le Rage Mode. Donc, ce sera clairement pas limité à 300W.

#38

On en reparle à la sortie de WD Legions et Cyberpunk

Oui faudra faire le tri dans les notes, comme pour l’histoire du smart access évoqué plus haut.

#39

Perso j’achète une rtx 3080 pour le raytracing. Sinon ma gtx 1080 me suffirait encore avec quelques compromis.

#40

Je comptais partir sur une 3080, je vais quand même attendre un peu histoire de voir l’évolution des prix, et surtout ce que valent réellement ces cartes AMD, ça pourrait me pousser à revoir mes projets.

Ma 1070 commence tranquillement a accuser le coup avec un écran 1440p.

#41

Je pense attendre encore une ou deux générations, je ne suis pas convaincu ni par amd ni par nvidia.

#42

Je garde aussi ma 1080, la compétition n’a que du bon, j’attends la prochaine gen

#43

Et sinon des CG abordablent c’est pour quand ?

#44

Elle est ou la 6900 XTX ?Vouloir du calcul alors que ces GPUs ne sont pas faits pour ça et que c’est CDNA qui occupera ce créneau

#45

Pour info j’ai mis à jour l’article avec quelques détails supplémentaires publiés depuis sur le site d’AMD

Il faut toujours attendre (les tests notamment ;))

(les tests notamment ;))

C’est quoi qui serait convaincant selon toi ?

Sans doute pour l’année prochaine, le temps de décliner. Après comme la série 3060 arrivera vite chez NVIDIA, il y a fort à parier qu’AMD suivra aussi sur ce terrain.

Oui c’est une des différences d’AMD à ce niveau, de segmenter selon le type de carte. Mais CDNA c’est du produit serveur essentiellement. AMD avait d’ailleurs sorti la Radeon VII comme un produit “créateur”. Le souci ce n’est pas tant qu’il n’y ait pas de possibilités en compute, c’est surtout qu’AMD n’en parle pas (comme si ça n’existait pas), tout en sortant des cartes avec 16 Go de mémoire.

#46

Je suis impatient de vous lire, comme d’habitude !

#47

Aux dernières nouvelles AMD avait assez peu de cartes de prévues pour le lancement, pas sûr qu’on publie le jour de la levée de NDA. On verra si on arrive à se fournir des cartes d’ici là

#48

Je lis les commentaires et je lève un sourcil parfois. Comment on peut parler de victoire ou de meilleurs alors qu’il n’y a aucun test INdépendant de sortie ?

Pour le moment ça semble être pas mal mais c’est à voir.

Par contre comparer la 6900XT et la 3090, ça ne sert à rien. Comme le dit David, elle ne vise pas le même public et surtout, il faudrait voir comment la nouvelle venue s’en tire sur des softs pro.

#49

Bonjour,

Finalement AMD se cale sur les prix de NVIDIA, donc rien de vraiment abordable.. les tarifs restent élevés.

En plus faut voir les tarifs en France qui ont une tendance à la hausse.

Peut-être qu’avec le temps la concurrence jouera plus pour revenir à des tarifs plus bas.

Jouer en 4K pour 200 € de plus que les nouvelles consoles c’est vraiment trop. AMD et NVIDIA prennent les joueurs PC pour des vaches à lait.

#50

Je m’en doutais un peu, mais je suis pas si presser t’inquiète :)

#51

Vis ma vie

Oui et non, AMD se positonne entre les cartes de NVIDIA sans toujours s’aligner. La 6800 est par exemple plus chère (en tarif public annoncé) que la RTX 3070 qui est son équivalent selon les chiffres d’AMD (avec smart access, donc sans doute dans la tranche optimiste).

Il faudra surtout attendre des modèles avec un GPU inférieur. C’est ce qui semble plomber la 6800 d’ailleurs, on verra comment ça évoluera comme dit plus haut.

Vache à lait c’est quand tu prends les gens pour des idiots, je doute que les joueurs soient perdants dans l’évolution tarifaire des GPU sur cette génération ;) Que les consoles permettent déjà de jouer convenablement en 1080 à 60 ips avec une qualité d’image élevée, on parlera ensuite de 4K

#52

Et moi qui attends les version XX60

#53

Perso je suis plus pour une carte qui me permet de faire tourné du 4K 60 ips en ultra, comme ca je pourrais faire tourné mes jeux sur mon écran 1080p en 75hrz (stable) + freesync pendant un long moment ^^.

Psk au final la 4k c’est bien beau mais au final on nous dit ouais 4k 60 fps mais dans les fait les jeux auront du 60fps que dans certaine zone et on aura droit au stuttering et chute de fps dans les zones mal optimisée.

#54

Économie circulaire, tu achètes une bonne carte de la génération précédente d’occasion. Dans un scénario où on est pas avec des contraintes particulières genre embarqué ou mobile, je ne vois pas l’intérêt de faire des cartes peu puissantes sur chaque génération alors que le marché de l’occasion rempli largement les besoins des petits budgets.

#55

mouais bof, la 6800 xt est 10-20% meilleure que la 2080ti , mais consomme 20% de plus. Donc, elle aurait la meme efficacité energétique qu’une carte sortie y a deux ans. Assez decevant.

J’attend plutot la 6700 xt , j’espere que le rendement sera meilleur.

#56

Je n’ai pas l’effet wow, qui me donne envie. Le ray tracing m’a été vendu au départ avec une qualité photographique digne des trailers, mais je suis déçu par ce que je vois pour l’instant.

#57

Le RTX ça n’existe pas il n’y a que DXR et toutes les cartes présentés par AMD font du raytracing. Contrairement à Nvidia, AMD n’a pas besoin de bullshit core pour faire du RT car toutes les unités de calcul peuvent le faire.

#58

10Go en 4K oui c’est peu, en 1440p c’est assez futureproof

#59

Décevant de ne rien voir sur un equivalent DLSS, une techno qui a déjà 2ans..

A l’époque ils avaient sorti vite fait un algo de sharpening en écran de fumée mais la nada

#60

Euh, les GeForce GTX supportent DirectX Raytracing depuis un moment. Ce n’est pas une question de bullshit c’est juste que les RTX ont des unités dédiées pour une partie du traitement (comme lRDNA 2 à priori même si on ne sait pas encore exactement de quoi il en retourne).

J’ai pas un test 4K qui fait de mauvaises perfs du fait de la mémoire. Le souci en 4K c’est la puissance de calcul nécessaire, pas la mêmoire.

Bah ils vont sans doute jouer sur leur SuperResolution Fidelity FX histoire de retenter l’arnaque (réussie) avec leur filtre de sharpening, emballé c’est pesé, ça passera sans souci chez les Youtubers

#61

Le Ray Tracing apporte un plus au côté photo réaliste mais en aucun cas c’est lui qui l’apporte. C’est le moteur du jeu et surtout la puissance de calcul dispo.

#62

Pour l’instant 10Go ça me semble assez, mais pour 2021, 2022,2023 avec les jeux de la génération PS5/XSX ça risque d’être short, non?

#63

” leur filtre de sharpening “ les test que j ai lu sur le net démontraient bien que ” leur filtre de sharpening, “ était efficace et que lui au moins il floutait pas la moitié (au minimum) de l image comme le faisait Dlss version 1 lol ( heureusement corrigé avec la version 2 de Dlss )

#64

Pour moi, la 6900XT ne concurrence en aucun cas la 3090. La cible des 3090, c’est pas le gaming mais plutôt les utilisateurs de Cuda. La 6900XT est juste une débauche de performance qui ne sera pas exploité et qui ne justifie pas de payer le double de prix alors que l’évolution des générations futurs de GPU la rendra obsolète en terme de puissance avant de l’avoir amorti.

#65

C’est marrant, c’est exactement l’effet que me fait le DLSS…

#66

houlà j’espère que Joto peux courir vite , car je crois que les fanboys Nvidia sont déjà à sa poursuite mdr

#67

Même pas peur ;)

;)

#68

Merci de dire ce que j’ai dit d’une autre façon… Et les RT Core c’est de la daube ils ont une latence de fou

#69

Par contre si ils te rattrapent pour le “ même pas mal ” ca va être difficile

#70

Avant de dire “même pas mal” faudrait déjà avoir une réponse

Et je ne m’inquiète pas de la réponse, je m’en régale même d’avance

#71

Le DLSS2, c’est de la bombe

#72

Ah oui… je ne me rendais même pas compte… dis comme cela, ça ressemble à une puissante substance

#73

#74

L’égal de quoi, je ne sais pas, mais si ça cause pas de soucis… faut que les fanboys Nvidia restent tranquille alors

#75

La 2080ti à été achetée par beaucoup de gamers, plein de gens ont de l’argent à dépenser. De plus pour du after effect / premiere pro avec beaucoup d’effets avoir beaucoup de mémoire vidéo peut être utile (mais j’attendrai les tests de puget pour voir ce que ça vaut)

Sinon, il suffit que le PC serve à autre chose que seulement du jeu (ce qui n’est pas si rare quand même), la mémoire vidéo disponible sera déjà amputée par d’autre applications, donc 16Go en 2020 c’est pas juste marketing.

#76

Enéfé, je suis étonné que tout le monde s’emballe sur des slides marketing avec des benchs sans réel contexte ! J’ai l’impression de voir des électeurs de Trump devant Fox News. Ils vendaient déjà la Fury X comme la carte pour le 4k qui écrasait la concurrence.

C’est vraiment super si il n’y a pas de loups mais attendons les tests. C’est une présentation courte, peu de détails, tout passe très vite, absence totale sur le raytracing : ils ne me rassurent pas forcement.

Je trouve que le plus impressionnant est la conso, si c’est véritablement 300 max c la plus grosse claque que se prend Nvidia.

#77

Si, c’est juste de marketing…. Si tu veux entrainer des modèles tu prends une 2080ti , une 3090 ou une carte spécialisée

#78

C’est pas trop ce que les stats steam disent. La 2080ti est juste la carte la moins possédé avant de passer aux GPU de laptop.

https://store.steampowered.com/hwsurvey/Steam-Hardware-Software-Survey-Welcome-to-Steam

Ensuite, je te rejoins sur le cheminement, mais pas sur la conclusion. Il suffit que le PC serve à autre chose que du jeu pour que AMD s’effondre. On verra les tests mais si AMD vend sa carte aussi peu cher, c’est parce que plus cher, elle ne trouvera pas d’acheteur.

#79

Je suis le seul à trouver ça suspicieux voir malhonnête de présenter des benchs sur du FPS Max et pas sur de la moyenne voir du P1 ?

#80

Non. Mais l’important c’est que l’acheteur ait le doute ;) Pour le reste, je l’ai déjà dit mais le besoin en calcul grimpe bien plus vite que le besoin en mémoire (il suffit de regarder les TFLOPS d’il y a 3 ans et la mémoire d’il y a trois ans).

Quand tes jeux nécessiteront 16 Go de manière courante, 20 TFLOPS ce sera assez pour 20 ips Et comme je le répète, la mémoire ne fait pas la performance. La Radeon VII est, en la matière, le meilleur des exemples.

Et comme je le répète, la mémoire ne fait pas la performance. La Radeon VII est, en la matière, le meilleur des exemples.

Ah ben vu que c’est un filtre de sharpening, c’est assez logique qu’il améliore la netteté de l’image. Mais pour autant, cette fonctionnalité (que NVIDIA proposait dans ses filtres avant de l’intégrer plus directement à ses pilotes) n’a rien à voir avec DLSS 1 ou 2.

Pour DLSS, oui la version 1 était mauvaise (on l’a dit). Comme la version 2 est un bon outil (on l’a dit aussi).

Si, sauf si ta carte est exploitable massivement dans des applications Pro. Le souci d’AMD, c’est qu’ils sont en retrait sur ce point. C’était un de leur pari avec la Radeon VII qui a montré ses limites. Ce sera pareil ici, surtout que ce n’est même plus dans leur discours.

On verra comment ils s’en tireront avec OpenCL, notamment dans des applications de rendu 3D. Infinity Cache peut être un paliatif intéressant dans ce contexte et la Radeon VII pouvait avoir quelques fulgurances. Mais bon, la BP mémoire ça ne fait pas tout non plus. En tous cas ça ne transforme pas 20 TFLOPS en 30 TFLOPS+.

Le 7 nm leur confère forcément un avantage. Comme le fait de consacrer toute la puce ou presque au rendu 3D. Pour les 300 watts, ça me parait réaliste au regard du reste, mais il faudra voir en pratique. La consommation réelle ce n’est pas le TGP (ou équivalent).

L’autre point où il faudra être méfiant c’est le refroidissement. Parce que la Radeon VII c’était 295 watts et c’était une turbine. Là aussi ils ont peut évoqué le sujet, donc il faudra voir, mais espérons qu’ils auront bien avancé sur le sujet depuis les précédentes générations.

Oui, mais 1% du marché c’est déjà pas si mal pour une carte à 1200 €+ sans parler du fait qu’il y a eu pas mal de déclinaisons de Turing (2080, Super, etc.). Mais je te rejoins sur le fait que même si c’est une carte qui s’est bien vendue, ça reste une carte plus orientée calcul que JV.

Disons que la 6800XT semble la seule réellement bien placée. La 6900XT existe pour celui qui veut avoir la plus performante de la gamme, et se donner l’impression d’avoir une 3090 pour bien moins cher. Mais comme tu le fais remarquer, si AMD a tapé si “bas” c’est parce qu’ils savent qu’ils manquent des vrais atouts d’une telle carte, qui font que certains payent le double pour 6 TFLOPS de plus. Notamment les 24 Go de mémoire, NVLink, la stack logicielle, etc.

Non c’est classique dans les présentations de ce genre. Et tant que ce sont les mêmes conditions pour tout le monde c’est honnête (modulo l’activation de telle ou telle fonctionnalité, ce qui semble être le cas ici).

#81

Ah bah la mémoire quand elle est saturée, il en faut plus.

Après une carte à 30Tflops et 10GB, ça fait pas bcp.

Ma 1080 Ti sorti en 2017 à 11GB.

#82

Deux points:

1- Quid des performances en mining, avec l’impact éventuel sur le marché lors de la mise en vente?

2- Sachant que la fessée monumentale assènée par les Ryzen 5900 X et 5950X (aux flagships 14nm++++ Intel) ont défrayé la chronique lors des bench post NDA dans la webpresse, et non explicitement mise en évidence lors de la présentation, peut on s’attendre à une surprise analogue en jeu?

#83

Cherche il va juste te répondre que 16 c’est quand même juste marketing. Basé sur quoi, je sais pas, mais quand je lui dis que je sature à 8 Go il répond juste que c’est marketing et apparemment 10 Go c’est large pour les 2 années à venir… Je sais pas pourquoi il ne veut pas entendre que c’est déjà limite aujourd’hui et que ça va devenir encore plus problématique mais bon… Les PC sont souvent multitaches et il y a plus d’une application lancée à la fois.

#84

Après, si 8Go c’est pas assez, suffit de baisser les textures d’un cran. ^^

#85

Mais, en même temps que tu joues, tu vas lancer quoi comme appli qui va occuper ta mémoire vidéo ?

Je me pose la question depuis ton précédent commentaire et je ne vois pas. Si t’as des exemples concrets, je suis preneur, car curieux :)

#86

Bref, AMD apporte encore une fois de la stagnation en ne proposant pas l’évolution qui saute aux yeux qu’est le Ray Tracing et en restant sur la rastérisation, qui plus est avec des puces qui ne sont clairement pas concurrentielles comme l’a montré le rédacteur de l’article; on sent qu’AMD a juste placé des produits pour géner NVIDIA et empecher le RT d’arriver en masse; comme au niveau des CPU avec sa logique de socket unique sur plusieurs générations, AMD tue la créativité et empêche de saines évolutions dans le hardware, au contraire de ses deux concurrents qui ont apporté tellement dans la décennie précédente.

C’est une honte.

#87

#88

Ah mais je me débrouille, ou parfois je ferme d’autres applications, mais c’est pas délirant du tout de proposer 16 Go fin 2020 quand on propos des cartes pour la 4K et la VR (où les nouveaux casques ne vont que monter en résolution aussi). L’idée c’est que les gens ne rachètent pas de GPU tous les 2 ans, et que ça puisse durer jusqu’à 2024⁄2025.

#89

La 2080 Ti n’est pas la plus répandue c’est vrai mais tu exagères un peu, elle reste plus répandue que la RX 5700 XT ou que la RTX 2080 SUPER par exemple.

Je suis par ailleurs un peu étonné de voir les 1050 Ti et 1050 truster les 2ème et 3ème places, probablement parce que c’est un classement mondial et que tout le monde n’a pas le même budget à y passer.

Quant à ma CG (Vega 56) elle n’est même pas dans la classement tellement elle a bidé. Pourtant j’en suis bien content, surtout vu le prix que je l’ai payée. Bref, je m’égare…

Quant à ta conclusion “AMD ne vend pas cher parce que si ils vendaient plus cher il n’y aurait pas d’acheteurs” j’ai envie de te répondre de regarder du côté des processeurs Zen première génération : AMD étaient sûrs d’eux, ils ont sorti de bons produits à un prix très compétitif, pas parfaits du premier coup peut-être, mais ils sont revenus dans la course. J’ai envie de croire (oui j’assume, je n’en ai pas les preuves pour le moment) qu’AMD sort à nouveau une gamme compétitive à prix assez bas pour qu’on daigne s’y intéresser.

#90

D’autant qu’il me semble que Windows met aussi en sourdine la plupart des autres apps lorsqu’un jeu est lancé en plein écran ? C’était d’ailleurs le sujet du “mode jeu” de Windows 10 mais qui ne semble pas super bien fonctionner, autant fermer les apps gourmandes avant de lancer le jeu, plus simple.

#91

Alors le workflow d’hier :

. Blender : Environ 40 mo le fichier, un png de 400 mo d’une vue satellite haute résolution et un patté de maison en résolution moyenne via le plugin d’import google map. Quelques textures et d’autre objets modélisés.

. Photoshop : Un fichier d’environ 300 mo / 1.5 go en 4k avec au moins 40 calques,

. Unity : La map d’importée ( sans gmap ) + une tonne de textures 2k ( haute densité ) et des objets.

. Firefox : J’écoutais bouffe merde TV et je surfait sur nxi.

Mais bon on est d’accord ça touche peu de monde. Après je vois clairement l’avantage d’avoir mis un peu de sous pour chopper un octocore + une cg avec 2 go de ram en plus. Avec un dual / quad et sans les 2 go y’aurais pas moyen de faire tout ça.

Peut être qu’il faudrait pouvoir upgrade la ram des gpu.

#92

On peut avoir plusieurs écrans hein… Ce n’est parce qu’un jeu est en plein écran qu’il ne se passe rien à côté. Perso avec 8 Go je ne crois pas avoir saturé, mais je suis régulièrement à 7 ou 7.5 Go de pris.

#93

il me semble qu’il n’y pas eu d’annonce ou de road map sur le moyen de gamme. Du coup, pour un achat à 3 mois, la meilleur carte AMD moyen de gamme reste la 5700xt (Sapphire) pour env. 450€.

J’ai bon?

#94

Elle va baisser en prix, sinon réflexe occasion hein.

#95

Elle va baisser en prix? La RX 5700XT ou les CG series RX 6000 ?

#96

Plutôt de parler à la troisième personne d’un rédacteur, il vaut mieux apporter le moindre début de preuve. On tombe sur des Raoults de la Vram ? Aujourd’hui absolument aucun jeu n’est véritablement handicapé par 8Go. La seule chose que l’on peut remarquer, semble-t-il, est que certains titres allouent toute la Vram disponible mais ne l’utilisent pas (préemption comme peuvent le faire les OS). La raison des 16 Gb est la taille de bus et un choix marketing (difficile de vendre une CG qui a moins de Vram que les précédentes générations). Les joueurs continueront à vouloir acheter en 5950x plutôt qu’un 5600, se jetteront sur les écrans 360 Hz, les souris 50000 dpi, changeront de SSD pour gagner 500Mb/s sur un bench séquentiel… L’acte d’achat ne se base que très peu sur le rationnel.

Entre les uns qui veulent absolument défendre Nvidia, AMD, Apple, Fleury Michon et ceux qui avalent toute communication intéressée; les arguments les plus spécieux sont de sortie.

Il me semble que les 16Gb, c’est pas plus utile pour un gamer que les 20Gb de Nvidia jusqu’à preuve du contraire.

#97

Il n’y a jamais eu besoin de GPU pour faire de la 3D, tout ce que fait un GPU est possible avec un CPU. Je jouait à Flight Simulator 3.0 avant même que les cartes d’accélérations 3D n’existe. Certain ici ont surement jouer à Quake sans avoir de carte 3dfx Voodoo (Id tech 2/Quake Engine, père d’un grand nombre de moteur 3D, dont le Source Engine)

Oui, tu peux faire absolument tout faire avec une unité de calcul générique, mais tu ne le fera pas forcément de manière aussi efficace qu’avec une unité de calcul dédié. Les RT core sont des unités de calcul dédiés au calculs pour le raytracing, c’est un circuit spécialisé dans un algo bien précis (ici, si je me rappelle bien, les coordonnée “d’impact” des rayons) qui le fait plus rapidement, avec une plus gros débit, en consommant moins et de manière concurrentiel (parallèle) qu’avec des unités générique.

Parce que niveau unité générique de calcul, ce n’est pas des guignols chez NVidia, tu as quand même en face les pères de Cuda principal promoteur du GPGPU (OpenCL et AMD/ROCm sont inexistants) et qui est massivement et pratiquement exclusivement utilisé dans les grilles de calculs sur GPU. Ils ont donc théoriquement plus d’intérêt à pousser les unité générique de calcul tellement ils sont dominant dans le domaine alors Intel semble vouloir sa revanche avec une réponse plus solide que la première fois.

#98

Photoshop stocke le fichier en vram ? Je ne comprends pas mais je n’y connais pas grand chose

#99

Il y à certains calculs qui passent par la carte graphique comme beaucoup de soft 2d / vidéos. Donc plus tu à de ram dans une carte graphique pour travailler mieux c’est.

#100

Le classement des résolutions est intéressant: presque personne joue en plus de 1080p (11%), et pour ça une GTX970 de 2014 est suffisant aujourd’hui, la 4k (2,27%) ce n’est pas pour demain

#101

Oui et, tu as un seul cas qui montre un début de saturation réelle parce que la mémoire disponibles est insuffisante ? (je veux dire pas un chiffre de mémoire allouée sorti d’on ne sait où). Ce que montre bien les RTX 30 c’est justement que tu peux aller taper de la 4K/8K avec ton GPU qui reste encore la contrainte de performances, pas sa mémoire.

Pour le mining il faudra sans doute attendre une optimisation des clients, mais c’est sans doute un des usages visés par les 16 Go de mémoire ;) Après RDNA2 n’est pas fondamentalement différente de RDNA à quelques éléments près (dans sa structure générale quoi). Donc l’adaptation devrait être aisée.

AMD et NVIDIA ont simplement une stratégie différente, qui vise des clients et besoins différents. AMD sait qu’il ne peut pas aller en frontal sur tout ce que développe NVIDIA, du coup ils font une puce de JV assez monolithique dans sa conception, sans accélérateurs spécifiques (mais avec du cache), pour taper fort là où NV consacre une partie de sa puce à des unités tierces.

Du coup même si RDNA(2) est moins efficace, ils ont des résultats similaires. Par contre tout ce qui est RT, IA, rendu, etc. sera en retrait, sans parler de la couche logicielle. C’est un choix de court terme, mais qui se défend parce qu’il peut servir l’objectif N°1 d’AMD : gagner en pdm et monter en gamme. Avec 20% de pdm et seulement Navi sur le marché, ça ne peut qu’avancer dans le bon sens et les RX 6000 lui permettront d’atteindre ce but.

Vanter un produit exceptionnel avec des chiffres délirants, c’est une pratique de marketing, de conférence de presse comme celle d’hier. Les objectifs commerciaux et stratégiques sont le plus souvent bien plus subtiles.

Tu as un seul cas concret qui appuie le besoin en 4K ou VR ? Pour 2024⁄2025, on en reparlera à ce moment là, et on verra comment s’en tirerons des GPU avec 16 Go de mémoire et 20 TFLOPS de calcul dans 4⁄5 ans ;)

Attention quand même a deux choses. Quand Zen est sorti les prix étaient elevés. AMD a très rapidement changé sa position la-dessus, et tant Zen que Zen+ ont rencontré un succès aussi parce qu’ils ont été rapidement bradés.

C’est avec Zen 2 puis Zen 3 qu’AMD a progressivement remonté ses différentes marges. On le voit avec la série 5000 qui a une price list similaire à celle d’Intel pour son lancement.

Malgré ça, AMD a encore un souci d’image et le réflexe “ils doivent proposer mieux pour moins cher pour convaincre” est encore assez présent en pratique. On peut le regretter mais il faut faire avec. Cela change peu à peu, et l’inertie est différentes selon les marchés (parce qu’il n’y a pas que le retail dans la vie). Mais ça prend des années. Pour comprendre l’ampleur de la tâche d’AMD, il suffit de regarder leurs résultats et ceux d’Intel (bien qu’affaibli).

D’alloués, pas d’utilisés.

Oui, comme dit plusieurs fois : une grande quantité de VRAM quand tu fais autre chose que du jeu, c’est légitime. Mais il faut aussi que ton GPU soit apte à faire autre chose que du jeu et que ce soit supporté par les applications que tu utilises au quotidien.

#102

AMD n’ayant pas (encore?) les capacités de R&D de Nvidia, RDNA2 a été pensé comme une archi commune console et PC.

Dans cette optique, la priorité donnée à la rasterization par rapport au ray tracing dans le “budget transistor” disponible me semble pertinent compte tenu de la durée de vie d’une architecture console et des contraintes de dissipation/encombrement/prix

#103

Je n’y connais rien mais l’ensemble du fichier 2d des calques ne va pas en vram (on utilise photoshop je regarderai), par exemple pour de l’encodage accéléré Hevc via Nvenc le fichier vidéo ne va pas dans la vram… J’ai déjà fait ce test que le fichier fasse 2Go ou 50Go ça ne change rien.

#104

Un conseil de vie “il ne faut pas déduire trop rapidement de chose que l’on voit”…

Je ne connais pas grand chose en dev 3d/Dx mais potentiellement le fait que la majorité de la mémoire est allouée ne veut pas dire qu’elle est utilisée / utile ou à un impact sur les perfs. Un dev doit pouvoir faire un gros Malloc (un truc de vieux) pour tout préempter pour des bonnes ou mauvaises raisons. C’est pour cela qu’il faut parfois prendre avec circonspection des déductions trop rapide

#105

Désolé, je me rends compte que je répète ton explication sur l’allocation/préemption

#106

Je n’en ai pas non, après les jeux “next-gen” ne sont pas encore sorti. ;)

#107

Sympa la consommation plus basse que Ampere.

Ça laisse présager du bon pour les cartes d’entrée de gamme.

J’ai du mal à comprendre le positionnement de la 6800.

Perso je ne me vois pas acheter un GPU d’occasion. C’est toujours le composant qui me lache en premier.

Je trouve fort l’optimisation Ryzen / Radeon. C’est assez malin, surtout avec Zen3.

En tout cas cette présentation explique pleinement le changement de stratégie tarifaire de Nvidia.

#108

Il manquait des mots dans ma réponse. Désolé pour les multiples posts.

Correction :

C’est pour cela qu’il faut parfois prendre avec circonspection des déductions trop rapide sur la consommation que ce soit pour la Vram, les systèmes d’exploitation voire des navigateurs. A minima faire le test “que se passe-t-il si je colle moins et si je colle plus de mémoire”.

#109

En faite, ça va dépendre de la façon dont c’est fait. Dans le cas d’un calcule sur une images/fichier 2D GPU peut être vu comme un processeurs capable d’appliquer le même calcule sur l’intégralité des pixels d’un ou plusieurs calques. Mais pour faire ces calculs, il va devoir charger les calques en question dans sa mémoire, ainsi que des résultats intermédiaires (même si je t’avoue que parfois, je ne sais pas trop comment c’est géré). Ca, c’est le cas où tu veux applique un filtre sur l’intégralité de l’image en une seul fois. Cependant, il est possible dans certain cas, de découper l’image en bloc, et de faire le calcul par bloc (si le rendu est visible en temps réel, ça donne souvent une animation de “scan”).

Une vidéo, c’est une image (tenseur) en 4 dimensions : hauteur, largeur, couleur, temps. J’imagine que l’encodage découpe en bloc de temps (peut-être des blocs avec chevauchement) et procède ainsi. Tu n’a donc pas besoin de charger l’intégralité de la vidéo dans la VRAM. Par exemple avec 380Mo (60×1920×1080×3 octets) tu as 60 frames de vidéo FHD non compressé en mémoire. Il me semble qu’un group of picture est indépendant et ne fait que 8 à 16 frames, donc avec ces 60 frames, on est large. Il y a même moyen d’être plus efficace et d’utiliser un buffer circulaire pour avoir quelques seconde de vidéo en permanence en mémoire que tu charges en continue, et de ne travailler que sur la fenêtre qui t’intéresse dans ce buffer.

#110

Ah oui le fameux “vous allez voir ce que vous allez voir” pour prédire quelque chose démenti par toutes les générations précédentes et tendances de marché Après comme dit, je n’empêche personne de faire ses choix en fonction de la VRAM pour du jeu. Certains ont choisi la Radeon VII sur ce critère notamment. Je ne fais que livrer des infos, chacun voit midi à sa porte.

Après comme dit, je n’empêche personne de faire ses choix en fonction de la VRAM pour du jeu. Certains ont choisi la Radeon VII sur ce critère notamment. Je ne fais que livrer des infos, chacun voit midi à sa porte.

Ne jamais comparer ces valeurs d’un constructeur à l’autre, ça n’a aucun sens. Ce qui en aura, ce seront les relevés ;)

Les stratégies tarifaires sont toujours la dernière chose figée dans le marbre. Tant pour AMD que NVIDIA. AMD s’est positionné fonction des RTX de série 30, connue depuis l’annonce de septembre. Sur Radeon comme sur Ryzen (et comme ses concurrents), si AMD peut vendre plus cher, ils n’hésitent pas à le faire.

#111

Shadow of Mordor -> jeu de 2014 explosait les 3Go de ma GTX 780 pourtant sorti en début de gen PS4/Xbox One

J’imagine que le besoin de mémoire vidéo va être croissant sur cette même génération.

#112

J’ose espérer que dans 4 ans une carte à 800E chez nous ça tienne encore la route quand même. D’ailleurs ma 1080 acheté en mai 2016 tient encore très bien, c’est pour ça que je la garde jusqu’à la prochaine gen. Mais on se dit rdv dans 4 ans

#113

Mon dernier écran PC, un 27 pouces 144Hz VA… FHD.

Autant pour travailler le QHD fait clairement la différence sur un 27 pouces. Autant pour jouer, je trouve que le prix à payer (en € et FPS) est trop élevé pour le peu de différence en terme de rendu final . Surtout quand c’est pour se manger de l’upscale DLSS à la fin…

Bref

#114

En fait ça dépend beaucoup de ta vision. Je ne vois pas de différence au dessus de 120 fps (et qu’on ne vienne pas me parler de réglages ou de framerrate capé dans certains jeux, j’ai eu un écran 120 Hz et de quoi suivre niveau cg, je ne vois pas la différence). Autant le changement de résolution me saute directement aux yeux, tout est bien plus net, lisible et moins fatiguant pour moi.

J’ai bien conscience de ne pas faire partie de la majorité, masi ça m’agace un peu le “c’est mieux c’est indiscutable” parce que ce n’est pas vrai pour tout le monde.

#115

On peut toujours jouer sur de veiilles cartes, ce que je dis, c’est que quand le besoin de VRAM augmente réellement, celui en compute explose comparativement. Donc oui dans 4 ans tu pourras toujours jouer avec une 3080⁄6800(XT), mais pas là où 16 Go de VRAM seront nécessaires.

#116

bonjour,

pourquoi beaucoup de personne visent les ecrans 21⁄9 ?? quand je vois les screens d écran 21⁄9 je me demande comment ils arrivent à joués alors qu ils ne voient presque plus, ni le sol ni le ciel ????? 16⁄9 légérement trop haut et 21⁄9, 3 fois trop large un compromis du style 21⁄11 serait equilibré ca donne du 1.9090909090……… pour 16⁄9->1.7777777777….. et 21⁄9->2.333333333……

#117

C’est bien pour ça que je précise « je trouve que », c’est mon avis perso. Et cet avis dépendra aussi beaucoup du type de jeu. Pour faire tourner un Witcher 3 , on s’en fou d’avoir 120fps. Par contre, un mono-maniaque overwatch voudra ses 90fps minimum constant. D’ailleurs je viens de commander le remplaçant de mon 2ème écran et c’est un QHD 27 pouces IPS 75Hz (promo dell si ça intéresse quelqu’un) pour bosser et si je veux me faire un jeu solo contemplatif ou rts.

Sur le côté fps, au déjà de 90fps, je (moi) ne vois plus de différence. 60 ça peut passer sur des jeux pas trop nerveux mais il faut que ça soit 60 constant. Rien de plus rageant de se manger des freeze des que l’action arrive (coucou warzone avec mon ancien côté i5-6600)

#118

Oui désolé, mais tellement de gens m’ont limite traité de débile alors qu’objectivement, je ne vois pas la différence au delà de 60, même sur des jeux nerveux, que j’ai peut être été un peu désagréable. J’aurais dû préciser que je ne te visais pas particulièrement.

Pour la constance, je suis bien d’accord. JE préfère du 50 stable à plus mais en yoyo.

#119

Apparemment, la carte (AMD ne précise pas laquelle) serait moins rapide que les verts pour le Ray Tracing.

Lesnums ont fait un test avec une 3080, à chaud, 33% de différence en faveur de la 3080. Mais après, il faudra voir en condition réelle.

#120

Le besoin de mémoire n’est pas un problème de génération de carte, mais de résolution d’affichage, de résolution de textures et de nombre de textures à un instant T (là où cela aurait un coût de transférer de la ram ou du ssd). Le reste c’est du flutiau. D’ailleurs, le besoin de Vram n’a pas forcément augmenté ces dernières années.

Si tu achètes une NVidia 20Gb ou une AMD 16Gb et que tout le monde passe au 16K si ta carte tente de travailler avec le double de texture elle va juste exploser en vole. Donc le surplus de mémoire ne servira à rien comme son coût (en € ou technologique). À puissance égale bien entendu. Si tu veux, le plus pérenne il faut prendre les plus puissantes. Malheureusement vouloir absolument garder une carte plus de 3 ans n’est pas “financièrement” le plus intéressant (écologiquement oui). Une carte de quelques années peut encore être vendue quelques centaines d’€ après c’est un beau bloc pour caler une porte.

#121

hum, hum “ les nums ” comme référence, vu leur “objectivité”ces 3 dernières années je vais juste consulté leur site pr de l électroménager( je me cherche un bon combi frico-congélo ^^) ca fait un bail que je me fie plus a leur test composants informatique…..

( ps je dis pas que les Nvidia sont pas plus performante que les Amd pr le raytracing mais de là a obtenir du 33% j attend plutôt un vrai test sous dirextx12 Ultimate car c est directx 12 qui sera le vrai juge entre les 2 cartes graphiques et bien évidemment Nvidia sera au dessus de amd mais je pense pas que ce sera du 33% plutôt du 15 ou 20% au dessus des amd )

#122

Peu importe, une partie de l’information vient des documents de chez AMD. Et comme je le dit, il faut voir en condition réelle.

#123

C’est évoqué dans l’article, c’est basé sur les chiffres du SDK DXR. Faudra voir en jeu pour confirmer les échelles par contre parce que là c’est du full RT.

#124

Comme tu as écrit précédemment “les jeux avec du raytracing on en compte actuellement que 2 ou 3.” c’est pas grave même si Nvidia est 30% au dessus en Raytracing…. Faut être cohérent, les nums pas objectifs mais toi…

#125

Intéressant de lire les footnotes AMD https://www.amd.com/en/graphics/amd-radeon-rx-6000-series

les benchmarks sont quand même souvent en Smart Access Memory + Rage Mode.

Ce qui m’inquiète, c’est que la liaison CPU AMD, chipset AMD, CG AMD c’est quand même un sacré silo technique et commercial. On revient à une verticalité des années 80 (ou à du Apple). On peut même imaginer une segmentation quasi-artificielle (cad indépendante du hardware).

Et au final on risque de perdre sur tous les tableaux : liberté et tarifs…

#126

En effet c’est bien possible que ça soit plus de l’allocation que de l’utilisation, mea culpa je n’ai pas creusé le sujet quand ça m’est arrivé. D’ailleurs y a un moyen de savoir si c’est simplement alloué ou si c’est réellement utilisé ?

#127

Ce que j’ai du mal à comprendre pour le moment, c’est la raison pour laquelle c’est limité à Zen 3/Chipset 500 (autre que la segmentation qu’AMD a toujours dit combattre). On verra une fois qu’ils donneront plus de détails, mais comme tu dis ça fait très silo.

Pour les footnotes, oui, comme dit dans l’article ils ont souvent eu recours à leurs deux technos pour booster un peu leurs graphiques, ce qui laisse à penser qu’ils étaient en retrait de NVIDIA sans ça. Heureusement que NViDIA ne fait pas des comparaisons avec les Radeon en activant DLSS

Non, c’est tout le souci. Mais bon, la VRAM qui manque c’est comme les œufs périmés : quand c’est le cas, tu le sais : tes perfs s’effondrent. Parfois c’est parce que le jeu gère mal, parfois parce que le GPU n’est tout simplement pas adapté (mais c’est un cas hyper rare dans un usage cohérent. Faire saturer une 1650 Ti sur un jeu en 4K c’est forcément plus simple ).

).

#128

J’étais en 1080p à l’époque, donc une “petite” résolution, les 3GB n’étaient plus suffisant.

On verra bien pour les gens qui jouent en 4K. ^^

Moi je suis en 1440p et je ne compte pas passer à l’UHD sur cette carte.

#129

Désolé, j’ai lu ça hier soir je ne me souvenais pas que c’était dedans.

#130

Je crois avoir vu des tests qui jouaient avec des cartes identiques/proches mais avec une quantité de vram différente… Mais suis vieux plus de mémoire.

Pas de “on verra” si je peux me permettre, c’est tout vu. On a tous les retours possible depuis 1-2 ans. Il existe pas mal de tests qui confirment le truc. Comment sais-tu que c’était la vram en 1080p…

On va dire que c’est la période qui me rend négatif…

#131

aucun soucis avec m a 1070Ti, juste horizon qui stagne a 60fps stable en ultra (et un setting en élevé, les ombres il me semble) mais bon ^^

RE 3 75fps sans soucis RE2 idem…

#132

Bah parce que afterburner m’indiquait 3000MB de pleins sur les 3000MB de ma carte. ^^

Et que les performances augmentaient bizarrement en enlevant le pack de texture HD. ;)

J’avais eu ça aussi avec ma Radeon 5870 1GB de l’époque sur Battlefield 3.

Donc moi aussi j’ai une expérience avec des CG à la VRAM saturée.

#133

Comme quoi on peut tirer une mauvaise conclusion d’un bon constat

#134

Alors ça c’est pas très gentil.

Un article dessus ça serait sympa du coup !

#135

Il faut aussi les bons outils, dans le gestionnaire des taches de win10 il manque le graph d’utilisation de la VRAM

#136

On fait des tests en 4K max sur toutes les cartes graphiques, on a même fait en 8K sur la 3090, en soi, ça traite déjà assez du sujet ;) Mais globalement cette histoire de VRAM c’est une affaire de foi. Tu peux tenter tous les arguments rationnels de la terre, ça ne marche pas sur ceux qui se sont fait bousiller par le marketing

Allouée. D’ailleurs c’est comme ceux qui passent leur temps à dire “Windows c’est nul ça bouffe toute ma RAM” et qui n’ont pas compris que l’objectif c’est souvent de foutre pas mal de données en RAM pour y accéder le plus rapidement possible, même si les développeurs ne doivent pas y foutre tout et n’importe quoi. Le manque de RAM c’est quand tu as 200 onglets de navigateur ouverts et 2 Go. Là tu souffres.

#137

Ah mais moi 10GB ça me va très bien.

8K ça doit claquer !

#138

Disons que ça en fait du pixel

#139

En tous cas c’est sympa de parler avec un journaliste du site !

Même jusqu’à 21h

#140

Incroyable d’être aussi désobligeant, et de ne pas comprendre que 1 il y a des gens pour qui c’est déjà limite (et oui, il y en a qui jouent et qui utilisent aussi leur gpu pour des applications plus pros en même temps), et de 2 de ne pas voir que ça risque d’être un problème dans un futur proche. Avec cette mentalité Intel serait toujours en train de vendre des 4 cœurs pour le grand public à un prix premium car ça sert à rien d’avoir plus.

De plus un pro qui veut un GPU avec plus de 10 Go il va devoir aller sur une 3090, et c’est bien pour ça que Nvidia ne met pas plus. En espérant que ça les pousse à mettre plus de Ram dans le futur.

#141

Si j ai bien compris :

Variable Rate Shading (amd) = Dlss version2 et ces 2 “ solutions ” = argument marketing ^^

et apparemment c est la même danse pr la quantité de gddr

donc il reste quoi qui ne soit pas marketing alors ????????? ( aussi bien chez amd que chez nvidia bien entendu ^^ )

#142

Les gens y sont méchants avec moi y sont même désobligeant (synonyme de y font que me contredire ).

Effectivement peut-être que dans 4 ans, le mec qui va en même temps jouer sur son écran 16k à red dead 4, entrainer un modèle, recompiler Windows 11 sp2 (oui il sera open source) tout en testant un modèle 3D de 2 millions de polygones sera bien content d’avoir un modèle avec 16Gb de Vram. Et pan les désobligeants cyniques d’inpact-hardware.

Cette fois 100% sérieux, j’adore “désobligeant”, on ne pense pas assez à l’utiliser, c’est choupinou, tout tant en restant super correct.

#143

Variable Rate Shading et DLSS sont 2 choses différentes depuis les RTX Nvidia doit être capable de faire les deux. Le VRS doit en gros, si j’avais bien compris, c pas nouveau, rendre des parties de l’image sur lesquelles ton oeil n’est pas focalisé, avec une qualité dégradé (shaders) et donc avec un moindre coût de rendu. Surtout entendu parlé pour la VR. Moi qui suis presbyte (âge) tout va tourner à 240i/s mais ce sera super moche.

Le DLSS c’est de l’upscale/reconstruction d’une image, d’une partie de l’image, d’une texture (pas sûr) par deep learning donc la aussi à moindre coût. Ça marche vraiment très bien.

#144

Et même tôt le matin

Avant de m’accuser d’être désobligeant, il faudrait quand même prendre la peine de lire et de comprendre ce que je dis aussi bien dans l’article que dans les commentaires. Si je devais simplifier pour être sûr que ça rentre : 16 Go pour les jeux = stupide. 16 Go pour du compute & co = utile, mais il faut que la carte et son écosystème soit taillé pour ça. C’est moins le cas chez AMD, surtout que RDNA 2 est limité en puissance de calcul brute (Infinity Cache permet de palier le problème et son manque d’efficacité dans les jeux, on verra si c’est le cas en calcul brut, mais ça ne fera sans doute pas de magie).

Celui qui a besoin de plus de 10 Go dans des apps Pro, c’est quand même pas le client lambda avec un budget rikiki. Je l’ai expliqué dans le papier 3090, mais NVIDIA a fait un choix sur Série 30 : réduire fortement le prix du haut de gamme, mais réserver le stuff “pro” (NVLink, 24 Go, 36 TFLOPS) à son remplaçant de la Titan. La 3080 pouvant être utilisée en duo (mais sans NVLink et sans accès mémoire unifié donc) avec un bon débit en PCIe 4.0.

Après on peut se dire “non mais moi je veux la 3090 pour 500 euros” et taper du pieds devant son clavier, chacun est libre. Ou alors remarquer qu’entre la 3080 et la 3090 il y a un très large espace tarifaire qui ne manquera pas d’être comblé dans les mois à venir ;)

Bon après c’est surtout qu’avoir une stratégie commerciale c’est un brin plus compliqué que de grogner et d’exiger. Mais comme évoqué aussi plus haut, si quelqu’un veut craquer pour une carte 16 Go pour la raison qu’il souhaite et que ça lui parait raisonnable, moi, ça me va

De toutes façons, il y a de grandes chances que la stratégie du 16 Go pour tous soit une manière d’aller séduire les mineurs qui sont déjà très friands de Radeon, ce qui n’est sans doute pas la première chose qu’AMD ira assumer en public (sauf à être devant un public de financiers )

)

Je suis au regret de te confirmer que tu n’as pas compris (mais comme quelqu’un a déjà tenté de t’expliquer correctement plus haut, je n’en rajouterai pas une couche

(mais comme quelqu’un a déjà tenté de t’expliquer correctement plus haut, je n’en rajouterai pas une couche  )

)

#145

En même temps il n’y a pas d’autre choix dans la gamme 3000 de Nvidia que la RTX3090 car c’est la seule qui est orientée calcul.

#146

Faut faire dodo !

Je paye un abonnement pour que le code du travail soit respecté justement.

#147

#148

Oui et non, tu peux faire du calcul sur n’importe laquelle. Le PCIe 4.0 aide pas mal à l’interconnexion. Mais celui qui veut une quantité massive de mémoire et de TFLOPS, il va aller vers la 3090, forcément.

#149

C’est à peu prêt ça. Le Variable Rate Shading, qui au passage il me semble est une techno NVidia, pas AMD, permet d’utiliser des traitement graphique moindre sur certaine zone de l’image pour pouvoir optimiser le temps calcul sur les zones qui vont focaliser l’oeil du joueurs.

Le DLSS (deep learning super sampling) est un algo d’upscaling de rendu 3D utilisant le deep learning. Or les cartes NVidia RTX possèdent des tensor core qui sont justement dédié aux calculs pour le deep learning, ce qui fait que le DLSS a qu’un inpact assez faible sur le restes des performances. faire un rendu 720p et avec un DLSS faire un upscaling vers du 1080p va avoir un frame rate assez proche d’un rendu 720p seul.

Je rejoint David, mais quand tu es pro est que tu as besoin de plus de 10Go de VRAM, tu dois avoir le budget pour mettre 1550€ dans la CG qui est ton outil de production (sachant que derrière, c’est un achat pro avec toutes les déductions possibles).

Et la 3090 est totalement cohérente pour un usage pro contrairement aux autres qui sont clairement des carte grand public avant tout. Si tu as besoin des 20Go de VRAM ou du NVLink, il y a peu de chance que tu trouve ton bonheur dans la puissances des puces de gamme inférieurs.

Je te rappelle que les cartes pro, historiquement ce ne sont pas les GeForce, mais les Quadro, et quand tu verras les tarifs tu risques de déchanter sur les tarifs appliqués sur le matos réellement destiné aux pros.

#150

les cartes Quadro ….

#151

Tiens comme j’ai vu qu’on parle du PCIe 4.0 plus haut, je me pose une question :

J’aurais vraiment une perte de perf si je colle une 3080 sur un slot 3.0 ?

#152

Pour du jeu, il y a peu de chance que tu voie la différence, tu va peut-être perdre 0.5%, et encore.

Même passer du Pci-ex 3.0 à 2.0 n’a qu’un impact très limité.

#153

Non, mais ça peut jouer sur une situation d’interconnexion entre deux GPU

#154

Merci mais c’est même exactement ça !

mais c’est même exactement ça !

Le VRS fait partie de DX12 et c’est un brevet Microsoft. Nvidia a dû être le premier à l’implémenter dans son hardware. NV est à l’origine de pas mal de brevets sur le shading comme AMD etc. Ce genre de truc, c’est rarement des découvertes d’un seul acteur ça provient d’incréments de recherche.

#155

bonjour,

Dans la liste -> https://www.cowcotland.com/news/73905/un-point-complet-sur-les-nouvelles-cartes-graphique-rx-6x00-rdna2-d-amd.html des technos utilisables par les big navi quelle est celle qui s’approche le plus de ce que propose le dlss svp ????? que je puisse repérer la bonne techno dans les tests a venir et savoir ce que çà va donner en résultats….

#156

Normalement c’est SuperResolution qui semble être une fonction d’upscaling, AMD disant qu’elle sera (quand elle sera terminée) basée sur WinML. Mais comme pour le moment c’est juste un nom sur une slide, et que ça fait depuis le début de DLSS qu’AMD en parle sans rien dire/montrer, on ne sait pas trop à quel point c’est comparable. En tous cas ce ne sera pas dispo au lancement des RX 6000.

#157

Plus tu aura de ram video sur les cartes et plus tu aura de chance qu’elle sois utilisée par des programmes. Pourquoi s’assoir sur 4 / 12 go alors que ça sera devenu un standard.

C’est une histoire de cohérance de composant. Si t’a 12 go de vram il vaut mieux avoir un bon cpu derrière et de la ram. La encore de plus en plus de programme vont les utiliser.

Photoshop entre nous c’est juste “devenu” une grosssssse merde quasiment plus mise à jours. Ils profitent à fond sur leur monopole de format de fichier et du fait d’avoir été très loin dans leur domaine. Mais maintenant ça fait plus de 10 ans qu’il ne vont plus loin. Mais c’est peut être trop loin à atteindre pour la concurrence.

Sans parler du fait que tout leur produit sont compatible entre eux.

Ce que je veut dire c’est qu’en 2020 quasiment 100% des opérations devrait être calculée par la CG et qu’un maximum de vram devrait être utilisée. Peut être qu’en 2025 ça sera le cas.

#158

Merci

#159

Tu as Affinity qui a sorti de très bons produits (Designer, Photo et Publisher + versions ipad) pour concurrencer Adobe sur ses fondamentaux.

#160

Bonjour,

question le Super Résolution de AMD, est ce que cela à un rapport avec le VIRTUAL SUPER RÉSOLUTION !!!??

si non quel sont la différence entre Super Résolution et VSR !!!???

Merci.

#161

édit bon VSR c’est l’inverse de Super résolution.

tu calcul une image 8K sur une sortie en 4K en VSR.

#162

Tarif de la 6800:

Donc, AMD a la voie ouverte pour vendre ses cartes (au tarif qu’elle veut), vue qu’il y n’a plus de 3070 disponible.

la 6800XT: proche de la 3080 tout en étant moins cher que la FE (et bien moins cher que les AIB version) toutes difficilement à avoir à mois de $799. (sans parler de plus de mémoire, et la synergie sur la plateforme serie 500 + Ryzen 5000)

C’est sûr, qu’il y a un sacré écart de prix entre la 3080FE et la 3090FE (x2 en tarif).

Mais les performances de la 3090FE (en jeux) ne suivent pas le ration x2. Sans OC, on est à quoi? 5 à 10% de plus qu’une 3080FE ? NV va mettre quoi entre les deux? une 3090 12 Go 5% plus rapide qu’un 3080? à quel prix? \(899? \)999? Est-ce que ça ne va pas montrer que finalement la 3090 24Go la “BFGC” à \(1499 n'était qu'une vaste blague pour faire payer les 24 Go alors que 12 Go suffiraient? Bien-sûr, 90, c'est forcément mieux que 80ti, donc autant facturer ça \)300 de plus que la précédente génération…

Donc, pas sûr, avec tous ces problème de dispo, qu’NV va garder ses 80% de part de marché… mais ça, on verra bien les chiffre l’année prochaine (et la dispo des cartes RDNA 2 dans 3 semaines: même si la dispo est conséquente, on va peut-être se jeter dessus… faute de dispo en face…)

#163

Tu veux dire en 207… euh 21

Vu comment un des pontes de CDPR transpirait intensément et bottait en touche quand il a été interroge par un investisseur au sujet d’un éventuel prochain report quelques jours après l’annonce de la nouvelle date de sortie… indiquant que les équipes étaient “confiantes, mais sans certitudes”.

https://happygamer.com/cd-projekt-red-ceo-not-comfortable-but-confident-in-cyberpunk-2077s-new-release-date-90522/

Notez bien ce que je dis, au plus tard le 10 Décembre, le jeu sera a nouveau repoussé d’au moins 2 mois.

Le point positif c’est que ceux qui attendent le jeu pour achetez un nouveau GPU pour leur PC ben…euh…

#164

Attention quand même à ne pas trop partir du principe qu’AMD a la voie ouverte parce que eux ont des cartes alors que NV travaille à flux tendu ;)

Pour la 3090, ce n’est pas une carte de jeu, ni pour ceux qui ont besoin de 10 à 12 Go de mémoire. Je l’ai déjà évoqué en long et en large, on ne va pas refaire tout l’article ici. Pour les pdm, NV (et à peu près tous les acteurs) est bien conscient qu’en l’état actuel du marché, ils ne peuvent que redescendre et que ça ne serait qu’un juste rééquilibrage. La question est de savoir quel sera le nouveau rapport de force, on verra ;)

#165

La 3090 pas une carte pour les jeux?

Lors de la présentation NV a bien montré un 8K en gaming

Sur le site office: Vivez l’expérience gaming ultime avec 24 Go de mémoire G6X et une puissance incomparable.

And, of course, it’s ideal for extreme gamers who want to experience the new world of 8K gaming.

https://www.nvidia.com/en-us/geforce/news/rtx-3090-out-september-24/

Donc oui, c’est bien un GPU qu’NV nous facture au prix d’une titan (ou presque, tout dépend à quels tarifs de Titan on compare)… sans les drivers de la titan.

Flux tendu? NV n’avait qu’a pas choisir SAMSUNG, et là on aurait peut-être eu un meilleur approvisionnement, en particulier en Europe (d’ailleurs, NV semble y revenir pour un hypothétique refresh en 7nm l’année prochaine, en juin, voir plus tôt).

Mais comme dise certaines sources, NV est probablement en train de tester plusieurs porte de sortie de ce (pseudo) fiasco (je dit pseudo car on a pas de chiffres officiel).

Je doute qu’AMD aurait mis la 6800 à $579 si la 3070 avait largement disponible partout.

Et en décembre (au plus tôt, je suppose), si la dispo de la 3070 s’améliore, rien ne dit qu’AMD ne baissera pas son pris, comme ça s’est déjà vu.

Enfin, pour ceux qui douterait (nouvelle de série carte sortie “rapidement” après), NV la déjà fait dans le passé (épisode Fermi -> Kepler)

#166

#167

Oups, erreur de ma part (j’arrive pas à édier mon post), ce fut l’épisode Fermi 1.0 -> Fermi 2.0

Exemples (6 mois d’écart entre ces deux générations)

https://www.techpowerup.com/gpu-specs/geforce-gtx-480.c268

https://www.techpowerup.com/gpu-specs/geforce-gtx-580.c270

Donc, bref: en creusant bien, NV veulent bien faire croire ce qu’ils veulent (discours marketing bien rôdé plein de BS comme dirait certain) mais cette faible disponibilité est bien de leur ressort.

Quand on 80% des PDM, on assume.

(désolé, je ne fume pas ;) )

#168

petit hs, il semblerait que les bios pour les x470 soient sortis en beta (du moins chez gigabyte) supportant l’AGESA 1.1.0.0, bios beta donc j’attendrais un peu, visiblement pas de soucis avec des 2700x, sans doute la branche 1700/athlon am4 viré…à creuser

#169

Pas publiquement en tous cas, ils sont encore en F60c. Mais il y a forcément de premiers tests qui doivent avoir commencé, le plus sage est d’attendre à ce stade.

#170

jusqu’à il y a une ou deux semaines, c’était du F50, et après recherche c’est bien le bios supportant les zen 3

https://phonemantra.com/gigabyte-has-already-made-amd-x470-and-b450-boards-compatible-with-ryzen-5000/

#171

étonnant qu’ils ne précisent pas, surtout si c’est en AGESA 1.1.0.0, je vérifierai ça et si ça fonctionne de manière effective

#172

les bios beta, j’ai déjà donné il y a bien longtemps avec asus, il y en a un pour les 5000, ils étaient mentionnés, ils seront suivi des zen3+ (2021) et du chipset x670 par asmedia et s’en sera fini de l’am4 :)

#173

bonjour,

en regardant la video de présentation de Godfall :

https://www.youtube.com/watch?v=ppLFctc0iMU&feature=youtu.be&t=88

Apparement le VRS fonctionne trés trés bien ^^ ( vrs versus dlss2 match nul ^^ [perso je trouve le rendu visuel de vrs meilleur que le dlss2 mais bon chaccun ses goûts ^^ )

Et la question de la quantité de gddr est remise sur le tapis :

https://www.generation-nt.com/godfall-jeu-4k-ultrahd-12-go-vram-configuration-actualite-1981838.html

#174

On répète : VRSS n’est pas une alternative à DLSS, ce n’est pas comparable (mais tes goûts sont… prévisibles disons ;)). C’est d’ailleurs intégré chez NVIDIA depuis Turing, ça permet simplement de définir des zones où la précision de calcul est moins nécessaire pour avoir un plus gros débit d’image.

Pour la VRAM, on verra dans la pratique. AMD peut faire du forcing ici ou là pour pousser la limite juste ce qu’il faut, mais in fine, on en reviendra toujours au même. Après comme déjà évoqué, chacun est libre de se faire berner par le marketing et de penser que plus de VRAM = plus de perfs même si c’est débile.