Avec ses GeForce RTX de série 30, NVIDIA a frappé fort. Il livre une architecture dans la lignée des précédentes, mais profondément remaniée pour changer la donne. RT Cores et Tensor Cores améliorés, unités FP32 doublées, consommation maitrisée... Après les promesses, voici venue l'heure des tests.

Comme on pouvait s'y attendre, l'architecture Ampere telle qu'elle est intégrée au GeForce RTX de série 30 est une amélioration de celle des séries 20. « Telle quelle aurait dû être » diront certains. Mais ce serait oublier que les GPU ne se conçoivent pas en un claquement de doigts, et qu'il faut parfois du temps pour opérer certains changements.

Une densité doublée, l'importance de la maitrise du coût

NVIDIA aurait-t-il pu opérer le doublement des unités de calcul FP32 sans le passage au 8 nm de Samsung ? Non. On le voit d'ailleurs très bien lorsque l'on analyse la densité des puces, qui a presque doublé. AMD garde l'avantage et devrait aller un peu plus loin sur ses Radeon RX 6000 en 7 nm+ (RDNA 2, Navi 2X). Nous verrons.

NVIDIA confirme son choix, de raison : le procédé de gravure en 7 nm de TSMC est trop sollicité pour livrer en volume à un prix raisonnable, ce que même Microsoft (qui l'utilise pour ses prochaines Xbox) a confirmé ces derniers mois. C'est d'ailleurs l'un des soucis auquel devra faire face AMD pour ses nouveaux Ryzen/Radeon.

Chez NVIDIA, cette solution n'est ainsi utilisée que pour la puce A100, destinée aux serveurs.

Car l'un des objectifs de NVIDIA avec Ampere est de démocratiser ses nouveautés techniques. Malgré le succès des GeForce RTX de série 20, tant le ray tracing que DLSS, les Tensor Cores ou encore le rendu 3D accéléré n'ont été accessibles qu'à une part restreinte de ses clients. Surtout pour des produits performants.

GeForce RTX de série 30 : un bien meilleur rapport performances/prix

C'est en partie ce qui explique l'agressivité tarifaire même sur l'offre haut de gamme. Une Titan RTX qui était vendue près de 3 000 euros se trouve désormais moins performante qu'une RTX 3090 annoncée à 1 549 euros. Le glissement est le même pour les GeForce RTX 3070 (520 euros) et 3080 (720 euros) équivalentes des 2080 (Ti).

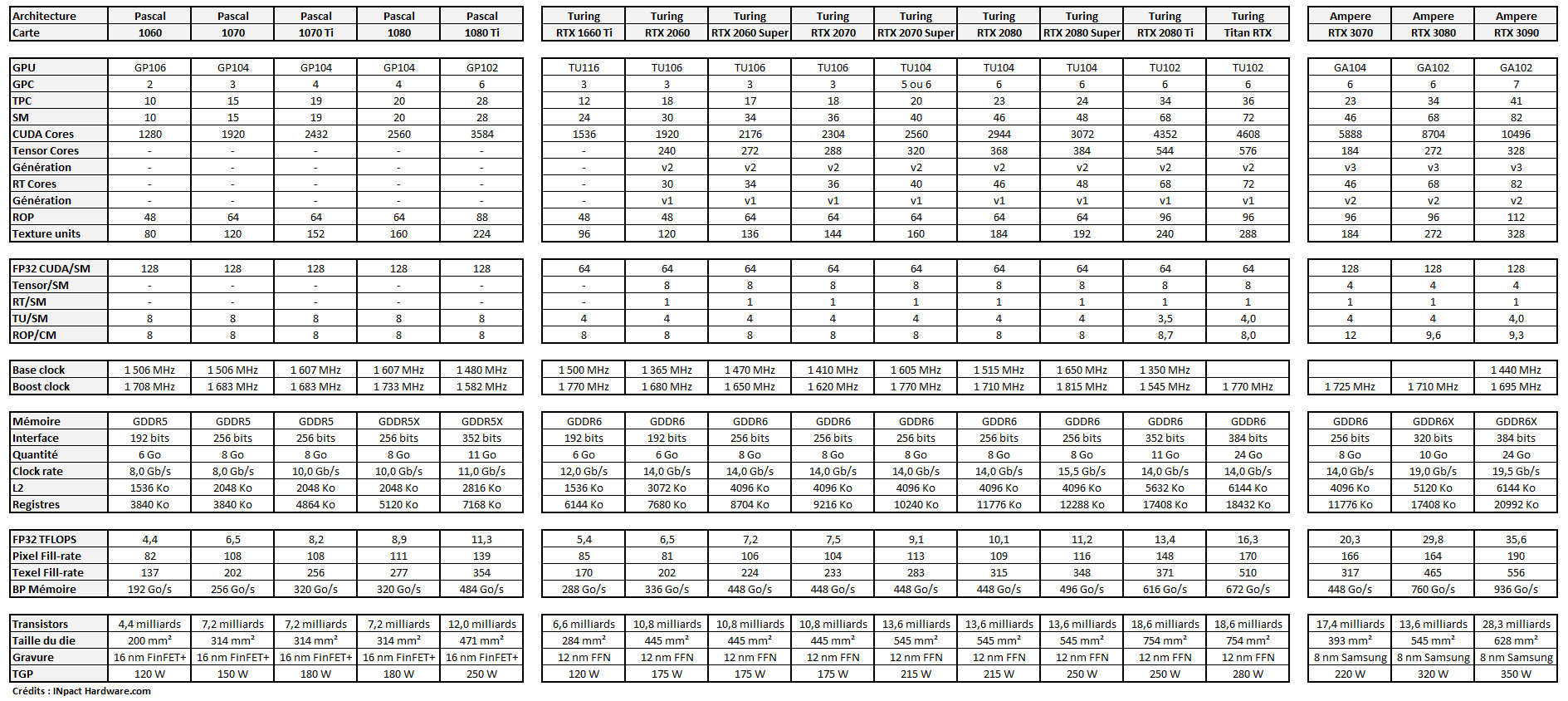

Là aussi, pour s'en convaincre, il suffit de regarder les chiffres, notamment la constitution de chaque carte/puce :

Comme on peut le voir, la RTX 3070 est calquée sur la 2080, la 3080 sur la 2080 Ti. Le tout en étant bien moins chères qu'à leur sortie ou même leurs tarifs actuels. Comme nous l'avions analysé, la 3080 est le modèle le plus intéressant pour son rapport TFLOPS/euros, ce qui aura son importance, notamment pour les amateurs de calcul.

Il y a quelques subtilités à noter dans ce tableau : tout d'abord le nombre de Tensor Cores, revu à la baisse. Ils sont en effet deux fois plus rapides dans leur « v3 » que la génération précédente, ce qui explique ce choix. Si les RT Cores sont plus nombreux, ils ont un autre avantage de taille : ils gèrent l'exécution concurrentielle. Ils peuvent être actifs en même temps que les Tensor Cores et donc plus efficaces, comme nous le verrons plus loin.

Concernant la puissance de calcul FP64, NVIDIA fait comme à son habitude. Ses schémas ne mentionnent pas d'unités dédiées, mais elles existent bel et bien pour que les applications puissent fonctionner. Il n'y en a toutefois pas autant que dans une A100, où le rapport est de 1:2 par rapport au FP32. Dans les GA102/104, il est de 1:64.

Nous l'avons en effet mesuré avec le test GPGPU d'AIDA64 :

- GeForce RTX 2080 :

- FP32 : 11 706 GFLOPS

- FP64 : 366 GFLOPS

- GeForce RTX 2080 Ti :

- FP32 : 16 348 GFLOPS

- FP64 : 503 GFLOPS

- GeForce RTX 3080 :

- FP32 : 31 698 GFLOPS

- FP64 : 539 GFLOPS

L'information nous a depuis été confirmée par NVIDIA, qui a donc divisé par deux ce rapport, sans doute pour limiter les unités et rester sur le même niveau de calculs en FP64. Nous ne reviendrons pas plus avant sur les évolutions de l'architecture Ampere, déjà détaillées dans de précédents articles.

- NVIDIA dévoile RTX IO et ses GeForce RTX 3070, 3080 et 3090 dès 519 euros

- GeForce RTX 3070, 3080 et 3090 : Ampere expliqué techniquement et simplement

Enfin un ventirad dont le ventilateur s'arrête au repos !

Si NVIDIA a ouvert le bal des GeForce de série 30 avec la RTX 3080, ce n'est pas anodin. Il s'agit de son « flagship », pensée à la fois pour les joueurs et ceux qui veulent en faire une bête de calcul. Certes, la RTX 3090 sera plus performante, mais elle visera des usages particuliers. Ici, NVIDIA vante une carte d'un autre genre.

Elle est annoncée comme deux fois plus performante que la RTX 2080 et meilleure que la 2080 Ti. Suffisamment pour être la première carte permettant de jouer en 4K à 60 images par seconde sans artifices tels que DLSS. Avec une puissance revue à la hausse, certes, mais maitrisée. Son TDP passe de 250 à 320 watts (+28 %).

NVIDIA voulait néanmoins garder une carte silencieuse. Pour arriver au niveau de performances de la 2080 Ti, des concessions avaient dû être faites, notamment sur la température qui pouvait grimper à plus de 80°C et un ventilateur toujours raisonnable, mais qui ventilait plus que sur les autres modèles.

C'est ce qui explique le travail fait autour du PCB, sa réduction pour l'intégration d'un ventilateur traversant, un design pensé pour extraire directement une partie de la chaleur du boîtier, en profitant du flux d'air global pour le reste. Lors de nos tests, même au sein de notre machine compacte, nous n'avons pas relevé de problème.

Le GPU reste comme annoncé dans les 70-75°C. Le ventilateur affiche une vitesse de rotation d'un peu moins de 1700 tpm lorsqu le GPU est sollicité, et d'environ 1000 tpm lorsqu'il l'est peu. Il reste silencieux dans tous les cas. Bonne nouvelle : c'est la première fois sur une Founders edition qu'il s'arrête au repos. Une solution déjà intégrée par de nombreux partenaires et qui manquait aux cartes de NVIDIA.

Le GPU peut grimper jusqu'à 2 GHz selon les cas, descendant désormais jusqu'à 210 MHz au repos. La consommation minimale sur notre machine équipée d'un Core i9-10850K était d'un peu moins de 50 watts, comme avec les anciennes générations ou même les cartes concurrentes. Pas de surprises ici.

Notez que la carte est lourde, 1,4 kg. C'est un peu plus que la 2080 Ti ou la Radeon VII (1,3 kg environ). Elle n'occupe que deux emplacements PCIe au sein du boîtier et ne comporte aucun connecteur NVLink (désormais réservés aux RTX 3090). La Founders edition nécessite un connecteur d'alimentation PCIe 12 broches, un adaptateur étant fourni.

Côté sorties vidéo, elle compte trois DisplayPort 1.4a et un HDMI 2.1 à 48 Gb/s (son débit maximal). Jusqu'à quatre écrans peuvent être gérés en simultané selon la définition.

Notre machine de test

Notre premier chantier sur cette carte a été de vérifier les déclarations de l'entreprise sur les performances. Nous avons monté une machine équipée d'un processeur Core i9-10850K avec 32 Go de mémoire G.Skill à 3 GHz et une carte mère ASRock Z490 Taichi. Pourquoi pas un modèle PCIe 4.0 ? Parce que les gains sont inexistants dans les jeux, surtout pour un modèle haut de gamme. Ce sera sans doute différent avec DirectStorage et RTX IO, en 2021.

Nous avons effectué quelques tests rapides sur un Ryzen 9 3950XT et n'avons pas relevé d'écart particulier. Parfois, la fréquence plus importante du CPU Intel jouait en sa faveur. Nous sommes donc restés sur cette configuration. La machine était installée sous Windows 10 (Mai 2020) à jour, tant pour le système que les pilotes que le BIOS/UEFI.

Nous n'utiliserons pas ici de carte graphique AMD pour référence, car tant les Radeon RX 5700XT que la Radeon VII (qui n'est plus commercialisée) sont positionnées sous la GeForce RTX 2080, les intégrer n'aurait pas eu grand intérêt. Cela montre au passage que 16 Go de mémoire ne suffisent pas à placer un GPU en tête.

Il sera par contre intéressant d'opposer ces Radeon à la future RTX 3070 et de refaire le point sur la 3080 une fois que les RX 6000 seront annoncées et disponibles pour les tests, en novembre.

Nous avons fait le choix de tester la carte en 1080p, 1440p et 2160p (4K). Une manière de voir la progression des performances et surtout quand les jeux sont limités par le CPU plus que par le GPU. Lorsque des packs de textures haute définition sont proposés, nous les avons installés. Le ray tracing et DLSS sont analysés séparément.

Nous avons aussi passé du temps à décortiquer les performances dans différentes applications de rendu 3D, toute la puissance de l'architecture Ampere pouvant s'y exprimer plus pleinement. La charge de travail est en effet mixte entre INT32 et FP32 dans les jeux, ce qui est bien moins le cas dans du pur calcul.

Qu'en disent les benchmarks ?

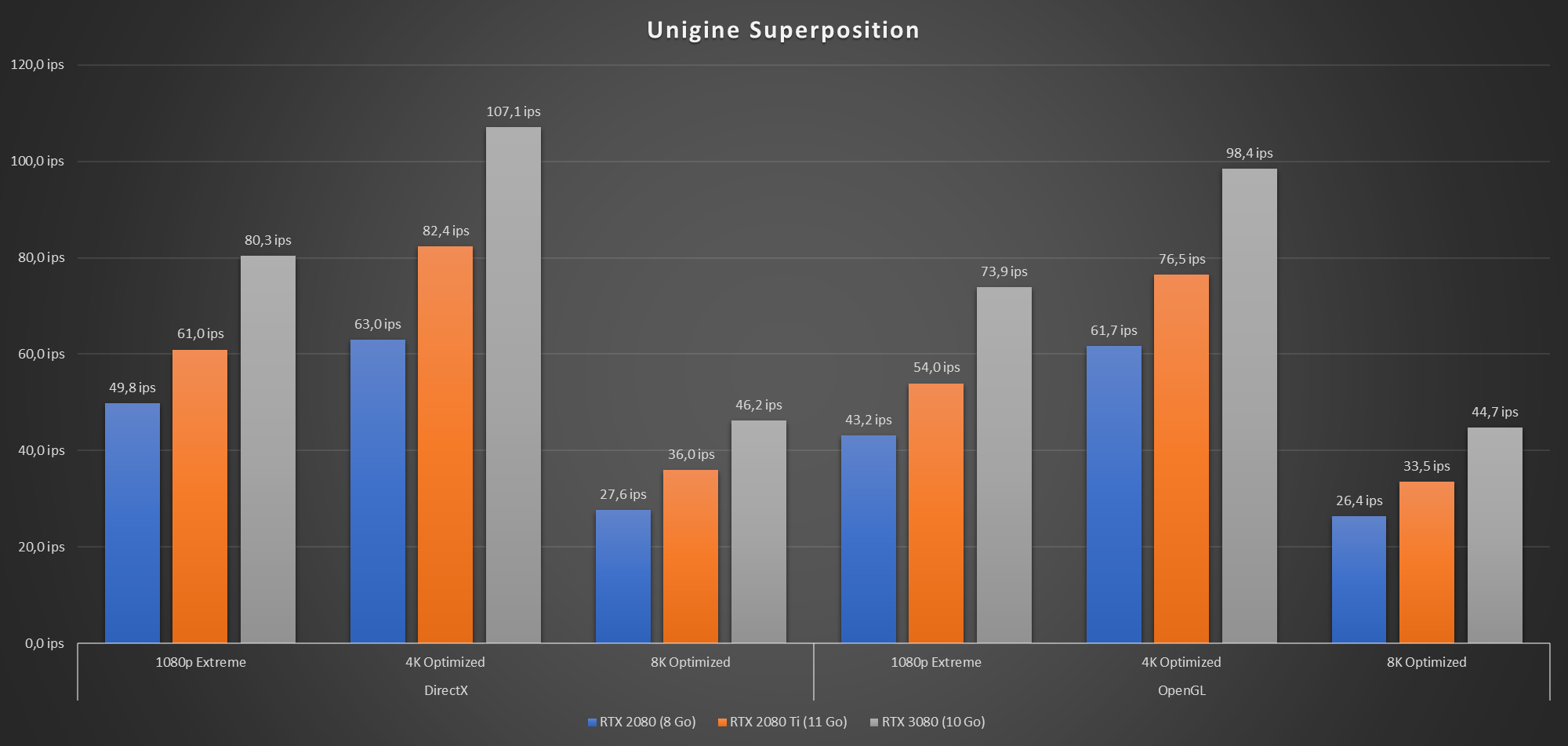

Commençons simplement par un benchmark assez populaire, Unigine Superposition, qui permet de grimper jusqu'à des tests de rendu en 8K, avec DirectX et OpenGL :

Les gains sont nets et assez stables : la 3080 fait jusqu'à 70 % de mieux que la 2080 et 33 % de mieux que la 2080 Ti en moyenne. Dans le test 4K Optimized, on dépasse les 100 images par seconde pour la première fois.

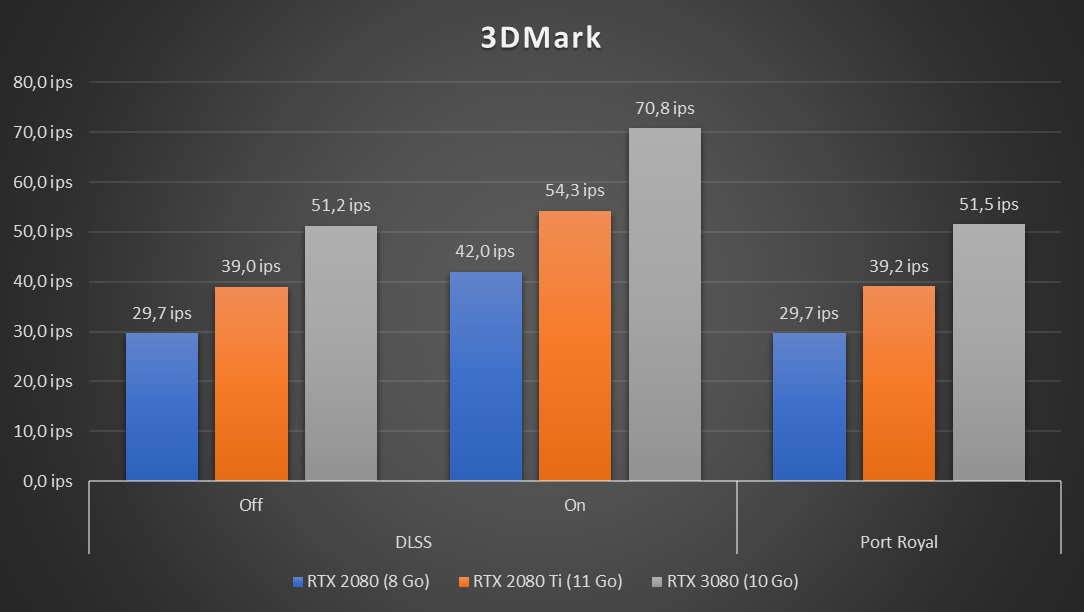

Continuons avec 3DMark. Nous avons utilisé Time Spy – le test le plus gourmand – dans ses versions classique et Extrême (4K), ainsi que les tests VRS, DLSS et de DirectX Raytracing :

Les évolutions sont du même ordre : 70 % de mieux que la 2080 et 30 % sur la 2080 Ti. Le second cas s'explique facilement : si le nombre d'unités FP32 a été doublé, certaines exécutent également des calculs INT32. Surtout, les unités liées au rendu 3D comme les ROP, unités de texturing, la bande passante mémoire, etc. n'ont pas été doublées, une manière pour NVIDIA de limiter la taille de sa puce. Leur croissance est de 25/30 %.

Notez une exception ici : l'activation du VRS Tier 1 semble bien plus profiter à la RTX 3080 qu'aux anciens modèles. Le gain y est respectivement de 101 % par rapport à la 2080 et 45 % par rapport à la 2080 Ti. Pour rappel, les Radeon RX 6000 seront les premières cartes d'AMD à supporter VRS et DirectX Raytracing.

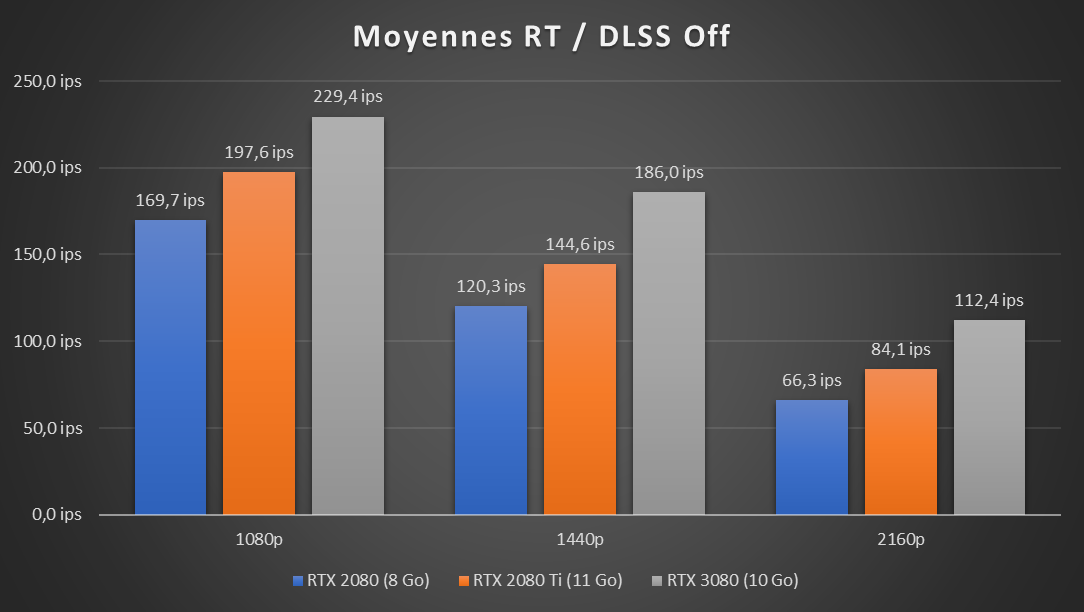

Dans les jeux : +70 % de la 2080, jusqu'à +40 % par rapport à la 2080 Ti

Les benchmarks restent un brin théoriques. Passons aux choses sérieuses avec les jeux. Premier constat lors de nos essais, c'est que la promesse de NVIDIA d'une carte taillée pour la 4K est tenue. Malgré des tests systématiquement effectués avec les options maximales, nous avons obtenu presque à chaque fois un résultat supérieur à 60 ips. Dans certains jeux, on est à plus du double :

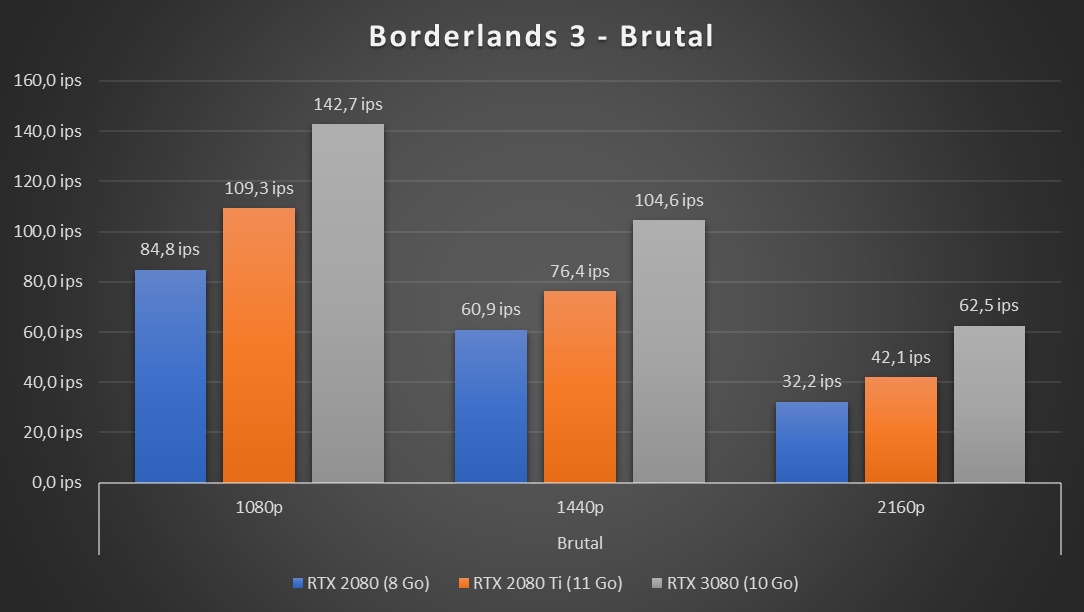

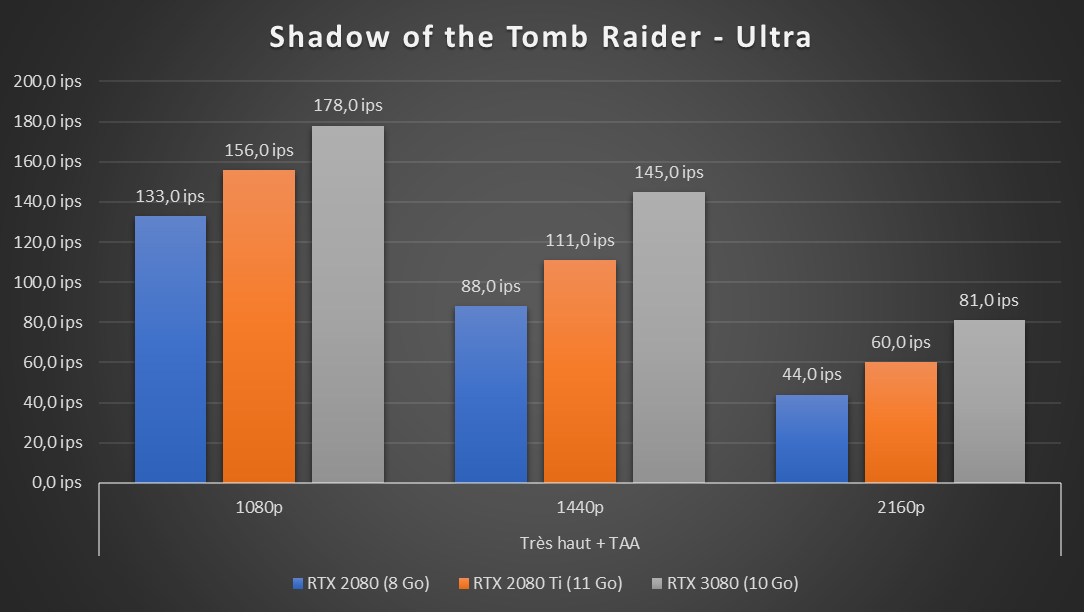

Clairement, cette carte n'est pas faite pour un simple écran 1080p. C'est le cas où les gains sont le plus faibles par rapport aux générations précédentes. On est quand même dans un ordre de 35 % et 16 % en moyenne. On retrouve parfois les 70/30 % des benchmarks, notamment dans les jeux gourmands comme Borderlands 3.

Dès que l'on passe au 1440p les écarts retrouvent leur normale, la carte s'exprimant à son meilleur en 4K. Là aussi Borderlands 3 se distingue avec des gains pouvant atteindre 94/48 %, dépassant pour la première fois les 60 ips en 4K. Des gains impressionnants, surtout lorsque l'on se rappele qu'il s'agit d'une carte à 720 euros, là où la 2080 Ti était commercialisée dans les 1 200 euros encore ces dernières semaines.

Notez que la version Vulkan de Tom Clancy's Breakpoint a rencontré un souci dans sa version 4K avec les RTX 2080 et 3080, sans que nous sachions pourquoi. Sans doute un bug qui devra être corrigé. La version DirectX du jeu n'a pas rencontré le même problème. Nous n'avons donc comptabilisé que celle-ci pour nos moyennes.

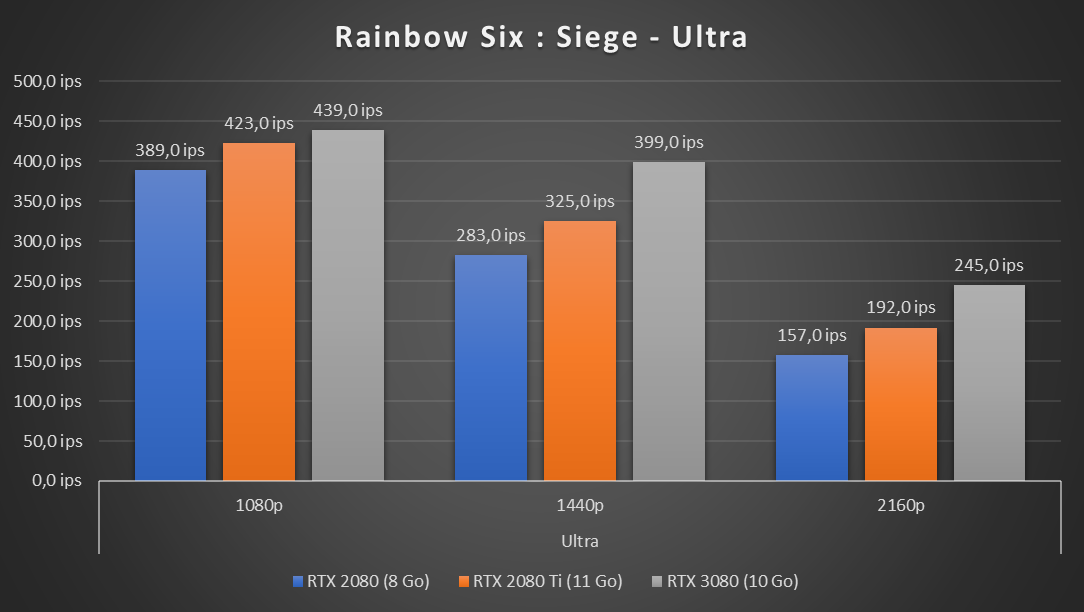

Bien que très peu gourmand, Rainbow Six Siege profite aussi du passage à la série 30 de manière plus intensive dès le 1440p, où l'on frôle les 400 ips. Le jeu est donc paré pour les dalles à 360 Hz que vont tenter de nous vendre NVIDIA et ses partenaires. On grimpe à 245 ips en 4K, le CPU limite par contre à 439 ips en 1080p... tout de même.

Performances RTX/DLSS : la cerise sur gâteau

Comme on pouvait s'y attendre, ces écarts augmentent avec l'activation du ray tracing ou de DLSS. Les RT/Tensor Cores ayant été améliorés et la puissance FP32 revue à la hausse, les jeux compatibles en profitent pleinement. Surtout ceux qui n'utilisent plus un rendu classique, comme Quake II RTX :

Ici, on retrouve un gain de 85 à 90 % par rapport à la RTX 2080, comme pour Bordelands en 4K. De 45 à 50 % par rapport à la 2080 Ti. Le 4K à 60 ips n'est pas encore pour tout de suite, mais on s'en approche petit à petit. On peut néanmoins en profiter à près de 90 ips en 1440p, ce qui est déjà impressionnant.

NVIDIA a mis à notre disposition un patch spécifique pour Wolfenstein : Young blood, permettant d'améliorer les performances (notamment en 1080p) et d'activer le fonctionnement asynchrone des RT Cores. Nous avons relevé les résultats de la version actuelle du jeu et de ce patch qui devrait bientôt être rendu public.

Là encore, on dépasse dans tous les cas les 60 ips en 4K sans DLSS 2.0. Avec, on double ce chiffre, même en demandant le niveau de rendu « Qualité ». En moyenne, les gains en 1440p avec RT/DLSS sont de 77/40 % par rapport aux 2080 et 2080 Ti. De 89/43 % en 4K.

Les temps de rendu 3D divisés par deux par rapport à la 2080

Comme on pouvait s'y attendre, si la GeForce RTX 3080 est une carte intéressante dans les jeux, allant jusqu'à dépasser les meilleures cartes de la génération précédente de 30 à 40 % selon les cas, ce n'est pas l'usage qui leur est le plus favorable. Pour s'en convaincre, il suffit de lancer Blender 2.90 dans une scène basique, comme bmw27 :

Bien que simplissime, elle bénéficie d'un gain de... 125 % par rapport à la RTX 2080 et de 70 % par rapport à la 2080 Ti. Ce rendu, qui nécessite près d'une minute même sur les plus gros CPU du marché, ne demande ici que... 12 secondes. Et ce n'est pas la scène qui affiche les plus gros écarts. Nous en avons retenu deux autres.

La première est barbershop, disponible dans les démos publiques de Blender. La seconde est une scène de test fournie par NVIDIA permettant d'activer le flou cinétique, mieux pris en charge par les RT Cores de seconde génération intégrés à l'architecture Ampere, ce qui est d'ores et déjà exploitable via OptiX.

Dans le premier cas, les gains passent respectivement à 125 et 112 %. Une scène qui mettait près de 15 minutes à calculer sur GPU n'en demande désormais plus que 7 ! Les chiffres grimpent à 191/160 % avec le flou cinétique.

Dans la plupart des autres tests, on trouve des écarts de plus de 100 % par rapport à la 2080 et aux alentours de 60 à 70 % par rapport à la 2080 Ti. Nous avons effectué des relevés dans différentes applications compatibles avec l'accélération du ray tracing de NVIDIA : Reshift, V-Ray, Octane, etc. Dans SpecViewPerf, qui n'en tire pas partie, les résultats sont plus limités, même si dans certains tests les gains sont aux niveaux relevés pour les jeux : 70/30 %.

Dans un outil de pur calcul comme Hashcat, qui sert à casser des mots de passe, cela dépendra des algorithmes et de leur complexité. Un MD5 verra par exemple très peu de gains, même si en poussant un peu sur les paramètres en mode manuel nous avons réussi à grimper à 59 759 MH/s, plus que ceux par défaut (workload 4).

Mais sur les PDF, SHA-512crypt ou Scrypt, on s'approche au pire des 100 % par rapport à la 2080, allant jusqu'à 159 %. Vis-à-vis de la 2080 Ti, on est entre 59 et 135 % de gain sur ces trois cas précis.

Pour la compression vidéo, n'espérez pas de gain. Le moteur NVENC reste le même. Les seuls gains pouvant être espérés dans des outils comme Première sont ceux de l'application de filtres CUDA ou exploitant les Tensor Cores par exemple. Nous avons relevé 69,4 ips pour une compression 4K > 1080p dans Handbrake en H.265 via ce moteur, comme sur les RTX de série 20.

Reflex et Broadcast : NVIDIA vise les amateurs de compétition

Comme nous l'avons évoqué ces dernières semaines, l'arrivée des GeForce RTX de série 30 signe celui d'améliorations logicielles. Certes pas du pilote lui-même, qui commence pourtant à se faire vieux, mais des outils annexes et autres solutions pour les développeurs. Notamment Reflex qui intègrera demain Fortnite, puis d'autres.

Mais aussi Broadcast qui permet aux streamers de retirer leur fond en temps réel, d'annuler les bruits ambiants de leurs micros, d'assurer un suivi de leur visage par la caméra automatiquement. Nous aurons l'occasion de revenir en détails dans ces fonctionnalités lorsqu'elles seront pleinement disponibles.

On apprécie aussi que l'overlay soit destiné à être renforcé pour être plus utile, à la manière de ce que propose déjà AMD. De nouveaux pilotes seront ainsi proposés sous peu pour apporter ces améliorations. Des nouveautés qui ne sont pas, pour la plupart, réservées aux GeForce de série 30.

C'est plus performant, d'accord, mais est-ce plus efficace ?

La question de la consommation de la RTX 3080 nous a occupé quelque temps. En effet, c'est la carte la plus gourmande du constructeur jamais produite pour le marché grand public avec ses 320 watts. Impossible donc de mettre un équivalent en face et d'opposer leur niveau de performances.

Surtout, les méthodes classiques de relevé à la prise posent souci. Le CPU a aussi son rôle à jouer, et s'il consomme 150 watts sur 300 watts relevés pour le GPU, il pénalise d'autant les gains d'efficacité relevé. Sans parler du rendement de l'alimentation. Mais cela a l'avantage de correspondre à ce que paiera le consommateur.

NVIDIA recommande de son côté aux testeurs de s'appuyer sur son outil FrameView à une performance fixe dans un jeu (60 ips par exemple) pour opposer une carte à une autre. Il met aussi à disposition de certaines testeurs son kit PCAT (que nous n'avons pas reçu) pour isoler la consommation de la carte du reste du système matériellement.

Nous avons donc opté pour une solution intermédiaire. Les relevés ont été faits à la prise avec un dispositif de notre conception (nous y reviendrons dans un prochain article). Chaque seconde, la consommation est relevée pendant un test. Nous en tirons une moyenne que nous mettons en relation avec les performances observées.

Dans le premier cas, il s'agit du test intégré de Borderlands, lancé en 4K avec le niveau de qualité Brutal. Nous divisons la consommation par le score obtenu afin d'obtenir la quantité d'énergie nécessaire en joules (J) pour calculer une image. Dans le second cas, nous multiplions le temps de rendu de la scène barbershop par la consommation pour obtenir la quantité d'énergie en Wh nécessaire pour effectuer le rendu entier de l'image.

Et comme on peut le voir, si la consommation relevée à la prise est bien en hausse, de 15 à 40 % selon les cas, c'est très largement compensé par les gains de performances. Le rendu de l'image sous Blender ne nécessite ainsi que 38,1 Wh contre 67/70 Wh avec les RTX 2080 (Ti), soit 45 % de réduction. Même constat pour Bordelands où l'on relevait 8,3 et 8,6 joules par image contre 6,9 désormais, une baisse de 28 et 16 %.

RTX 3080 et Core i9-10850K : une alimentation de 620 W suffit-elle ?

L'une des questions qui nous a le plus été posée sur cette GeForce RTX 3080 était l'alimentation nécessaire. NVIDIA recommande 750 watts, certains constructeurs poussent vers leurs blocs de 850 watts. Comme toujours, il n'y a pas de réponse automatique sur le sujet, tout dépendra de votre machine, notamment du CPU.

Pour vérifier qu'une alimentation de 620 watts est suffisante, nous avons utilisé un de nos anciens modèles Antec sur l'ensemble de nos tests. Malgré le Core i9-10850K, il a tenu le choc sans problème. La consommation relevée à la prise (prenant donc en compte le rendement de l'alimentation) grimpait parfois à 520 watts, mais pas au-delà. Si nous poussions volontairement le CPU et le GPU, on pouvait atteindre 620 watts.

Ce bloc est donc suffisant, surtout si vous avez un CPU moins gourmand. Sinon, il atteindra ses limites, particulièrement si vous overclockez le CPU et/ou le GPU. Ce dernier devrait d'ailleurs avoir une bonne marge de manœuvre, ne serait-ce que lorsque l'on poussera la limite de température et ou de consommation.

Nous referons le point sur le sujet lorsque tous les outils auront été mis à jour. D'ici là, considérez la recommandation de NVIDIA comme adaptée. Rien ne sert de monter trop haut ou de dépenser des fortunes, optez simplement pour un bloc d'alimentation de qualité, si possible certifié 80PLUS pour avoir un bon rendement.

La carte haut de gamme dont certains rêvaient

À 720 euros, la GeForce RTX 3080 n'est pas pour toutes les bourses. Certains préfèreront attendre la RTX 3070 à 520 euros qui sera sans doute plus taillée pour le 1440p, comme l'était déjà la 2080 qu'elle remplace. Le tout en profitant des avantages de NVIDIA, du ray tracing à DLSS en passant par Reflex, Broadcast, etc.

La RTX 3080 est taillée pour la 4K, pour le 1440p « confort » notamment avec des écrans à 120 Hz+ et surtout pour le calcul. Il y a de fortes chances que les professionnels se l'arrachent pour cette raison, même si certains attendront sans doute de voir ce que la RTX 3090 et ses 24 Go de GDDR6x ont dans le ventre.

On apprécie le gain en efficacité énergétique apporté par Ampere, le silence de la carte et son design plutôt convaincant. Bien entendu il faudra attendre de voir ce que les partenaires proposeront, mais cette Founders Edition est déjà de très bonne facture. Les stocks seront-ils suffisants ? Nous le saurons demain.

Car pour ceux qui disposent du budget, avoir 40 % de performances en plus d'une RTX 2080 Ti pour 40 % de moins sur la facture finale est déjà un argument suffisant pour craquer. De quoi opposer à AMD et ses Radeon RX 6000 un double défi pour convaincre en novembre prochain : être au niveau, et le faire à un tarif aussi compétitif.

Commentaires (89)

#1

Pile à l’heure

J’attendais votre analyse avec impatience !

#2

Merci pour ce test. C’est une belle bête. Concernant les stocks, je suis assez étonné que les customs arrivent avant la FE (du moins pour la strix en précommande dès ce week end chez amazon pour une réception dès demain !).

#3

Un peu de retard en fait et quelques graphiques qui manquent, je mange et après j’ajoute les derniers détails

FE et custom c’est le 17 pour tout le monde (NDA Revendeur). Amazon et la Strix c’était une erreur qui a rapidement été corrigée

#4

Je vais attendre une 3080Ti pour changer ma 1080Ti. Je ne suis pas du tout pressé, ma carte actuelle a encore de beaux jours devant elle.

Très chouette analyse en tout cas

#5

Merci pour l’analyse ! En FHD ma 2070 Super me suffit. :-)

#6

Cry in 2080ti

Meme si c’est pas la pilule annoncée je l’ai paye un peu cher d’occas’z

#7

Ma 5700XT Nitro+ va tirer sa révérence de manière anticipée je le crains, les problèmes de drivers qui n’en finissent plus auront eu raison de moi.

Se choper 100% d’utilisation du GPU sur la plupart des jeux (même sur des jeux assez anciens et peu gourmands) parce que le jeu n’est pas compatible avec un des paramètres du driver ça finit par lasser (une fois c’est l’enhanced sync du driver, une fois c’est la synchro V du jeu, une fois c’est l’antialiasing du jeu), je deviens fou et à chaque jeu que je lance pour la première fois je me demande combien de temps je vais mettre à le configurer…

#8

Bon je crois qu’il est temps de remplacer ma 770… Manque que l’annonce du Ryzen pour mon Core i5 (oui bon ok je change tout sauf le boitier quoi :P )

#9

500W de consommés, voire plus en poussant.

Pour rappel, il est considéré qu’un radiateur soufflant de 500W peut chauffer 5m2.

L’article évoque l’efficacité électrique, mais est-ce bien raisonnable quand l’énergie consommée est celle d’un chauffage (d’appoint) ?

En été, il faut ajouter une clim pour jouer, cela va encore diminuer l’efficacité

#10

Les 500W de chauffage sont à déduire de ta facture de chauffage l’hiver ;)

Par contre effectivement l’été c’est plus compliqué.

#11

Merci pour ce test !

J’avais un peu d’appréhension, mais au final ça confirme que nVidia n’a pas pris les gens pour des cons.

Ça m’a convaincu de remplacer ma 2080 (je joue sur TV 4K)

#12

Il est possible d’under OC, passer la Power Limit en négatif etc..

#13

Tu peux aussi monter une machine qui consomme moins, l’efficacité d’une architecture est une chose, valable sur l’ensemble de la gamme, la puissance brute d’un modèle une autre.

#14

500W consommé ce n’est pas 500W de chaleur

Sinon il est temps de lancer un nouveau concept de GPU muraux

#15

David, si tu as envie de jouer, peux-tu le faire sous Cinema 4D?

Vivement qu’on puisse commander les ROG 3090, j’en ai une à acheter…

#16

Bah en fait si. Ton énergie doit partir quelque part, et c’est bien en chaleur.

Tu rigoles, mais il y a effectivement des projets de calculateur intégré à des radiateurs où tu loues de la puissance de calcul en chauffant ton logement (gratuitement du coup).

#17

Si ton ordi restitues 100% de la puissance consommée en chaleur c’est que c’est un radiateur, pas un ordinateur.

#18

Les numériques sont plus critiques sur le bruit des ventilos. Je comprends que l’organisation interne joue pas mal dessus (c’est logique que la manière dont le boîtier est ventilé ait un impact). Mais ils notent malgré tout que les ventilos peuvent vite monter dans certaines configurations et dans ce cas, être bruyants.

Techpowerup semble dire comme vous. Vous n’avez rien noté de particulier (notamment la cohabitation ventirad CPU et CG) ?

#19

A moins que ton ordinateur stocke de l’énergie sous une autre forme, alors oui un ordinateur d’un point de vue externe est un simple radiateur.

#20

J’ai installé la carte dans mon setup Micro ATX sans trop de souci. Après ça dépendra forcément du flux d’air global, si la machine est orientée silence (ventilo off) ou pas. Mais je n’ai pas relevé de soucis particulier. Après soyons honnêtes : un GPU avec 320 watts au compteur, ça se met dans un grand boîtier bien ventilé, pas dans un mini PC.

#21

Très grand merci pour cette analyse complète ! Ça donne envie …

#22

Je viens de lire sur les numériques qu’un CPU un peu ancien limiterai la performance.

J’ai aujourd’hui un 6700k + une GTX980 et je joue en 1200p. Vu que ça ne vaut pas le coup d’acheter un modèle plus ancien, je me pose la question de savoir si je serais limité avec cette carte ci a cause de mon CPU.

En tout cas, je devrais pouvoir jouer en ultra sans soucis…

Quant au bruit et à l’évacuation de la chaleur vers l’entre du radiateur du cpu, j’attends de voir ce que donne les cartes tierces.

En tout cas, nvidia fait un produit techniquement intéressant, ce qui fait plaisir à voir (et à avoir )

)

#23

Certes certes, je ne comptais pas la mettre dans un mini-ITX (par contre, j’attends le test de la 3070 pour cela) ;)

#24

nVidia a fait du bon travail. Hâte de voir les nouveaux Ryzen pour un combo gagnant en jeux mais nettement moins dans mon portefeuille.

#25

C’est toujours pareil, c’est assez vrai en 1080p, moins en 4K. Quand le GPU attend le CPU ça joue, quand c’est l’inverse on s’en fout un peu

#26

En plus limiter, avoir 180 ou 200 fps ^^

Merci pour le dossier, ca va être dur d’attendre le 28 octobre

#27

Ça a été répondu plus bas mais pour ajouter un peu de détails, l’énergie électrique peut se transformer en 3 autres énergies:

Un CPU ne produisant ni énergie mécanique, ni lumière ou onde (en tout cas négligeable), tout part donc en chaleur.

On peut donc dire qu’un PC est un smart-radiateur.

Je m’étais déjà fait la réflexion du gâchis d’énergie des radiateurs électriques, alors qu’on pourrait faire du calcul avant de cramer l’énergie bêtement.

Et donc en hiver, un pc qui consomme 500W économise 500W d’énergie d’un radiateur type grille pain.

#28

D’où Qarnot

#29

Salut,

J’ai regardé des tests sur nextinpact, et sur d’autres sites, je ne comprend pas les résultats sur le 1080P.

On parle quand même de 30% en 1080P à 100% de perf en plus sur du 4K entre 2 cartes.

Quelqu’un pourrait-il expliquer pourquoi la différence de performances entre chaque cartes se fait sentir uniquement en 1440p et 4K et non en 1080P ?

Ces résultats ne sont-ils pas surprenants pour des cartes de dernière générations ?

#30

Comme dit dans l’article, en 1080p on est “CPU bound”, le GPU attend le CPU, pas l’inverse comme en 1440p/2160p.

#31

Est-ce normal qu’avec un CPU aussi puissant que le Ryzen 9 3950XT on arrive a être limité par le CPU en full HD ? Qu’est-ce qui fait le CPU n’est plus capable de suivre le GPU ?

Je n’ai pas les chiffres ni les pourcentages mais j’ai l’impression que ces écarts importants ne concernent que la RTX3080.

#32

De ce que j’ai compris c’est simplement parce que tous les calculs sont fait trop vite par le gpu, donc s’il y a plus rien à calculer, bah y’a plus rien à calculer

#33

Ce n’est pas spécifique à la RTX 30080, c’est spécifique à tout GPU trop rapide pour la définition affichée. Cela peut dépendre des jeux (certains sont plus gourmands que d’autres), du niveau de qalité, etc. Comme on l’explique, la 3080 n’est pas une carte faite pour le 1080p, elle est souvent trop puissante pour cela. Donc elle s’y exprime avec de plus faibles écarts qu’en 1440p/2160p. Mais si tu prends une 2080 Ti pour jouer en 720p ou avec un niveau de qualité plus faible en 1080p tu auras le même souci.

N’importe quel CPU sera concerné, si le traitement du GPU va trop vite par rapport à la charge que le CPU doit traiter de son côté, le résultat sera le même.

#34

Dans tous les cas ça finit en chaleur y compris pour l’energie mécanique et les rayonnements…

#35

En voyant les benchs synthétiques avec 3DMark, ça m’a rappelé que je n’avais pas lancé mes tests après la màj 2020 de W10, ça va, ma 1080ti n’a pas à rougir face à la 2080, face à 3080 par contre…

TimeSpy GT1 à 63.9i/s, GT2 à 57.9i/s (https://www.3dmark.com/spy/13904112)

TimeSpy Extreme GT1 à 29.3i/s, GT2 à 26.7i/s (https://www.3dmark.com/spy/13903990)

Pour l’alim, même si la 3080 FE tient sur une 620W avec l’i9-10850K et son TDP de 125W, ça ne me rassure pas sur l’achat d’une éventuelle 3080 custom qui tournerait sur mon alim de 650W avec mon vieux proco et ses 140W de TDP.

#36

Sur ce point, chaque configuration sera différente, mais s’il y a deux PCIe 8 broches en général ça passera. Mais il faudra éviter d’abuser ou d’espérer faire un OC de barbare. Tout dépendra aussi du comportement de la custom, qui peut être différent de la FE. PS : le TDP n’est pas un indicateur de consommation, attention.

#37

Merci pour les explications et d’avoir pris le temps de me répondre.

Maintenant il ne reste plus qu’à attendre AMD avec ses RX 6000 mais malheureusement je ne suis pas optimiste, vu qu’il se faisait déjà battre à pleine couture sur la génération précédente, j’ai bien peur que cela se répète :s

Enfin, j’espère vraiment me tromper…

#38

Ben moi, j’ai complètement craqué pour une 3090 Rog Strix O/C que j’ai précommandée chez Amazon… Ça m’a un peu (beaucoup ? ^^) rincé mais au moins, je pense pouvoir la garder sans avoir envie de la changer d’ici 5 à 6 ans. ;)

Et puis, pour le streaming ou l’encodage à la volée de vidéos, ça devrait aussi bien le faire ^^.

#39

Ca y est la 4k devient réelle. Hâte de voir la gamme 3070 et 3060 au niveau de la chauffe.

#40

Salut !

Merci pour le test, petite remarque juste, ça serait cool que pour les futurs tests lorsqu’il y a des graphiques de comparaison qu’il y ait une note en bas pour indiquer “lower is better” ou dans le genre !

#41

Super ! Merci NXI ! Du coup avec ma vieille 1080, mon i7 6700K et mon alim à 650W, aucun risque de voir cette carte cramer mon alimentation !

… Par contre, va falloir dire adieu mon CPU à un moment donné :(

#42

Je ne sais pas si il y a un gain de performance quelconque sur la 3090, mais sur les 70⁄80, ça ne change strictement rien car l’encodeur est exactement le même.

Attention à l’usure de l’alimentation, qui pourrait permettre de fournir moins de courant que ce que l’alimentation le permettait à son ouverture de carton. Après, changer l’alimentation en même temps que ton processeur te permettra de monter un vieux pc “pour la famille” et de ne pas se trainer une vieille alimentation ambigüe pendant 10 ans….

A vue de nez, tu en as encore pour un an ou 2 pour ton processeur ;)

#43

j’attends de voir ce qu’il proposent pour une config plus modeste en low profile pour remplacer ma 1050 TI

en espérant faire de 1080p tranquille

#44

Je sais que le TDP =/= conso, mais ça donne tout de même une idée à la grosse louche. Je ne fais plus d’OC depuis longtemps, enfin juste à l’achat pour voir ce que le matos a dans le ventre, puis je laisse tout @stock, mais je crains juste que les cartes custom OC d’origine par rapport aux FE aient des conso nettement plus élevées, de mémoire les 1080ti OC pouvaient allègrement dépasser les 300W de conso là où les FE restaient sous les 285W.

Je lutte pour ne pas entrer dans le jeu de Nvidia et me précipiter sur Ampere, actuellement je n’ai encore jamais eu de problème pour jouer en UHD à plus de 60fps avec la 1080ti, mais ils sont forts pour faire monter la hype et me donner envie de changer de carte

J’essaie de me raisonner à attendre les tests des différents modèles customs et voir également ce qu’AMD va proposer, ou encore voir des modèles avec plus de 10GB parce que je reste persuadé que ça risque d’être court à terme en UHD/RTX on… et puis, si j’arrive à ne pas craquer, il y a aura peut-être une surprise à la clé de type Pascal avec une 3080ti en 7 ou 5nm d’ici 1 an… on peut rêver

#45

Comme on est dans la précision, le facteur de puissance n’est pas le même, un radiateur est juste une charge résistive donc on reste sur de la puissance active avec un rendement de 100 %.

Alors qu’un PC c’est aussi un mélange de charge capacitive et inductive donc le cos phi n’est pas à 1 et on se choppe de la puissance réactive.

Donc on se choppe un mauvais rendement (même si dans ce cas-ci on cherche la perte joules pour le côté chauffage du bouzin) ça peut avoir une incidence du côté du producteur d’énergie et en général le producteur fait payer les industriels qui ont un mauvais cos phi.

Ici ça reste très limité on est d’accords mais sur le volume ça peut impacter surtout sur du matos bas de gamme.

#46

@david

vous avez noté 210MHz en fréquence GPU au repos sur un seul écran, mais quand vous en mettez plusieurs (2/4k peut importe avec des frequences >60Hz), ça donne quoi ? 1000-1200 ?

#47

J’ai du mal à croire que tu dépasses les 60 fps en UHD mais ça doit dépendre des jeux ?

Pour ma part, avec une 2080 (non Super), je tourne entre 50 et 60 (voir moins sur AC Odyssey qui est certes optimisé à la truelle par les génies d’Ubisoft).

#48

Pour le coup, est-ce que vous pensez que la 3070 sera plus adapté au 1080p ?

Où est-ce qu’il faut attendre la future 3060 pour profiter pleinement des capacité sur cette résolution ?

#49

Hum voilà encore un exemple où l’analogie me met dedans

Pour moi c’était justement comme un moteur, la chaleur vient d’un mauvais rendement.

Donc finalement dans un PC, mis à part les ventilo (oui ca va pas loin du coup XD) , tout part en chaleur ?

Autant faire du cryptomining en hiver et couper le chauffage alors…

#50

Pour du 1080, la 2060 suffit déjà pour du 60 fps. Ca dépend surtout du nombre d’images par secondes que tu souhaites obtenir.

#51

Sur PC je joue principalement à des FPS, et à part la qualité des maillages, du terrain et des textures que je mets généralement en high, j’ai tendance à désactiver ou mettre en low pas mal de trucs qui nuisent à la visibilité ou aux perfs. Dernièrement, j’ai plus joué sur console, donc j’ai pas de références très récentes, mais je jouais à Battlefield V ou Borderlands 3 autour des 80-90fps.

#52

Quels problemes de drivers ? J’ai la meme carte et aucun soucis …

#53

si toute l’énergie consommée part en chaleur alors il ne reste rien pour faire les calculs nécessaire au fonctionnement de ton ordinateur. La chaleur est la conséquence des pertes d’énergie inhérentes, non du fonctionnement voulu.

#54

« Certains préfèreront attendre la RTX 3070 à 520 euros qui sera sans doute plus taillée pour le 1440p »

La 3070 est l’équivalent de la série S chez Xbox.

#55

Ou pas

#56

Un calcul ne contient pas d’énergie. Essaye d’imaginer en quelles formes d’énergie ton électricité a pu être transformée (il n’existe pas des milliers de formes possibles). Tu devrais te rendre compte qu’à la fin, ça finit en chaleur. Même l’énergie des ventilateurs qui devient mécanique finit en chaleur par frottement, la lumière de ton écran aussi,…

#57

Ou pt’ête.

#58

#59

bah il a pas tort en fait

un calcul c’est quoi ? des électrons qui ont été déplacés, comment ? en les excitant

la chaleur c’est quoi ? une excitation de la matière

donc un calcul informatique n’est au final que de la génération de chaleur.

le seul truc c’est que le calcul en lui-même n’est à l’origine que d’une fraction de la chaleur générée par l’ordi, les courants de fuite et autres pertes sont largement plus générateurs de chaleur à priori.

ça doit pouvoir se calculer l’énergie nécessaire pour faire un calcul via des transistors “parfaits”, et donc on devait pouvoir en déduire le rendement des processeurs (si pour 1TFlop à une gravure de 10nm il faut 10w, et qu’un processeur à besoin d’un radiateur pouvant dissiper 100w, …)

#60

Tu compares une carte dédiée de 20 TFLOPS avec une console atteignant 4TFLOPS.

C’est comme dire que la Xbox One X est faite pour jouer en 4K, oui elle peut afficher du 4K et quelques jeux en 4K mais avec quelle qualité graphique? On est plus proche d’une qualité basse ou moyenne.

Donc là où la 3070 pourrait te sortir un Borderlands 3 en Brutal à 80fps en 1440p, la series S va peut-être te sortir du 30fps en qualité Ultra/Haute ou 60fps en qualité Moyenne.

Bref l’équivalent d’une Series S côté PC c’est une GTX 1060 (à vue de nez)

#61

Quelqu’un sait-il si les Founders Edition sont trouvables/achetables en Suisse ? Visiblement, le shop officiel nVidia redirige en France, mais il n’est pas possible de se la faire livrer dans ce pays… Remarquez, je n’ai pas essayé concrètement, mais c’est ce que j’ai lu.

#62

Après, il y a le démon de Maxwell qui a fait pas mal réfléchir sur la relation entre l’entropie et l’information.

#63

Pour résumer cette carte offre un rendement de 25% à 50% de plus pour les performances en pleine charge. Avec une consommation plus ou moins 15% à 40% de plus. Le tout par rapport à ses petites sœurs.

Qu’en est t-il de la consommation en mode bureautique (basse charge) ?

#64

On l’a évoqué dans l’article

#65

Loin d’être un expert du sujet, vous parez du principe que tout ce qui rentre est transformé en chaleur. Pourtant, il y a bien des “données” qui sortent, donc la production de chaleur est bien la résultante d’une perte, d’une imperfection du processus… Non ?

#66

Je parlais au niveau marketing, pas au niveau hardware. De la perception pour le client. « Moi je suis plutôt ci donc c’est cet item qu’il me faut ».

Ensuite spécifiquement au hardware, les teraflops ne disent pas grand chose, Sans une notion de rendement et d’objectif collés à leurs fesses.

#67

Une fois pour toute je vais tenter de clore définitivement le débat : Tout dépend quel framerate / qualité graphique et combien de temps tu veut garder ta carte. C’est aussi “simple que ça”.

#68

Si j’ai bien compris l’exercice de pensée du Démon de Maxwell, oui, l’information peut être utilisé pour diminuer l’entropie. Cependant pour l’instant, les Watt utilisé pour l’obtenir sont quand même bel et bien partie en chaleur alors que l’information est rarement utilisé pour diminuer l’entropie (la chaleur).

#69

Du coup quel chipset est préférable? Je suppose qu’il faut exploiter du PCIe4? Quels sont les choix idéaux niveau CM et CPU?

#70

Lire l’article

#71

Je suis tenté de changer ma 980 Ti par une 3080… Cependant, je ne sais pas si mon i7 5930K ne briderait pas le GPU… Quoi qu’il en soit, ne joue plus assez pour que cela soit intéressant pour moi, pour le moment.

Superbe article en tout cas.

Merci !

#72

En effet je suis passé trop vite dessus, toutes mes excuses! Je pensais que la différence de perfs entre PCIe3 et 4 était bien plus importante.

Je pensais que la différence de perfs entre PCIe3 et 4 était bien plus importante.

Du coup, est-ce qu’un upgrade fait du sens/est compatible pour ceux qui sont sur des configs vieillissantes ( ex : socket LGA-1150 + chipset Z97) quitte a avoir un peu de bottleneck pendant un moment?

Ou est-ce qu’il faut forcément faire évoluer le CPU+chipset?

Changer de CPU/CM semble peu intéressant en ce moment (si on peut/veut attendre l’USB 4 par exemple), non?

#73

Mouais, le 1440p pour celui qui joue sur TV, c’est très loin de lui parler…

#74

Le bottleneck dépendra surtout du jeu, si le GPU est sous l’eau le CPU l’attendra et donc forcément… mais il n’y a pas de règle fixe qui permet de dire “ce CPU est une limite” ou pas.

Après ça peut être intéressant de mettre à jour le GPU puis dans un second temps CPU/CM, tout dépend de l’empressement et du budget. Dans tous les cas, même si le GPU est limité par le CPU, il fera forcément mieux que les générations précédentes ;)

Mais oui, avec les nouvelles générations CPU qui arrivent, autant attendre encore un peu de ce côté-là.

#75

Merci pour ta réponse

Pour ma part j’ai un i7 4770 (Haswell) + MSI Z87-GD65. La DDR3 1600Mhz (bien que 32Go) et la vitesse du CPU (quad 3.9Ghz) se font vraiment vieux… mais remplacer la GTX1080 est très tentant, surtout tant qu’elle a encore un minimum de valeur de revente!

La 3080 est en effet une carte dont certains comme moi rêvaient, surtout pour la VR, mais aussi pour le jeu en 1440p… et refaire Quake II :).

#76

Salut,

Comptez-vous essayer un undervolt sur la carte graphique et faire un test de performance dessus pour voir combien de watt on peut gagner tout en gardant des performances équivalentes ou légèrement inférieur, afin d’améliorer le rapport performance / watt ?

#77

Comme dit un peu plus haut, j’ai quelques trucs en cours, j’attends de voir comment se comportent les différents outils dont certains ont été mis à jour récemment avant de publier

#78

De quoi changer ma 1080Ti ? Franchement, le gain vers la série 20xx l’avait laissé de marbre, reste à voir quelle carte acheter dans la série 30xx …

Je vais attendre les benchs qui incluent des cartes un peu plus vieilles (parce que oui, sauter une génération sur deux c’est quand même mieux)

#79

Bah on peut toujours intégrer plus de cartes mais bon ça multiplie surtout les doublons dans les graphiques et les temps de test pour pas grand chose. Les rapports sont connus. La 1080 Ti c’est un peu moins que la 2080 en général (qui fait +10% en moyenne de mémoire) sans tous les avantages de l’architecture Turing.

#80

Heu tu m’inquiete un peu Patos,, J’ai exactement la même conf que Thoscllen; à savoir 1080, I7-6700K et alim de 650W.

Tu veux dire quoi par “encore pour un an ou 2 pour ton processeur” ? Ca s’use pas vraiment ces petites choses normalement. Et pour l’instant je ressens aucune lenteur ou problème à l’utilisation et ce même avec des jeux qui viennent de sortir ou en utilisation “bureautique”.

Il y a FS2020 qui me tente bien (depuis le temps que je veux passer mon PPL) et on est encore au dessus des config recommandées pour la CG et minimal pour le CPU.

Bon par contre la question finale est : si grosso merdo, si une seule génération sur deux vaut le coups … quand sortiront les xTX5000 et est ce que nos pauvres config tiendront jusqu’à là ?

#81

Ca s’use pas mais ça devient petit à petit obsolète. Les nouveaux jeux d’instructions donnent de bons boosts de performance, les modes turbo évoluent, etc… Regarde les performances brutes de certains processeurs qui sont identiques avec 10 ans d’écart, mais au final, le nouveau est plus efficace grâce à ces évolutions.

Perso, j’estime qu’un processeur dure 6 ans et une carte graphique entre 3 et 4 ans selon le joueur.

#82

OK merci pour la précision.

Effectivement “selon le joueur”; celui-ci n’est pas “gêné” par son matériel actuel, il y a pas vraiment besoin d’en changer … Mais il va peut être se faire voir comme un Amish

Blague à part, reste plus qu’à attendre la comparaison entre les RTX30xx et les nouvelles d’AMD.

#83

Houla, je viens d’avoir une jolie 404, avec Nginx qui ronchone en postant mon commentaire du dessus.

Je sais pas se qu’il sait passé.

Par contre sait on quand on commencera à voir des PC portable avec cette génération de CG ?

#84

Sans doute pas avant le début d’année prochaine, TGL arrive à peine chez Intel, on aura sans doute des nouvelles autour du CES.

#85

Est-ce que passer pour un amish est un problème ? L’essentiel est que ta configuration te convienne par rapport à ton usage et tes moyens. L’avis des autres, tu t’en branle

#86

Bien résumé

#87

Ha mais je suis tout à fait d’accord avec toi sur ce point.

#88

Pour le coup j’ai assez confiance dans mon alimentation, ma configuration actuelle n’ayant jamais dépassé les 400 W de consommation instantanée. En plus y’a déjà une prise 12 pins dessus !

#89

Je pense pas qu’il parle d’usure mais plutôt d’obsolescence. Mettre une 3080 avec un i6700 c’est peut être un peu du gachit de GPU, parce que le CPU n’est plus assez rapide ou puissant :p