Si AMD est une fois de plus dans une phase de troubles et de changements, la société veut rassurer, mais sans forcément trop en dire. Ainsi, alors que la fin de 2014 approche à grands pas, la roadmap 2015 n'est toujours pas dévoilée à une exception près : l'arrivée prochaine de Carrizo et Carrizo-L. Un nouvel APU promis comme révolutionnaire, mais toujours gravé en 28 nm.

Après avoir capitalisé sur l'intégration de ses produits dans les consoles de dernière génération, AMD doit faire à nouveau face à ses démons habituels : des soucis financiers, une restructuration, et un changement à sa tête. En effet, le précédent PDG Rory Read a quitté la société afin de laisser sa place à Lisa Su depuis le mois dernier. Un poste de premier rang pour une femme dans le secteur des nouvelles technologies, qui est un double symbole puisque celle-ci n'est pas issue du marketing, mais d'une formation d'ingénieur du MIT.

AMD change de tête, annonce un bénéfice, mais continue de licencier

Et si AMD préfère indiquer que c'est une nouvelle ère qui s'ouvre suite à une restructuration massive, tous les voyants ne sont pas pour autant au vert. La roadmap 2015 est encore assez floue, et la promesse de passer au 20 nm faite par Su il y a quelques mois à peine fait déjà face à des rumeurs d'abandon au profit du 16 nm, plus tard.

Du côté des équipes, on a récemment appris que 700 nouveaux licenciements allaient être mis en place d'ici la fin de l'année, soit 7 % de son équipe actuelle. Une mauvaise nouvelle qui tombe alors que la société a annoncé un léger bénéfice à l'occasion du troisième trimestre de l'année : 17 millions de dollars pour un chiffre d'affaires de 1,43 milliard. Le constructeur peut d'ailleurs remercier ses revenus tirés du marché de l'embarqué et ses SoC « custom », notamment ceux vendus au sein des dernières consoles, qui permettent d'éponger les pertes (en hausse) de la section « Compute and Graphics » : 17 millions de dollars.

Cela ne devrait néanmoins pas sauver l'année puisque les deux trimestres précédents affichaient respectivement une perte de 20 et 36 millions de dollars, pour un chiffre d'affaires aux alentours de 140 millions. La marge est elle aussi d'un niveau assez stable, mais en baisse par rapport à l'année précédente : 35 %.

En réaction à ces chiffres, Lisa Su indique que « la performance de la section Compute and Graphics est plutôt mitigée du fait de conditions de marché très concurrentielles qui nous demandent de prendre de nouvelles mesures afin de renforcer nos résultats financiers dans ce secteur. Notre priorité est de fournir des technologies et des produits leaders sur leur marché alors que nous continuons de transformer AMD. »

La concurrence se porte comme un charme et déroule ses nouveautés

Il faut dire que la situation est problématique puisque ses deux principaux concurrents, Intel et NVIDIA, viennent de leur côté d'annoncer de très bonnes performances. Ils ont d'ailleurs à leur manière assuré leur présence sur le mobile en renfort de leurs solutions pour ordinateurs et serveurs, et visent de nouveaux marchés, le tout en ayant déjà évoqué de manière plus ou moins détaillée leurs produits à venir et leurs perspectives d'évolution. Résultat, si le cours d'AMD est en hausse ces derniers jours, il s'est effondré sur trois mois, passant d'un peu plus de 4 dollars à moins de 3 dollars. Ses deux concurrents, eux, sont en légère hausse sur la même période avec un cours respectivement aux alentours de 36 et 20 dollars.

Roadmap 2015 : du 28 nm et du flou

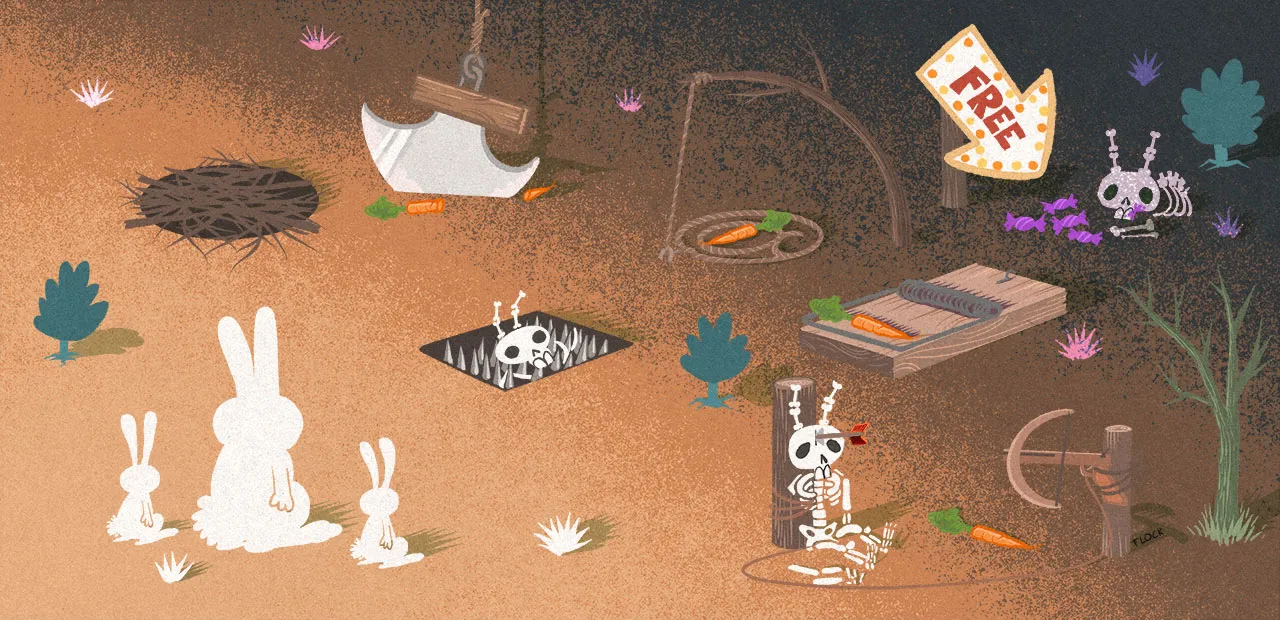

C'est dans ce contexte que la société a décidé d'en dire un peu plus sur sa roadmap 2015, avec un nouveau document publié il y a quelques jours, accompagné d'une vidéo (voir ci-dessous). Ne vous attendez à rien du côté des CPU ou des GPU, alors que rien de vraiment nouveau n'est sorti depuis des mois, sans parler des processeurs FX qui continuent d'être gravés en 32 nm... Il faudra, au mieux, attendre le CES pour en savoir plus sur ce terrain.

En réalité, c'est sur un seul segment qu'AMD a décidé de communiquer : la nouvelle génération d'APU dédiée aux ordinateurs portables et aux machines de type tout-en-un, connue sous le petit nom de Carrizo et Carrizo-L. Comme annoncé par la société et comme indiqué dans les documents fournis, leur packaging sera identique : un FP4 de type BGA (soudé à la carte mère, donc) :

Et si la version haut de gamme aura droit à une architecture CPU de nouvelle génération (Excavator) tout comme au niveau graphique (non détaillé), elle sera surtout la première à supporter pleinement HSA 1.0. Côté TDP, on reste dans le 15-35 watts, et pour cause : la finesse de gravure sera une fois de plus du 28 nm. Néanmoins, NVIDIA nous a montré avec Maxwell qu'il était possible d'améliorer grandement l'efficacité énergétique à gravure identique. De son côté, AMD indique que cette nouvelle série d'APU sera la plus performante et la plus efficace qu'elle a mise sur le marché. Reste à voir ce qui se cachera derrière ces promesses, tant les générations précédentes pouvaient parfois être décevantes malgré les annonces.

Pour la version « L », les évolutions seront bien plus légères. Car contrairement à ce que le nom peut laisser penser, il s'agit surtout d'une évolution des actuels Beema avec des cœurs Puma+ plutôt qu'une version allégée de Carrizo. Là aussi, ce sera d'ailleurs le 28 nm qui sera exploité, pour un TDP entre 10 et 25 watts.

« Tout va bien, nous sommes dans les temps »

Côté timing, John Byrne annonce dans sa vidéo que tout se passe bien et que ses équipes sont dans les temps. Les APU sont actuellement en phase de validation et l'on nous promet pour bientôt de nombreux designs exploitant ces nouvelles puces. Reste à voir si cela sera l'occasion d'une annonce dans le mois à venir ou s'il faudra attendre le CES. Quoi qu'il en soit, la période de lancement visée est la première moitié de 2015.

Partenaires, clients et même les acheteurs avec lesquels AMD dit échanger sur les réseaux sociaux seraient très enthousiastes à en croire le Vice-Président. Reste maintenant à voir ce qu'il en sera lorsque ces produits seront devenus une réalité, et ne seront plus que des promesses... et s'ils seront à même d'inverser la tendance du côté des ventes pour les trimestres à venir.

Commentaires (93)

#1

Courage AMD.

#2

#3

C’est stupide de dire ca.

Qu’on aime ou pas les produits AMD, c’est une concurrence à INTEL.

AMD serait pas la tu payerais beaucoup plus cher ton matos….. il ne faut surtout pas qu’ils disparaissent.

#4

T’aimes pas trop le lundi toi " />

" />

#5

Si il disparaisse, Intel risque de se faire découper.

L’idéal serait tout de même qu’ils perdent le droit exclusif sur les instructions x86. Cela empêche toute concurrence.

Ou alors, il faut un basculement sur ARM. Cela arrivera peut être avec l’arrivé des ARM 64 bits, si jamais un gros, vise la performance et pas seulement la consommation.

#6

#7

#8

Courage, AMD…

#9

On est tous avec toi ! (Depuis son ordinateur Intel/Nvidia)

#10

#11

C’est toujours un concurrent. Faut pas exagérer non plus, sur le marché des GPU pour joueurs, Intel n’existe pas. Ya que nVidia et AMD. Et si nVidia propose des cartes plus puissantes, AMD propose des performances légèrement moins jolies mais à des prix largement plus contenus, donc toute la clientèle est visée.

" />

" />

Sur le marché du GPU multimédia, nVidia et AMD n’existent pas, c’est Intel qui empoche la mise (d’ailleurs 70% des GPU dans le monde sont des Intel, simplement parce que la majorité des GPU sont des chipsets graphiques, donc Intel (laptops, PC vendus tout fait, etc.)

Sur le marché des CPU, AMD n’est pas non plus méga à la traine. Certes ils sont un peu mou du genoux, mais ils ont quand même des processeurs dans les dernières générations.

Donc ton raccourci du lundi, il sentait la frustration intérieure non ?

#12

#13

#14

+1

Surtout que depuis environ 8 ans, la course à la performance est devenue plus marketting que techniquement réelle, puisque c’est la course au nombre de cœurs plutôt qu’à la vitesse par cœur, alors même que les applications ne sont toujours pas massivement adaptées au multi threading…

Aujourd’hui on s’émerveille devant un CPU 2.5 GHz 16 cœurs, alors que hier, en dessous de 3.5 GHz on se plaignait…

#15

une architecture CPU de nouvelle génération (Excavator)

" />

" />

Bulldozer, Excavator. Ces noms de code, c’est pour signifier qu’AMD creuse sa tombe avec sa division cpu?

#16

ça sent le sapin pour eux quand même…

#17

En même temps ils n’ont pas les mêmes moyen en R&D. Dans un domaine hyper technique ça crains. Et l’écart ne pourra que ce creuser.

#18

#19

Grrrr ça m’énerve quand je vois ce genre de news ! AMD reveillez vous ! sortez nous un putain de proc de la mort qui tue ! que je puisse rebasculer … Pour le moment, je ne voie pas d’alternative à mon i5 ! Pourquoi AMD néglige autant ce secteur …

#20

#21

#22

raptr il me semble. Mais moi elle ne me dérange pas.

#23

#24

Oui mais non.

Une meilleure performance énergétique n’est pas la cause ou un incitateur à une plus grande consommation. Ce sont les hommes qui en sont la cause.

C’est bien pour cela qu’il faut travailler sur deux axes, à la fois la performance énergétique de manière générale (consommation des appareils, isolation/conservation) et l’éducation des peuples sur l’importance de l’énergie (comme l’importance de l’eau).

L’un ne va pas sans l’autre.

C’est d’ailleurs le principal problème aujourd’hui dans une société du “toujours plus”.

#25

#26

Oui, ce serait un sophisme.

La question n’est pas vraiment de savoir s’il faut continuer à améliorer les rendements (ça semble aller de soit).

Mais de savoir s’il faut continuer avec le modèle de croissance à tout prix (qui à pour effet de bord d’absorber ces améliorations de rendement d’un point de vu énergétique).

#27

#28

#29

Oui parfaitement, le problème est d’avantage économique (croissance à tout prix) qu’énergétique.

Je donnais le liens juste pour casser l’argument simpliste:

Réduction de consommation = consommation d’énergie réduite dans le futur

Qui ne tiens justement pas compte du contexte économique (qui est un facteur essentiel de l’équation).

C’est la même hypocrisie que la “croissance verte” qui est par définition antinomique.

#30

#31

Intel ne s’est pas pris une amende de 1 Milliard par hasard…

#32

AMD cay nul " />

" />

#33

#34

Qu’est ce qu’il reste à AMD ? Mantle, et des bons APU

Le gros du marché des CPU est à Intel

Le gros du marché des GPU est à Nvidia

Et plus le temps passe plus il est difficile de combler l’écart

#35

Toi, t’es du genre à installer tous les crapwares qui te passent sous la main (genre Chrome en navigateur par défaut lors de la mise à jour de flash player)

Avec 2 ronds de bon sens, tu n’installerais que ce qui est nécessaire.

#36

deuxième ligne du wiki :

" />

" />

“ Cette idée est une analyse plus moderne d’un phénomène connu sous le nom de paradoxe de Jevons.”

lire, tout ça tout ça

#37

#38

#39

Tu peux développer?

#40

#41

#42

Et les opteron A1100 ?

Voilà quelque chose d’intéressant pour les datacenters. Et après ça, on verra arriver de l’ARM en desktop dans la mesure où on a déjà les smartphones et les tablettes sous ARM.

Mais bon, si des éditeurs sautaient le pas en terme d’architecture processeur, les procs ARM dernière génération pourraient très honorablement fournir le niveau de service requis dans les desktops.

#43

#44

+1 pour le sous-titre : depuis q’AMD utilise des noms d’engins de chantier pour ses architectures, on dirait qu’il creuse sa tombe….

SInon, le gros problème, c’est quand même la gravure à 28nm. Les performances des CPU d’AMD suffisent pour la plupart des gens, même s’ils sont moins rapides dans l’absolu que les Intel. Le problème, c’est la consommation et la chauffe, qui ne peuvent réellement s’améliorer qu’avec la passage à une gravure plus fine.

Du coup, n’est-ce pas les fondeurs qui risquent d’enterrer AMD, en repoussant (annulant) le 20nm ?

#45

#46

#47

#48

#49

#50

#51

Ben HS ou pas, moi j’attendais aussi l’explication de ta supposée haine contre ladite encyclopédie pourtant bien reconnue dans le monde entier, et partant de a meilleure intention qui soit : “partager le savoir”.

C’est bien dommage d’en penser autant de mal. Je suis triste pour toi.

#52

Je changerai peut-etre pour un futur proc AMD et une nouvelle CM, cependant aujourd’hui encore mon Phenom II x2 B550, GTX660 OC, 16Go mem, SSD, ne me posent aucun problèmes pour travailler et jouer a des jeux récents en étant en haut du classement :)

#53

ce qu’il faut pas lire quand meme qu’il crevent mais espece d’idiot tu te rend compte au moins que de ce que tu dis si amd creve tu creve aussi car intel sera le kador et mettra des prix hors de ta bourse bordel que certain qui ont un QI de d’escargot la ferme et dégage de ce site

#54

#55

M’ouais, AMD ils sont forts pour prendre leurs clients pour des jambons avec leurs pilotes graphiques qui sent la bouse… Enfin, quand je dis “qui sent la bouse”, c’est quand ces pilotes existent !

Hé oui j’ai une machine avec une ATI (à l’époque) HD4850, une vieille bête :

Alors c’est bien, ils poussent à la conso, mais s’ils croient que les gens dans la même situation que moi retourneront chez eux pour la prochaine CG, ils se mettent un doigt dans… hum, allez, dans l’oeil, je suis gentil.

Je suppose qu’il y a moins de problèmes côté CPU cela dit, même si en général ils consomment bien chez AMD… Mais cela est un autre débat !

#56

Vision à court terme / hater simpliste

Intel ne pourra pas rester seul sur le marché. Cela a déjà été dit plus haut, il sera découpé pour des raisons de monopole (anti trust toussa …)

#57

je me disais exactement la meme chose.

Qu’on aime ou qu’on aime pas, la concurrence, y a que du bon ! je veux surtout pas de Monopole sur les CG, sinon comme l’a dit Stel, on aura du matos identique, ils se fouleront plus et on paiera les yeux de la tete :)

#58

Déjà ils sont la, et Intel ne se gène pas pour pratiquer des prix inhumains ! Imagine sans eux !!!

" />

" />

Faudrait qu’une grosse Boite genre Microsoft/Apple/Google ravale AMD et booste le schmilblick pour détrôner le roi

#59

Mouai, là je vois surtout un pessimiste de base qui, bien que philosophe a juste fait un amalgame entre le modèle économique utilisé par Wikipedia et le service qui est fourni. Mais enfin, au moins, t’as développé. Quel que soit les manières de penser c’est toujours intéressant de comprendre pourquoi les autres ne pensent pas comme nous.

#60

Heuu.. Je suis pas très a l’aise avec l’anglais et le traducteur Google à du mal transcrire.

J’ai bien compris que ça traitais de la définition du néolibéralisme mais je n’ai pas compris la critique qui en était faite.

Tu peux m’éclairer?

#61

Sauf que voilà, AMD à fait DODO pendant la période merdique P4 pour Intel, et que depuis, Intel se remue le derrière (pour pas dire autre chose), et bouffe plus de parts de marché (légalement ou pas), et surtout, faut pas se voiler la face, actuellement les CPU Intel sont meilleurs.

#62

Sont meilleurs en mono-thread et en consommation. Parce que sinon, ça tourne très bien AMD, voir parfois mieux qu’Intel !

#63

#64

Ce qu’il faut pas lire concernant les pilotes AMD…

" /> ). Et RaptR bouffe que dalle en ressources, évidemment pour les jeux tipiaks ça fait chier hein ? Alors faut arrêter de se payer une carte à 200 euros dans ces cas là si ont a pas le blé pour les jeux…

" /> ). Et RaptR bouffe que dalle en ressources, évidemment pour les jeux tipiaks ça fait chier hein ? Alors faut arrêter de se payer une carte à 200 euros dans ces cas là si ont a pas le blé pour les jeux…

-Entre celui qui troll : “AMD crève, ça pue, c’est pourri !”, qui n’as pas compris que si AMD disparait il se retrouvera avec un i3 au prix d’un i5/i7, de toute façon l’archi x86 commence à s’essouffler, donc la guéguerre “Intel/AMD qui est le meilleur des benchmarks kikolol” ne sert plus à rien, AMD commence déjà à s’orienter vers d’autres options…

-Entre celui qui râle parque les pilotes sont sois-disant moisis : déjà les pilotes des cartes mères sont nickels (bah oui ça parle de proco la news, non ?), et les pilotes GPU AMD sont pas moins/pas plus stable que ceux d’Nvidia…

C’est très très loin l’époque des pilotes des HD2xxx & consort… Sans compter que c’est souvent le gars avec sa carte Nvidia payé plein pot qui râle d’un pilote AMD instable d’il y a 10 ans…

-Celui qui râle pour RaptR qui n’est maintenant plus installé d’office depuis un moment… (Ou alors il ne sais pas cocher une option ?

-Celui qui râle pour des pilotes d’une HD4870 sortie il y a… 6 ans ? Les pilotes des HD4870 ont déjà toute leurs optimisations depuis un moment, tu veut aussi que ta HD4870 soit compatible DX12 ?

Tu te plains aussi pour XP qui n’as plus de support ? Aussi parce que tu ne trouve plus de sacs pour ton aspirateur vieux de 6 ans ? Tu crois qu’ils vivent comment les boites comme Intel, Nvidia, AMD ? Avec leurs matos vendus il y a 5-10 ans ? Les HD4870 n’étaient pas prévu pour Windows 8.1 à la base, mais pour max Vista…

Effectivement il faut obligatoirement qu’AMD sortent des pilotes pour des cartes vendues maintenant d’occaz 20 euros (HD4870) pour une poignée d’utilisateurs qui veulent pas dépenser plus… Après sous Linux vu le peu de jeux, autant rester sur le GPU intégré au CPU, plus simple lol

#65

#66

#67

Allez plein de code HSA dans le kernel et quelques bibliothèques majeures qu’on puisse y goûter et voir ce que ça donne vraiment…

Encore 2 ans pour y arriver? S’ils trainent trop ils vont encore se faire dépasser après avoir défriché un concept…

#68

Je donne mon point de vue, je trouve cela intéressant, même si totalement HS :

Wikipedia ne fait que “rassembler” le savoir, de façon chaotique et sans objectif précis. On perd le concept d’un meta-savoir, d’un guide dans le voyage de l’information, ce que propose chaque marque d’encyclopédie. C’est ce qui faisait “la patte” des encyclopédies pré-internet. Et Wikipedia est en train de les tuer, autant financièrement que dans l’intérêt, car il annhilie le concept même de l’encyclopédiste, de celui qui est suffisament à l’aise dans la masse du savoir pour en faire une présentation/un point d’entrée aux non-initiés.

Autre point intéressant, Wikipedia est constamment en mouvance, ce qui empêche de connaitre l’état d’esprit d’une période. Grâce à Diderot, nous avons une biographie de la cartographie du savoir de l’époque. On sait qui l’a écrit et quand. Avec Wikipedia, cette cartographiqe est plus compliquée à faire voire insurmontable. Et si Wikipedia mets fin aux autres encyclopédie, je te laisse imaginer les dommages que cela pourrait créer que de confondre savoir/état d’esprit/coutume/moral d’une époque.

#69

#70

tu te trompes. Les pilotes Open source pour les cartes AMD sont de bonnes factures et permettent aujourd’hui de jouer à pas mal de jeux. Ils ne sont pas encore aussi performants que les pilotes proprio, certes, mais l’ecart ne cesse de diminuer (il arrive même dans certains cas que les pilotes Open source soient plus performants que les pilotes proprios).

#71

#72

#73

#74

#75

Oui, c’est ce que je sous-entends avec le “On sait qui l’a écrit et quand..”

#76

#77

#78

#79

#80

#81

#82

Je ne pense pas que ça existe actuellement parce que c’est quand même pas trivial comme fonctionnalité (notamment sur la manière dont tu gères les versions et durées de vie des contenus dans la base de données), et je ne crois pas que la manière dont mediawiki gère actuellement soit adaptée. Cela étant du peu que j’en connais il n’y a pas d’obstacle technique particulier…

#83

Ahem… Au temps pour moi… Je lirai donc volontiers l’article en entier (mais pas tout de suite je suis presque en rush ;)). " />

" />

#84

#85

#86

#87

#88

Aha, c’est drôle, ce vieil argument ancestral des drivers graphiques. Cela fais 4 ans que je tourne sous les drivers amd, je n’ai jamais eu aucun problème, de plus j’ai eu en son temps des gains notables dans pas mal de jeux, donc ton argument du début de millénaire, à revoir. Et la fameuse appli dont tu parles, huuum, bah tu dois probablement faire partie des gens qui spam le bouton suivant dans les install ;)

#89

#90

#91

On a compris ta frustration tu veux pas changer de disque et sortir d’autres arguments ?

#92

Je suis sous AMD/ATI et j’ai ce qu’il se fait de mieux en terme de rapport prix/perf, même si AMD ne fait pas dans le haut de gamme, leur haut de gamme sont monstrueux en moyenne gamme.

Un simple 8320E que j’ai monté à 4.9ghz stable sur les 8 cores pour 130e … monstrueux quoi, et il ne dépasse pas 50° en charge de longue durée.

#93

Hum , je t’avouerai que dernièrement, je n’ai pas testé en profondeur de lourdes tâches avec les pilotes libres (genre du jeu, personnellement). Mais il y a de ça encore quelques petits mois, les pilotes propriétaires restaient largement meilleurs. Seulement je devais down la version de Xorg car les dernières n’étaient plus supportées (je ne sais plus trop pourquoi), et maintenant même avec ce hack, ce n’est même plus possible de le faire apparemment…

" />

" />

Bref, je retesterai quand même, mais bon… Je reste sceptique.